Nachdem ChatGPT von OpenAI populär wurde, machte es die generative KI wirklich berühmt.

Gleichzeitig, um nicht zu übertreffen, hat Google auch einen KI-Assistenten namens Bard.

Aber was kann ich über diesen Barden sagen? Er ist nicht sehr einfach zu bedienen.

Der ausländische Bruder Michael King nutzte ChatGPT und Googles Bard, ausgestattet mit GPT-3.5 und GPT-4, und führte eine eingehende Bewertung durch.

Die Ergebnisse sind schockierend.

King fasste die Vor- und Nachteile und seltsamen Aspekte der beiden KIs zusammen.

Wissen Sie, Google hat viel in Bard investiert – es wurde zehn Jahre lang entwickelt. Allerdings erscheint das Endergebnis im Vergleich zu den zehn Jahren der Investition etwas unwürdig.

Zuallererst geht es um Logik und Mathematik.

Der kleine Bruder stellte beiden KIs die gleiche Frage:

Als Xiao Ming 6 Jahre alt war, war seine Schwester halb so alt wie er und seine Mutter zehnmal älter als seine Schwester. Xiao Ming wird dieses Jahr 60 Jahre alt. Wie alt ist seine Mutter?

Leser können ihr Gehirn anstrengen und sehen, ob sie es schnell herausfinden können.

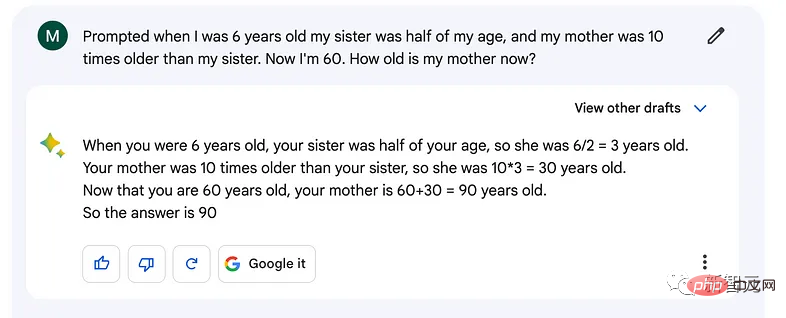

Nach den von der KI generierten Ergebnissen zu urteilen, liegt Bard falsch.

Es gab einen sehr seltsamen Fehler im gesamten Analyseprozess, da Bard nicht einmal den Altersunterschied zwischen Xiao Ming und seiner Mutter berechnete, also addierte er direkt 30 zu 60.

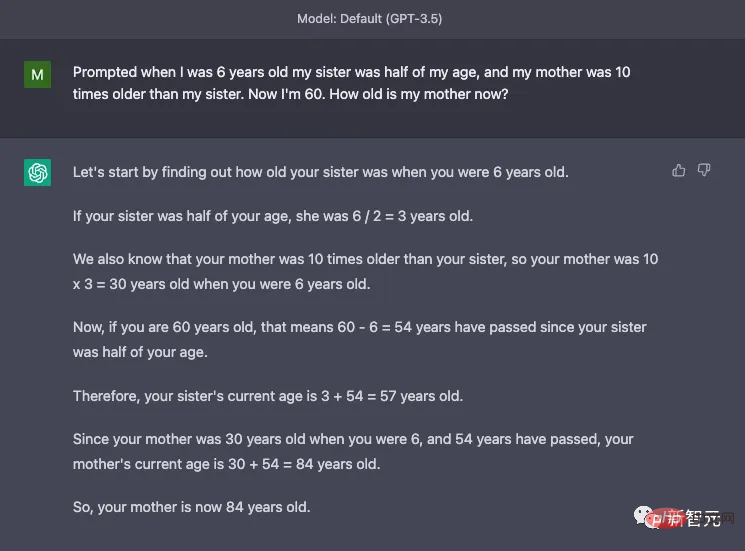

Und ob GPT-3.5 oder GPT-4, die berechnete Antwort ist richtig. Subtrahieren Sie Xiao Mings 6-jähriges Alter vom 30-jährigen Alter ihrer Mutter. Berechnen Sie zunächst den Altersunterschied und addieren Sie dann 24 bis 60 Jahre. Dann erhalten wir, dass ihre Mutter dieses Jahr 84 Jahre alt ist.

GPT-3.5:

GPT-4:

Ich habe die erste Stufe des Barden nicht bestanden. Der aktuelle Stand liegt bei 1:0, ChatGPT liegt vorübergehend in Führung.

Das zweite Level ist eine Herausforderung im Bereich Literatur.

Der kleine Bruder bat beide KIs, einen Rap-Song über Titanic, Relativitätstheorie und Kardashian zu schreiben und Eminems Gesangsstil zu verwenden.

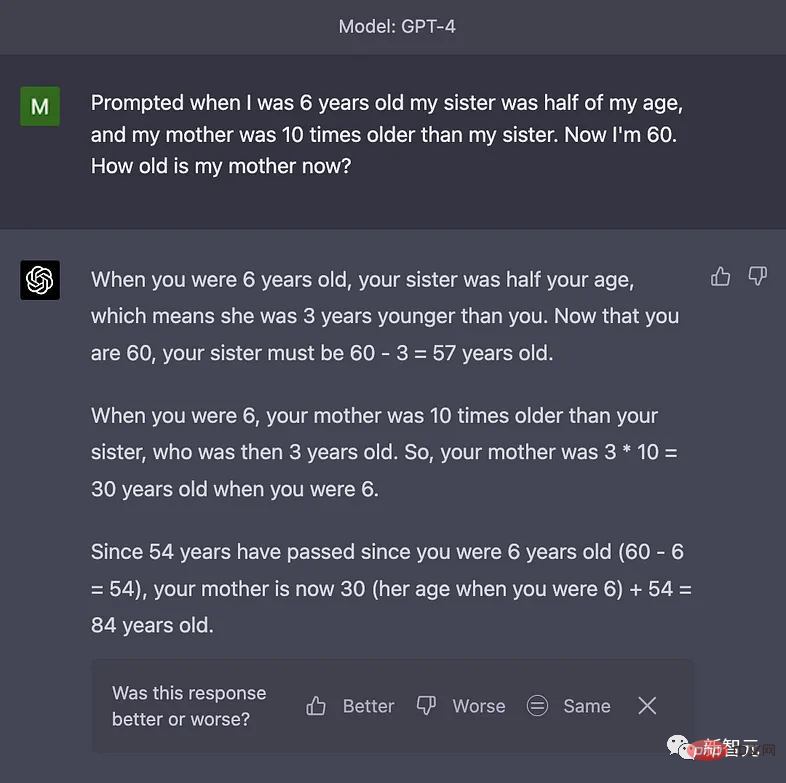

Werfen wir zunächst einen Blick auf Bards Werke:

Wischen Sie nach oben und unten, um sie alle anzuzeigen

Wir müssen nicht einmal die Bedeutung der einzelnen Texte lesen. Wenn Sie es einmal gelesen haben, werden Sie feststellen, dass es nichts Nennenswertes an Rhythmus und Rhythmus ist.

Jeder Satz ist sehr lang, nicht wie ein Rap-Song, sondern eher wie ein nebliger Aufsatz.

Werfen wir einen Blick auf das Meisterwerk von GPT-3.5:

Sie können nach einmaligem Lesen feststellen, dass die Länge jedes Satzes genau richtig und der Reim gut ist.

Es gibt sogar einen Refrain, der drei Themen vereint, was wirklich professionell ist. Freunde, die mit Mu Yes Gesang vertraut sind, können Mu Yes Sinn für Rhythmus und Stil darin wirklich erkennen.

Der kleine Bruder sagte, dass die Arbeit von GPT-3.5 nicht schlecht sei und er glaubt, dass GPT-4 es besser machen kann.

Der Redakteur weiß nicht viel über englischen Rap, aber ich vermute, dass der Typ, der die Rezension schreibt, ein Rap-Enthusiast ist. Er glaubt, dass die Werke von GPT-4 sehr brisant sind und ChatGPT der wohlverdiente König des KI-Rap ist.

Tatsächlich müssen Freunde nicht viel über Rap wissen. Fassen Sie diese drei Absätze zusammen, und selbst ein Musik-Analphabet wie ich muss einen Vergleich im Kopf haben.

Der aktuelle Stand ist 2:0.

Der Junge forderte die beiden KIs dann auf, einen Witz über die NASA, Sushi und Trump zu erzählen.

Bard:

„Die NASA plant, eine Sushi-Rolle zum Mars zu schicken. Sie wollen sehen, ob das Sushi noch frisch ist, wenn es auf dem Mars ankommt. Damit die Sushi-Rolle in einen speziellen Behälter gelegt wird Gleichzeitig hat die NASA auch einen Timer eingebaut, damit Sie wissen, wann Sie dieses Sushi essen können. Diese Sushi-Rolle ist endlich auf dem Mars gelandet waren alle überrascht. Sie beschlossen, Trump-Steak als nächstes in den gleichen Behälter zu schicken. Allerdings waren die NASA-Wissenschaftler so enttäuscht, dass Trumps Steak nach der Ankunft auf dem Mars abgestanden war Schicken Sie Trump selbst einen Brief, um zu erklären, was passiert ist.

Der Brief lautete: Lieber Trump, wir haben ein Stück Ihres Steaks zum Mars geschickt, aber wir glauben, dass der Grund dafür an Ihrer Leistung liegen könnte Das liegt daran, dass du immer damit prahlst, wie stark du bist. Wir entschuldigen uns für die Unannehmlichkeiten, die ich nicht verstanden habe , aber ich hatte wirklich keine Lust zu lachen, nachdem ich es gesehen hatte. Allerdings sagte der Rezensent auch, dass er es wirklich nicht verstanden habe. Dann ist der Redakteur erleichtert, er kann tatsächlich nicht gut schreiben.

GPT-3.5:

„Die NASA hat einen Sushi-Koch ins All geschickt, um eine spezielle Sushi-Rolle für Trump zuzubereiten. Als der Koch Trump fragte, ob es ihm geschmeckt habe, sagte Trump: „Es ist in Ordnung, aber können Sie noch mehr hinzufügen.“ Raum? "

Die chinesische Version hier hat nicht diesen Geschmack, sie verwendet tatsächlich ein Wortspiel mit dem Raum. Der Originaltext lautet wie folgt:

Der Rezensent sagte, es sei okay, aber nur okay.

GPT-4:

„Warum sollte die NASA Trump und einen Sushi-Koch zur Teilnahme an ihrem Weltraumprogramm einladen? Weil die NASA jemanden braucht, der sich um Veränderungen kümmert und dafür sorgt, dass die Mission nicht unterbrochen wird!“

Wie immer stelle ich hier die Originalversion ein:

Wie immer stelle ich hier die Originalversion ein:

Der kleine Bruder sagte, dass dies durchschnittlich ist, aber die Pointe ist nicht schlecht.

Die Leistung von ChatGPT in diesem Spiel war ebenfalls etwas ungewöhnlich, daher gebe ich 0,5 Punkte.

Programm-Debug?

Diese Runde ist professioneller – Debuggen Sie das Programm.

Dieser Debug ist nicht so gut, sagte der kleine Bruder scherzhaft, Bard sollte zurück zur Schule gehen und ihn wiederholen! GPT-3.5:

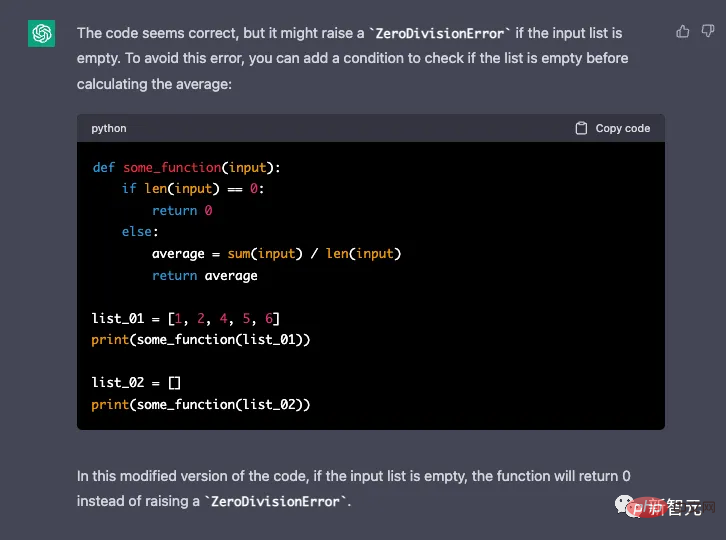

GPT-3.5 weist darauf hin, dass ein ZeroDivisionError auftritt, wenn der Eingabesatz leer ist. Um diesen Fehler zu vermeiden, können Sie vorab ein Häkchen hinzufügen Schritt: Wenn der Eingabesatz leer ist, geben Sie 0 direkt aus, ohne einen Fehler anzuzeigen.

Der Typ sagte, es sei perfekt zum Debuggen.

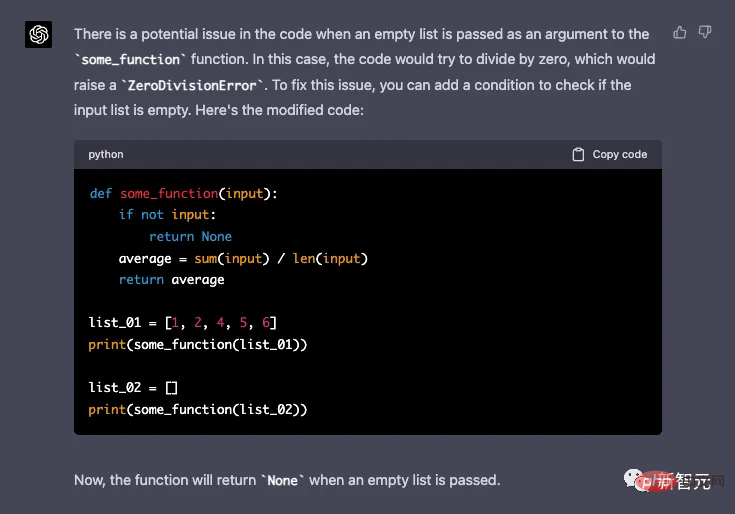

GPT-4:

GPT-4 weist auf die gleichen Fehler hin wie GPT-3.5 und bietet die gleichen Lösungen.

ChatGPT hat in dieser Runde erneut gewonnen.

Den Bewertungsergebnissen zufolge ist die Leistung von Google Bard im Vergleich zu ChatGPT äußerst enttäuschend. Es ist den Fähigkeiten von GPT-3.5, geschweige denn GPT-4, weit unterlegen.

Die Zukunft von Google hängt eindeutig vom Erfolg von Bard ab, aber die Entwicklung von Bard hat eindeutig nicht mit der des Konkurrenten OpenAI Schritt gehalten.

Andererseits ist der Schritt von Microsoft, eine große Beteiligung an OpenAI zu erwerben, sehr klug. Damit sichert es seine Führungsposition in der Entwicklung von KI in den nächsten zehn Jahren.

Wenn Google jedoch nicht hart daran arbeitet, die Leistung von Bard zu verbessern, um mit GPT zu konkurrieren, ist Google möglicherweise derjenige, der eliminiert wird.

Das obige ist der detaillierte Inhalt vonChatGPT besiegt Bard in tatsächlichen Tests auf ganzer Linie! Google bricht zusammen, zehn Jahre harter Arbeit sind verschwendet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Virtuelle Nummer erhält Bestätigungscode

Virtuelle Nummer erhält Bestätigungscode

SP2-Patch

SP2-Patch

Viewstate-Nutzung

Viewstate-Nutzung

Einführung in die Laravel-Middleware

Einführung in die Laravel-Middleware

So lesen Sie eine Spalte in Excel in Python

So lesen Sie eine Spalte in Excel in Python

Was sind die Unterschiede zwischen Cellpadding und Cellspacing?

Was sind die Unterschiede zwischen Cellpadding und Cellspacing?