Nachdem Technologieriesen wie Meta und Google mehr als ein halbes Jahr lang Text in Bild umgewandelt haben, haben sie ein neues Schlachtfeld im Visier: Text in Video.

Letzte Woche hat Meta ein Tool angekündigt, mit dem sich hochwertige Kurzvideos erstellen lassen – Make-A-Video. Die mit diesem Tool erstellten Videos sind sehr einfallsreich.

Natürlich ist Google nicht zu übertreffen. Soeben hat der CEO des Unternehmens, Sundar Pichai, persönlich seine neuesten Errungenschaften auf diesem Gebiet bekannt gegeben: zwei Text-zu-Video-Tools – Imagen Video und Phenaki. Ersteres konzentriert sich auf die Videoqualität, während letzteres hauptsächlich die Videolänge in Frage stellt. Man kann sagen, dass jedes seine eigenen Vorzüge hat.

Der Teddybär beim Abwaschen unten wurde mit Imagen Video erstellt. Wie Sie sehen, sind Auflösung und Kohärenz des Bildes bis zu einem gewissen Grad gewährleistet.

Die generative Modellierung hat in neueren Text-zu-Bild-KI-Systemen wie DALL-E 2, Imagen, Parti, CogView und Latent Diffusion erhebliche Fortschritte gemacht . Insbesondere Diffusionsmodelle haben bei einer Vielzahl generativer Modellierungsaufgaben wie Dichteschätzung, Text-zu-Sprache, Bild-zu-Bild, Text-zu-Bild und 3D-Synthese große Erfolge erzielt.

Was Google tun möchte, ist, aus Text ein Video zu generieren. Frühere Arbeiten zur Videogenerierung konzentrierten sich auf eingeschränkte Datensätze mit autoregressiven Modellen, latenten Variablenmodellen mit autoregressiven Priors und neuerdings auch nicht-autoregressiven latenten Variablenmethoden. Diffusionsmodelle haben auch hervorragende Fähigkeiten zur Videogenerierung mittlerer Auflösung gezeigt.

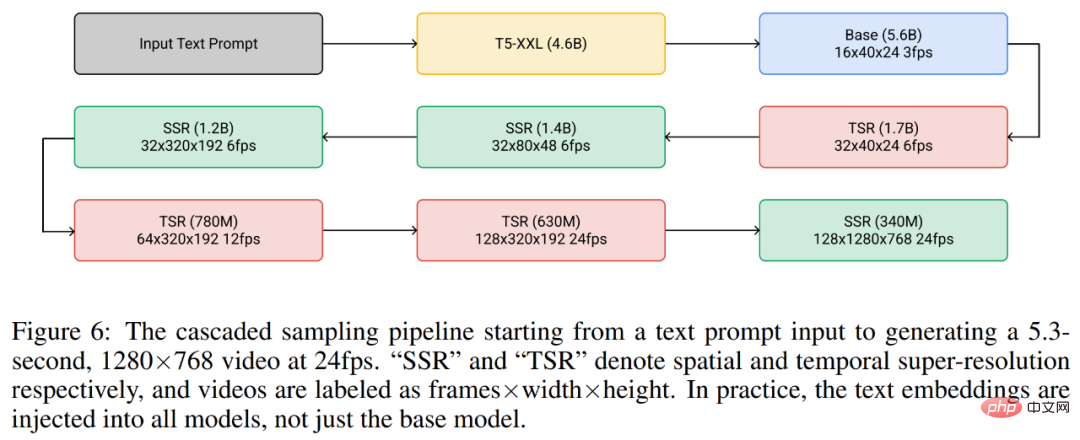

Auf dieser Grundlage startete Google Imagen Video, ein textbedingtes Videogenerierungssystem, das auf dem Kaskadenvideodiffusionsmodell basiert. Bei einer Textaufforderung kann Imagen Video hochauflösende Videos über ein System generieren, das aus einem eingefrorenen T5-Text-Encoder, einem grundlegenden Videogenerierungsmodell und einem kaskadierten räumlich-zeitlichen Video-Superauflösungsmodell besteht.

Papieradresse: https://imagen.research.google/video/paper.pdf

In dem Papier beschreibt Google ausführlich, wie das System in einen hochauflösenden Text erweitert werden kann -zu-Video-Modell, einschließlich Entwurfsentscheidungen wie der Auswahl eines vollständig faltenden räumlich-zeitlichen Superauflösungsmodells bei bestimmten Auflösungen und der Auswahl der V-Parametrisierung des Diffusionsmodells. Google hat außerdem frühere Forschungsergebnisse zur diffusionsbasierten Bildgenerierung erfolgreich auf eine Einstellung zur Videogenerierung migriert.

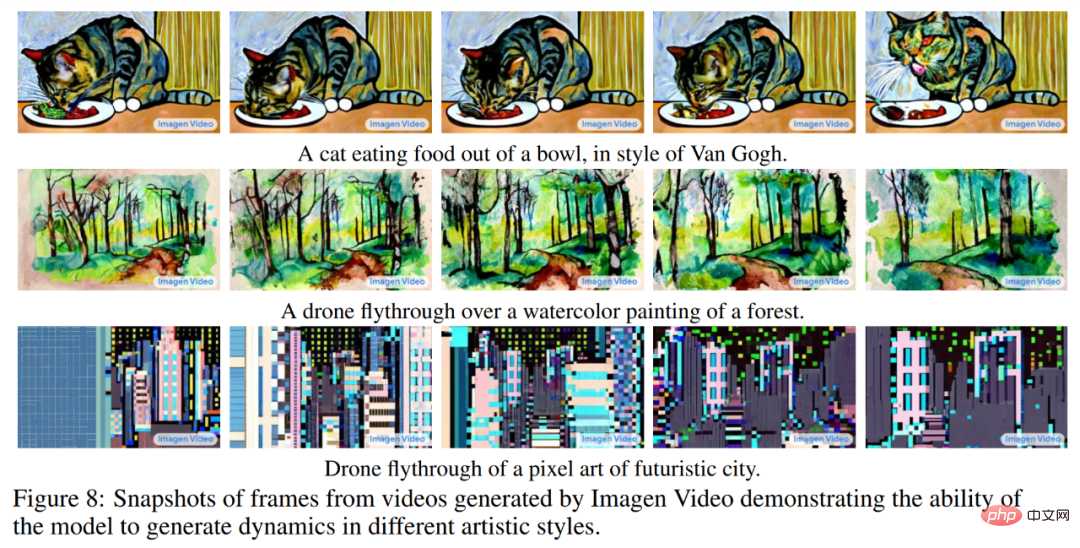

Google hat herausgefunden, dass Imagen Video das 128×128-Video mit 24 Bildern pro Sekunde und 64 Bildern, das bei früheren Arbeiten erstellt wurde, auf HD-Video mit 128 Bildern und 1280×768 hochskalieren kann. Darüber hinaus verfügt Imagen Video über ein hohes Maß an Steuerbarkeit und Weltwissen, kann Video- und Textanimationen in verschiedenen künstlerischen Stilen generieren und verfügt über Funktionen zum Verständnis von 3D-Objekten.

Lassen Sie uns weitere von Imagen Video generierte Videos genießen, wie zum Beispiel einen Panda, der ein Auto fährt:

Ein Holzboot, das im Weltraum reist:

Für weitere generierte Videos, bitte siehe: https://imagen.research.google/video/

Methoden und Experimente

Insgesamt ist das Videogenerierungs-Framework von Google eine Kaskade von sieben Sub-Video-Diffusionsmodellen, die eine textbedingte Videogenerierung, eine räumliche Superauflösung bzw. eine zeitliche Superauflösung durchführen. Mit der gesamten Kaskade ist Imagen Video in der Lage, 128 Bilder von 1280×768 HD-Videos (ca. 126 Millionen Pixel) mit 24 Bildern pro Sekunde zu produzieren.

Mittlerweile generiert Imagen Video mithilfe der progressiven Destillation qualitativ hochwertige Videos mit nur acht Diffusionsschritten in jedem Untermodell. Dies beschleunigt die Videogenerierungszeit um etwa das 18-fache.

Abbildung 6 unten zeigt die gesamte Kaskadenpipeline von Imagen Video, einschließlich 1 Encoder für eingefrorenen Text, 1 grundlegendes Videodiffusionsmodell, 3 Modellen mit räumlicher Superauflösung (SSR) und 3 Modellen mit zeitlicher Superauflösung (TSR). Die sieben Videodiffusionsmodelle verfügen über insgesamt 11,6 Milliarden Parameter.

Während des Generierungsprozesses verbessert das SSR-Modell die räumliche Auflösung aller Eingabebilder, während das TSR-Modell die zeitliche Auflösung verbessert, indem es Zwischenbilder zwischen Eingabebildern ausfüllt. Alle Modelle erzeugen gleichzeitig einen vollständigen Block von Frames, sodass das SSR-Modell nicht unter auffälligen Artefakten leidet.

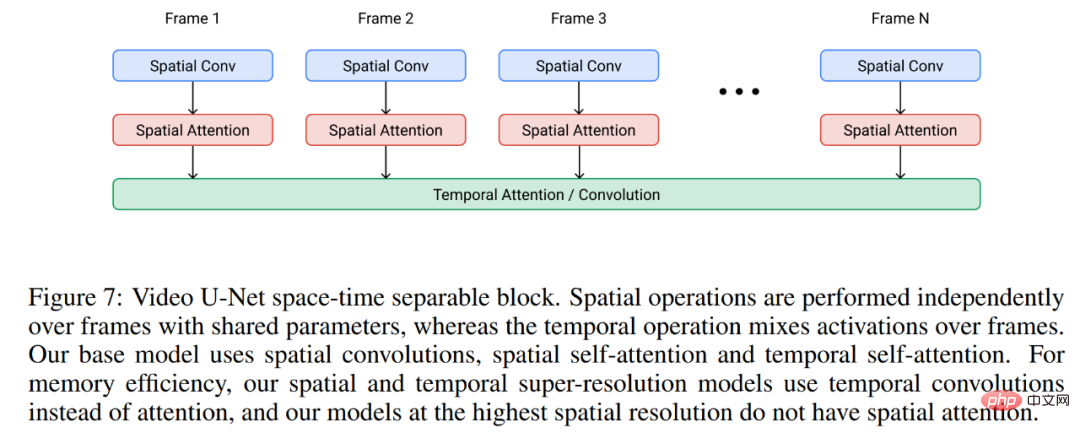

Imagen Video basiert auf der Video-U-Net-Architektur, wie in Abbildung 7 unten dargestellt.

In Experimenten wird Imagen Video auf dem öffentlich verfügbaren Bild-Text-Datensatz LAION-400M, 14 Millionen Video-Text-Paaren und 60 Millionen Bild-Text-Paaren trainiert. Dadurch ist Imagen Video, wie oben erwähnt, nicht nur in der Lage, hochauflösende Videos zu generieren, sondern verfügt auch über einige einzigartige Funktionen, die unstrukturierte generative Modelle, die rein aus Daten lernen, nicht haben.

Abbildung 8 unten zeigt die Fähigkeit von Imagen Video, Videos mit künstlerischen Stilen zu erstellen, die aus Bildinformationen gelernt wurden, wie z. B. Van Goghs Malstil oder Videos im Aquarellstil.

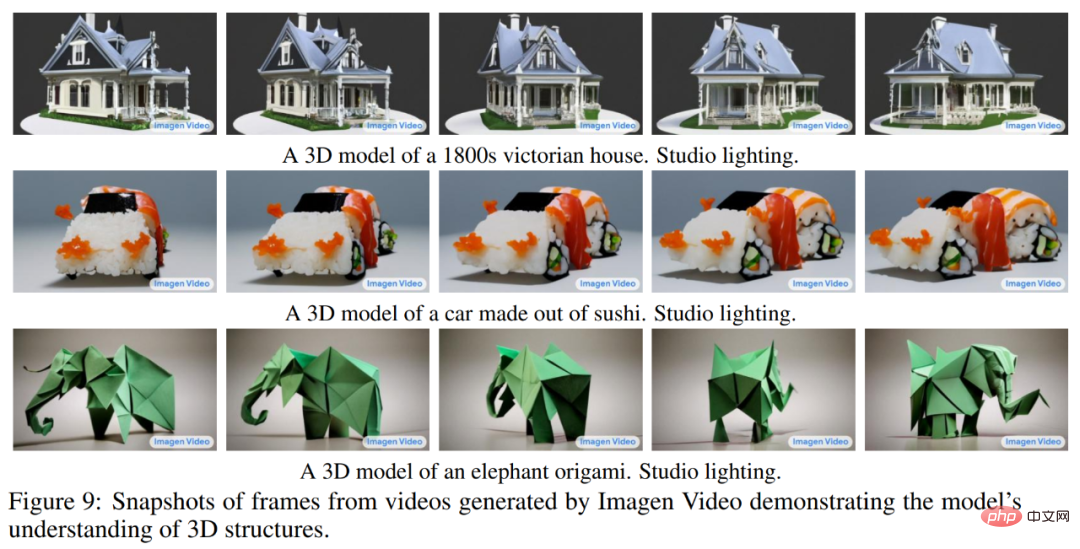

Abbildung 9 unten zeigt die Fähigkeit von Imagen Video, 3D-Strukturen zu verstehen. Es kann Videos von rotierenden Objekten erstellen und dabei die allgemeine Struktur des Objekts beibehalten.

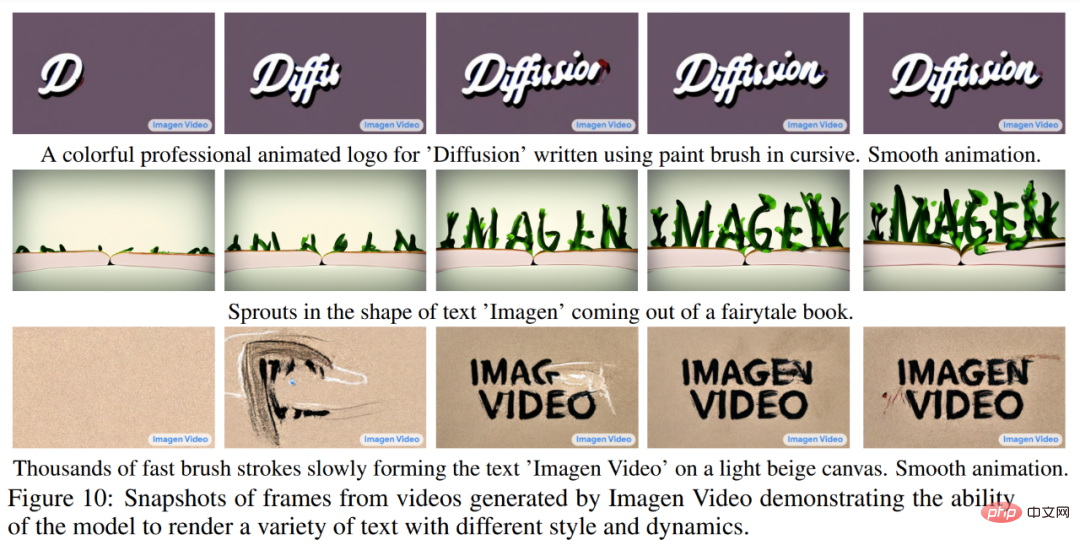

Abbildung 10 unten zeigt, wie Imagen Video zuverlässig Text in einer Vielzahl animierter Stile generieren kann, von denen einige mit herkömmlichen Werkzeugen schwer zu erstellen sind.

Weitere experimentelle Details finden Sie im Originalpapier.

Wir wissen, dass ein Video zwar im Wesentlichen aus einer Reihe von Bildern besteht, die Erstellung eines zusammenhängenden langen Videos jedoch nicht so einfach ist, da bei dieser Aufgabe die verfügbare hohe Qualität erforderlich ist Daten sind knapp und die Aufgaben selbst sind rechenintensiv.

Was noch problematischer ist, ist, dass die kurzen Textaufforderungen, die wie bisher zur Bildgenerierung verwendet werden, normalerweise nicht ausreichen, um eine vollständige Beschreibung des Videos bereitzustellen. Was das Video benötigt, ist eine Reihe von Aufforderungen oder Geschichten. Idealerweise muss ein Videogenerierungsmodell in der Lage sein, Videos beliebiger Länge zu generieren und die generierten Videobilder entsprechend sofortigen Änderungen zu einem bestimmten Zeitpunkt t anzupassen. Nur mit dieser Fähigkeit können die vom Modell erzeugten Werke als „Video“ und nicht als „bewegte Bilder“ bezeichnet werden und den Weg für reale kreative Anwendungen in Kunst, Design und Inhaltserstellung öffnen.

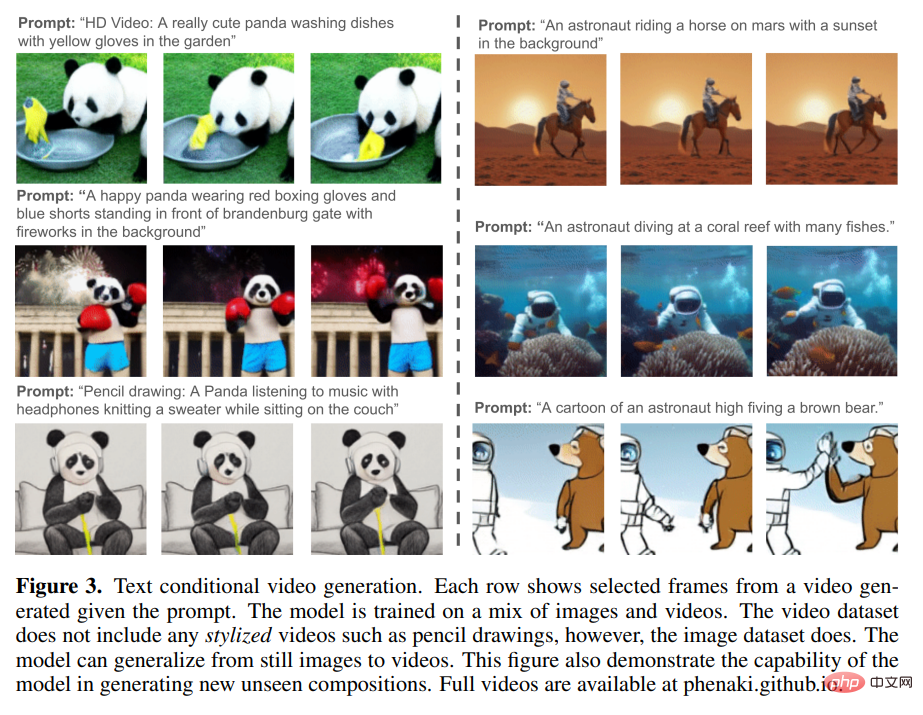

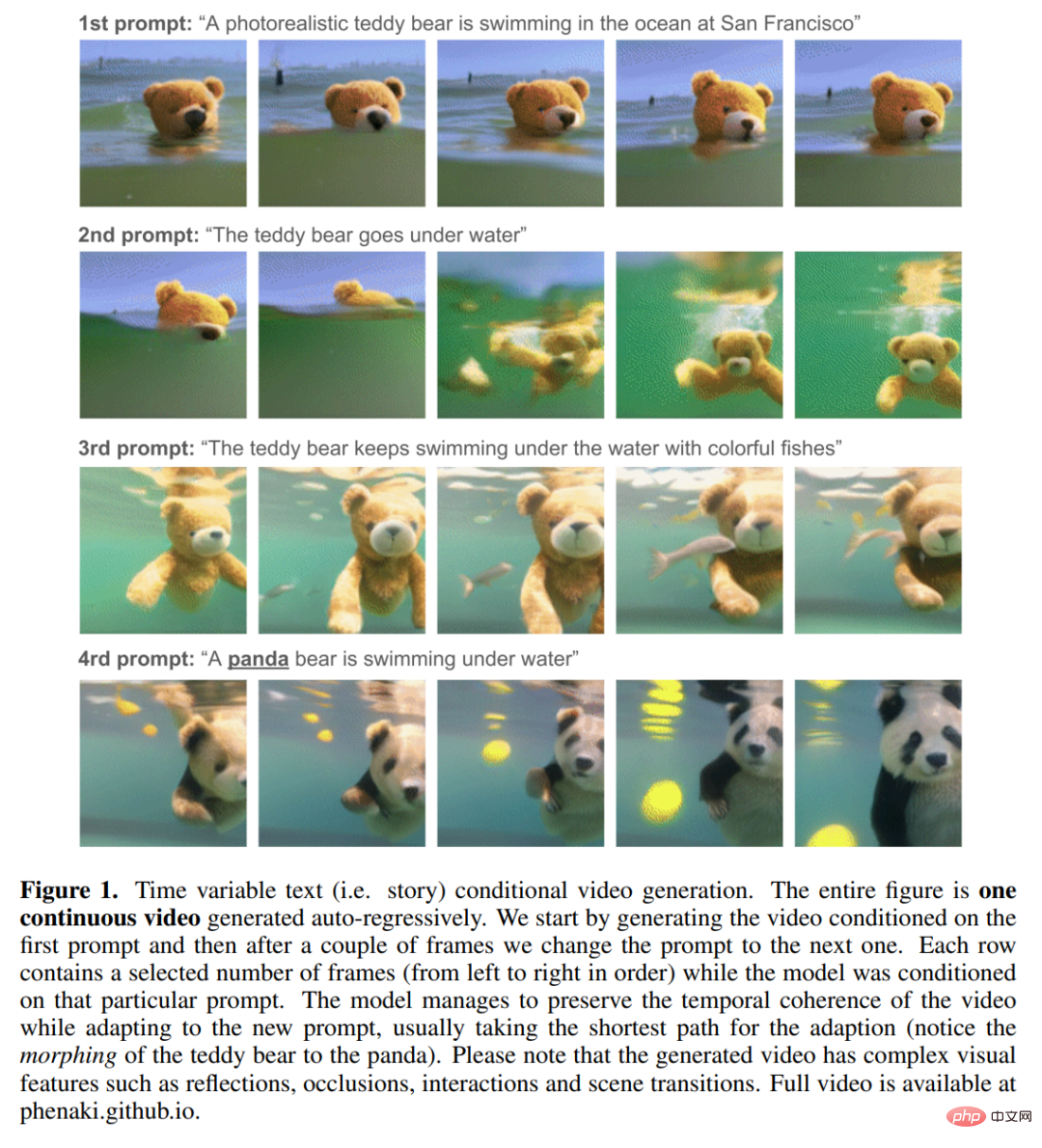

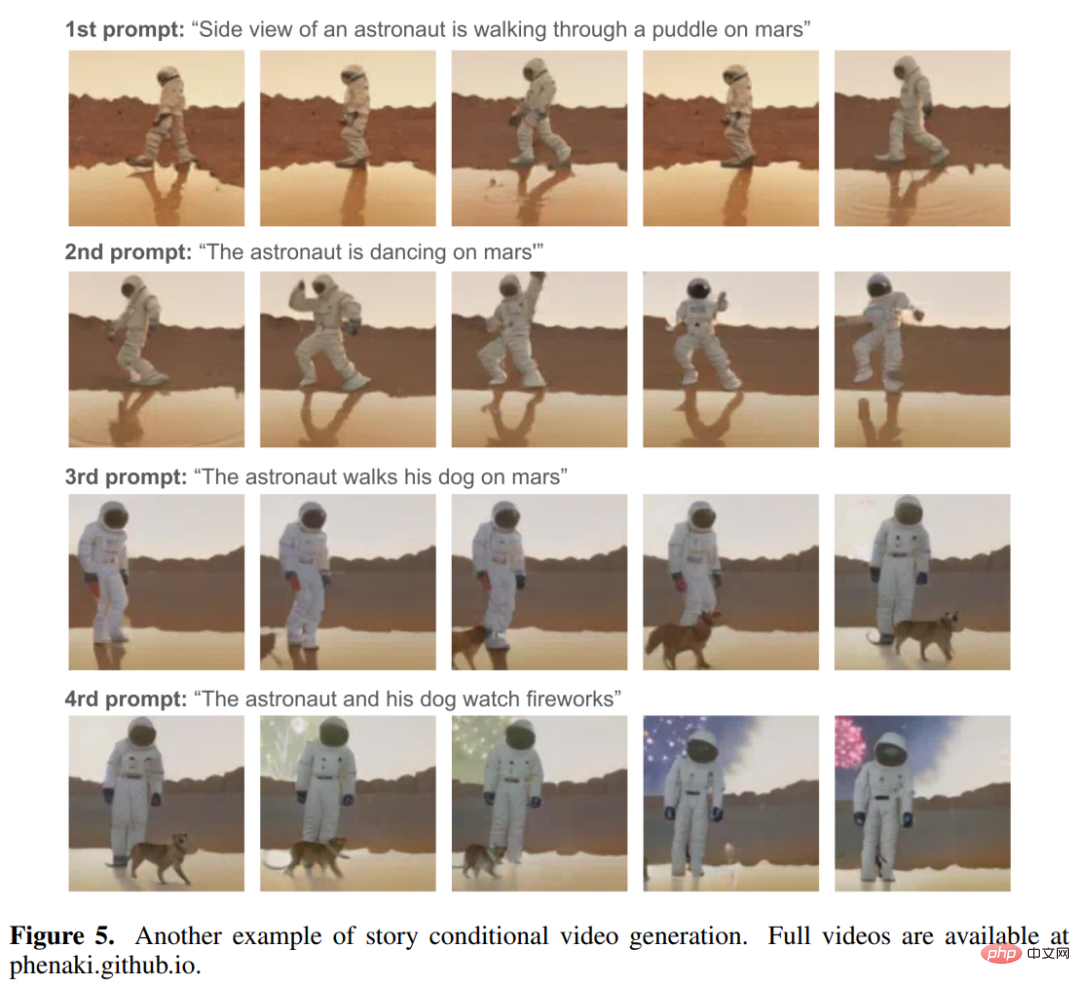

Forscher von Google und anderen Institutionen sagten: „Unseres Wissens wurde die geschichtenbasierte bedingte Videogenerierung noch nie zuvor erforscht, und dies ist die erste frühe Arbeit, die sich diesem Ziel nähert.“ Da es keine geschichtenbasierten Datensätze gibt, aus denen man lernen könnte, haben Forscher keine Möglichkeit, sich einfach auf traditionelle Deep-Learning-Methoden (einfaches Lernen aus Daten) zu verlassen, um diese Aufgaben zu erledigen. Deshalb haben sie speziell für diese Aufgabe ein Modell entworfen. Dieses neue Text-zu-Video-Modell heißt Phenaki und verwendet „Text-zu-Video“- und „Text-zu-Bild“-Daten zum gemeinsamen Training. Das Modell verfügt über die folgenden Funktionen: 1 Generieren Sie zeitlich kohärente, vielfältige Videos unter der Bedingung einer offenen Domänenaufforderung, auch wenn es sich bei der Aufforderung um eine neue Konzeptkombination handelt (siehe Abbildung 3 unten). Das generierte Video kann mehrere Minuten lang sein, auch wenn das zum Training des Modells verwendete Video nur 1,4 Sekunden lang ist (8 Bilder/Sekunde). ), wie in Abbildung 1 und unten in Abbildung 5 dargestellt:

Anhand der folgenden Animation können wir die Kohärenz und Vielfalt der von Phenaki generierten Videos erkennen: Um diese Funktionen zu implementieren, recherchieren Sie. Sie können sich nicht auf vorhandene Video-Encoder verlassen, da diese Encoder nur Videos mit fester Größe dekodieren oder Frames unabhängig kodieren können. Um dieses Problem zu lösen, führten sie eine neue Encoder-Decoder-Architektur ein – C-ViViT. Die zeitliche Redundanz im Video nutzen, um die Rekonstruktionsqualität jedes Frame-Modells zu verbessern und gleichzeitig die Anzahl der Video-Tokens um 40 % oder mehr zu komprimieren; Ermöglicht die Kodierung und Dekodierung von Videos variabler Länge bei gegebener Kausalstruktur. Inspiriert durch frühere Forschungen zu autoregressivem Text-zu-Bild und Text-zu-Video besteht Phenakis Design hauptsächlich aus zwei Teilen (siehe Abbildung 2 unten): Einer komprimiert das Video in Diskret Ein Encoder-Decoder-Modell für die Einbettung (d. h. Token) und ein Transformatormodell, das die Texteinbettung in ein Video-Token umwandelt. Eine komprimierte Darstellung eines Videos zu erhalten, ist eine der größten Herausforderungen bei der Erstellung von Videos aus Text. Frühere Arbeiten verwendeten entweder Bildencoder pro Frame wie VQ-GAN oder Videoencoder mit fester Länge wie VideoVQVAE. Ersteres ermöglicht die Generierung von Videos beliebiger Länge, in der Praxis müssen die Videos jedoch kurz sein, da der Encoder das Video nicht rechtzeitig komprimieren kann und die Token in aufeinanderfolgenden Frames hochredundant sind. Letzteres ist hinsichtlich der Anzahl der Token effizienter, ermöglicht jedoch nicht die Generierung von Videos beliebiger Länge. In Phenaki besteht das Ziel des Forschers darin, Videos variabler Länge zu generieren und gleichzeitig die Anzahl der Video-Tokens so weit wie möglich zu komprimieren, damit das Transformer-Modell innerhalb der aktuellen Einschränkungen der Rechenressourcen verwendet werden kann. Zu diesem Zweck führen sie C-ViViT ein, eine kausale Variante von ViViT mit zusätzlichen Architekturänderungen für die Videogenerierung, die Videos sowohl in zeitlicher als auch in räumlicher Dimension komprimieren kann und gleichzeitig die zeitliche Autoregression beibehält. Diese Funktion ermöglicht die Generierung autoregressiver Videos beliebiger Länge. Um Texteinbettungen zu erhalten, verwendet Phenaki auch ein vorab trainiertes Sprachmodell – T5X. Bitte beachten Sie das Originalpapier für spezifische Details.

C-ViViT kann:

C-ViViT kann:

Das obige ist der detaillierte Inhalt vonGoogle war der Bildgenerierung überdrüssig und wandte sich der Text-Video-Generierung zu, zwei leistungsstarken Tools, die gleichzeitig Auflösung und Länge herausfordern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!