Kürzlich ist ein AI-Nachtszenen-Aufnahmevideo von Google viral gegangen!

Die Technologie im Video heißt RawNeRF und ist, wie der Name schon sagt, eine neue Variante von NeRF.

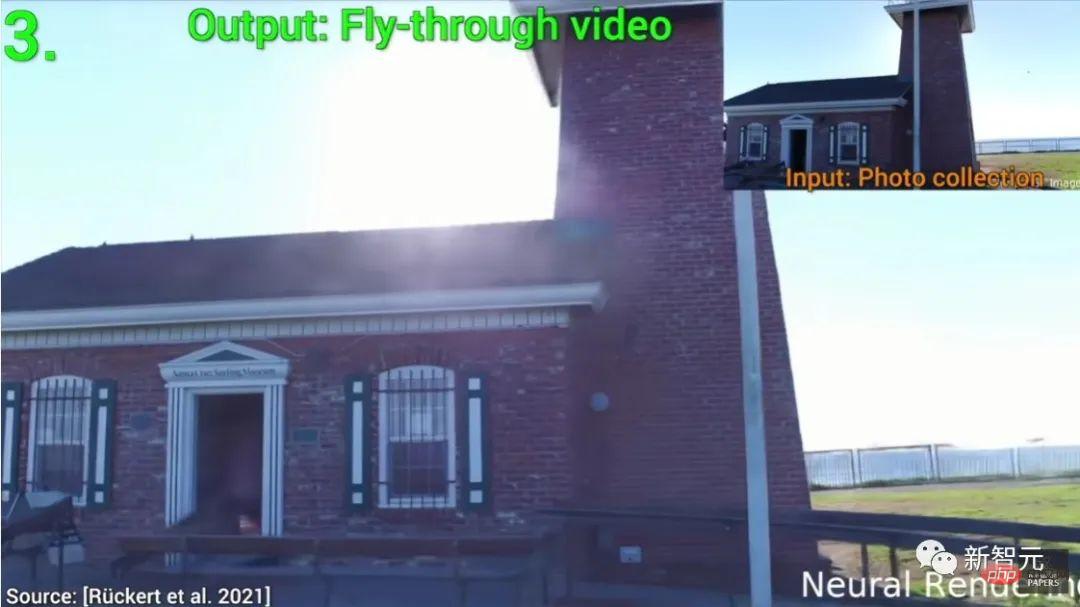

NeRF ist ein vollständig verbundenes neuronales Netzwerk, das 2D-Bildinformationen als Trainingsdaten zur Wiederherstellung von 3D-Szenen verwendet.

RawNeRF hat viele Verbesserungen im Vergleich zum vorherigen NeRF. Es reduziert nicht nur das Rauschen perfekt, sondern verändert auch die Kameraperspektive und passt Fokus, Belichtung und Tonwertzuordnung an. Dieses Papier von Google wurde im November 2021 veröffentlicht und in CVPR 2022 aufgenommen.

Projektadresse: https://bmild.github.io/rawnerf/

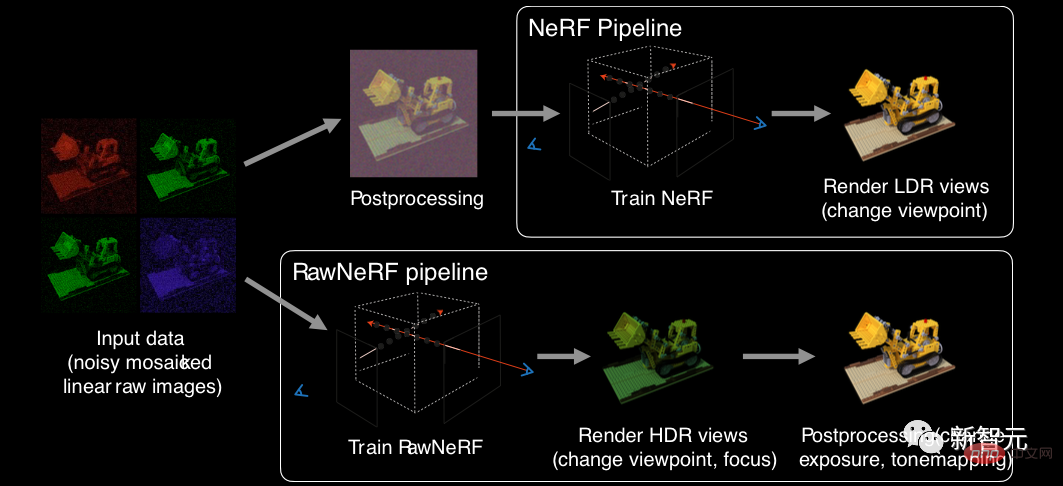

Zuvor war NeRF ein LDR-Bild mit niedrigem Dynamikbereich, das Tone Mapping als Eingabe verwendete .

Googles RawNeRF trainiert stattdessen direkt auf linearen Rohbildern, wodurch der volle Dynamikbereich der Szene erhalten bleiben kann.

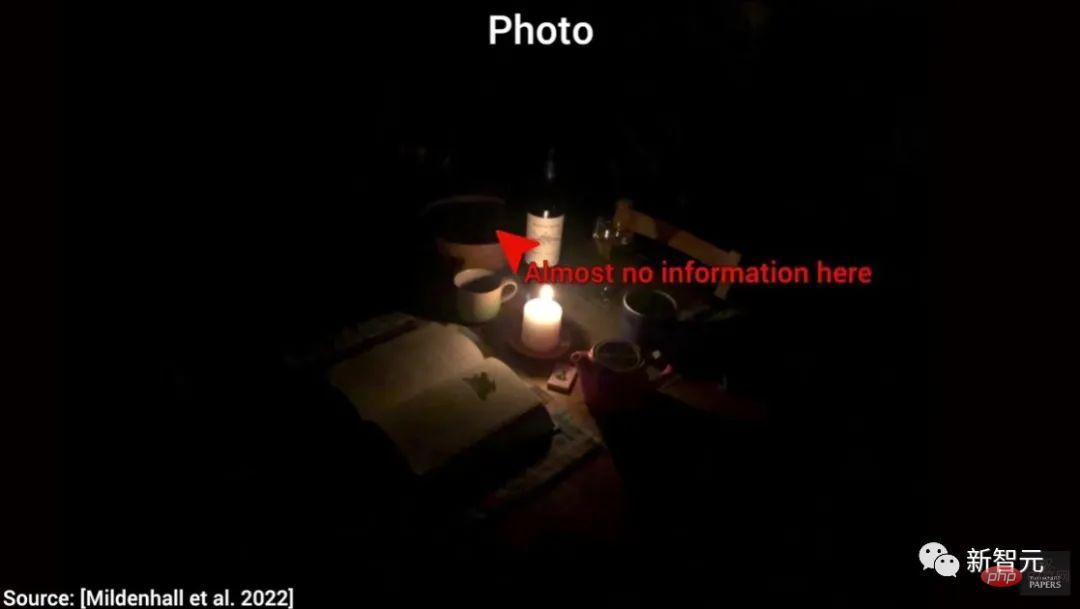

Im Bereich der zusammengesetzten Ansichten war der Umgang mit dunklen Fotos schon immer ein Problem.

Weil in diesem Fall das Bild nur minimale Details enthält. Und diese Bilder machen es schwierig, neue Ansichten zusammenzufügen.

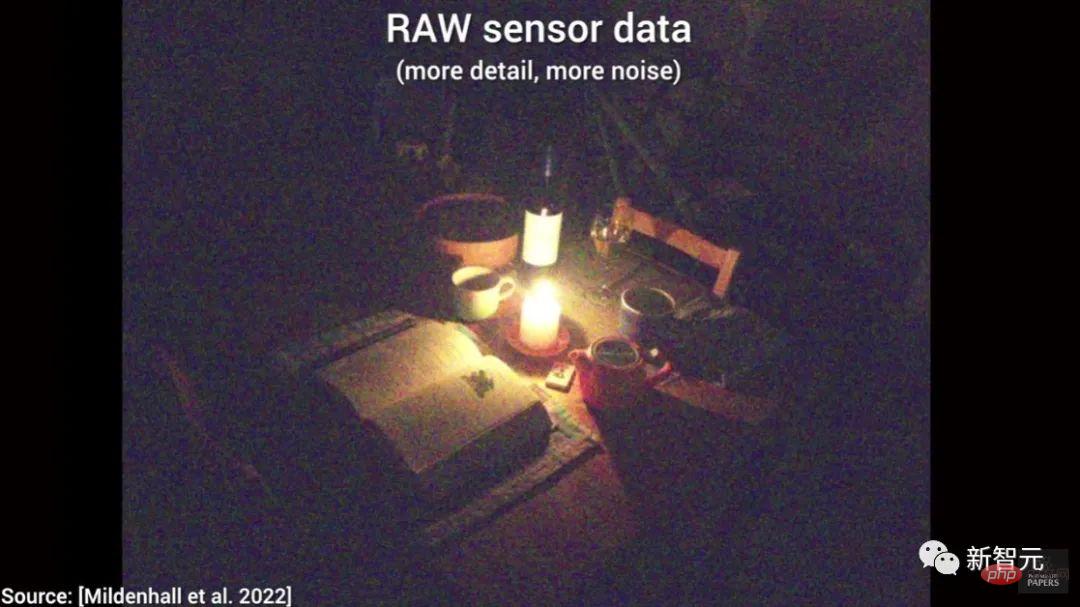

Glücklicherweise haben wir eine neue Lösung – die Nutzung roher Sensordaten.

Es ist ein Bild wie dieses, also haben wir mehr Details.

Allerdings gibt es immer noch ein Problem: Es gibt zu viel Lärm.

Also müssen wir eine Wahl treffen: weniger Details und weniger Rauschen oder mehr Details und mehr Rauschen.

Die gute Nachricht ist: Wir können die Bildrauschunterdrückungstechnologie nutzen.

Sie können sehen, dass der Bildeffekt nach der Rauschunterdrückung gut ist, aber für zusammengesetzte Ansichten reicht diese Qualität immer noch nicht aus.

Die Bildentrauschungstechnologie bringt uns jedoch auf eine Idee: Da wir ein einzelnes Bild entrauschen können, können wir auch eine Gruppe von Bildern entrauschen.

Werfen wir einen Blick auf die Wirkung von RawNeRF.

Und es verfügt über weitere erstaunliche Funktionen: Tone Mapping der zugrunde liegenden Daten, um mehr Details aus dunklen Bildern zu extrahieren.

Ändern Sie beispielsweise den Fokus des Bildes, um einen tollen Tiefenschärfeeffekt zu erzielen.

Was noch erstaunlicher ist, ist, dass dies in Echtzeit geschieht.

Außerdem ändert sich auch die Belichtung des Bildes entsprechend, wenn sich der Fokus ändert!

Als nächstes werfen wir einen Blick auf fünf klassische Anwendungsszenarien von RawNeRF.

1. Bildklarheit

Wenn Sie sich dieses Bild ansehen, können Sie die Informationen auf dem Straßenschild erkennen?

Sie können sehen, dass nach der RawNeRF-Verarbeitung die Informationen auf den Verkehrsschildern viel klarer sind.

In der Animation unten können wir deutlich den Unterschied in der Bildsynthese zwischen der ursprünglichen NeRF-Technologie und RawNeRF erkennen.

Tatsächlich ist das sogenannte NeRF keine so alte Technologie, es ist erst 2 Jahre her...

Man sieht, dass RawNeRF bei der Highlight-Verarbeitung immer noch sehr gut abschneidet können wir sogar sehen, wie sich die Hervorhebung um das Nummernschild in der unteren rechten Ecke ändert.

2. Glanzlichter

Spiegelglanzlichter sind sehr schwer einzufangen, da sie sich stark verändern, wenn Sie die Kamera bewegen, und der relative Abstand zwischen den Fotos auch relativ groß ist. Diese Faktoren stellen große Herausforderungen für Lernalgorithmen dar.

Wie Sie im Bild unten sehen können, kann man sagen, dass das von RawNeRF erzeugte Glanzlicht ziemlich wiederhergestellt ist.

3. Dünne Struktur

Selbst in einem gut beleuchteten Szenario zeigte die vorherige Technologie den Zaun nicht gut an.

Und RawNeRF kommt mit Nachtfotos mit einer Reihe von Zäunen klar und kann mithalten.

Selbst dort, wo der Zaun das Nummernschild überlappt, ist die Wirkung immer noch sehr gut.

4. Spiegelnde Reflexion

Die Reflexion auf der Straße ist ein anspruchsvolleres spiegelndes Highlight. Wie Sie sehen, geht RawNeRF auch sehr natürlich und realistisch damit um.

5. Fokus ändern, Belichtung anpassen

In dieser Szene versuchen wir, die Perspektive zu ändern, den Fokus ständig zu ändern und gleichzeitig die Belichtung anzupassen.

Um diese Aufgaben zu erledigen, brauchten wir früher eine Sammlung von 25 bis 200 Fotos.

Jetzt brauchen wir nur noch ein paar Sekunden, um das Shooting abzuschließen.

Natürlich ist RawNeRF jetzt nicht perfekt. Wir können sehen, dass es immer noch einige Unterschiede zwischen dem RawNeRF-Bild links und dem echten Foto rechts gibt.

Allerdings hat RAWnerf erhebliche Fortschritte gemacht, von einer Reihe von Originalbildern voller Rauschen bis zum aktuellen Effekt. Wissen Sie, die Technologie war vor zwei Jahren dazu überhaupt nicht in der Lage.

Um kurz darauf einzugehen: Die NeRF-Trainingspipeline empfängt von der Kamera verarbeitete LDR-Bilder und die anschließende Szenenrekonstruktion und Ansichtswiedergabe basieren auf dem LDR-Farbraum. Daher wurde die Ausgabe von NeRF tatsächlich nachbearbeitet und es ist unmöglich, sie wesentlich zu ändern und zu bearbeiten.

Im Gegensatz dazu wird RawNeRF direkt auf linearen Roh-HDR-Eingabedaten trainiert. Das resultierende Rendering kann wie jedes Originalfoto bearbeitet werden, indem Fokus und Belichtung usw. geändert werden.

Die Hauptvorteile, die sich dadurch ergeben, sind zwei Punkte: HDR-Ansichtssynthese und Rauschunterdrückungsverarbeitung.

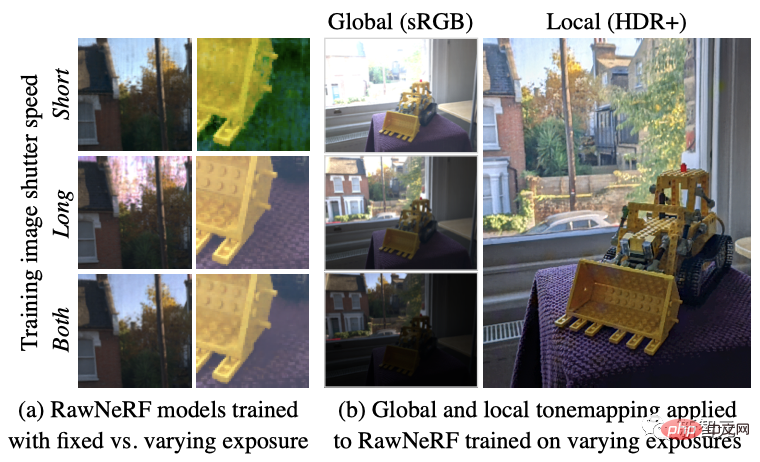

Bei Szenen mit extremen Helligkeitsschwankungen reicht eine feste Verschlusszeit nicht aus, um den vollen Dynamikumfang einzufangen. Das RawNeRF-Modell kann sowohl Kurz- als auch Langzeitbelichtungen gleichzeitig optimieren, um den vollen Dynamikumfang wiederherzustellen.

Zum Beispiel erfordert die Szene mit großem Lichtverhältnis in (b) einen komplexeren lokalen Tone-Mapping-Algorithmus (z. B. HDR + Nachbearbeitung), um die Details der dunklen Teile und die Highlights im Freien gleichzeitig zu bewahren.

Darüber hinaus kann RawNeRF synthetische Defokussierungseffekte mit korrekt gesättigten „unscharfen“ Glanzlichtern mithilfe linearer Farben rendern.

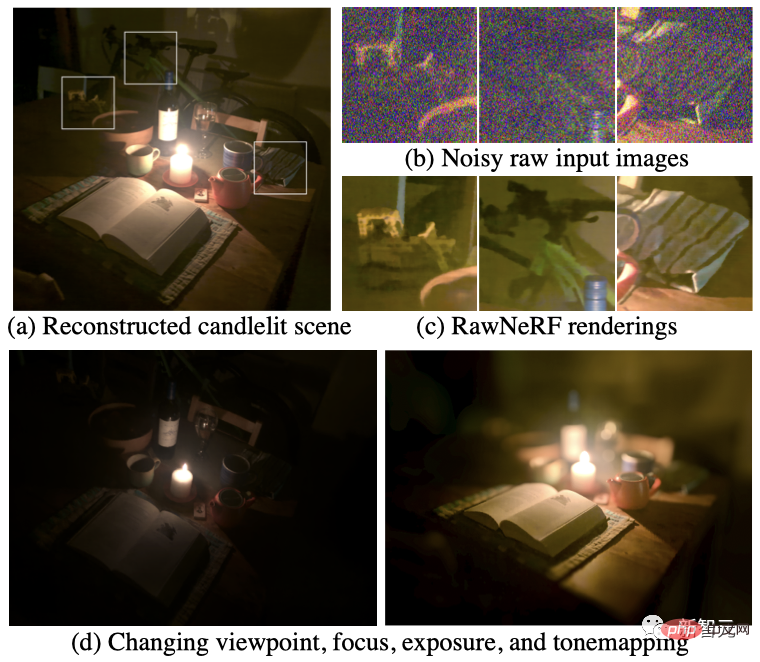

In Bezug auf die Bildrauschenverarbeitung hat der Autor RawNeRF an völlig unverarbeiteten linearen HDR-Originalbildern weiter trainiert und daraus einen Algorithmus gemacht, der Dutzende oder sogar Hunderte von Eingabebildern verarbeiten kann.

Diese Robustheit bedeutet, dass RawNeRF die Aufgabe der Rekonstruktion von Szenen im Dunkeln hervorragend bewältigen kann.

In (a) dieser Nachtszene, die nur von einer Kerze beleuchtet wird, kann RawNeRF beispielsweise Details aus den verrauschten Rohdaten extrahieren, die sonst durch die Nachbearbeitung zerstört würden (b, c).

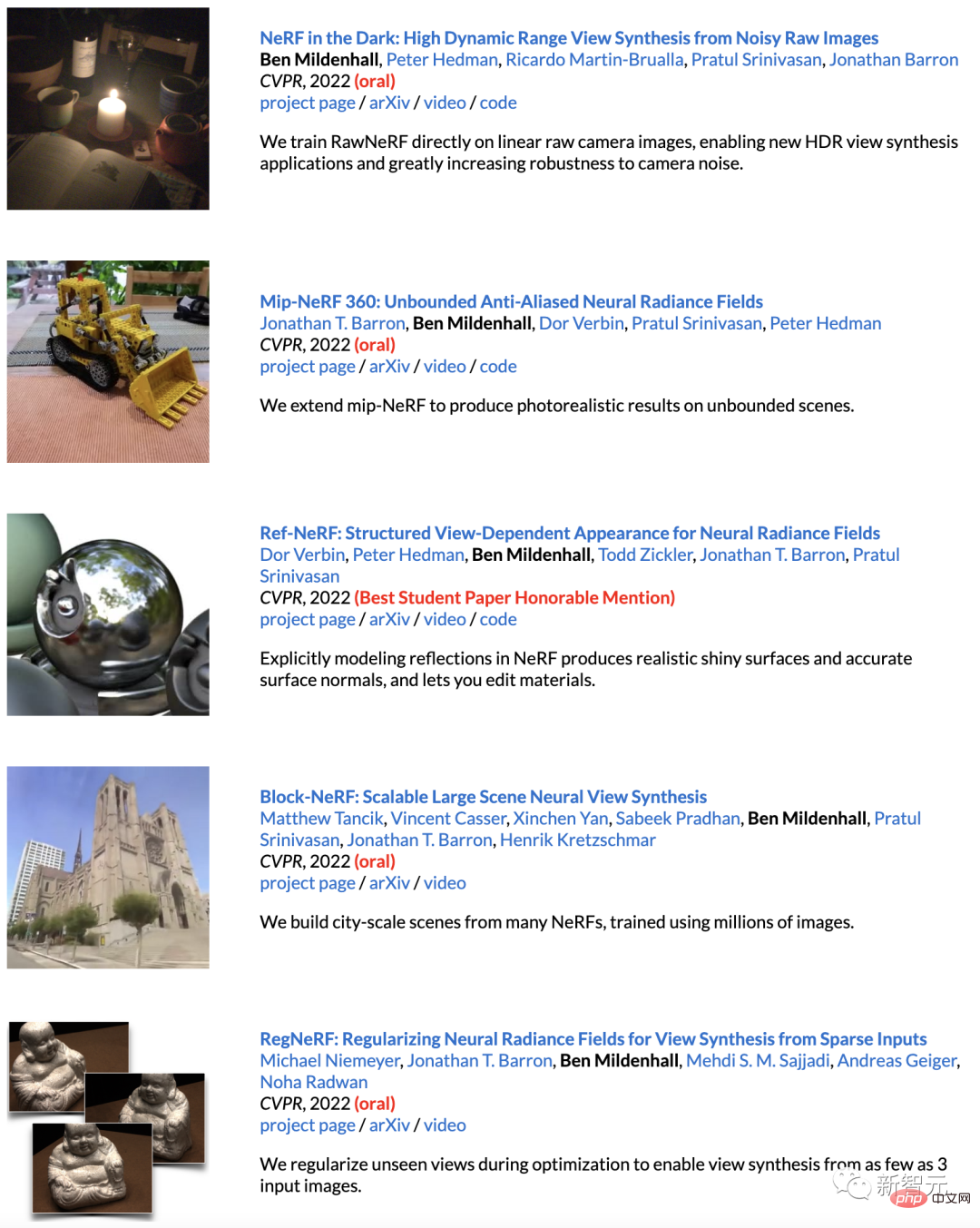

Vorstellung des Autors

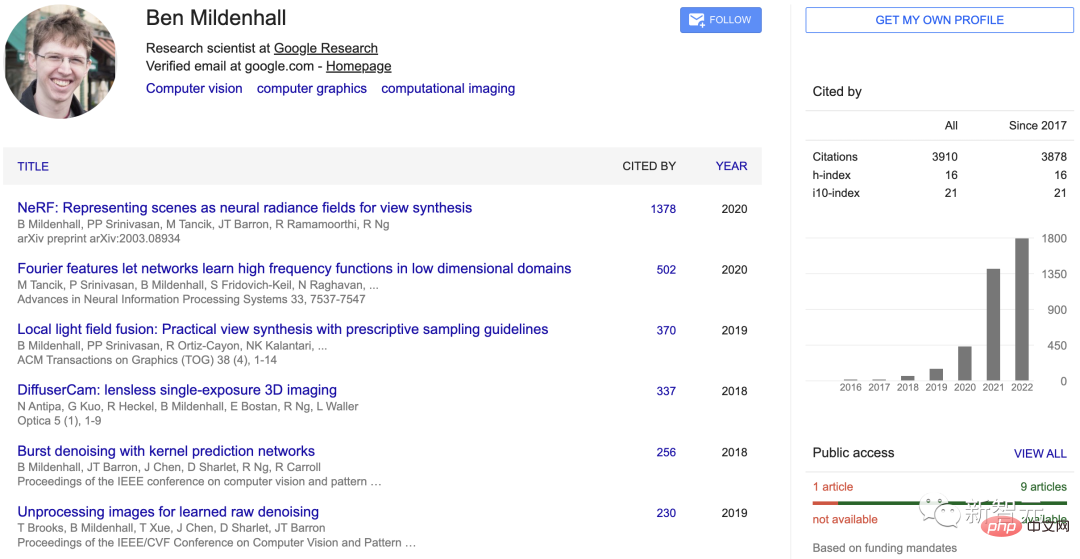

Der Erstautor des Artikels, Ben Mildenhall, ist ein Forschungswissenschaftler bei Google Research, der sich mit Computer Vision und Grafikthemen beschäftigt.

Er erhielt 2015 einen Bachelor-Abschluss in Informatik und Mathematik von der Stanford University und 2020 einen Ph.D. in Informatik von der University of California, Berkeley.

Das gerade zu Ende gegangene CVPR 2022 kann als Bens Höhepunkt bezeichnet werden.

5 der 7 angenommenen Arbeiten gewannen die mündliche Prüfung, und eine erhielt die lobende Erwähnung für die beste Studentenarbeit.

Sobald das Video herauskam, überraschte es sofort alle Netizens. Lasst uns alle gemeinsam Spaß haben.

Angesichts der Geschwindigkeit des technologischen Fortschritts wird es nicht lange dauern, bis Sie sich keine Sorgen mehr um das Fotografieren bei Nacht machen müssen~

Das obige ist der detaillierte Inhalt vonGoogles unglaubliche „Nachtsicht'-Kamera wurde plötzlich populär! Perfekte Rauschunterdrückung und 3D-Perspektivsynthese. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Eigenschaften des Netzwerks

Eigenschaften des Netzwerks

So behalten Sie die Anzahl der Dezimalstellen in C++ bei

So behalten Sie die Anzahl der Dezimalstellen in C++ bei

So richten Sie die automatische Aktualisierung einer Webseite ein

So richten Sie die automatische Aktualisierung einer Webseite ein

So lösen Sie ungültige Syntax in Python

So lösen Sie ungültige Syntax in Python

So werden Sie auf TikTok ein enger Freund

So werden Sie auf TikTok ein enger Freund

Freelaunchbar

Freelaunchbar

Webserver

Webserver

Wie viel entspricht Dimensity 9000 Snapdragon?

Wie viel entspricht Dimensity 9000 Snapdragon?