目录

推荐#🎜 🎜#:该研究发现 ESM2 的新蛋白质. 🎜🎜#

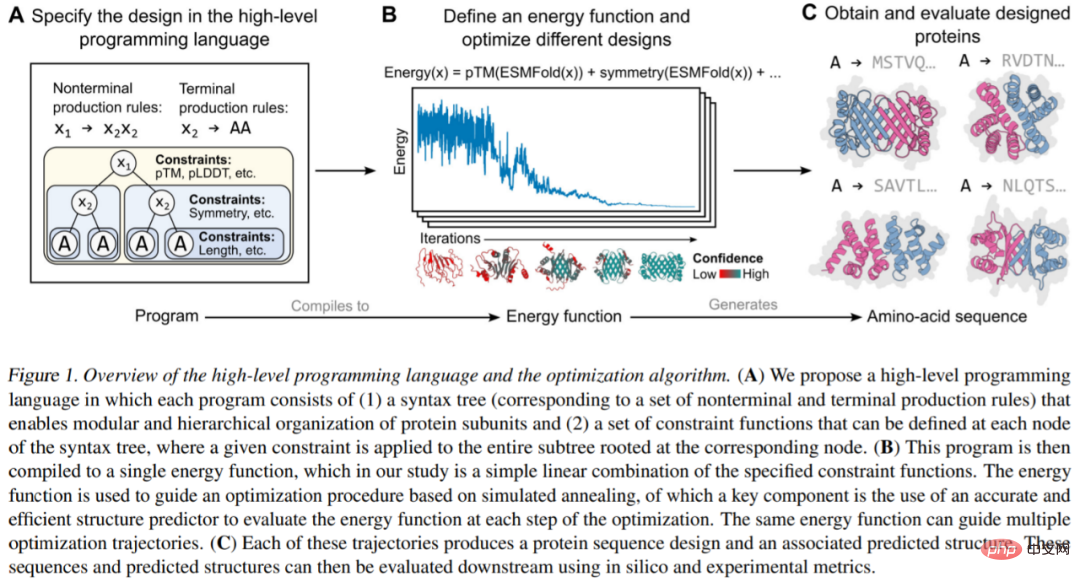

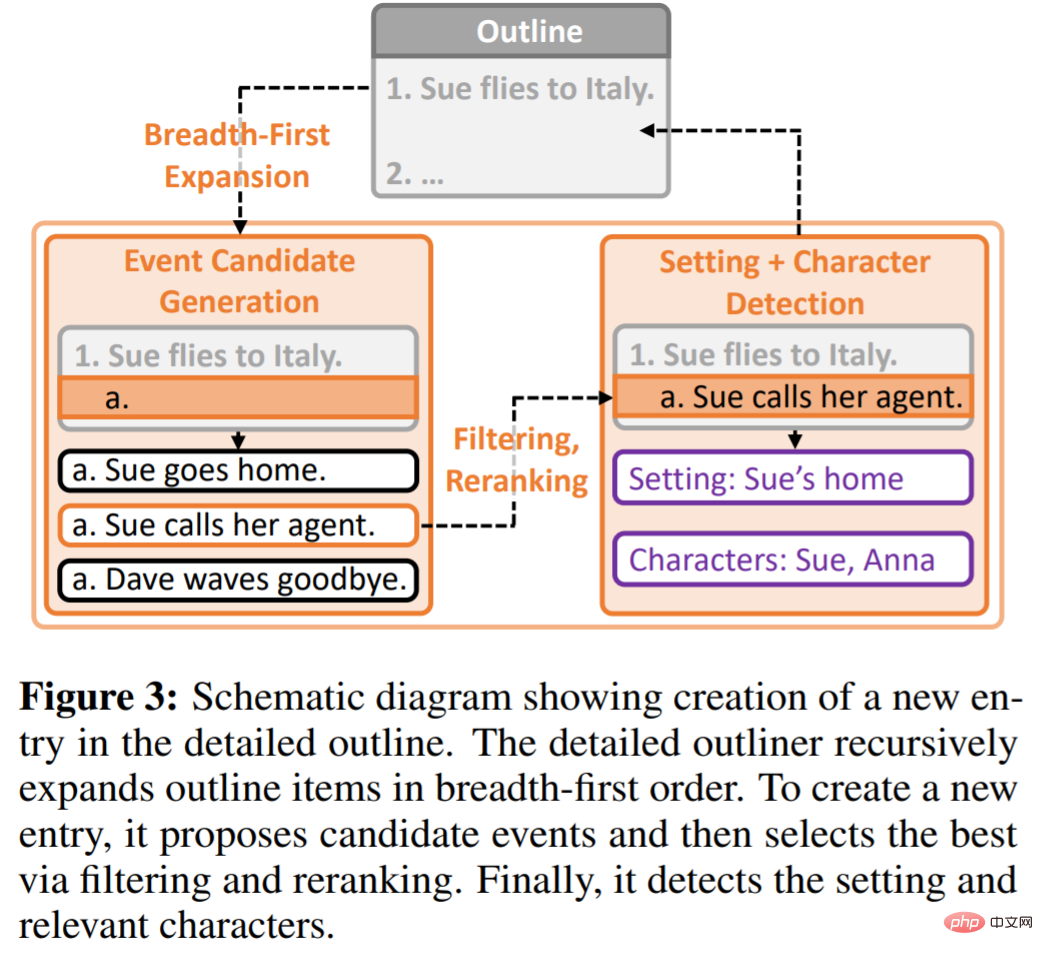

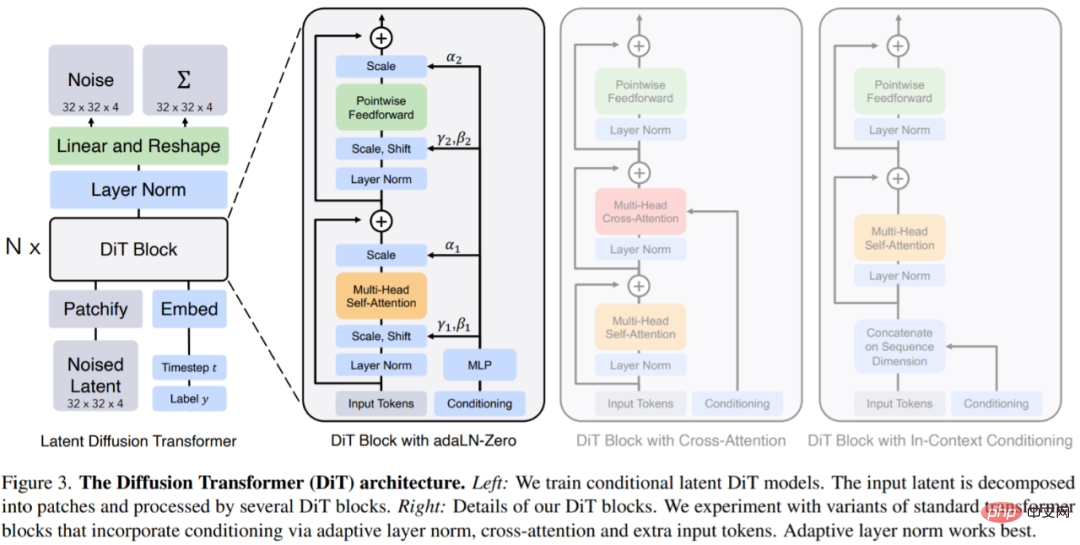

他们提出的生成蛋白质设计的编程语言,允许设计人员指定直观、模块化和(即树的内部节点) 组成,前者对应一个独特的蛋白质序列 (在蛋白质中可能重复),后者支持分层组织. Darüber hinaus ist ein energiebasiertes Erzeugungsmodell erforderlich. Zunächst spezifiziert Protein Designer ein High-Level-Programm, das aus einer Reihe hierarchisch organisierter Einschränkungen besteht (Abbildung 1A). Das Programm wird dann in eine Energiefunktion kompiliert, die zur Bewertung der Kompatibilität mit Einschränkungen verwendet wird, die willkürlich und nicht differenzierbar sind (Abbildung 1B). Schließlich kann durch die Integration von Strukturvorhersagen auf atomarer Ebene (unterstützt durch Sprachmodelle) in Energiefunktionen eine große Anzahl komplexer Proteindesigns generiert werden (Abbildung 1C). Empfohlen: Programmieren Sie komplexe und modulare Proteinstrukturen programmgesteuert. Papier 3: DOC: Verbesserung der Kohärenz langer Geschichten mit detaillierter Gliederungskontrolle Abstract: Vor einiger Zeit wurde Re^3 veröffentlicht, ein Sprachmodell, das den menschlichen Schreibprozess nachahmt. Dieses Modell erfordert keine Feinabstimmung von großen Modellen, erzeugt aber Konsistenz durch die Gestaltung starker Geschichten. Jetzt hat das Forschungsteam ein neues Modell-DOC zur Generierung von Geschichten vorgeschlagen. Die Autoren des Papiers, Kevin Yang und Tian Yuandong, posteten ebenfalls auf Twitter, um für das DOC-Modell zu werben, und sagten, dass die von DOC generierten Geschichten kohärenter und interessanter seien als die von Re^3 generierten. DOC-Framework bedeutet Detaillierte Gliederungskontrolle, die zur Verbesserung der Handlungskohärenz bei der automatischen Generierung von Geschichten mit mehreren Tausend Wörtern verwendet wird. DOC besteht aus zwei komplementären Komponenten: Detaillierter Outliner und Detaillierter Controller. Detailed Outliner ist für die Erstellung detaillierter, hierarchisch strukturierter Gliederungen verantwortlich, die Schreibideen von der Entwurfs- in die Planungsphase bringen. Der Detaillierte Controller stellt sicher, dass die generierten Ergebnisse der detaillierten Gliederung folgen, indem er die Ausrichtung der Story-Absätze an den Gliederungsdetails steuert. Die Studie führte eine manuelle Bewertung der Fähigkeit des Modells durch, automatisch Geschichten zu generieren, und DOC erzielte erhebliche Fortschritte bei mehreren Indikatoren: Handlungskohärenz (22,5 %), Gliederungsrelevanz (28,2 %) und Interesse (20,7 %). Das ist viel besser als das Re^3-Modell. Darüber hinaus ist DOC in einer interaktiven Build-Umgebung einfacher zu steuern. Empfehlung: Eine weitere neue Arbeit von Tian Yuandong und anderen ursprünglichen Teammitgliedern: KI generiert lange Geschichten, und lange Artikel mit Tausenden von Wörtern können zusammenhängend und interessant sein. Papier 4: Skalierbare Diffusionsmodelle mit Transformatoren Abstract: In diesem Artikel haben William Peebles von der UC Berkeley und Xie Saining von der New York University „Scalable Diffusion Models with Transformers“ geschrieben. Ziel ist es, die Bedeutung architektonischer Entscheidungen in Diffusionsmodellen aufzudecken und Informationen bereitzustellen für zukünftige generative Modellforschung. Diese Studie zeigt, dass die induktive Vorspannung von U-Net für die Leistung von Diffusionsmodellen nicht entscheidend ist und leicht durch Standarddesigns wie Transformatoren ersetzt werden kann. Diese Forschung konzentriert sich auf eine neue Klasse transformatorbasierter Diffusionsmodelle: Diffusion Transformers (kurz DiTs). DiTs folgen den Best Practices von Vision Transformers (ViTs), mit einigen kleinen, aber wichtigen Anpassungen. Es hat sich gezeigt, dass DiT effizienter skaliert als herkömmliche Faltungsnetzwerke wie ResNet. In diesem Artikel wird insbesondere das Skalierungsverhalten von Transformer im Hinblick auf Netzwerkkomplexität und Probenqualität untersucht. Es wird gezeigt, dass es durch die Konstruktion und das Benchmarking des DiT-Designraums im Rahmen des Latent Diffusion Model (LDM)-Frameworks, bei dem das Diffusionsmodell innerhalb des Latentraums von VAE trainiert wird, möglich ist, das U-Net-Backbone erfolgreich durch einen Transformator zu ersetzen. Dieses Papier zeigt außerdem, dass DiT eine skalierbare Architektur für Diffusionsmodelle ist: Es besteht eine starke Korrelation zwischen der Netzwerkkomplexität (gemessen durch Gflops) und der Probenqualität (gemessen durch FID). Durch einfaches Erweitern von DiT und Trainieren eines LDM mit einem Backbone mit hoher Kapazität (118,6 Gflops) werden hochmoderne Ergebnisse von 2,27 FID auf dem klassenbedingten 256 × 256 ImageNet-Generierungsbenchmark erzielt. Empfehlung: Das U-Net, das das Diffusionsmodell dominiert, wird Transformer eingeführt und DiT vorgeschlagen. 🔜 :/ /arxiv.org/abs/2212.08751 Zusammenfassung Empfohlen: Dreidimensionale Text-zu-Bild-KI wird: Einzelne GPU wird in weniger als einer Minute ausgeliefert, von OpenAI. 🔜 /articles/s41586-020-2975-4 Abstract : Am 2. Dezember 2020 erschienen mehrere überraschende Worte auf dem Cover des Top-Wissenschaftsmagazins „Nature“: „Turning Back“ Time“ (turn Zeit zurück). Die Recherche auf dem Cover stammt vom Team von David Sinclair, einem ordentlichen Professor an der Harvard Medical School. Obwohl der Artikel nur wenige Seiten umfasst, zeigt er eine neue Perspektive auf: Die Verwendung von Gentherapie zur Neuprogrammierung von Ganglienzellen und zur Wiederherstellung jugendlicher epigenetischer Informationen, sodass sich der Sehnerv nach einer Schädigung regenerieren und den durch Glaukom und Alterung verursachten Sehverlust umkehren kann . David Sinclair sagte, dass das Forschungsziel des Teams immer darin bestand, die Alterung des Menschen zu verlangsamen und umzukehren und Krankheiten durch die Lösung der Ursachen und nicht der Symptome zu behandeln. Die neuesten Forschungsergebnisse stammen von David Sinclair und einem von ihm geleiteten Team von 60 Personen. Er sagte, dass Alterung wie Kratzer auf einer CD ist, die gelöscht werden können, oder beschädigte Software im System, die nur benötigt wird Umkehrungen können erreicht werden, genau wie im Lifespan-Buch. Im Preprint-Artikel gaben die Autoren an, dass alle Organismen im Laufe der Zeit genetische Informationen verlieren und nach und nach zelluläre Funktionen verlieren. Mithilfe eines gentechnisch veränderten Maussystems namens ICE (für Inducible Changes in the Epigenome) zeigen Forscher, dass der Prozess der Reparatur nicht mutagener DNA-Brüche altersbedingte physiologische, kognitive und molekulare Veränderungen beschleunigt, einschließlich der Expression. Beobachten Sie genetische Erosion und Zellverlust Fähigkeiten, Zellalterung usw. Epigenetische Neuprogrammierung durch ektopische Expression kann jugendliche Genexpressionsmuster wiederherstellen, sagen Forscher. Empfohlen Papier 7: Training von Robotern zur Bewertung von Robotern: Beispielbasierte interaktive Belohnungsfunktionen für das Lernen von Richtlinien #🎜🎜 #Autor: Kun Huang, Edward Hu, Dinesh Jayaraman Die Evaluierungsergebnisse zeigen, dass IRF durch den Zugriff auf Demos oder sorgfältig gestaltete Belohnungen erhebliche Leistungsverbesserungen erzielen und sogar die Ausgangswerte übertreffen kann. Im Bild unten muss der Roboter beispielsweise zuerst die Tür schließen und dann den symmetrischen Türgriff drehen, um die Tür vollständig zu verriegeln.

Das obige ist der detaillierte Inhalt vonCoRL 2022 Excellent Paper; Sprachmodell erzeugt Proteine, die in der Natur nicht vorkommen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Wie man unter Linux mit verstümmelten chinesischen Schriftzeichen umgeht

Wie man unter Linux mit verstümmelten chinesischen Schriftzeichen umgeht

Empfohlene Reihenfolge zum Erlernen von C++ und der C-Sprache

Empfohlene Reihenfolge zum Erlernen von C++ und der C-Sprache

So lösen Sie verstümmelte Zeichen in PHP

So lösen Sie verstümmelte Zeichen in PHP

Methode zur Reparatur von Datenbankzweifeln

Methode zur Reparatur von Datenbankzweifeln

Timeout-Lösung für Serveranfragen

Timeout-Lösung für Serveranfragen

IIS unerwarteter Fehler 0x8ffe2740 Lösung

IIS unerwarteter Fehler 0x8ffe2740 Lösung

navigator.useragent

navigator.useragent

So erhalten Sie ein Token

So erhalten Sie ein Token