Der Artikel diskutiert hauptsächlich, warum das überparametrisierte neuronale Netzwerkmodell eine gute Generalisierungsleistung haben kann? Das heißt, es merkt sich nicht einfach den Trainingssatz, sondern fasst eine allgemeine Regel aus dem Trainingssatz zusammen, sodass diese an den Testsatz angepasst werden kann (Verallgemeinerungsfähigkeit).

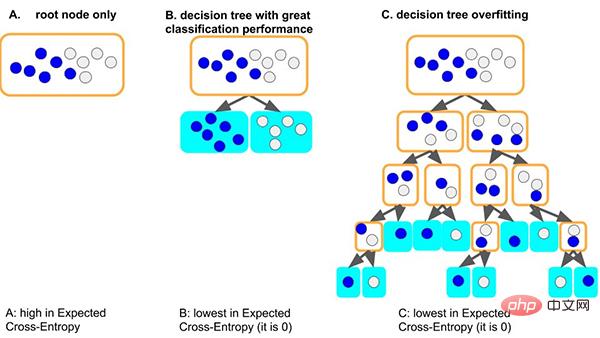

Nehmen Sie das klassische Entscheidungsbaummodell als Beispiel: Wenn das Baummodell die allgemeinen Regeln des Datensatzes lernt: Eine gute Situation ist, dass der Baum, wenn er zuerst den Knoten teilt, nur Proben mit unterschiedlichen Bezeichnungen gut unterscheiden kann Da die Tiefe sehr gering ist und die entsprechende Anzahl von Stichproben auf jedem Blatt ausreicht (dh die auf statistischen Regeln basierende Datenmenge ist ebenfalls relativ groß), ist es wahrscheinlicher, dass die erhaltenen Regeln auf andere Daten verallgemeinert werden . (d. h. gute Anpassungsfähigkeit und Generalisierungsfähigkeit).

Eine weitere schlimmere Situation besteht darin, dass, wenn der Baum einige allgemeine Regeln nicht lernen kann, der Baum zum Erlernen dieses Datensatzes immer tiefer wird und jeder Blattknoten einer kleinen Anzahl von Stichproben (weniger) entsprechen kann Die durch die Daten gelieferten statistischen Informationen können nur Rauschen sein. Und schließlich müssen alle Daten auswendig gelernt werden (d. h. Überanpassung und keine Verallgemeinerungsfähigkeit). Wir können sehen, dass zu tiefe Baummodelle leicht überpassen können.

Wie kann also ein überparametrisiertes neuronales Netzwerk eine gute Generalisierung erreichen?

Dieser Artikel erläutert aus einer einfachen und allgemeinen Perspektive die Gründe für die Generalisierungsfähigkeit im Gradientenabstiegsoptimierungsprozess neuronaler Netze:

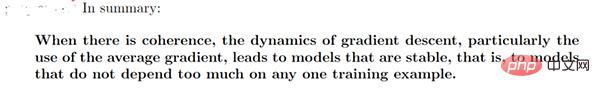

Wir haben die Gradientenkohärenztheorie zusammengefasst: Aus den Gradienten verschiedener Proben entsteht Kohärenz, weshalb neuronale Netze über gute Generalisierungsfähigkeiten verfügen. Wenn die Gradienten verschiedener Proben während des Trainings gut ausgerichtet sind, das heißt, wenn sie kohärent sind, ist der Gradientenabstieg stabil, kann schnell konvergieren und das resultierende Modell kann gut verallgemeinert werden. Andernfalls kann es zu keiner Verallgemeinerung kommen, wenn zu wenige Stichproben vorhanden sind oder die Trainingszeit zu lang ist.

Basierend auf dieser Theorie können wir die folgende Erklärung abgeben.

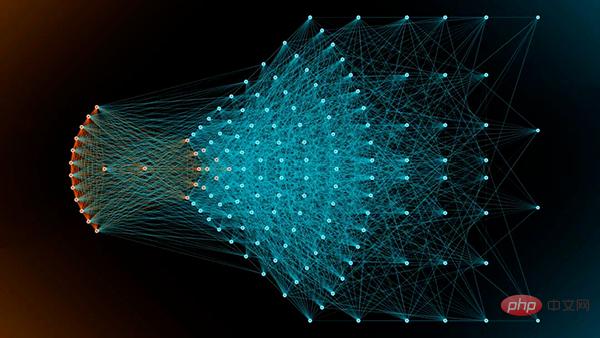

Modelle breiterer neuronaler Netze verfügen über gute Generalisierungsfähigkeiten. Dies liegt daran, dass größere Netzwerke über mehr Subnetzwerke verfügen und mit größerer Wahrscheinlichkeit eine Gradientenkohärenz erzeugen als kleinere Netzwerke, was zu einer besseren Generalisierung führt. Mit anderen Worten, der Gradientenabstieg ist ein Merkmalsselektor, der Generalisierungsgradienten (Kohärenzgradienten) priorisiert, und breitere Netzwerke können bessere Merkmale aufweisen, einfach weil sie mehr Merkmale haben.

Aber ich persönlich denke, es muss immer noch zwischen der Breite der Netzwerkeingabeschicht und der verborgenen Schicht unterschieden werden. Insbesondere für die Eingabeebene von Data-Mining-Aufgaben müssen Sie die Feature-Auswahl in Betracht ziehen (d. h. die Breite der Eingabeebene verringern), da die Eingabe-Features normalerweise manuell entworfen werden. Andernfalls wird die Gradientenkohärenz durch die direkte Eingabe von Feature-Rauschen beeinträchtigt . .

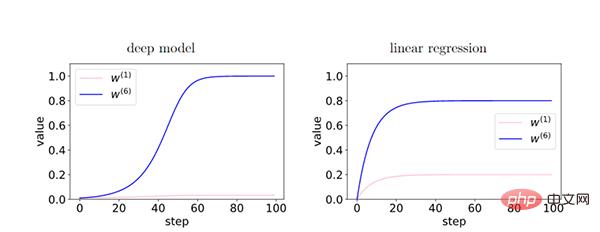

Je tiefer das Netzwerk ist, desto stärker wird das Phänomen der Gradientenkohärenz und die Generalisierungsfähigkeit ist besser.

Da im Tiefenmodell die Rückkopplung zwischen den Schichten den kohärenten Gradienten stärkt, besteht während des Trainingsprozesses ein relativer Unterschied zwischen den Merkmalen des kohärenten Gradienten (W6) und den Merkmalen des inkohärenten Gradienten (W1) Exponentiell verstärkt. Dies führt dazu, dass tiefere Netzwerke kohärente Gradienten bevorzugen, was zu besseren Generalisierungsfähigkeiten führt.

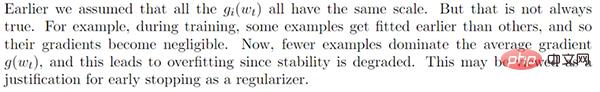

Durch frühes Stoppen können wir den übermäßigen Einfluss inkohärenter Gradienten reduzieren und die Generalisierung verbessern.

Während des Trainings passen einige einfache Proben früher als andere Proben (harte Proben). In der frühen Trainingsphase dominiert der Korrelationsgradient dieser einfachen Stichproben und lässt sich leicht anpassen. In der späteren Trainingsphase dominiert der inkohärente Gradient schwieriger Proben den durchschnittlichen Gradienten g (wt), was zu einer schlechten Generalisierungsfähigkeit führt. Zu diesem Zeitpunkt ist es notwendig, frühzeitig aufzuhören.

Wir haben festgestellt, dass ein vollständiger Gradientenabstieg auch eine gute Generalisierungsfähigkeit aufweisen kann. Darüber hinaus zeigen sorgfältige Experimente, dass der stochastische Gradientenabstieg nicht unbedingt zu einer besseren Verallgemeinerung führt. Dies schließt jedoch nicht die Möglichkeit aus, dass stochastische Gradienten eher aus lokalen Minima herausspringen, eine Rolle bei der Regularisierung spielen usw.

Wir glauben, dass eine niedrigere Lernrate den Generalisierungsfehler möglicherweise nicht verringert, da eine niedrigere Lernrate mehr Iterationen bedeutet (das Gegenteil des vorzeitigen Anhaltens).

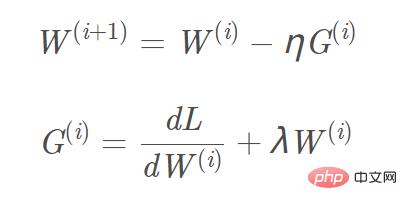

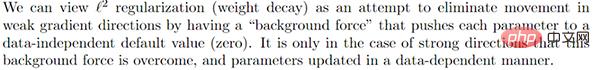

Wir können „L2-Regularisierung (Gewichtsabschwächung)“ als „Hintergrundkraft“ betrachten und jeden Parameter drücken nahe an einem datenunabhängigen Nullwert (mit L1 lässt sich leicht eine spärliche Lösung erhalten, mit L2 lässt sich leicht eine glatte Lösung nahe 0 erhalten), um den Einfluss in der Richtung des schwachen Gradienten zu eliminieren. Nur bei kohärenten Gradientenrichtungen können die Parameter relativ von der „Hintergrundkraft“ getrennt und die Gradientenaktualisierung auf Basis der Daten abgeschlossen werden.

2.6 Weiterentwicklung des Gradientenabstiegsalgorithmus

Momentum, Adam und andere Gradientenabstiegsalgorithmen

Momentum, Adam und andere Gradientenabstiegsalgorithmen

Zusammenfassung

Das obige ist der detaillierte Inhalt vonIn einem Artikel wird kurz die Generalisierungsfähigkeit von Deep Learning erörtert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Java ruft Webservice auf

Java ruft Webservice auf

Der Unterschied zwischen Bond0 und Bond1

Der Unterschied zwischen Bond0 und Bond1

Methode zum Öffnen einer Caj-Datei

Methode zum Öffnen einer Caj-Datei

Lösung für Syntaxfehler beim Ausführen von Python

Lösung für Syntaxfehler beim Ausführen von Python

HTML-Bildcode-Sammlung

HTML-Bildcode-Sammlung

Welche Konfigurationsmanagement-Tools gibt es?

Welche Konfigurationsmanagement-Tools gibt es?

Was bedeutet es, einen Drucker offline zu verwenden?

Was bedeutet es, einen Drucker offline zu verwenden?

So richten Sie die Domänennamenumleitung ein

So richten Sie die Domänennamenumleitung ein