Maschinelles Lernen (ML) hat zu einem grundlegenden Wandel in der Art und Weise geführt, wie wir Wissenschaft betreiben, und viele machen das Lernen aus Daten nun zu einem Schwerpunkt ihrer Forschung. Da die Komplexität der wissenschaftlichen Fragen, die wir untersuchen möchten, zunimmt und die Datenmenge, die durch heutige wissenschaftliche Experimente generiert wird, zunimmt, trägt ML dazu bei, traditionelle Arbeitsabläufe zu automatisieren, zu beschleunigen und zu verbessern. An der Spitze dieser Revolution steht ein Bereich namens Scientific Machine Learning (SciML). Das zentrale Ziel von SciML besteht darin, bestehende wissenschaftliche Erkenntnisse enger mit ML zu verknüpfen und leistungsstarke ML-Algorithmen zu generieren, die auf unserem Vorwissen basieren.

Papieradresse: https://ora.ox.ac.uk /objects/uuid:b790477c-771f-4926-99c6-d2f9d248cb23

Es gibt derzeit eine Reihe von Möglichkeiten, wissenschaftliche Prinzipien in zu integrieren ML und die Menschen Die Erwartungen an SciML, einige der größten Herausforderungen in der Wissenschaft zu lösen, steigen. Allerdings boomt das Fachgebiet und es stellen sich noch viele Fragen. Eine wichtige Frage ist, ob SciML-Methoden auf komplexere reale Probleme ausgeweitet werden können. Ein Großteil der SciML-Forschung befindet sich in der Proof-of-Concept-Phase, in der die Technologie an reduzierten, einfachen Problemen getestet wird. Für ihre breite Anwendung ist es jedoch entscheidend, ihre Skalierbarkeit auf komplexere Probleme zu verstehen. Diese Frage steht im Mittelpunkt dieses Artikels.

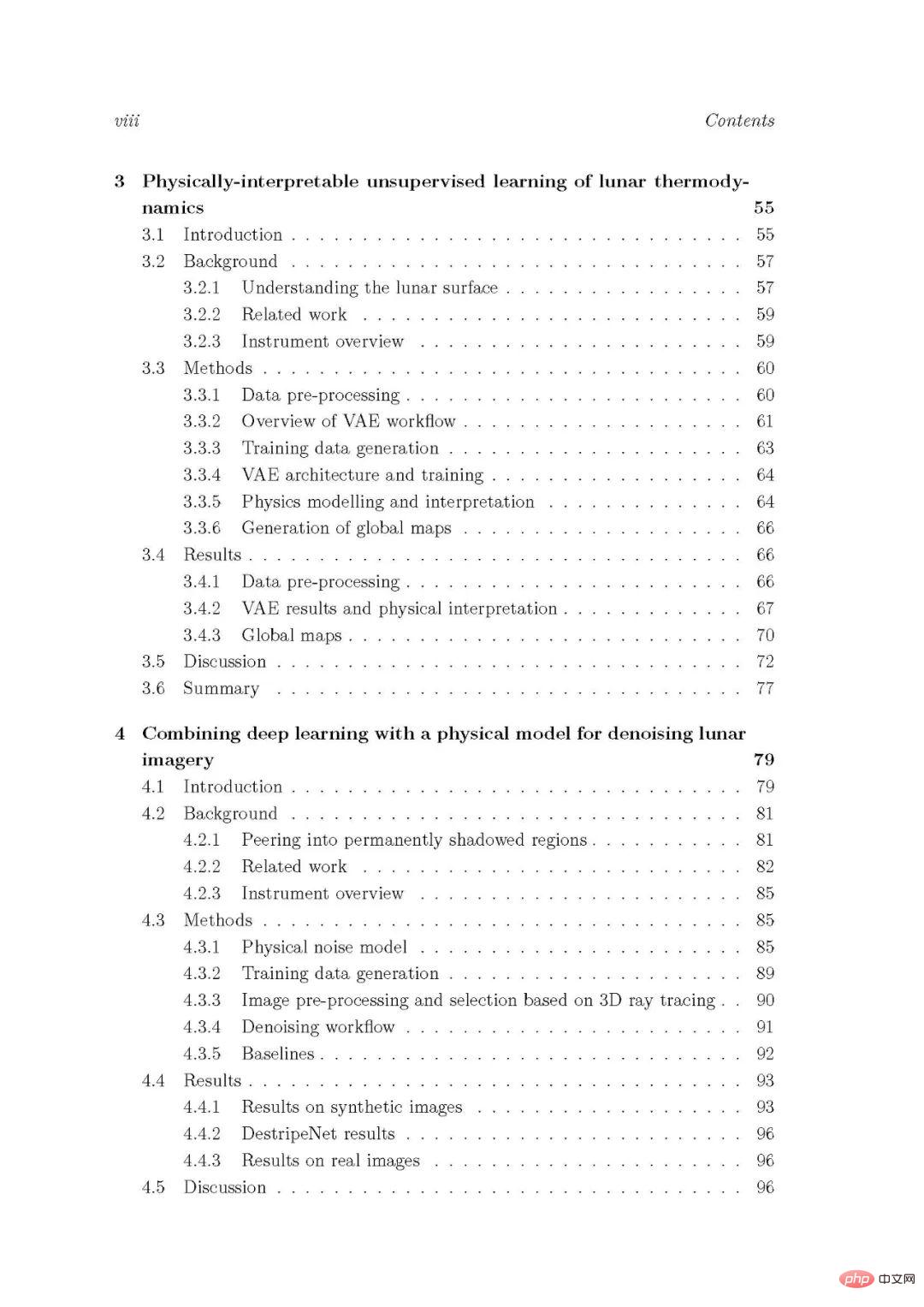

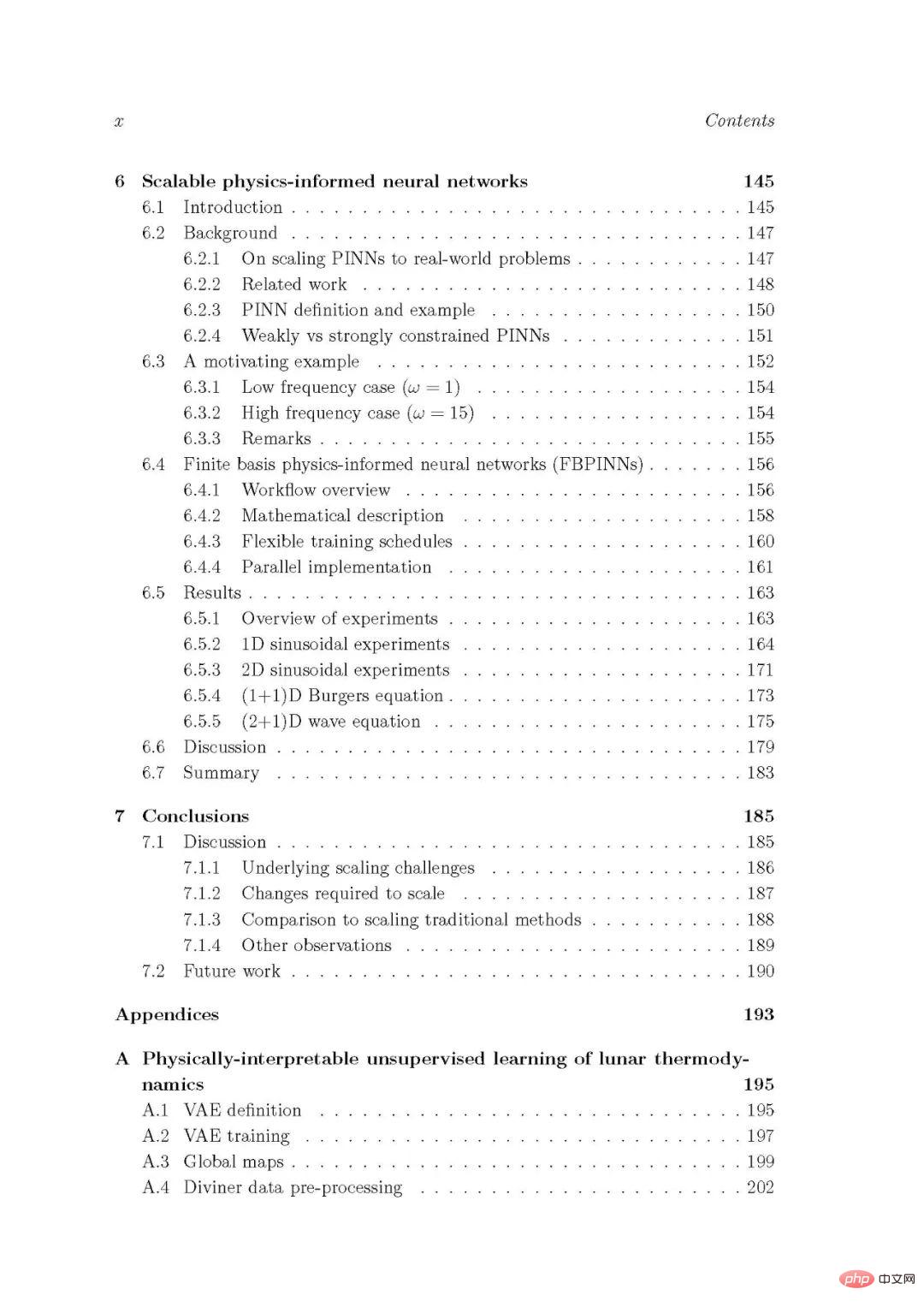

Zuerst werden mehrere komplexe, reale, domänenspezifische Fallstudien in der Mondwissenschaft und Geophysik entworfen Lernmethoden und bewerten deren Leistung und Skalierbarkeit. Zweitens wird die Skalierbarkeit physikinformierter neuronaler Netze, einer beliebten Allzweck-SciML-Methode, zur Lösung von Differentialgleichungen mit großen Regionen und Hochfrequenzlösungen bewertet und verbessert. Gemeinsame Beobachtungen aus diesen Studien werden diskutiert und wesentliche Vorteile und potenzielle Einschränkungen identifiziert, was die Bedeutung der Entwicklung skalierbarer SciML-Techniken hervorhebt.

Maschinelles Lernen (ML) hat eine Revolution im Bereich der Wissenschaft ausgelöst. Traditionell dreht sich die wissenschaftliche Forschung um Theorie und Experiment: Man schlägt eine handgefertigte und klar definierte Theorie vor, verfeinert sie dann kontinuierlich anhand experimenteller Daten und analysiert sie, um neue Vorhersagen zu treffen. Heutzutage legen jedoch viele Menschen den Schwerpunkt ihrer Forschung auf das Lernen aus Daten. Hier wird mithilfe von ML-Algorithmen ein Modell der Welt aus Daten erlernt, eine bestehende Theorie ist nicht erforderlich. Diese Verschiebung erfolgt aus verschiedenen Gründen.

Erstens hat der Bereich ML im letzten Jahrzehnt ein exponentielles Wachstum erlebt, und die wichtigsten treibenden Faktoren für diesen Anstieg sind wird oft auf Durchbrüche im Deep Learning zurückgeführt [Goodfellow et al., 2016]. Wichtige Entdeckungen wie die Verwendung tieferer Netzwerkdesigns und besserer Trainingsalgorithmen sowie die Verfügbarkeit leistungsfähigerer Computerarchitekturen haben zu raschen Verbesserungen der Leistung von Deep-Learning-Techniken bei einer Vielzahl von Problemen geführt [Dally et al., 2021] . Moderne ML-Algorithmen sind mittlerweile in der Lage, unglaublich komplexe Aufgaben zu lernen und zu lösen, von selbstfahrenden Autos [Schwarting et al., 2018] bis hin zum Sieg über Weltklasse-Go-Spieler [Silver et al., 2018].

Mit diesen Fortschritten generieren die heutigen wissenschaftlichen Experimente immer mehr Daten und untersuchen immer komplexere Phänomene [ Baker et al., 2019, Hey et al., 2020]. Das Analysieren und Theoretisieren all dieser Daten wird für Menschen und unsere traditionellen Arbeitsabläufe schnell unmöglich, und bald könnten wissenschaftliche Experimente durch ihre Fähigkeit eingeschränkt sein, Erkenntnisse aus den Daten zu gewinnen, die sie bereits haben, und nicht mehr durch das, was sie sammeln können. [Baker et al., 2019]. Angesichts der leistungsstarken Tools, die ML bieten kann, wenden sich viele Forscher an ML, um traditionelle Arbeitsabläufe zu automatisieren, zu beschleunigen und zu verbessern. Im letzten Jahrzehnt hat die Kombination aus neuen ML-Algorithmen und Datenverfügbarkeit zu einigen großen wissenschaftlichen Fortschritten geführt. Beispielsweise wurde ML verwendet, um Proteinstrukturen genauer als je zuvor vorherzusagen [Jumper et al., 2021], Sprache aus neuronaler Aktivität zu synthetisieren [anummanchipalli et al., 2019] und Simulationen von Quanten-Vielteilchensystemen zu verbessern [Carleo und Troyer, 2017]. Tatsächlich werden moderne ML-Algorithmen mittlerweile auf fast jeden Aspekt der Wissenschaft angewendet, und eine der bestimmenden Forschungsfragen dieser Ära lautete: „Lösen Sie Problem X und wenden Sie ML darauf an“, gefolgt von interessanten und oft spannenden Ergebnissen.

Trotz dieser Fortschritte sind jedoch im Bereich ML verschiedene Mängel von ML, insbesondere Deep-Learning-Algorithmen, aufgetreten. Beispielsweise werden tiefe neuronale Netze trotz ihrer Fähigkeit, hochkomplexe Phänomene zu lernen, oft als „Black Boxes“ betrachtet, denen es an Verständnis dafür mangelt, wie sie die Welt darstellen und über sie nachdenken. Diese Uninterpretierbarkeit ist ein kritisches Problem, insbesondere für sicherheitskritische Anwendungen, die den Nachweis von Netzwerkvorhersagen erfordern [Gilpin et al., 2019, Castelvecchi, 2016]. Darüber hinaus gibt es kaum theoretische Anleitungen zum Entwurf von Deep-Learning-Algorithmen, die für bestimmte Aufgaben geeignet sind. Die Wahl der tiefen neuronalen Netzwerkarchitektur ist weitgehend empirisch, obwohl die Bereiche Meta-Learning und neuronale Architektursuche beginnen, automatisiertere Ansätze bereitzustellen [Elsken et al., 2019, Hospedales et al., 2021]. Obwohl tiefe neuronale Netze zwar sehr ausdrucksstark sind, sind sie durch die Trainingsdaten begrenzt und weisen außerhalb der Trainingsverteilung häufig eine schlechte Leistung auf. Das Erlernen verallgemeinerbarer Modelle der Welt, die bei neuen Aufgaben gut funktionieren, ist ein Schlüsselmerkmal allgemeinerer Systeme der künstlichen Intelligenz (KI) und eine zentrale herausragende Herausforderung im Bereich ML [Bengio et al., 2021].

Forscher stoßen zunehmend auf diese Einschränkungen, wenn sie ML in wissenschaftlichen Problemen einsetzen [Ourmazd, 2020, Forde und Paganini, 2019]. Angesichts der schlechten Generalisierungsfähigkeiten tiefer neuronaler Netze stellt sich die entscheidende Frage, ob sie tatsächlich wissenschaftliche Prinzipien „lernen“. Von einer guten wissenschaftlichen Theorie wird erwartet, dass sie außerhalb experimenteller Daten neuartige und genaue Vorhersagen macht, tiefe neuronale Netze haben jedoch Schwierigkeiten, außerhalb von Trainingsdaten genaue Vorhersagen zu treffen. Auch wenn ein Netzwerk verlässliche Vorhersagen treffen kann, kann es angesichts ihrer Uninterpretierbarkeit eine Herausforderung sein, daraus aussagekräftige wissenschaftliche Erkenntnisse zu gewinnen. Ein weiteres großes Problem besteht darin, dass viele aktuelle Arbeitsabläufe für maschinelles Lernen traditionelle wissenschaftliche Modelle vollständig durch erlernte Modelle ersetzen. Dies kann zwar nützlich sein, diese rein datengesteuerten Methoden „werfen“ jedoch einen großen Teil unseres bisherigen wissenschaftlichen Wissens weg.

Der wichtige Punkt ist, dass es für viele Probleme eine bestehende Theorie gibt, auf der man aufbauen kann, anstatt bei Null anzufangen. In einem Bereich, der traditionell auf einem engen Zusammenspiel von expliziter Theorie und Experiment basiert, argumentieren einige, dass die oben genannten Einschränkungen aktuelle ML-Methoden inakzeptabel machen. Diese Bedenken haben die Entstehung eines schnell wachsenden neuen Feldes namens Scientific Machine Learning (SciML) vorangetrieben [Baker et al., 2019, Karniadakis et al., 2021, Willard et al., 2020, Cuomo et al., 2022, Arridge et al al., 2019, Karpatne et al., 2017a]. Das Ziel von SciML besteht darin, vorhandene wissenschaftliche Erkenntnisse und ML zu verschmelzen, um differenziertere ML-Algorithmen zu generieren, die auf unserem Vorwissen basieren, wie in Abbildung 1.1 dargestellt. Das Hauptargument in diesem Bereich ist, dass wir dadurch letztendlich zu robusteren Methoden für die Durchführung wissenschaftlicher Forschung gelangen. Herkömmliche Methoden und ML-Methoden haben jeweils Vor- und Nachteile, und eine Kombination aus beiden kann effektiver sein als eine der beiden. Beispielsweise können bei der Datenassimilation (z. B. in Klimamodellen) traditionelle physikalische Modelle verwendet werden, um Vorwissen bereitzustellen, während ML verwendet werden kann, um Datenabhängigkeiten und andere unbekannte physikalische Aspekte zu berücksichtigen. Abbildung 1.1: Überblick über wissenschaftliches maschinelles Lernen (SciML). SciML zielt darauf ab, ML eng mit wissenschaftlichen Erkenntnissen zu verknüpfen, um leistungsfähigere, robustere und interpretierbarere ML-Methoden für die wissenschaftliche Forschung zu entwickeln.

Die Erwartungen der Menschen in diesem Bereich wachsen rasant, und derzeit werden zahlreiche Methoden und viele innovative Strategien vorgeschlagen und untersucht Wissenschaftliche Erkenntnisse werden in ML integriert. Diese Methoden reichen von beabsichtigten wissenschaftlichen Aufgaben (wie Simulation, Inversion und Entdeckung von Leitgleichungen) über verschiedene Möglichkeiten zur Einbeziehung wissenschaftlicher Prinzipien (wie durch die Architektur tiefer neuronaler Netze, ihre Verlustfunktionen und die Verwendung von Hybridmodellen) bis hin zu wissenschaftlichen Das Ausmaß, in dem Prinzipien auferlegt werden (z. B. durch harte oder weiche Einschränkungen). Wir werden diese Methoden in Kapitel 2 ausführlich besprechen. Viele Methoden nutzen Ideen aus der Physik, um ihre ML-Algorithmen in einem Teilgebiet von SciML zu informieren, das als physikalisch-informiertes maschinelles Lernen (PIML) bezeichnet wird [Karniadakis et al., 2021].

Bisher hatte SciML erste Erfolge. Es hilft uns, leistungsstarke Simulationen durchzuführen [Raissi al., 2019], die maßgeblichen Gleichungen komplexer physikalischer Systeme zu entdecken [Kutz und Brunton, 2022] und grundlegende Parameter in Inversionsproblemen genau zu invertieren [Arridge et al., 2019] und nahtlos zu integrieren traditionelle Arbeitsabläufe mit erlernten Komponenten in einem breiten Spektrum von Bereichen [Rackauckas et al., 2020, Thuerey et al., 2021]. Trotz früherer Versprechen steckt das Gebiet von SciML noch in den Kinderschuhen und es stellen sich viele wichtige Fragen, wie zum Beispiel: Wie sollten wir die mangelnde Interpretierbarkeit datengesteuerter Modelle mit der Klarheit der bestehenden Theorie in Einklang bringen? Gibt es eine übergreifende SciML-Technologie, die in allen wissenschaftlichen Disziplinen angewendet werden kann? Kann SciML neue Perspektiven und Ideen für den ML-Bereich bieten? Wie skalierbar ist die SciML-Technologie für komplexe reale Probleme? wie folgt.

In diesem Artikel verwenden wir hauptsächlich zwei Methoden, um die oben genannten Teilprobleme zu untersuchen. Zunächst werden für die ersten drei Teilprobleme komplexe, reale, domänenspezifische Fallstudien verwendet, um die Leistung und Skalierbarkeit mehrerer verschiedener PIML-Methoden zu untersuchen. Für jedes Teilproblem stellen wir eine Fallstudie vor, schlagen eine PIML-Technik (oder verschiedene PIML-Techniken) zur Lösung vor und bewerten, wie die Technik auf diese Situation erweitert werden kann. Zweitens konzentrieren wir uns beim letzten Teilproblem auf eine einzelne Allzweck-PIML-Technologie und bewerten und verbessern deren Skalierbarkeit. Die ersten drei Teilprobleme werden in separaten Kapiteln dieser Arbeit untersucht (jeweils Kapitel 3 bis 5), und ihre Fallstudien stammen alle aus den Bereichen Mondwissenschaft und Geophysik. Das letzte Teilproblem wird in Kapitel 6 untersucht. Abschließend diskutieren und fassen wir die Implikationen jedes Kapitels für unsere wichtigsten Forschungsfragen in Kapitel 7 zusammen.

SciML-Methodengenealogie. Diese Grafik zeigt, wie „stark“ die verschiedenen Arten von SciML-Methoden, die in diesem Kapitel vorgestellt werden, für wissenschaftliche Erkenntnisse sind. Beachten Sie, dass die Stärke einer wissenschaftlichen Einschränkung ein eher vages Konzept ist. In diesem Diagramm definieren wir sie als die Nähe eines SciML-Ansatzes zu einem traditionellen Arbeitsablauf. Fortgeschrittene Ansätze kombinieren ML auch mit bestimmten Aspekten traditioneller Arbeitsabläufe, beispielsweise in Schleifenmethoden, die traditionelle iterative Löser mit ML-Modellen verknüpfen. Außerdem ist unsere Zuordnung etwas subjektiv, daher dient diese Zahl nur dazu, den allgemeinen Trend auszudrücken.

Das obige ist der detaillierte Inhalt vonWie macht ML wissenschaftliche Entdeckungen? Die 268-seitige Doktorarbeit der Universität Oxford beschreibt detailliert die Bedeutung des wissenschaftlichen maschinellen Lernens. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was sind Primzahlen?

Was sind Primzahlen?

Was ist Javaweb?

Was ist Javaweb?

So wechseln Sie auf dem Laptop in den abgesicherten Modus

So wechseln Sie auf dem Laptop in den abgesicherten Modus

So überprüfen Sie den Videospeicher von Win11

So überprüfen Sie den Videospeicher von Win11

Was ist ein UI-Designer?

Was ist ein UI-Designer?

Windows kann nicht auf den freigegebenen Computer zugreifen

Windows kann nicht auf den freigegebenen Computer zugreifen

So verwenden Sie Split in Python

So verwenden Sie Split in Python

Welche Daten speichert der Redis-Cache im Allgemeinen?

Welche Daten speichert der Redis-Cache im Allgemeinen?