Hat die KI wieder Fortschritte gemacht?

Und es ist die Art, die aus einem Bild ein kontinuierliches 30-Sekunden-Video generiert. ... Information .

Dies ist ein allgemeiner Rahmen für Bildmodellierungs- und Sehaufgaben, der auf der probabilistischen Bildvorhersage basiert, die kürzlich von DeepMind – Transframer – vorgeschlagen wurde.

Einfach ausgedrückt geht es darum, Transframer zu verwenden, um die Wahrscheinlichkeit eines Frames vorherzusagen.

Diese Frames können von einem oder mehreren annotierten Kontextframes abhängig gemacht werden, bei denen es sich um vorherige Videoframes, Zeitstempel oder mit einer Kamera markierte Ansichtsszenen handeln kann.

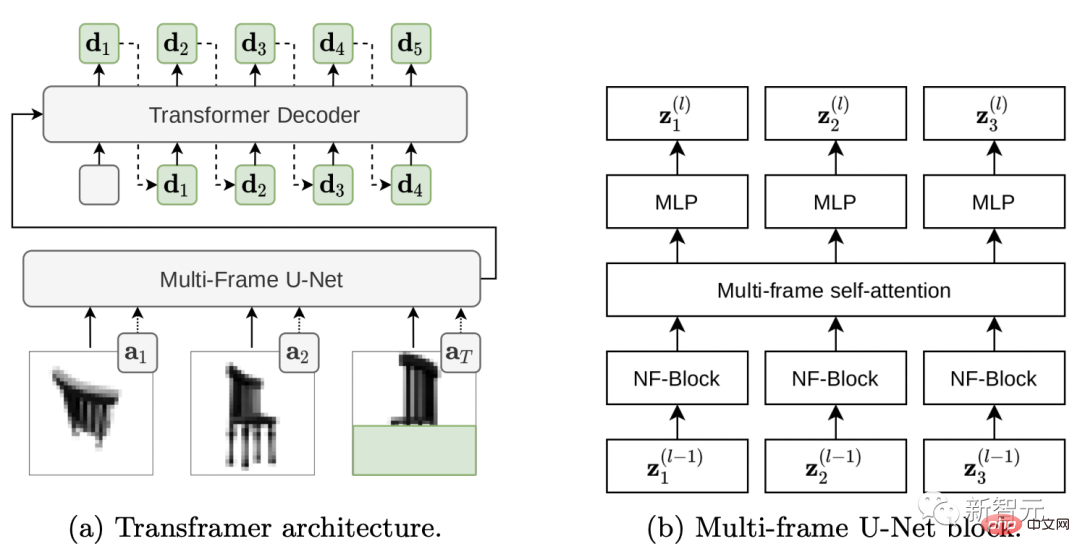

Transframer-ArchitekturWerfen wir zunächst einen Blick darauf, wie diese magische Transframer-Architektur funktioniert.

Um die Vorhersageverteilung auf dem Ziel abzuschätzen image benötigen wir ein Ausdrucksgenerierungsmodell, das vielfältige, qualitativ hochwertige Ausgaben erzeugen kann.

Obwohl die Ergebnisse von DC Transformer auf einer einzelnen Bilddomäne die Anforderungen erfüllen können, sind sie nicht auf den von uns benötigten Mehrbildtextsatz {(In,an)}n angewiesen.

Deshalb haben wir DC Transformer erweitert, um eine bedingte Bild- und Anmerkungsvorhersage zu ermöglichen.

Wir ersetzen DC Transformer durch einen Encoder im Vision-Transformer-Stil, der mit einem einzelnen DCT-Bild arbeitet und eine U-Net-Architektur mit mehreren Frames verwendet, um einen Satz annotierter Frames sowie teilweise verborgene Ziel-DCT-Bilder zu verarbeiten.

Sehen wir uns an, wie die Transframer-Architektur funktioniert.

(a) Transframer nimmt als Eingabe die DCT-Bilder (a1 und a2) sowie das teilweise ausgeblendete Ziel-DCT-Bild (aT) und zusätzliche Anmerkungen, die vom Multi-Frame-U-Net-Encoder verarbeitet werden. Als nächstes wird die U-Net-Ausgabe durch Queraufmerksamkeit an den DC-Transformer-Decoder weitergeleitet, der automatisch eine Regression durchführt, um eine DCT-Token-Sequenz (grüne Buchstaben) zu generieren, die dem verborgenen Teil des Zielbilds entspricht. (b) Der Multi-Frame-U-Net-Block besteht aus einem NF-Net-Faltungsblock und einem Multi-Frame-Selbstaufmerksamkeitsblock, die Informationen zwischen Eingabeframes und Rest-MLP im Transformer-Stil austauschen.

Werfen wir einen Blick auf Multi-Frame U-Net, das Bildeingaben verarbeitet.

Die Eingabe in U-Net ist eine Sequenz bestehend aus N DCT-Frames und teilweise ausgeblendeten Ziel-DCT-Frames, und Anmerkungsinformationen werden in Form von Vektoren bereitgestellt, die jedem Eingabeframe zugeordnet sind.

Die Kernkomponente von U-Net ist ein Rechenblock, der zunächst einen gemeinsamen NF-ResNet-Faltungsblock auf jeden Eingaberahmen anwendet und dann einen Selbstaufmerksamkeitsblock im Transformer-Stil anwendet, um rahmenübergreifende Informationen zu aggregieren. (Abbildung 2 b)

Der NF-ResNet-Block besteht aus gruppierten Faltungen sowie Squeeze- und Anregungsschichten und zielt darauf ab, die Leistung von TPU zu verbessern.

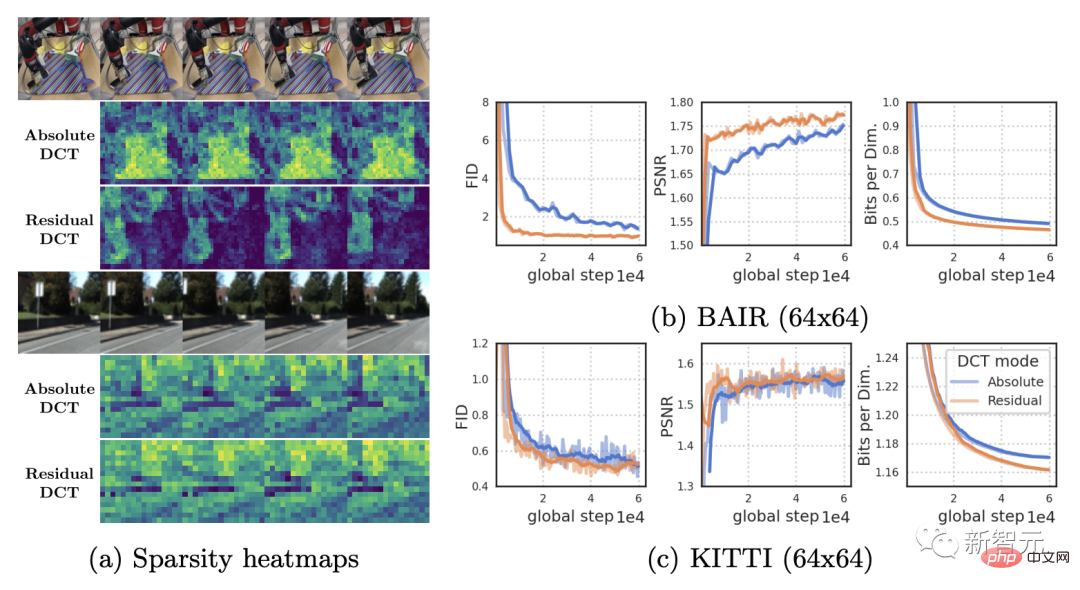

Unten vergleicht Abbildung (a) die Sparsamkeit absoluter und restlicher DCT-Darstellungen von RoboNet- (128 x 128) und KITTI-Videos.

Da RoboNet aus statischen Videos mit nur wenigen beweglichen Elementen besteht, nimmt die Spärlichkeit der Restbilddarstellung deutlich zu.

Und KITTI-Videos haben normalerweise eine bewegliche Kamera, was in aufeinanderfolgenden Bildern fast überall zu Unstimmigkeiten führt.

Aber in diesem Fall werden auch die Vorteile kleiner Sparsity abgeschwächt.

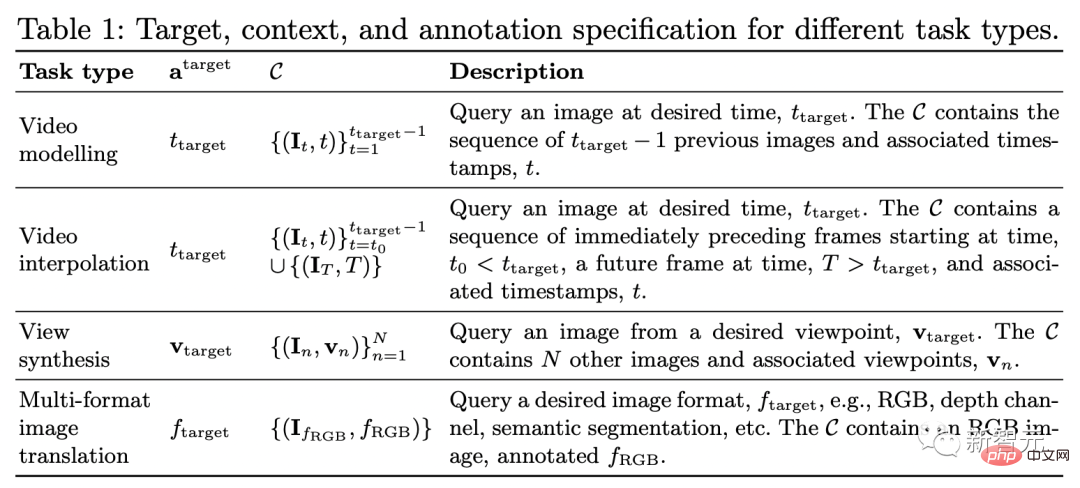

Durch Tests an einer Reihe von Datensätzen und Aufgaben zeigen die Ergebnisse, dass Transframer für eine Vielzahl von Aufgaben eingesetzt werden kann.

Einschließlich Videomodellierung, Synthese neuer Ansichten, semantische Segmentierung, Objekterkennung, Tiefenschätzung, Vorhersage des optischen Flusses usw.

Videomodellierung

Prognostizieren Sie das nächste Bild anhand einer Folge von Eingabevideobildern über Transframer.

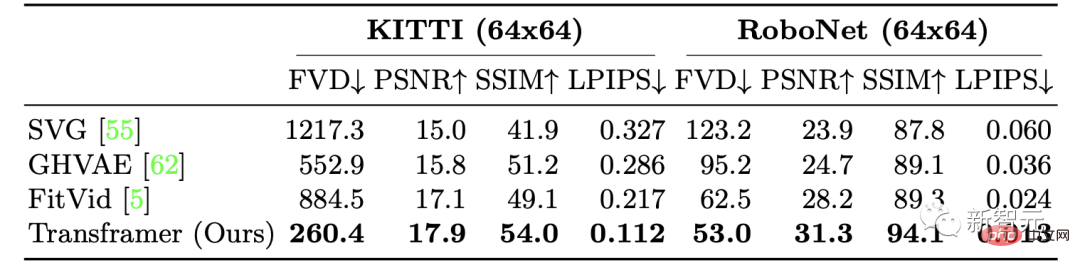

Die Forscher trainierten die Leistung von Transframer bei der Videogenerierung anhand von zwei Datensätzen: KITTI bzw. RoboNet.

Für KITTI zeigen die Ergebnisse bei 5 Kontext-Frames und 25 Beispiel-Frames, dass sich die Leistung des Transframer-Modells bei allen Metriken verbessert, wobei die Verbesserungen bei LPIPS und FVD am offensichtlichsten sind.

Auf RoboNet erhielten die Forscher 2 Kontextrahmen und 10 Abtastrahmen, trainierten sie mit einer Auflösung von 64 x 64 bzw. 128 x 128 und erzielten schließlich sehr gute Ergebnisse.

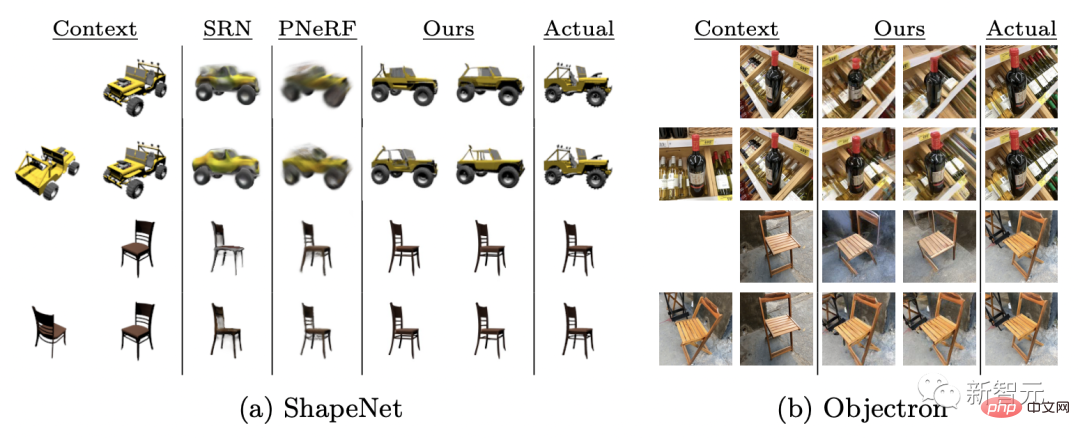

Ansichtssynthese

In Bezug auf die Ansichtssynthese stellen wir Kameraansichten als Kontext- und Zielanmerkungen bereit, wie in Tabelle 1 (Zeile 3) beschrieben, und proben einheitlich mehrere kontextbezogene Ansichten ab auf das angegebene Maximum.

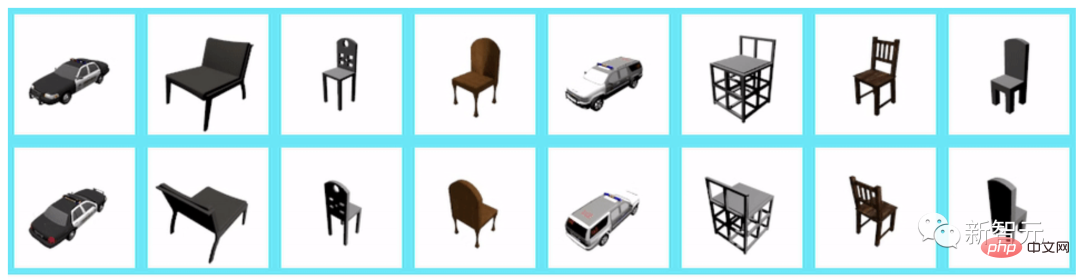

Model Transframer wird anhand des ShapeNet-Benchmarks bewertet und übertrifft PixelNeRF und SRN deutlich, indem es 1-2 kontextbezogene Ansichten bereitstellt.

Darüber hinaus ist nach der Auswertung des Objectron-Datensatzes ersichtlich, dass das Modell bei einer einzelnen Eingabeansicht eine kohärente Ausgabe erzeugt, jedoch einige Merkmale fehlen, wie z. B. gekreuzte Stuhlbeine.

Wenn 1 Kontextansicht angegeben ist, ist die mit einer Auflösung von 128×128 synthetisierte Ansicht wie folgt:

Wenn 2 weitere Kontextansichten angegeben sind, mit einer Auflösung von 128×128 Die synthetisierte Ansicht ist wie folgt:

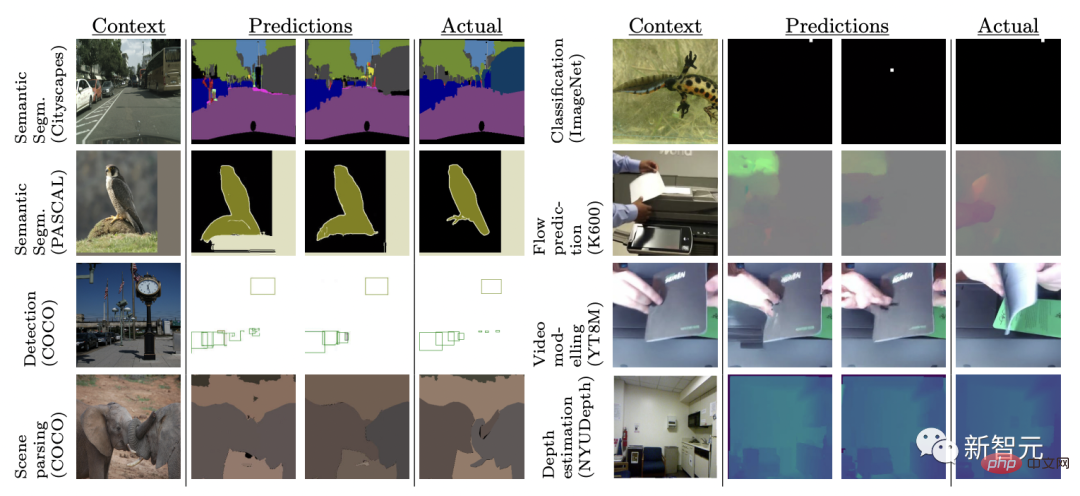

Mehrere Vision-Aufgaben

Verschiedene Computer-Vision-Aufgaben werden normalerweise mithilfe komplexer Architekturen und Verlustfunktionen bearbeitet.

Hier trainierten die Forscher gemeinsam das Transframer-Modell an 8 verschiedenen Aufgaben und Datensätzen unter Verwendung derselben Verlustfunktion.

Die 8 Aufgaben sind: Vorhersage des optischen Flusses eines einzelnen Bildes, Objektklassifizierung, -erkennung und -segmentierung, semantische Segmentierung (auf 2 Datensätzen), Vorhersage zukünftiger Bilder und Tiefenschätzung.

Die Ergebnisse zeigen, dass Transframer lernt, unterschiedliche Samples in völlig unterschiedlichen Aufgaben zu generieren, und in einigen Aufgaben, wie z. B. Stadtansichten, erzeugt das Modell qualitativ hochwertige Ergebnisse.

Allerdings ist die Qualität der Modellausgabe bei Aufgaben wie der Vorhersage zukünftiger Frames und der Erkennung von Begrenzungsrahmen unterschiedlich, was darauf hindeutet, dass die Modellierung in dieser Umgebung anspruchsvoller ist.

Das obige ist der detaillierte Inhalt vonGib mir ein Bild und erstelle ein 30-Sekunden-Video!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Einführung in das von vscode verwendete Framework

Einführung in das von vscode verwendete Framework

So schließen Sie die App-Ressourcenbibliothek

So schließen Sie die App-Ressourcenbibliothek

Welche Plattform ist Kuai Tuan Tuan?

Welche Plattform ist Kuai Tuan Tuan?

Regelmäßige Verwendung von grep

Regelmäßige Verwendung von grep

Die Rolle des Linux-Betriebssystems

Die Rolle des Linux-Betriebssystems

So konvertieren Sie Kleinbuchstaben in C-Sprache in Großbuchstaben

So konvertieren Sie Kleinbuchstaben in C-Sprache in Großbuchstaben

Was tun, wenn Postscript nicht geparst werden kann?

Was tun, wenn Postscript nicht geparst werden kann?

Einführung in Virtualisierungssoftware

Einführung in Virtualisierungssoftware