BerechnungÄhnlichkeit zwischen Bildern ist ein offenes Problem in der Computer Vision.

Heutzutage, da die Bildgenerierung auf der ganzen Welt beliebt ist, ist Wie man „Ähnlichkeit“ definiert auch ein zentrales Thema bei der Bewertung der Authentizität generierter Bilder.

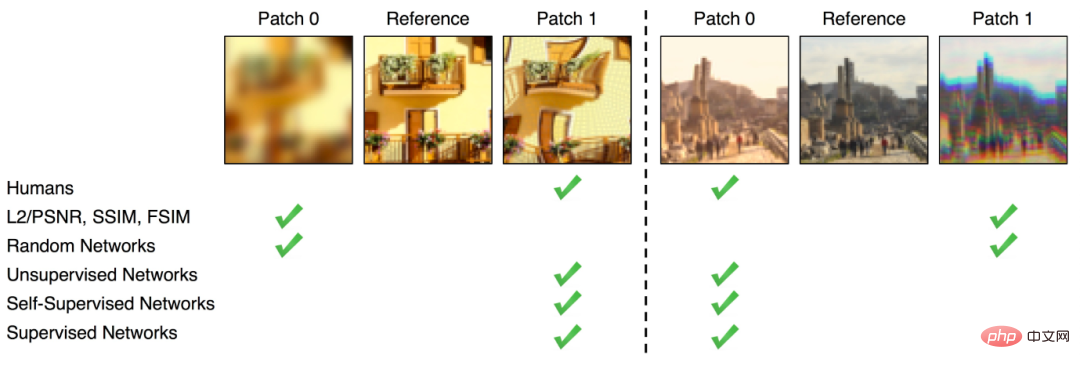

Obwohl es derzeit einige relativ direkte Methoden zur Berechnung der Bildähnlichkeit gibt, wie z. B. das Messen von Unterschieden in Pixeln (wie FSIM, SSIM), ist der mit dieser Methode erhaltene Ähnlichkeitsunterschied nicht derselbe wie der von der Bildähnlichkeit wahrgenommene Unterschied menschliches Auge Der Unterschied ist tiefgreifend.

Nach dem Aufstieg des Deep Learning stellten einige Forscher fest, dass die Zwischendarstellung, die nach dem Training auf ImageNet von einigen neuronalen Netzwerkklassifizierern wie AlexNet, VGG, SqueezeNet usw. erhalten wurde, für die Berechnung der Wahrnehmung verwendet werden kann Ähnlichkeit.

Mit anderen Worten: Einbettung kommt der Wahrnehmung der Menschen hinsichtlich der Ähnlichkeit mehrerer Bilder näher als Pixeln.

Natürlich ist das nur eine Hypothese .

Kürzlich hat Google einen Artikel veröffentlicht, der speziell untersucht, ob der ImageNet-Klassifikator Wahrnehmungsähnlichkeit besser bewerten kann. 🔜 BAPPS-Datensatz Die „Wahrnehmungswerte“ wurden mit dem ImageNet-Klassifikator der ersten Generation untersucht. Um die Korrelation zwischen Genauigkeit und Wahrnehmungswerten sowie die Auswirkungen verschiedener Hyperparameter weiter zu bewerten, wurden in dem Artikel die Forschungsergebnisse des neuesten ViT-Modells hinzugefügt .

Je höher die Genauigkeit, desto schlechter ist die wahrgenommene Ähnlichkeit?

Es ist bekannt, dass die durch das Training auf ImageNet erlernten Funktionen gut auf viele nachgelagerte Aufgaben übertragen werden können und die Leistung nachgelagerter Aufgaben verbessern, was auch das Vortraining auf ImageNet zu einem Standardvorgang macht. Darüber hinaus bedeutet das Erreichen einer höheren Genauigkeit bei ImageNet oft eine bessere Leistung bei einer Vielzahl nachgelagerter Aufgaben, wie z. B. Robustheit gegenüber beschädigten Bildern, Daten außerhalb der Verteilung usw. Generalisierungsleistung und Transferlernen auf kleinere kategoriale Datensätze.

Aber in Bezug auf die Berechnung der Wahrnehmungsähnlichkeit scheint alles umgekehrt zu sein.

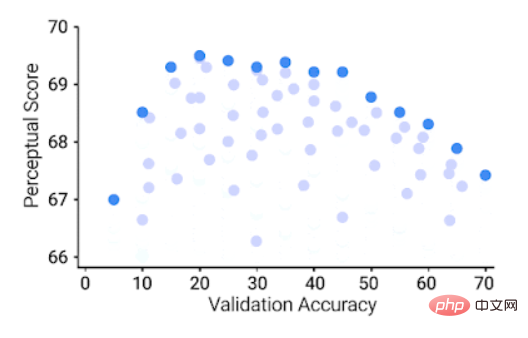

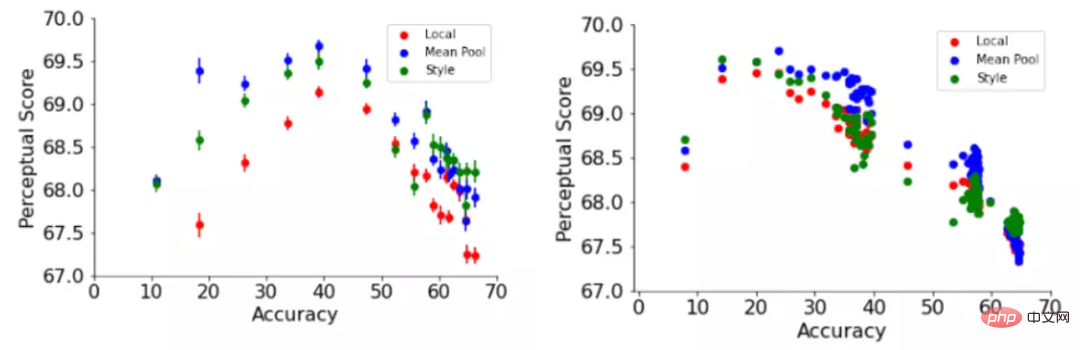

ImageNet 64 × 64 Validierungsgenauigkeit (x-Achse), 64 × 64 Wahrnehmungsbewertung auf dem BAPPS-Datensatz (y-Achse), jeder blaue Punkt stellt einen ImageNet-Klassifikator dar

Das können Sie Es ist ersichtlich, dass ein besserer ImageNet-Klassifikator bis zu einem gewissen Grad eine bessere Wahrnehmungsbewertung erzielt. Über einen bestimmten Schwellenwert hinaus führt eine Verbesserung der Genauigkeit jedoch zu einer Verringerung der Wahrnehmungsbewertung. Die Genauigkeit des Klassifikators ist moderat (20,0–40,0), was möglich ist die beste Wahrnehmungsbewertung .

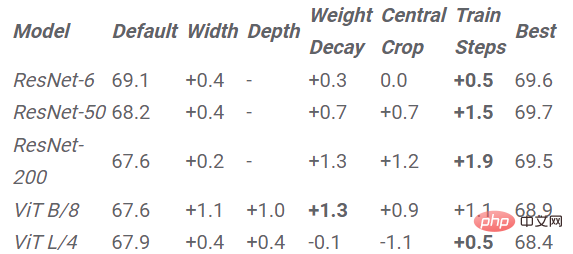

Der Artikel untersucht auch die Auswirkungen von Hyperparametern neuronaler Netze auf Wahrnehmungswerte wie Breite, Tiefe, Anzahl der Trainingsschritte, Gewichtsabschwächung, Etikettenglättung und Dropout.

Darüber hinaus führt eine Erhöhung der Klassifikatorgenauigkeit zu einer schlechteren Wahrnehmungsbewertung.

Zum Beispiel gibt der Artikel die Änderung der Wahrnehmungsbewertung relativ zu zwei Hyperparametern an: Trainingsschritte in ResNets und Breite in ViTs.

Früh gestoppte ResNets erzielten die besten Wahrnehmungswerte bei verschiedenen Tiefeneinstellungen von 6, 50 und 200.

Die Wahrnehmungswerte von ResNet-50 und ResNet-200 erreichten ihre höchsten Werte in den ersten Epochen von Training, aber nach dem Höhepunkt sank der Wahrnehmungswert des Klassifikators mit der besseren Leistung stärker.

Die Ergebnisse zeigen, dass die Trainings- und Lernratenanpassung von ResNets die Genauigkeit des Modells mit zunehmendem Schritt verbessern kann. Ebenso weist das Modell nach dem Höhepunkt auch eine progressive Abnahme der Wahrnehmungsähnlichkeitswerte auf, die dieser zunehmend zunehmenden Genauigkeit entspricht.

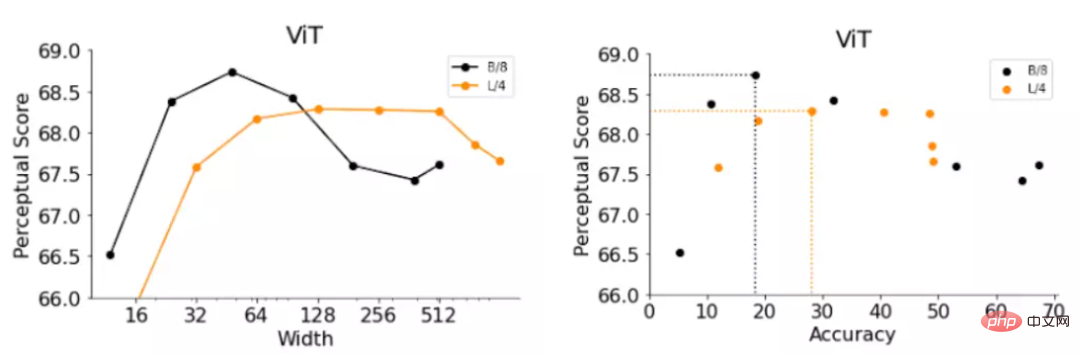

ViTs besteht aus einer Reihe von Transformer-Blöcken, die auf das Eingabebild angewendet werden. Die Breite des ViT-Modells ist die Anzahl der Ausgabeneuronen eines einzelnen Transformer-Blocks. Durch Erhöhen der Breite kann die Genauigkeit des Modells effektiv verbessert werden.

Durch Ersetzen der Breite der beiden ViT-Varianten erhielten die Forscher zwei Modelle B/8 (d. h. Basis-ViT-Modell, Patchgröße ist 4) und L/4 (d. h. Large-ViT-Modell) und bewerteten die Sexualität genau und Wahrnehmungsbewertungen.

Die Ergebnisse ähneln immer noch den frühen Stopp-ResNets-Beobachtungen, wobei schmalere ViTs mit geringerer Genauigkeit besser abschneiden als die Standardbreite.

Die optimalen Breiten von ViT-B/8 und ViT-L/4 betragen jedoch 6 % bzw. 12 % ihrer Standardbreiten. Das Papier enthält auch eine detailliertere experimentelle Liste für andere Hyperparameter B. Breite, Tiefe, Anzahl der Trainingsschritte, Gewichtsabfall, Label-Glättung und Dropout in ResNet und ViTs.

Wenn Sie also die wahrgenommene Ähnlichkeit verbessern möchten, ist die Strategie einfach: Reduzieren Sie einfach die Genauigkeit entsprechend.

Verbessern Sie die Wahrnehmungsbewertung durch Verkleinern des ImageNet-Modells. Die Werte in der Tabelle stellen die Verbesserung dar, die durch Skalieren des Modells mit gegebenen Hyperparametern gegenüber dem Modell mit Standard-Hyperparametern erzielt wird

gemäß In der obigen Schlussfolgerung schlagen wir eine einfache Strategie vor, um die Wahrnehmungsbewertung einer Architektur zu verbessern: Verkleinern Sie das Modell, um die Genauigkeit zu verringern, bis die optimale Wahrnehmungsbewertung erreicht ist.

In den experimentellen Ergebnissen ist auch die Verbesserung der Wahrnehmungsbewertung sichtbar, die durch die Verkleinerung jedes Modells für jeden Hyperparameter erzielt wird. Ein frühes Stoppen führt bei allen Architekturen mit Ausnahme von ViT-L/4 zu der höchsten Bewertungsverbesserung, und ein frühes Stoppen ist die effektivste Strategie, ohne dass zeitaufwändige Rastersuchen erforderlich sind.

In früheren Arbeiten wurde die Wahrnehmungsähnlichkeitsfunktion mithilfe des euklidischen Abstands über Bildraumdimensionen berechnet.

Dieser Ansatz geht von einer direkten Entsprechung zwischen Pixeln aus, diese Entsprechung gilt jedoch möglicherweise nicht für gekrümmte, verschobene oder gedrehte Bilder.

In diesem Artikel haben die Forscher zwei Wahrnehmungsfunktionen übernommen, die auf der globalen Darstellung des Bildes basieren, nämlich die Stilverlustfunktion und die Normalisierung in der neuronalen Stilübertragungsarbeit, die die Stilähnlichkeit zwischen zwei Bildern erfasst Funktion. Die Stilverlustfunktion

vergleicht die Interkanal-Kreuzkorrelationsmatrix zwischen zwei Bildern, während die durchschnittliche Pooling-Funktion die räumlich gemittelte globale Darstellung vergleicht.

Die globale Perzeptronfunktion verbessert kontinuierlich die Wahrnehmungsbewertung sowohl der Standard-Hyperparameter des Netzwerktrainings als auch von ResNet-200 als Funktion der Trainingsepoche.

Der Artikel untersucht auch einige Annahmen, um die Genauigkeit und Beziehungen zu erklären zwischen Wahrnehmungswerten und leitete einige zusätzliche Erkenntnisse ab.

Zum Beispiel ist die Modellgenauigkeit ohne die häufig verwendete Sprungverbindung auch umgekehrt proportional zur Wahrnehmungsbewertung, wobei Schichten näher an der Ausgabe im Durchschnitt niedrigere Wahrnehmungsbewertungen aufweisen als Schichten näher an der Eingabe.

Außerdem wurden die Verzerrungsempfindlichkeit, die Granularität der ImageNet-Kategorie und die Ortsfrequenzempfindlichkeit weiter untersucht.

Kurz gesagt, dieser Artikel untersucht die Frage, ob eine Verbesserung der Klassifizierungsgenauigkeit zu besseren Wahrnehmungsmetriken führt. Er untersucht die Beziehung zwischen Genauigkeit und Wahrnehmungswerten auf ResNets und ViTs unter verschiedenen Hyperparametern und stellt fest, dass Wahrnehmungswerte und Genauigkeit ein umgekehrtes U darstellen. Typbeziehung, bei der Genauigkeits- und Wahrnehmungswerte bis zu einem gewissen Grad miteinander in Zusammenhang stehen und eine umgekehrte U-förmige Beziehung aufweisen.

Abschließend wird in dem Artikel die Beziehung zwischen Genauigkeit und Wahrnehmungsbewertung ausführlich erörtert, einschließlich Sprungverbindung, globaler Ähnlichkeitsfunktion, Verzerrungsempfindlichkeit, hierarchischer Wahrnehmungsbewertung, Ortsfrequenzempfindlichkeit und ImageNet-Kategoriegranularität.

Während die genaue Erklärung für den Kompromiss zwischen ImageNet-Genauigkeit und Wahrnehmungsähnlichkeit ein Rätsel bleibt, ist dieses Papier ein erster Schritt vorwärts.

Das obige ist der detaillierte Inhalt vonUntergraben Sie drei Konzepte! Die neueste Studie von Google: Ist es genauer, die „Ähnlichkeit' mit einem Modell mit schlechter Leistung zu berechnen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lösung für das Problem, dass die Win10-Download-Software nicht installiert werden kann

Lösung für das Problem, dass die Win10-Download-Software nicht installiert werden kann

So lösen Sie das Problem, dass die Festplattenpartition nicht geöffnet werden kann

So lösen Sie das Problem, dass die Festplattenpartition nicht geöffnet werden kann

Verwendung der Update-Anweisung

Verwendung der Update-Anweisung

Kostenloser Website-Domainname

Kostenloser Website-Domainname

Löschen Sie redundante Tabellen in der Tabelle

Löschen Sie redundante Tabellen in der Tabelle

Was bedeutet WLAN deaktiviert?

Was bedeutet WLAN deaktiviert?

So optimieren Sie eine einzelne Seite

So optimieren Sie eine einzelne Seite

Welche Methoden gibt es, um die IP in dynamischen VPS sofort zu ändern?

Welche Methoden gibt es, um die IP in dynamischen VPS sofort zu ändern?