Diffusionsmodelle zur Rauschunterdrückung sind eine neue Klasse generativer neuronaler Netze, die durch einen iterativen Rauschunterdrückungsprozess Bilder aus einer Trainingsverteilung generieren. Diese Art von Diffusionsmodell erzeugt Proben von höherer Qualität und ist einfacher zu skalieren und zu kontrollieren als frühere Methoden wie GANs und VAEs. Dadurch können sie nach rasanter Entwicklung bereits hochauflösende Bilder erzeugen und es besteht ein großes öffentliches Interesse an großen Modellen wie dem DALL-E 2. Das Schöne an generativen Diffusionsmodellen liegt in ihrer Fähigkeit, neue Bilder zu synthetisieren, die sich oberflächlich betrachtet von allem im Trainingssatz unterscheiden. Tatsächlich haben umfangreiche Schulungsbemühungen in der Vergangenheit nicht ergeben, dass eine Überanpassung ein Problem darstellen wird. Forscher in datenschutzrelevanten Bereichen haben sogar vorgeschlagen, Diffusionsmodelle zum Schutz der Privatsphäre zu verwenden, indem sie synthetische Beispiele generieren, um echte Bilder zu erzeugen. Diese Arbeitsreihe wird unter der Annahme durchgeführt, dass das Diffusionsmodell Trainingsdaten nicht speichert und neu generiert. Dies würde alle Datenschutzgarantien verletzen und viele Probleme mit der Verallgemeinerung von Modellen und der digitalen Fälschung mit sich bringen.

In diesem Artikel haben Forscher von Google, DeepMind und anderen Institutionen bewiesen, dass das SOTA-Diffusionsmodell tatsächlich ein einzelnes Trainingsbeispiel merken und regenerieren kann.

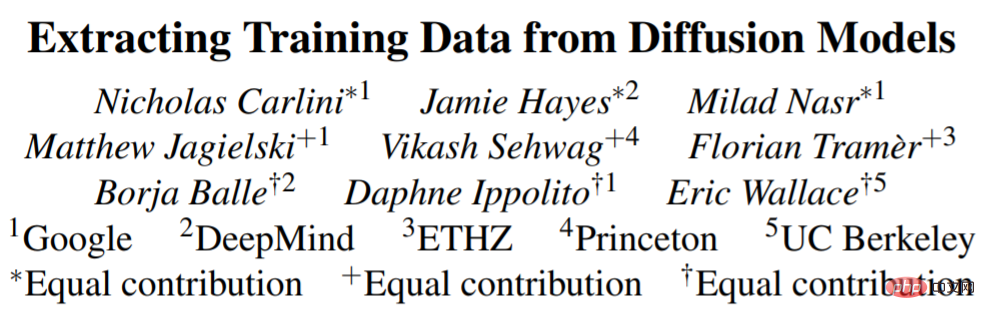

Zunächst schlägt die Forschung eine neue Definition des Gedächtnisses in Bildmodellen vor und implementiert diese. Anschließend entwarf die Studie einen zweistufigen Datenextraktionsangriff, bei dem Standardmethoden zum Generieren von Bildern und zum Kennzeichnen einiger Bilder verwendet wurden. Die Studie wandte diese Methode auf Stable Diffusion und Imagen an und führte zur Extraktion von mehr als 100 nahezu identischen Kopien von Trainingsbildern, die von persönlich identifizierbaren Fotos bis hin zu markenrechtlich geschützten Logos reichten (Abbildung 1). Um besser zu verstehen, wie Speicher funktioniert und warum, haben wir Hunderte von Diffusionsmodellen auf CIFAR10 trainiert, um die Auswirkungen von Modellgenauigkeit, Hyperparametern, Verbesserung und Deduplizierung auf den Datenschutz zu analysieren. Diffusionsmodelle sind die am wenigsten private Form von Bildmodellen, die in der Studie bewertet wurden und doppelt so viele Trainingsdaten preisgeben wie GANs. Schlimmer noch: Untersuchungen haben auch ergeben, dass bestehende Technologien zur Verbesserung der Privatsphäre keine akzeptablen Kompromisse zwischen Privatsphäre und Nutzen bieten. Insgesamt unterstreicht dieses Papier die Spannung, die zwischen immer leistungsfähigeren generativen Modellen und Datenschutz besteht, und wirft Fragen darüber auf, wie Diffusionsmodelle funktionieren und wie sie angemessen eingesetzt werden können.

Warum möchten Sie diese Forschung durchführen? Es gibt zwei Beweggründe für das Verständnis, wie sich Diffusionsmodelle Trainingsdaten merken und regenerieren.

Die erste besteht darin, die Datenschutzrisiken zu verstehen. Die Neugenerierung von Diffusionsmodellen, die Daten aus dem Internet extrahieren, kann ähnliche Datenschutz- und Urheberrechtsrisiken mit sich bringen wie Sprachmodelle. Beispielsweise wurde darauf hingewiesen, dass das Speichern und Wiederherstellen von urheberrechtlich geschützten Texten und Quellcodes potenzielle Indikatoren für eine Verletzung darstellen. Ebenso wird das Kopieren eines von einem professionellen Künstler erstellten Bildes als digitale Fälschung bezeichnet, und darüber gibt es in der Kunstwelt eine Debatte.

Daten aus dem SOTA-Diffusionsmodell extrahieren

Daten aus der stabilen Diffusion extrahieren# 🎜🎜 #

Rufen Sie jetzt Trainingsdaten von Stable Diffusion ab, dem größten und beliebtesten Open-Source-Diffusionsmodell.

Diese Extraktion wendet die Methode der vorherigen Arbeit auf das Bild an, einschließlich zweier Schritte:

2. Führen Sie eine Inferenz durch, um das Modell der neuen Generation vom gespeicherten Trainingsmodell zu trennen.

Um die Wirksamkeit des Eindringens zu bewerten, wählte die Studie 350.000 am häufigsten wiederholte Beispiele aus dem Trainingsdatensatz aus und generierte 500 Kandidatenbilder für jede Eingabeaufforderung (insgesamt 175 Millionen Bilder). generiert wurden).

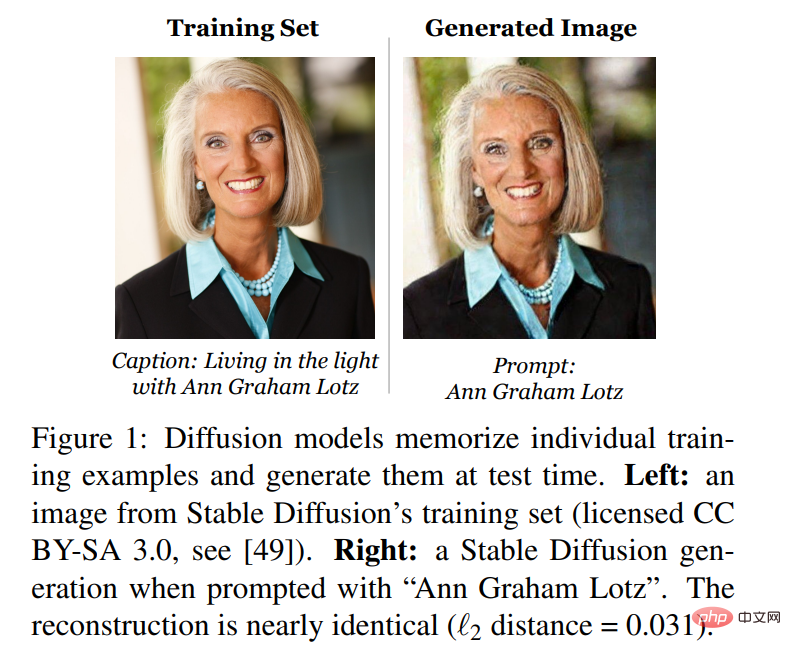

Zuerst sortiert die Studie alle diese generierten Bilder, um zu bestimmen, welche durch Speichern der Trainingsdaten generiert werden. Jedes dieser generierten Bilder wird dann mit den Trainingsbildern gemäß Definition 1 im Artikel verglichen und jedes Bild wird als extrahiert oder nicht extrahiert kommentiert. Die Studie ergab, dass 94 Bilder extrahiert wurden, um sicherzustellen, dass diese Bilder nicht nur einer willkürlichen Definition entsprachen, sondern auch die ersten 1.000 generierten Bilder manuell mit oder ohne Speicher versehen wurden. Und weitere 13 (insgesamt 109 Bilder). Es stellte sich heraus, dass es sich nahezu um Kopien der Trainingsbeispiele handelte, obwohl sie nicht der Definition der L_2-Norm der Studie entsprachen. Abbildung 3 zeigt eine Teilmenge der extrahierten Bilder, die mit nahezu perfekter Pixelgenauigkeit reproduziert werden.

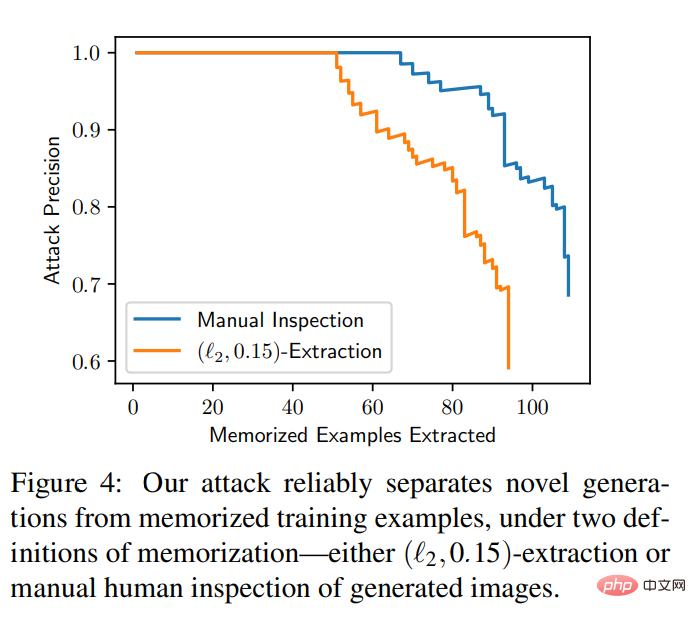

Das Experiment liefert auch eine vorgegebene annotierte Reihenfolge bei Bildsätzen wird eine Kurve berechnet, um die Anzahl der extrahierten Bilder im Vergleich zur Falsch-Positiv-Rate des Eindringens auszuwerten. Der Eingriff ist außergewöhnlich genau: Von 175 Millionen generierten Bildern konnten 50 Speicherbilder mit 0 Fehlalarmen identifiziert werden, und alle Speicherbilder konnten mit einer Genauigkeit von über 50 % extrahiert werden. Abbildung 4 enthält Präzisions-Recall-Kurven für beide Definitionen des Speichers.

Daten aus Bild extrahieren# 🎜 🎜#

Obwohl die stabile Diffusion derzeit die beste Wahl unter den öffentlich verfügbaren Diffusionsmodellen ist, haben einige nicht öffentliche Modelle mit größeren Modellen und Datensätzen eine stärkere Leistung erzielt. Frühere Untersuchungen haben ergeben, dass sich größere Modelle eher Trainingsdaten merken. Daher untersuchte diese Studie Imagen, ein Text-zu-Bild-Diffusionsmodell mit 2 Milliarden Parametern.

Überraschenderweise hat die Forschung herausgefunden, dass das Hacken nicht verteilter Bilder in Imagen effektiver ist als in Stable Diffusion. Auf Imagen versuchte die Studie, 500 Bilder mit dem höchsten Out-of-Distribution-Score (OOD) zu extrahieren. Imagen speichert und kopiert drei der Bilder (die im Trainingsdatensatz eindeutig sind). Als die Studie hingegen dieselbe Methode auf die stabile Diffusion anwendete, konnte sie selbst nach dem Versuch, die 10.000 Proben mit den meisten Ausreißern zu extrahieren, keine Erinnerungen identifizieren. Daher ist Imagen sowohl bei kopierten als auch bei nicht kopierten Bildern weniger privat als Stable Diffusion. Dies kann daran liegen, dass Imagen ein größeres Modell als Stable Diffusion verwendet und sich daher mehr Bilder merkt. Darüber hinaus trainiert Imagen mit mehr Iterationen auf kleineren Datensätzen, was ebenfalls zur Verbesserung der Speicherkapazität beitragen kann.

Das obige ist der detaillierte Inhalt vonMit kleinen Tricks zum Ausgraben des Diffusionsmodells sind die generierten Bilder fast Nachbildungen der ursprünglichen Trainingsdaten, und die Privatsphäre steht kurz vor der Offenlegung.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!