In weniger als 3 Tagen vergeht das Jahr 2022.

Während wir uns vom Alten verabschieden und das Neue willkommen heißen, versammelten sich Ng Enda, Bengio und andere KI-Tycoons bei DeepLearning.ai, um mit ihren eigenen Augen auf das Jahr 2023 zu blicken.

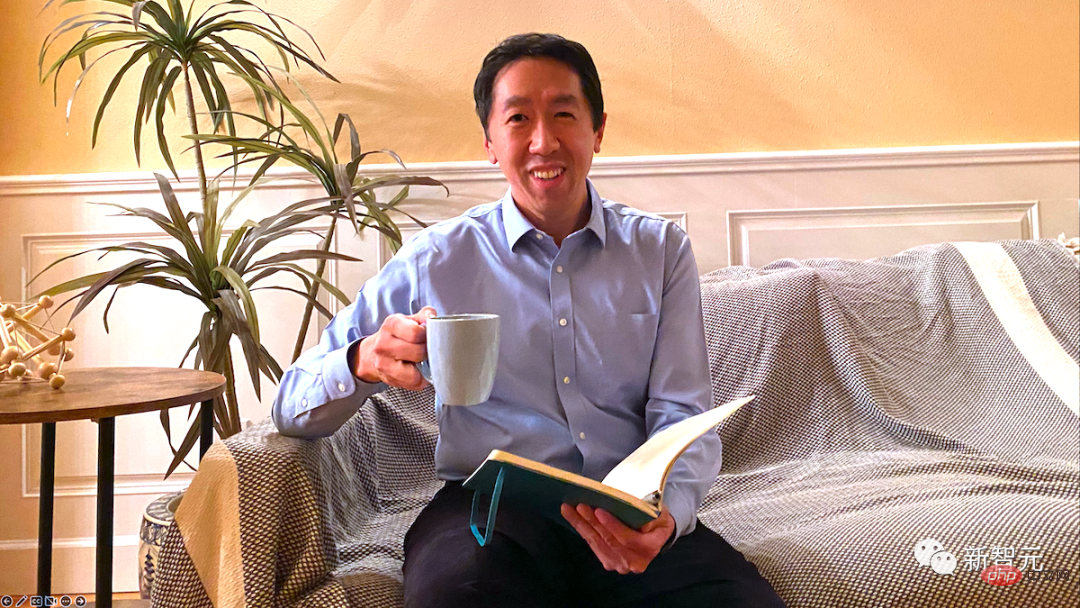

Als Gründer von DeepLearning.ai hielt Andrew Ng zunächst eine Begrüßungsrede und erinnerte an die Jahre, in denen er mit der Forschung begann, was einen guten Start für diese Diskussion mit vielen großen Namen darstellte.

Liebe Freunde:

Lasst uns zu Beginn des neuen Jahres 2023 nicht als ein einzelnes isoliertes Jahr betrachten, sondern als das Jahr in der Zukunft, in dem wir unsere langfristigen Ziele erreichen das erste Jahr. Es dauert lange, bis manche Ergebnisse erreicht sind, aber wir können dies effektiver erreichen, wenn wir uns einen Weg vorstellen, anstatt einfach von einem Meilenstein zum nächsten zu gehen.

Als ich jung war, habe ich kaum konkrete Zusammenhänge zwischen kurzfristigen Maßnahmen und langfristigen Ergebnissen hergestellt. Ich habe mich immer auf das nächste Ziel, Projekt oder die nächste Forschungsarbeit konzentriert und gesagt, es gäbe ein vages 10-Jahres-Ziel, aber keinen klaren Weg dorthin.

Vor 10 Jahren habe ich innerhalb einer Woche meinen ersten Kurs für maschinelles Lernen erstellt (oft um 2 Uhr morgens gefilmt). Dieses Jahr habe ich die Kursinhalte für das Hauptfach Maschinelles Lernen aktualisiert und den gesamten Kurs besser geplant (obwohl einige Aufnahmen immer noch um 2 Uhr morgens gemacht werden, ist die Anzahl jedoch reduziert!).

In früheren Unternehmen habe ich dazu tendiert, ein Produkt zu entwickeln und dann darüber nachzudenken, wie ich es an die Kunden bringen kann. Heutzutage denke ich bereits in der Anfangsphase stärker an die Bedürfnisse meiner Kunden.

Feedback von Freunden und Mentoren kann Ihnen dabei helfen, Ihre Vision zu gestalten. Ein großer Schritt in meiner Entwicklung bestand darin, zu lernen, dem Rat bestimmter Experten und Mentoren zu vertrauen und zu versuchen, ihn zu verstehen. Ich habe zum Beispiel Freunde, die Experten für globale Geopolitik sind und mir manchmal raten, in bestimmten Ländern mehr zu investieren.

Zu diesem Schluss kann ich selbst nicht kommen, da ich nicht viel über diese Länder weiß. Aber ich habe gelernt, meine langfristigen Pläne zu erklären, sie um Feedback zu bitten und aufmerksam zuzuhören, wenn sie mich in eine andere Richtung weisen.

Eines meiner obersten Ziele ist nun die Demokratisierung von KI-Innovationen. Ermöglichen Sie mehr Menschen, maßgeschneiderte Systeme für künstliche Intelligenz zu entwickeln und davon zu profitieren. Obwohl der Weg zu diesem Ziel lang und schwierig war, konnte ich die Schritte erkennen, die dorthin führen, und der Rat von Freunden und Mentoren hat mein Denken stark geprägt.

Wie weit können Sie mit dem Jahr 2023 in die Zukunft planen? Sie möchten sich Fachwissen zu einem Thema aneignen, Ihre Karriere vorantreiben oder ein technisches Problem lösen? Pfadannahmen treffen (auch ungetestete) und Feedback einholen, um sie zu testen und zu verfeinern?

Träume für 2023.

Frohes Neues Jahr!

Andrew Ng

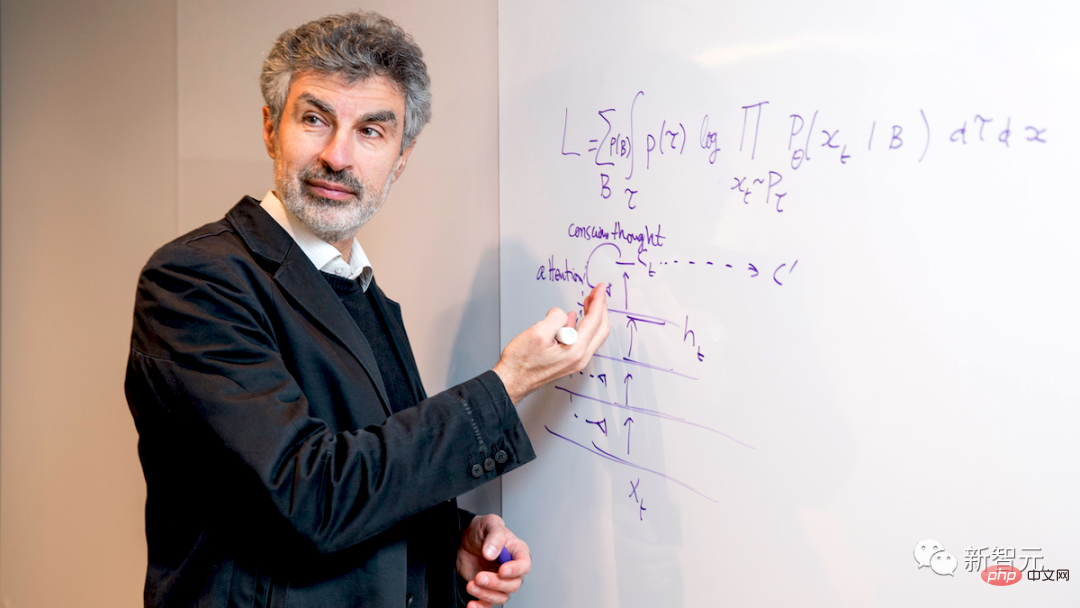

In der Vergangenheit basierte der Fortschritt des Deep Learning hauptsächlich auf „stärkenden Wundern“: der Einführung der neuesten Architektur, der Verbesserung der Hardware sowie der Erweiterung von Rechenleistung, Daten und Umfang. Verfügen wir bereits über die Architektur, die wir benötigen, und müssen wir nur noch bessere Hardware und Datensätze entwickeln, damit wir weiter skalieren können? Fehlt jetzt etwas?

Ich glaube, da fehlt etwas, und ich hoffe, diese fehlenden Dinge im kommenden Jahr zu finden.

Ich habe mit Neurowissenschaftlern und kognitiven Neurowissenschaftlern zusammengearbeitet, um die Kluft zwischen hochmodernen Systemen und Menschen zu untersuchen. Eine einfache Vergrößerung der Modellgröße wird diese Lücke nicht schließen. Stattdessen könnte die Kluft noch größer werden, wenn man in aktuelle Modelle eine menschenähnliche Fähigkeit einbaut, übergeordnete Konzepte und ihre Beziehungen zu entdecken und darüber nachzudenken.

Denken Sie über die Anzahl der Beispiele nach, die zum Erlernen einer neuen Aufgabe erforderlich sind, die sogenannte „Beispielkomplexität“. Das Trainieren eines Deep-Learning-Modells zum Spielen eines neuen Videospiels erfordert viel Gameplay, das Menschen sehr schnell erlernen können. Doch Computer müssen unzählige Möglichkeiten berücksichtigen, um eine effiziente Route von A nach B zu planen. Der Mensch braucht es nicht.

Menschen können die richtigen Wissensteile auswählen und diese Teile zusammenfügen, um eine relevante Reihe von Erklärungen, Antworten oder Plänen zu bilden. Darüber hinaus ist der Mensch anhand einer Reihe von Variablen sehr gut darin zu bestimmen, welche Ursachen und welche Auswirkungen sind. Die aktuelle Technologie der künstlichen Intelligenz kommt in dieser Fähigkeit nicht annähernd an das menschliche Niveau heran.

Normalerweise haben KI-Systeme großes Vertrauen in die Richtigkeit der von ihnen generierten Antworten und Lösungen, auch wenn diese tatsächlich falsch sind. Dieses Problem mag in einer Anwendung wie einem Textgenerator oder einem Chatbot ein lustiger Witz sein, in einem selbstfahrenden Auto oder einem medizinischen Diagnosesystem kann es jedoch lebensbedrohlich sein.

Das Verhalten aktueller KI-Systeme ist zum Teil darauf zurückzuführen, dass sie dafür konzipiert sind. Ein Textgenerator ist beispielsweise nur darauf trainiert, das nächste Wort vorherzusagen, und nicht darauf, eine interne Datenstruktur aufzubauen oder die Konzepte, auf denen er arbeitet, und die Beziehungen zwischen ihnen zu erklären.

Aber ich denke, wir können KI-Systeme entwerfen, die die Bedeutung von Dingen verfolgen und darüber nachdenken können, und gleichzeitig die vielen Vorteile aktueller Deep-Learning-Methoden nutzen. Dadurch werden Herausforderungen angegangen, die von übermäßiger Stichprobenkomplexität bis hin zu übermäßiger Konfidenzunrichtigkeit reichen.

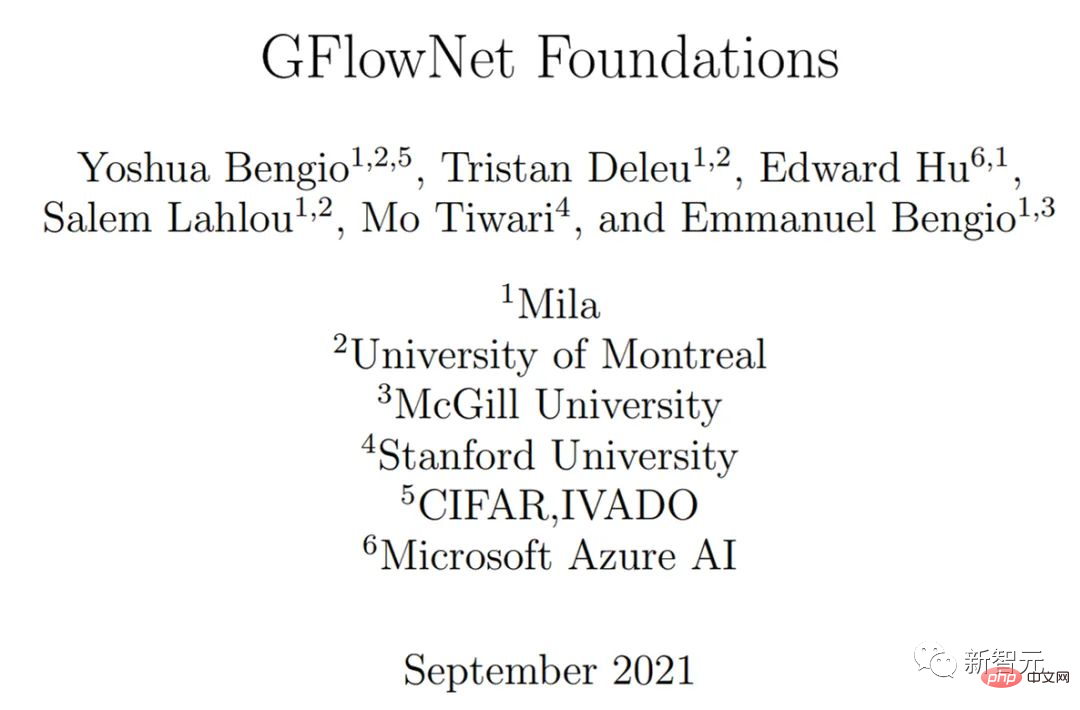

Link zum Papier: https://arxiv.org/pdf/2111.09266.pdf Unser Team Eine neue Methode zum Training tiefer Netzwerke wurde vor Jahren eingeführt. Die Idee wurde von der Art und Weise inspiriert, wie Menschen durch eine Reihe von Schritten denken und bei jedem Schritt neue relevante Informationen hinzufügen.

Dies ähnelt einem verstärkenden Lernen, da das Modell nacheinander Richtlinien lernt, um das Problem zu lösen. Es ähnelt auch der generativen Modellierung insofern, als es Lösungen testen kann, die probabilistischen Überlegungen entsprechen.

Wenn Sie über eine Interpretation eines Bildes nachdenken, kann Ihr Gedanke in einen Satz umgewandelt werden, aber es ist nicht der Satz selbst. Stattdessen enthält es semantische und relationale Informationen über die Konzepte im Satz. Im Allgemeinen stellen wir diesen semantischen Inhalt als Diagramm dar, in dem jeder Knoten ein Konzept oder eine Variable ist.

Ich glaube nicht, dass dies die einzige Lösung ist und freue mich auf verschiedene Ansätze. Durch vielfältige Erkundungen werden wir eine größere Chance haben, herauszufinden, was derzeit im Bereich der KI fehlt, und die Lücke zwischen dem heutigen Menschen und der KI auf menschlicher Ebene zu schließen.

Yoshua Bengio ist Professor für Informatik an der Universität Montreal und wissenschaftlicher Direktor des Mila-Quebec Institute for Artificial Intelligence. Für seine bahnbrechenden Beiträge zum Deep Learning erhielt er zusammen mit Geoffrey Hinton und Yann LeCun den Turing Award 2018.

Alon Halevy ist ein israelisch-amerikanischer Informatiker und Experte auf dem Gebiet der Datenintegration. Von 2005 bis 2015 war er als Forschungswissenschaftler bei Google tätig, wo er für Google Data Fusion Tables verantwortlich war.

Er ist ACM-Mitglied und erhielt im Jahr 2000 den U.S. Presidential Award ( PECASE). Er ist außerdem Gründer der Technologieunternehmen Nimble Technology (jetzt Actuate Corporation) und Transformic Inc.

Im Ausblick für 2023 konzentriert sich Halevy auf den Aufbau der Zeitleiste für personenbezogene Daten.

Wie nutzen Unternehmen und Organisationen Benutzerdaten? Dieses wichtige Thema hat sowohl in technischen als auch in politischen Kreisen große Aufmerksamkeit erregt.

Im Jahr 2023 gibt es eine ebenso wichtige Frage, die mehr Aufmerksamkeit verdient: Wie nutzen wir als Einzelpersonen die generierten Daten? Unsere Gesundheit verbessern, Energie und Produktivität steigern?

Wir generieren jeden Tag alle Arten von Daten. Fotos halten unsere Lebenserfahrungen fest, Mobiltelefone zeichnen unsere Trainingseinheiten und Standorte auf und Internetdienste zeichnen auf, was wir konsumieren und kaufen.

Wir erfassen auch verschiedene Wünsche: Ausflüge, die wir unternehmen möchten, und Restaurants, die wir ausprobieren möchten, Bücher und Filme, die wir genießen möchten, und möchten Kontakte knüpfen.

Schon bald werden Datenbrillen unsere Erlebnisse detaillierter aufzeichnen. Allerdings sind diese Daten über viele Anwendungen verteilt. Um vergangene Erfahrungen besser zusammenfassen zu können, müssen wir täglich vergangene Erinnerungen aus verschiedenen Anwendungen organisieren.

Können Sie alle Informationen in einer persönlichen Zeitleiste zusammenfassen, um uns dabei zu helfen, unsere Ziele, Hoffnungen und Träume zu erreichen? Tatsächlich hatte jemand diese Idee schon vor langer Zeit.

Bereits 1945 entwarf der amerikanische Wissenschaftler Vannevar Bush ein Produkt, das er Memex nannte. In den 1990er Jahren entwickelten Gordon Bell und Kollegen von Microsoft Research MyLifeBits, das alle Informationen über das gesamte Leben eines Menschen speichern kann.

Aber wenn wir alle Daten an einem Ort aufbewahren, ist der Schutz der Privatsphäre und die Verhinderung des Missbrauchs von Informationen offensichtlich ein zentrales Thema.

Derzeit kann kein Unternehmen alle unsere Daten besitzen und ist auch nicht berechtigt, alle unsere Daten zu speichern. Daher ist eine gemeinsame Anstrengung erforderlich, um die Technologie zur Unterstützung persönlicher Zeitpläne zu entwickeln, einschließlich Protokollen für den Datenaustausch, verschlüsselter Speicherung und sicherer Verarbeitung.

Es gibt zwei technische Herausforderungen, die gelöst werden müssen.

Die erste Herausforderung ist eine intelligente Frage und Antwort zum System. Obwohl wir bei der Beantwortung von Fragen auf der Grundlage von Texten und multimodalen Daten erhebliche Fortschritte gemacht haben, erfordert eine intelligente Beantwortung von Fragen in vielen Fällen, dass wir explizit über die Menge der Antworten nachdenken.

Dies ist die Basis des Datenbanksystems. Um beispielsweise zu antworten: „Welche Cafés habe ich in Tokio besucht?“ oder „Wie viele Halbmarathons bin ich in zwei Stunden gelaufen?“ muss die Sammlung als Zwischenantwort abgerufen werden. Diese Aufgabe kann derzeit in der Verarbeitung natürlicher Sprache nicht gelöst werden.

Um mehr Inspiration aus der Datenbank zu ziehen, muss das System auch in der Lage sein, die Quelle der Antwort zu erklären und festzustellen, ob die Antwort richtig und vollständig ist.

Die zweite Herausforderung beim Aufbau einer persönlichen Zeitleiste besteht darin, eine Technologie zur Analyse der persönlichen Datenachse zu entwickeln, um die Lebensqualität des Benutzers zu verbessern.

Laut positiver Psychologie können Menschen positive Erfahrungen für sich selbst machen und bessere Gewohnheiten für eine bessere Entwicklung entwickeln. Ein KI-Agent, der Zugriff auf unser tägliches Leben und unsere Ziele hat, kann uns an Dinge erinnern, die wir erreichen und vermeiden müssen.

Natürlich liegt es an uns, was wir tun, aber ich glaube, dass eine KI, die unsere täglichen Aktivitäten vollständig verstehen kann, über ein besseres Gedächtnis und bessere Planungsfähigkeiten verfügt, allen sehr zugute kommen wird.

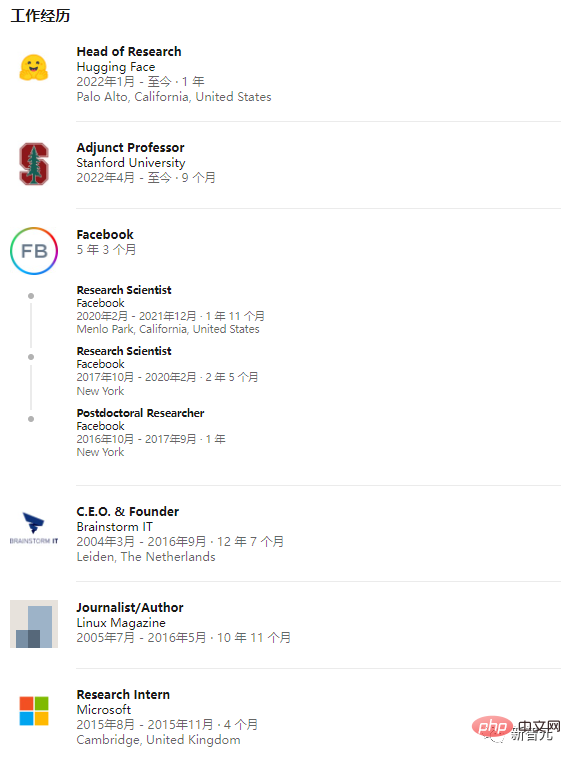

Douwe Kiela ist außerordentlicher Professor für symbolische Systeme an der Stanford University. Nach Abschluss seines Master- und Doktoratsstudiums an der Universität Cambridge arbeitete Kiela als Forscher bei IBM, Microsoft und Facebook AI sowie als Forschungsdirektor von Hugging Face.

In seinem Neujahrsausblick äußerte Kiela seine Wünsche für die Entwicklung künstlicher Intelligenzsysteme.

In diesem Jahr erleben wir wirklich, wie künstliche Intelligenz zum Mainstream wird. Systeme wie Stable Diffusion und ChatGPT haben die öffentliche Fantasie voll und ganz erobert.

Dies sind aufregende Zeiten und wir stehen an der Schwelle zu etwas Großartigem: Man kann ohne Übertreibung sagen, dass dieser Wandel der Fähigkeiten ebenso disruptiv sein wird wie die industrielle Revolution.

Aber inmitten der Aufregung sollten wir uns vor Hype hüten, besonders vorsichtig sein und Forschung und Entwicklung verantwortungsvoll betreiben.

Unabhängig davon, ob diese Systeme für große Sprachmodelle tatsächlich „Sinn ergeben“, werden Laien sie aufgrund ihrer Fähigkeit, das zu tun, was im Wesentlichen menschlich ist: Sprache produzieren, anthropomorphisieren.

Wir müssen die Öffentlichkeit jedoch über die Fähigkeiten und Grenzen dieser künstlichen Intelligenzsysteme aufklären, da die Öffentlichkeit größtenteils glaubt, dass Computer immer noch dieselben alten symbolischen Prozessoren sind, sie sind beispielsweise gut in Mathematik, aber nicht gut bei der Kunst und der aktuellen Situation Ganz im Gegenteil.

Moderne KI weist einen schwerwiegenden Fehler auf und ihre Systeme können leicht versehentlich oder absichtlich missbraucht werden. Sie produzieren nicht nur Fehlinformationen, sie wirken auch so selbstbewusst, dass die Leute ihnen glauben.

Diesen KI-Systemen fehlt ein ausreichendes Verständnis der komplexen multimodalen menschlichen Welt und sie verfügen nicht über das, was Philosophen „Volkspsychologie“ nennen, also die Fähigkeit, das Verhalten und die mentalen Zustände anderer zu erklären und vorherzusagen.

Derzeit sind KI-Systeme immer noch nicht nachhaltig ressourcenintensive Produkte, und wir wissen sehr wenig über die Beziehung zwischen den eingegebenen Trainingsdaten und dem Ausgabemodell.

Gleichzeitig kann die Modellskalierung zwar die Effektivität erheblich verbessern – zum Beispiel erscheinen bestimmte Funktionen erst, wenn das Modell eine bestimmte Größe erreicht –, aber es gibt auch Anzeichen dafür, dass dieses Modell mit zunehmender Skalierung eher voreingenommen ist sogar Es ist ein noch unfaireres System.

Meine Hoffnung für 2023 ist also, dass wir diese Probleme verbessern können. Forschung zu Multimodalität, Lokalisierung und Interaktion kann es Systemen ermöglichen, die reale Welt und das menschliche Verhalten besser zu verstehen und so den Menschen besser zu verstehen.

Die Untersuchung von Ausrichtung, Zuschreibung und Unsicherheit kann KI-Systeme sicherer machen, weniger anfällig für Halluzinationen und genauere Belohnungsmodelle erstellen. Datenzentrierte KI verspricht, effizientere Skalierungsgesetze zu demonstrieren, die Daten effektiver in robuste und faire Modelle umwandeln.

Link zum Papier: https://arxiv.org/pdf/2007.14435.pdf

Abschließend sollten wir der anhaltenden Bewertungskrise der künstlichen Intelligenz mehr Aufmerksamkeit schenken. Wir benötigen detailliertere und umfassendere Messungen unserer Daten und Modelle, um sicherzustellen, dass wir unsere Fortschritte und Grenzen beschreiben und uns aus der Perspektive der ökologischen Validität (z. B. reale Anwendungsfälle von KI-Systemen) verstehen können. Was Sie wirklich davon profitieren möchten Entwicklung künstlicher Intelligenz.

Been Kim ist Wissenschaftler bei Google Brain und hat seinen Abschluss am MIT. Sein Forschungsgebiet ist interaktives maschinelles Lernen.

Sie war zwar begeistert von der Kreativität und den vielen Erfolgen, die KI im vergangenen Jahr gezeigt hat, brachte aber auch einige ihrer Ansichten zur zukünftigen KI-Forschung zum Ausdruck.

Es ist eine aufregende Zeit für KI, mit faszinierenden Fortschritten in der generativen Kunst und vielen anderen Anwendungen,

Diese Richtungen sind zwar aufregend, aber ich denke, wir müssen weniger wählerisch arbeiten Dinge, nicht nur, wie viel mehr KI schaffen kann oder wie groß ein Modell sein kann:

Kehren Sie zu den Grundlagen zurück und studieren Sie KI-Modelle als wissenschaftliches Untersuchungsziel.

Warum machst du das?

Der Bereich der Interpretierbarkeit zielt darauf ab, Werkzeuge zu schaffen, um Erklärungen für die Ausgabe komplexer Modelle zu generieren und uns dabei zu helfen, die Beziehung zwischen KI und Menschen zu erforschen.

Zum Beispiel nimmt ein Tool ein Bild und ein Klassifizierungsmodell und generiert eine Erklärung in Form von gewichteten Pixeln. Je höher das Gewicht eines Pixels ist, desto wichtiger ist es. Je stärker sich beispielsweise sein Wert auf die Ausgabe auswirkt, desto wichtiger kann er sein, aber wie Wichtigkeit definiert wird, variiert von Werkzeug zu Werkzeug.

Während generative KI einige Erfolge erzielt hat, haben viele Tools nachweislich auf eine Weise funktioniert, die wir nicht erwartet hatten.

Zum Beispiel ist die Interpretation eines untrainierten Modells quantitativ und qualitativ nicht von der Interpretation eines trainierten Modells zu unterscheiden, und trotz der gleichen Ausgabe ändert sich die Interpretation oft mit kleinen Änderungen in der Eingabe.

Außerdem besteht kaum ein Kausalzusammenhang zwischen der Ausgabe des Modells und der Interpretation des Tools. Andere Arbeiten haben gezeigt, dass eine gute Interpretation der Ergebnisse eines Modells nicht unbedingt einen positiven Einfluss darauf hat, wie Menschen das Modell nutzen.

Was bedeutet dieses Missverhältnis zwischen Erwartungen und Ergebnissen und was sollten wir dagegen tun? Es legt nahe, dass wir untersuchen müssen, wie wir diese Tools erstellen.

Derzeit verfolgen wir einen technikorientierten Ansatz: Versuch und Irrtum. Wir bauen das Tool auf der Grundlage unserer Intuition auf (z. B. generieren wir Gewichtungen für jeden Pixelblock statt für einzelne Pixel, die Interpretation ist intuitiver).

Link zum Papier: https://arxiv.org/pdf/1811.12231.pdf

Ein Team der Universität Tübingen hat herausgefunden, dass Texturen (wie Elefanten) von neuronalen Netzen gesehen werden Haut) mehr als die Form (der Umriss des Elefanten), obwohl wir bei der Interpretation des Bildes gesehen haben, dass der Umriss des Elefanten möglicherweise in Form von kollektiv hervorgehobenen Pixeln vorliegt.

Diese Forschung zeigt uns, dass Modelle möglicherweise keine Formen, sondern Texturen sehen, was als induktive Verzerrung bezeichnet wird – eine Tendenz für eine bestimmte Klasse von Modellen, sich aus ihrer Architektur oder der Art und Weise, wie wir sie optimieren, zu ergeben.

Das Aufdecken dieser Tendenz kann uns helfen, Modelle zu verstehen, genauso wie das Aufdecken menschlicher Tendenzen dazu genutzt werden kann, menschliches Verhalten (z. B. unfaire Entscheidungen) zu verstehen.

Diese Methode, die häufig zum Verständnis von Menschen verwendet wird, kann uns auch dabei helfen, Modelle zu verstehen. Für Modelle verfügen wir aufgrund der Art und Weise, wie ihre internen Strukturen aufgebaut sind, über ein weiteres Werkzeug: die theoretische Analyse.

Die Arbeit in diese Richtung hat spannende theoretische Ergebnisse zum Verhalten von Modellen, Optimierern und Verlustfunktionen hervorgebracht. Einige nutzen klassische Werkzeuge aus der Statistik, der Physik, dynamischen Systemen oder der Signalverarbeitung, und viele Werkzeuge aus verschiedenen Bereichen müssen bei der Erforschung künstlicher Intelligenz noch erforscht werden.

Wissenschaft zu betreiben bedeutet nicht, dass wir mit der Praxis aufhören sollten: Die Wissenschaft ermöglicht es uns, Werkzeuge zu entwickeln, die auf Prinzipien und Wissen basieren, während die Praxis Ideen in die Realität umsetzt.

Link zum Papier: https://hal.inria.fr/inria-00112631/document

Auch die Praxis kann die Wissenschaft inspirieren: Was in der Praxis funktioniert, kann die Struktur der Wissenschaft liefern eine Referenz für verallgemeinerte Modellstrukturen, ebenso wie Hochleistungs-Faltungsnetzwerke im Jahr 2012 viele theoretische Arbeiten inspirierten, in denen analysiert wurde, warum Faltung die Generalisierung unterstützt.

Reza Zadeh ist der Gründer und CEO des Computer-Vision-Unternehmens Matroid. Seine Forschungsgebiete sind maschinelles Lernen, verteiltes Rechnen und diskrete Anwendungen . Mathematik und ein frühes Mitglied von Databricks.

Er glaubt, dass das kommende Jahr 2023 ein Jahr für den Durchbruch des aktiven Lernens sein wird.

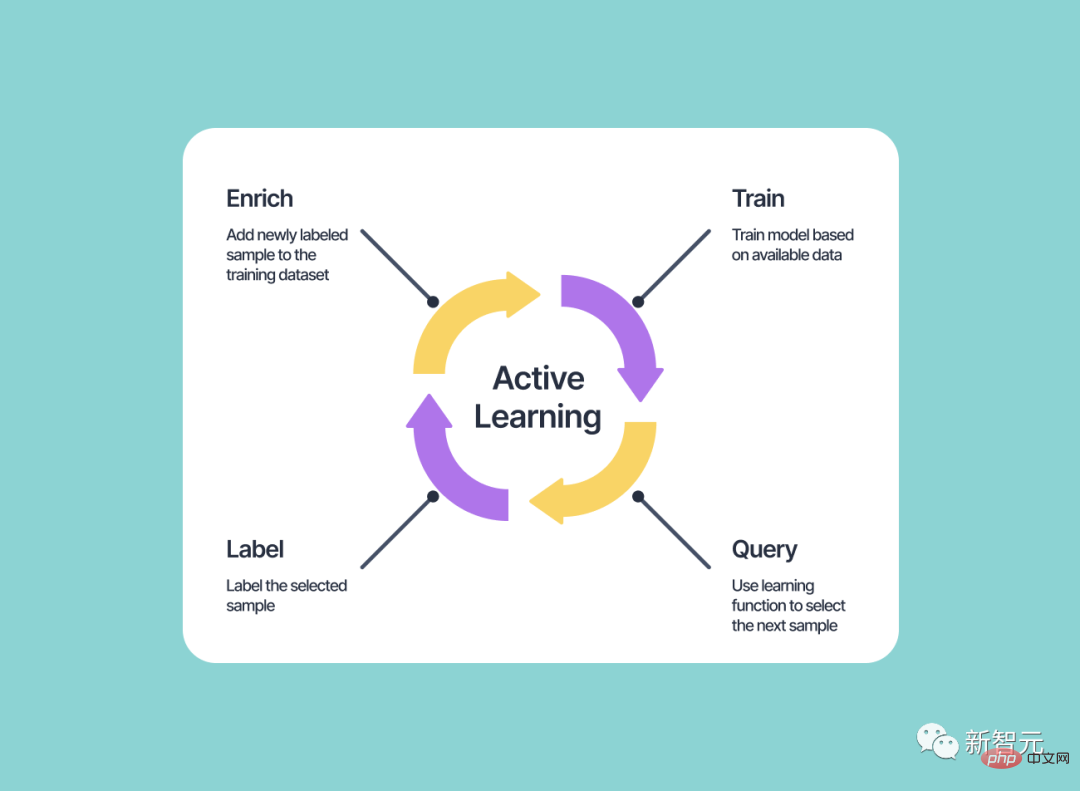

Zu Beginn des neuen Jahres besteht die Hoffnung, dass die Explosion generativer KI zu erheblichen Fortschritten beim aktiven Lernen führen wird.

Diese Technik ermöglicht es ML-Systemen, ihre eigenen Trainingsbeispiele zu generieren und diese zu kennzeichnen, während bei den meisten anderen Formen des maschinellen Lernens dem Algorithmus ein fester Satz von Beispielen gegeben wird und er typischerweise nur aus diesen Beispielen lernen kann.

Was kann aktives Lernen also für maschinelle Lernsysteme bringen?

Die Idee des aktiven Lernens gibt es schon seit Jahrzehnten, hat sich aber nie wirklich durchgesetzt. Bisher war es für Algorithmen schwierig, Bilder oder Sätze zu generieren, die Menschen auswerten und Lernalgorithmen weiterentwickeln konnten.

Aber mit der Beliebtheit der Bild- und Texterzeugungs-KI wird beim aktiven Lernen voraussichtlich große Durchbrüche erzielt. Wenn ein Lernalgorithmus nun nicht sicher ist, welche Bezeichnungen für einen Teil seines Codierungsraums richtig sind, kann er aus diesem Teil proaktiv Daten zur Eingabe generieren.

Aktives Lernen hat das Potenzial, die Art und Weise, wie maschinelles Lernen durchgeführt wird, zu revolutionieren, da es den Systemen ermöglicht, sich im Laufe der Zeit kontinuierlich zu verbessern und anzupassen.

Anstatt sich auf einen festen Satz gekennzeichneter Daten zu verlassen, kann ein aktives Lernsystem nach neuen Informationen und Beispielen suchen, die ihm helfen, das Problem, das es zu lösen versucht, besser zu verstehen.

Dies kann zu genaueren und effektiveren Modellen für maschinelles Lernen führen und den Bedarf an großen Mengen gekennzeichneter Daten verringern.

Ich freue mich auf die neuesten Fortschritte beim aktiven Lernen in der generativen KI. Zu Beginn des neuen Jahres werden wir wahrscheinlich mehr maschinelle Lernsysteme sehen, die Techniken des aktiven Lernens implementieren, und 2023 könnte das Jahr sein, in dem das aktive Lernen richtig Fahrt aufnimmt.

Das obige ist der detaillierte Inhalt von2023 steht vor der Tür, der Jahresausblick von Ng Enda, Bengio und anderen großen Jungs! Kommen rationale KI-Modelle?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was ist eine .Xauthority-Datei?

Was ist eine .Xauthority-Datei?

ASUS x402c

ASUS x402c

So überprüfen Sie tote Links auf Ihrer Website

So überprüfen Sie tote Links auf Ihrer Website

Lösung für keinen Ton im Win7-System

Lösung für keinen Ton im Win7-System

Wie man mit Blockchain Geld verdient

Wie man mit Blockchain Geld verdient

Was tun, wenn die temporäre Dateiumbenennung fehlschlägt?

Was tun, wenn die temporäre Dateiumbenennung fehlschlägt?

Befehl zur Paketerfassung unter Linux

Befehl zur Paketerfassung unter Linux

Formelle Handelsplattform für digitale Währungen

Formelle Handelsplattform für digitale Währungen