Bereits in den 1950er Jahren schlugen einige Wissenschaftler das Konzept der künstlichen Intelligenz (Künstliche Intelligenz) vor, dessen Zweck darin bestand, Computern menschliche Intelligenz (oder einen Teil davon) zu verleihen. Nach vielen Jahren der Entwicklung auf diesem Gebiet gab es bis zum Aufkommen der Deep-Learning-Technologie im Jahr 2012 immer noch keinen Durchbruch. Deep Learning löst hauptsächlich den Engpass bei der Modelldarstellungsfähigkeit. Die Modellierungsprobleme, mit denen wir konfrontiert sind, wie Bildverständnis, Sprachübersetzung, Spracherkennung, Vorhersage der Molekül-Protein-Bindungskonformation und andere Technologien, sind allesamt sehr komplexe nichtlineare Probleme. Vor dem Aufkommen des Deep Learning war die Fähigkeit zur Modelldarstellung sehr schwach Es war unmöglich, diese komplexen Probleme genau darzustellen. Die Deep-Learning-Technologie kann theoretisch Modelle jeder Tiefe erstellen, indem sie Modelle stapelt, den Engpass der Modelldarstellungsfähigkeiten durchbricht und so bahnbrechende Fortschritte in Bereichen wie Spracherkennung, Computer Vision und Verständnis natürlicher Sprache erzielt.

Das Aufkommen der Deep-Learning-Technologie markiert, dass die künstliche Intelligenz in eine neue Phase eingetreten ist, die etwa 2012 begann #🎜 🎜#Ära der künstlichen Intelligenz der neuen Generation (Tatsächlich lässt sich die Anwendung von Deep Learning im Bereich der Spracherkennung bis in die früheste Zeit zurückverfolgen, aber angesichts der Tatsache, dass viele Spätere Fortschritte im Deep Learning kamen aus dem Bereich Computer Vision, daher nehmen wir die Entstehung von AlexNet im Jahr 2012 als Ausgangspunkt. Dieser Zeitraum kann als die erste Stufe der neuen Generation künstlicher Intelligenz angesehen werden, die auf Deep Learning basiert. Das heißt, das annotationsdatengesteuerte Deep-Learning-Modell hat die Darstellungsmöglichkeiten des Modells erheblich verbessert und dadurch gefördert erhebliche Verbesserungen in der Technologie der künstlichen Intelligenz sowie Produkt- und Geschäftserfolge in den Bereichen Computer Vision und Spracherkennung. Die Hauptbeschränkung dieser Phase besteht darin, dass sie stark von der Menge der gekennzeichneten Daten abhängt. Da die Anzahl der Modellparameter zunimmt, ist eine große Menge an Trainingsdaten als Einschränkung erforderlich, um so viele Modellparameter zu lösen. Es ist sehr teuer, eine große Menge an kommentierten Daten zu erhalten, und nach Erreichen der 100-Millionen-Marke wird es schwierig sein, sie zu verbessern, und die von den Daten unterstützte effektive Modellgröße ist ebenfalls begrenzt. Im Zeitraum von 2012 bis 2015 war Computer Vision das aktivste Feld, wobei verschiedene Deep-Network-Modelle, darunter ResNet, entstanden. Im Jahr 2017 erschien mit Transformer ein wichtiges Grundlagenwerk. Im Bereich der Verarbeitung natürlicher Sprache (NLP), der keine großen Durchbrüche erzielen konnte, stach im Jahr 2019 eine Arbeit namens BERT heraus und erzielte die besten Ergebnisse bei mehr als einem Dutzend verschiedener Aufgaben der Verarbeitung natürlicher Sprache (NLP). Die Unterschiede zwischen diesen Aufgaben sind sehr groß, sodass die BERT-Arbeit nach der Veröffentlichung sofort die Aufmerksamkeit des gesamten Fachgebiets auf sich zog. BERT übernimmt eine Idee namens

Selbstüberwachtes Vortraining Es kann das Modell trainieren, ohne die Daten zu kennzeichnen, und verwendet nur die Einschränkungen des Textkorpus selbst (z. B (ein bestimmter Satz) An einer bestimmten Position können nur bestimmte qualifizierte Wörter verwendet werden), sodass im Internet vorhandene hochwertige Korpusse ohne manuelle Kalibrierung für das Training verwendet werden können, was die Menge der verfügbaren Trainingsdaten plötzlich stark erhöht, und mit The Das große Modell macht das BERT-Modell weitaus effektiver als frühere Modelle und bietet eine gute Vielseitigkeit für verschiedene Aufgaben, was es zu einem der Meilensteine auf dem Gebiet des NLP macht. Tatsächlich gab es 2018 vor dem Erscheinen von BERT eine Arbeit namens GPT (dh GPT1.0), die die Idee der Selbstüberwachung nutzte Für die Textgenerierung wird der vorherige Text eingegeben, und das Modell kann den folgenden Text vorhersagen und ausgeben. Ein hochwertiger Korpus kann ohne Anmerkungen trainiert werden. Sowohl BERT als auch GPT wurden auf Basis von Transformer entwickelt und Transformer hat sich nach und nach zu einem allgemeinen Modell im Bereich KI entwickelt. Die Wirkung von GPT1.0 ist nicht erstaunlich. Kurz nach der Einführung von BERT veröffentlichte GPT schnell die Modellgröße und die Menge an Trainingsdaten. Als allgemeines Modell (dh ohne nachgelagerte Aufgaben für Training und direkte Testergebnisse) sind die Ergebnisse besser als die aktuellen für die meisten Aufgaben. Da das BERT-Modell jedoch bei der Merkmalsdarstellung mehr Vorteile als das GPT2.0-Modell bietet und einfacher zu trainieren ist, ist BERT zu diesem Zeitpunkt immer noch die am meisten besorgniserregende Arbeit auf diesem Gebiet. Aber im Juli 2020 wurde GPT3.0 geboren und verblüffte alle mit 170 Milliarden Parametern. Noch wichtiger ist, dass GPT3.0 als universelles Sprachmodell dient, um die Generation zu beschreiben Basierend auf dem Inhalt können Sie ausführbaren Code generieren, Webseiten oder Symbole generieren, einen Artikel oder eine Nachricht vervollständigen und Gedichte und Musik entsprechend den Anweisungen schreiben, ohne dass eine Umschulung erforderlich ist. Nach dem Aufkommen von GPT3.0 hat es in der Branche große Aufmerksamkeit erregt und viele Entwickler haben viele interessante Anwendungen auf Basis von GPT3.0 erstellt. GPT3.0 hat sich zum besten und beliebtesten Textgenerierungsmodell entwickelt.

Nach dem Aufkommen der selbstüberwachten Pre-Training-Technologie können wir davon ausgehen, dass sich die neue Generation der künstlichen Intelligenz zur zweiten Stufe entwickelt hat, das heißt, die selbstüberwachte Pre-Training-Technologie hat die verfügbaren Trainingsdaten um verbessert Mehrere Größenordnungen, und die Trainingsdaten wurden mit der Unterstützung der Ära der allgemeinen großen Modelle, die auf selbstüberwachtem Vortraining basieren, erheblich verbessert. Nach

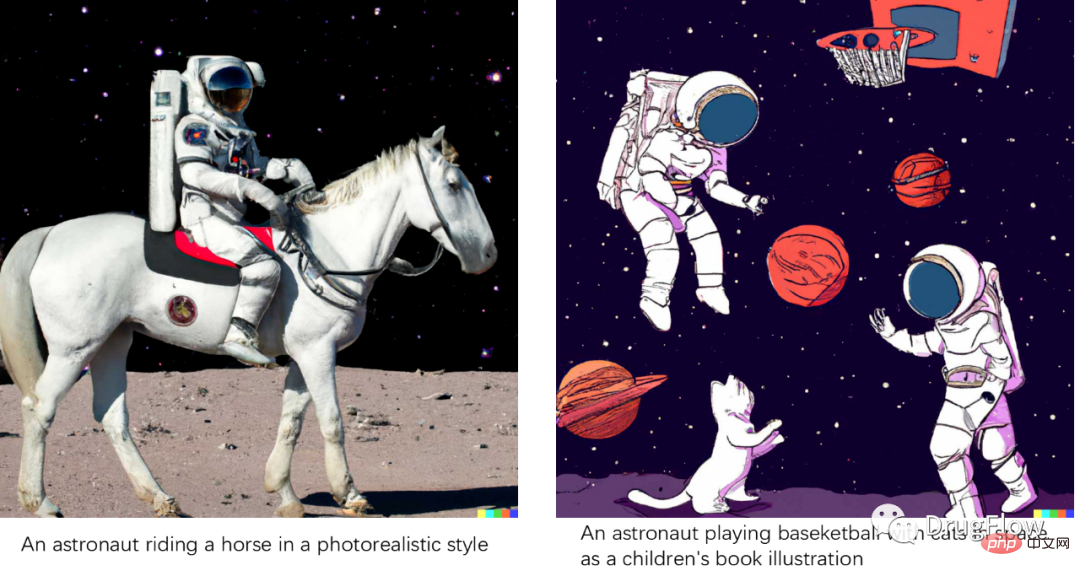

löste GPT3.0 zusammen mit anderen Arbeiten auf diesem Gebiet eine Welle von Wettrüsten in Modellgröße aus, aber es entstanden nur wenige wirklich bahnbrechende Technologien. Jeder ist sich darüber im Klaren, dass eine einfache Vergrößerung der Modellgröße das Problem nicht grundsätzlich löst. Gerade als sich alle auf das Aufkommen von Nachfolgearbeiten wie GPT4.0 freuen, wurde GPT seit zwei vollen Jahren nicht aktualisiert. In dieser Zeit konzentrierte sich die aktivste Arbeit auf dem Gebiet der künstlichen Intelligenz hauptsächlich auf zwei Aspekte: multimodale einheitliche Modelle und Inhaltsgenerierung. Multimodales einheitliches Modell, in der Hoffnung, ein multimodales oder modalübergreifendes einheitliches Modell zu erstellen, mit dem versucht wird, verschiedene modale Daten wie Text, Bild und Stimme einheitlich in einem Modell darzustellen, einschließlich des frühesten modalübergreifenden Darstellungsmodells CLIP und der nachfolgenden Serie multimodale einheitliche Darstellungsmodelle. Im Bereich der Content-Generierung sind einerseits auf technischer Ebene Basismodelle wie das Diffusionsmodell entstanden. Durch die Entwicklung des Diffusionsmodells und einer Reihe von Variantenmodellen ist der Bereich AI Generated Content (AIGC) entstanden. Es ist sehr heiß geworden und hat sich vom Bereich der Bilderzeugung auf die Bereiche der Verarbeitung natürlicher Sprache und der Biowissenschaften ausgeweitet. Auf der Anwendungsebene wurden jedoch viele wesentliche Fortschritte im Bereich der Bilderzeugung erzielt Die repräsentativste Arbeit unter ihnen ist DALLE2. Das Modell kann dem eingegebenen Text folgen. Selbst wenn die Textbeschreibung realistischer aussieht, ist es dennoch möglich, sie zu erzeugen die Textbeschreibung, wie in der Abbildung unten gezeigt. Der Erfolg einer Werkreihe wie DALLE2 ist einerseits auf die große Menge an Text-Bild-Korrespondenzdaten (ungefähr Hunderte Millionen Paare) zurückzuführen, die die Korrespondenz zwischen Text- und Bildsemantik modellieren, und andererseits Im Gegensatz zum Diffusionsmodell, das GAN überwindet, weisen VAE und andere Modelle Mängel auf, wie z. B. Schwierigkeiten beim Training und unzureichende Beibehaltung der Details der erzeugten Effekte. Die Effekte der Bilderzeugung sind so beeindruckend, dass viele Menschen glauben, dass KI bereits Inhalte erstellen kann.

Bild. DALLE2-Generationseffekt

Ende November 2022 veröffentlichte OpenAI ChatGPT. Nach der Veröffentlichung von ChatGPT stellte jeder fest, dass dieser Chatbot sehr ungewöhnlich ist und oft erstaunliche Antworten gibt. Es gibt viele Konversationsroboter im Bereich der Konversationsroboter, wie zum Beispiel Siri von Apple, Xiaobing Xiaona von Microsoft usw. Die Erfahrung mit diesen allgemeinen Konversationssystemen ist nicht sehr ideal. Die Leute benutzen sie, um sie zu necken und dann beiseite zu werfen. Das Systemgerüst von Frage-und-Antwort-Robotern zur Befehlsausführung, die in Produkten wie intelligenten Lautsprechern verwendet werden, basiert auf regelgesteuerten Dialogmanagementsystemen. Es gibt eine große Anzahl manueller Regeln, wodurch diese Systeme nicht auf allgemeine Bereiche erweitert werden können und kann nur einfache und stilisierte Antworten liefern, kann jedoch nicht mit den semantischen Umweltinformationen (Kontext) mehrerer Dialogrunden umgehen. Aus technischer Sicht unterscheidet sich ChatGPT grundlegend vom ursprünglichen Mainstream-Dialogsystem. Das gesamte System basiert auf einem Deep-Generation-Großmodell, das vom Deep-Modell verarbeitet wird und direkt eine abstrakte Zusammenfassungsantwort ausgibt. Auch im Hinblick auf das Produkterlebnis übertrifft ChatGPT frühere Chat-Systeme bei weitem. Als allgemeiner Chatbot kann er Fragen in fast jedem Bereich beantworten und seine Genauigkeit hat das Niveau erreicht, das Menschen bereit sind, ihn weiterhin zu verwenden. Er kann immer noch ein sehr gutes Erlebnis in mehreren Dialogrunden bieten.Natürlich ist ChatGPT als Deep-Learning-Modell nicht perfekt. Bei einigen Fragen, die genaue Antworten erfordern (z. B. mathematische Berechnungen, logisches Denken oder Namen). , es wird einige offensichtliche Fehler geben. Später gab es einige Verbesserungen. In Facebooks neuester Arbeit

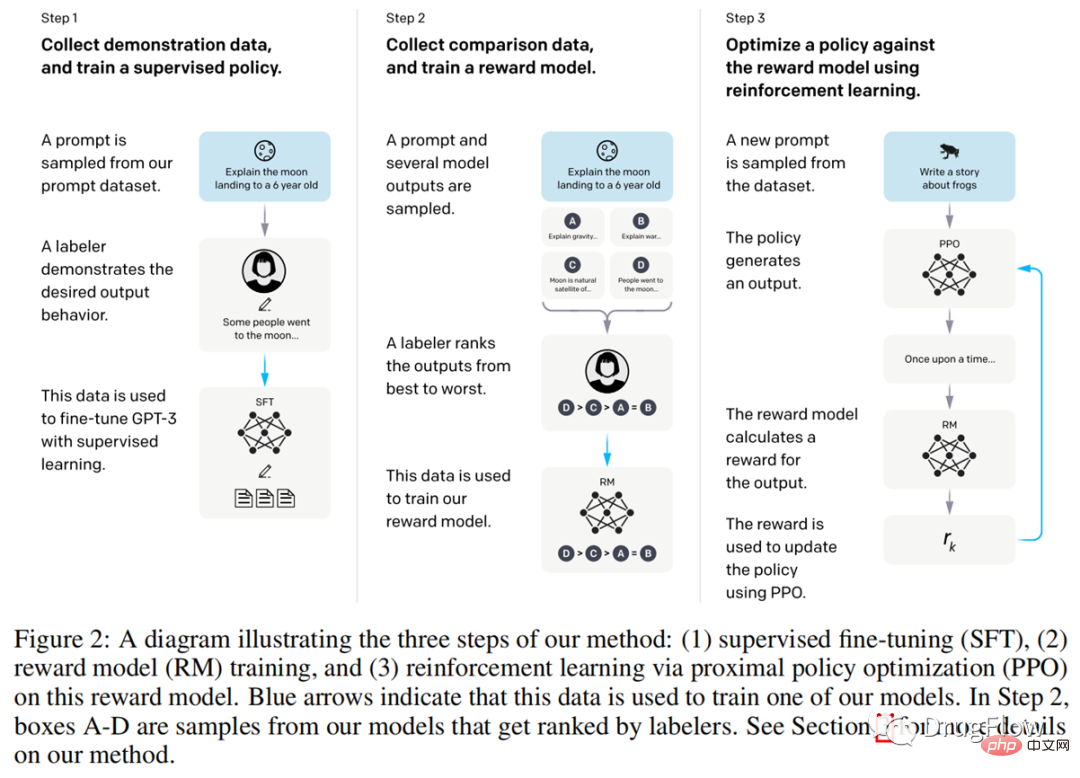

ToolFormer wird beispielsweise versucht, bestimmte Aufgaben zur Berechnung im generierten Modell zu übergeben Es wird erwartet, dass das Modell das Problem überwindet, dass das Modell nicht 100 % genau sein kann. Wenn dieser Weg voranschreitet, wird erwartet, dass das tiefe generative Modell zum Kernrahmen von AGI wird, und es ist sehr spannend, über die Integration anderer Skill-APIs über Plug-Ins nachzudenken. Kommerziell hat ChatGPT einerseits Fantasien über die Herausforderungen von Suchmaschinen wie Google ausgelöst, andererseits hat jeder verschiedene vertikale Produktanwendungsmöglichkeiten im Zusammenhang mit dem Verständnis natürlicher Sprache gesehen. Es besteht kein Zweifel, dass ChatGPT eine neue Geschäftsmöglichkeit im Bereich des Verstehens natürlicher Sprache schafft, die mit Suchempfehlungen konkurrieren kann. Warum hat ChatGPT so erstaunliche Effekte? Einer der Hauptgründe ist, dass ChatGPT auf der Grundlage des großen generativen Modells GPT3.5 erstellt wurde, das das beste Modell für die Textgenerierung im aktuellen Bereich des Verstehens natürlicher Sprache sein sollte (GPT3.5 verwendet mehr Daten und ist größer als das GPT3.0-Modell, mit besseren Ergebnissen). Der zweite Hauptgrund ist Reinforcement-Learning-Technologie basierend auf menschlichem Feedback, nämlich Reinforcement Learning from Human Feedback (abgekürzt als RLHF). Da OpenAI kein Papier zu ChatGPT veröffentlicht und den Code nicht veröffentlicht hat, wird allgemein angenommen, dass er der in einem früheren Artikel, InstructGPT (https://arxiv.org/pdf/2203.02155.pdf) offenbarten Technologie am ähnlichsten ist ). Wie in der folgenden Abbildung gezeigt, besteht der erste Schritt darin, Benutzerpräferenzdaten für verschiedene Antworten auf dieselbe Frage zu sammeln. Der zweite Schritt besteht darin, diese Präferenzdaten zum erneuten Trainieren des GPT-Modells zu verwenden zur Feinabstimmung der Überwachungsinformationen. Der dritte Schritt besteht darin, eine Bewertungsfunktion entsprechend der Präferenz des Benutzers für verschiedene Antworten zu trainieren. Diese Bewertung spiegelt die Präferenz des Benutzers für verschiedene Antworten wider Der Schritt besteht darin, diese Bewertungsfunktion als Methode des verstärkenden Lernens zu verwenden. Durch Feedback (Belohnung) wird das Modell des verstärkenden Lernens trainiert, sodass die endgültigen Antworten, die von ChatGPT ausgegeben werden, eher auf Antworten ausgerichtet sind, die den Benutzern gefallen. Durch den oben genannten Prozess gibt ChatGPT benutzerfreundlichere Antworten auf Benutzereingaben basierend auf GPT3.5 aus. ChatGPT Die erste Stufe des Trainings des GPT-Generierungsmodells verwendet viele Trainingsdaten, etwa Dutzende TB, und das Training eines Modells kostet mehrere zehn Millionen Dollar, während die zweite Stufe basiert zum Thema Verstärkungslernen Eine kleine Menge hochwertiger Datenrückmeldungen erfordert nur Zehntausende hochwertiger Daten. Wir können sehen, dass die ChatGPT-Technologie auf selbstüberwachten großen Modellen vor dem Training in Kombination mit Reinforcement-Learning-Technologie basierend auf menschlichem Feedback basiert und sehr bedeutende Fortschritte gemacht hat. Dieses neue Paradigma könnte zur Kernantriebstechnologie der dritten Stufe der künstlichen Intelligenz werden, die zunächst auf großen Modellen des selbstüberwachten Vortrainings basiert und dann mit Reinforcement-Learning-Technologie kombiniert wird, die auf einer kleinen Menge hoch- Hochwertiges Daten-Feedback, um einen geschlossenen Kreislauf von Modellen und Daten-Feedback zu bilden, um weitere technologische Durchbrüche zu erzielen. In Bezug auf ChatGPT sind unsere Ansichten wie folgt: (1) ChatGPT ist in der Tat eines der größten Werke dieser Ära und ermöglicht es uns, den Unterschied zwischen der Generierung großer Modelle auf der Grundlage selbstüberwachter Vorabmodelle zu erkennen -Training und basierend auf einer kleinen Anzahl hochwertiger Die erstaunliche Wirkung von KI nach Datenverstärkung Lern-Feedback-Strategie-Ergebnisse hat unsere Wahrnehmung in gewisser Weise verändert. (2) ChatGPT-bezogene Technologien haben einen sehr großen kommerziellen Wert, was dazu führt, dass viele Produkte, einschließlich Suchmaschinen, rekonstruiert oder untergraben werden müssen. Dies wird zweifellos viele neue Geschäftsmöglichkeiten mit sich bringen, von denen der gesamte NLP-Bereich profitieren wird. (3) Es wird erwartet, dass das Lernparadigma, das auf einer selbstüberwachten Pre-Training- und Reinforcement-Learning-Feedback-Strategie basiert, die auf einer kleinen Menge hochwertiger Daten basiert, in Zukunft zur treibenden Kraft für die Weiterentwicklung verschiedener Bereiche werden wird. Neben dem Bereich NLP wird erwartet, dass es auch in den Biowissenschaften und der Robotik eingesetzt wird. Das autonome Fahren und andere Bereiche haben eine neue Runde des Booms der künstlichen Intelligenz ausgelöst. (4) ChatGPT beweist nicht, dass künstliche Intelligenz einen menschlichen Geist hat. Ein Teil der Kreativität und Intelligenz, die ChatGPT zeigt, ist darauf zurückzuführen, dass das Korpus zum Verstehen natürlicher Sprache Semantik und Logik enthält und das generative Modell auf der Grundlage des Natürlichen trainiert wird Diese Korrespondenzen wurden im statistischen Sinne erlernt und scheinen über Intelligenz zu verfügen, aber nicht wirklich über einen menschlichen Geist. ChatGPT ist großartig, aber es ist nicht streng genug, um zu sagen, dass seine Intelligenz der eines mehrjährigen Kindes entspricht. Denn im Grunde genommen verfügt die KI noch nicht über die Fähigkeit, Menschen neues Wissen anzueignen, logisches Denken, Vorstellungskraft und Bewegungsrückmeldungen auszuführen. Ein übermäßiger Hype um die Intelligenz und die Fähigkeiten von ChatGPT wird gute Münzen vertreiben und der gesamten Branche schaden. (5) In diesem Bereich gibt es immer noch eine Lücke in der chinesischen Technologie. In den letzten zwei Jahren haben wir kein Textgenerierungsmodell gesehen, das die Wirkung von GPT3.0 ohne GPT3.0 und 3.5 wirklich reproduzieren kann. Es gäbe kein ChatGPT. Werke wie GPT3, GPT3.5 und ChatGPT sind nicht Open Source, und selbst die API ist in China blockiert. Dies ist eine praktische Schwierigkeit beim Kopieren von Werken. Um es pessimistischer auszudrücken: Die meisten Teams, die die Auswirkungen von ChatGPT nachahmen wollen, werden keinen Erfolg haben. (6) ChatGPT ist kein Algorithmus-Durchbruch von ein oder zwei Forschern, sondern das Ergebnis eines sehr komplexen Algorithmus-Engineering-Systems, das von fortschrittlichen Konzepten geleitet wird und in Bezug auf Team und Organisation aufeinander abgestimmt sein muss (analog zu OpenAI). und DeepMind). Ein rein forschungsorientiertes Team wird möglicherweise keinen Erfolg haben, ebenso wenig wie ein Team, das Deep Learning nicht ausreichend versteht und zu technikorientiert ist. Dieses Team benötigt: erstens ausreichende Ressourcenunterstützung, um teure Deep-Learning-Schulungen und die Rekrutierung von Talenten zu unterstützen; zweitens fachkundige Führungskräfte, die wirklich die Entwicklung großer Modellteams in der Branche geleitet haben. ChatGPT verfügt nicht nur über Algorithmeninnovationen, sondern auch über technische Systeminnovationen. Drittens, und vielleicht am wichtigsten, erfordert es eine Organisation, die geeint ist, zusammenarbeitet, eine einheitliche Führung hat und keine Veröffentlichung von Artikeln anstrebt (eine lockere Organisation ist der Algorithmeninnovation förderlich, aber nicht der technischen Algorithmenforschung förderlich) und ist es auch ausreichend ausgestattet. Was für großartige technische und algorithmische Talente. (7) Wir verfolgen nicht nur die Entwicklung eines ChatGPT, sondern verfolgen auch weiterhin die technologische Innovation dahinter, d Kleine Menge hochwertiger Daten. Dies ist die nächste Generation. Die Kerntechnologie von ChatGPT ist auch die Technologie, die den allgemeinen Fortschritt im Bereich der künstlichen Intelligenz fördert. Die größte Sorge besteht darin, dass aufgrund der Machtverteilung aufgrund von Spekulationen und der Verfolgung von Trends viele Ressourcen verschwendet werden oder dass eine übermäßige Werbung für ChatGPT der Branche schaden wird. (8) ChatGPT hat noch Raum für Verbesserungen und ist nicht die einzige Technologie, die Aufmerksamkeit und Erwartungen verdient. Das häufigste Missverständnis über KI besteht darin, ihre kurzfristige Leistung zu überschätzen und ihre langfristige Leistung zu unterschätzen. Dies ist eine großartige Ära, in der KI zur zentralen treibenden Kraft geworden ist, aber KI wird nicht so schnell allmächtig werden und erfordert unsere langfristigen Bemühungen. Hier fassen wir kurz die wichtigsten technologischen Entwicklungen in der neuen Generation der künstlichen Intelligenz zusammen, die seit 2012 durch Deep Learning verursacht wurden: (1) In der ersten Phase wird der wichtigste Fortschritt als datengesteuert bezeichnet Das überwachte Deep-Learning-Modell hat die Darstellungsmöglichkeiten des Modells erheblich verbessert und dadurch erhebliche Fortschritte in der Technologie der künstlichen Intelligenz gefördert. Die aktivsten Bereiche sind derzeit Computer Vision und Spracherkennung erhalten werden kann. Die Datenmenge begrenzt wiederum die effektive Modellgröße, die die Daten unterstützen können. selbstüberwachtes Vortraining von Big-Data-gesteuerten allgemeinen GroßmodellenDie selbstüberwachte Vortrainingstechnologie hat die verfügbaren Trainingsdaten um ein Vielfaches verbessert Die Größe des Modells wurde ebenfalls um mehrere Größenordnungen verbessert und ist zu einem allgemeinen Modell geworden, das für die Umschulung nicht auf Daten aus nachgelagerten Aufgabenfeldern angewiesen ist Der größte Fortschritt ist zu diesem Zeitpunkt am aktivsten. Die Haupteinschränkung besteht darin, dass ein umfangreiches Datentraining erforderlich ist. Das Modell ist sehr groß, teuer in der Schulung und Verwendung und das erneute Trainieren vertikaler Szenenmodelle ist ebenfalls sehr umständlich. Der sehr wichtige technische Schlüssel für die Zukunft ist, ob basierend auf dem großen Modell Verstärkungslernen, Eingabeaufforderungen und andere Methoden verwendet werden können, um die Ausgabeergebnisse des großen Modells mit nur einer kleinen Menge hochwertiger Daten erheblich zu beeinflussen . Wenn sich diese Technologie durchsetzt, werden Bereiche wie autonomes Fahren, Robotik und Biowissenschaften, in denen die Datenerfassung teuer ist, erheblich davon profitieren. Wenn man in der Vergangenheit die Probleme eines KI-Modells verbessern wollte, musste man große Datenmengen sammeln und das Modell neu trainieren. Wenn im Bereich der Roboter, die eine Offline-Interaktion erfordern, auf der Grundlage vorab trainierter großer Modelle die Entscheidungsfindung des Roboters nur dadurch beeinflusst werden kann, dass der Roboter über einige richtige und falsche Handlungsoptionen in realen Szenen informiert wird, dann ist die Technologie in Die Bereiche Fahrerloses Fahren und Robotik werden durch Iteration effizienter. Wenn im Bereich der Biowissenschaften nur eine kleine Menge experimenteller Datenrückmeldungen die Ergebnisse der Modellvorhersage erheblich beeinflussen kann, wird die Revolution bei der Integration des gesamten Bereichs der Biowissenschaften mit der Informatik schneller voranschreiten. An diesem Punkt ist ChatGPT ein sehr wichtiger Meilenstein und ich glaube, dass noch viel Arbeit vor uns liegt. Da die technologischen Fortschritte von ChatGPT die meisten NLP-bezogenen Bereiche verbessert haben, werden Technologien und Produkte im Zusammenhang mit der Abfrage, dem Abruf und der Extraktion von Informationen im Bereich der Biowissenschaften zuerst davon profitieren. Ist es beispielsweise möglich, dass es in Zukunft eine vertikale Konversationssuchmaschine im Bereich Life Sciences geben wird, in der Experten beliebige Fragen stellen können (z. B. Fragen zu Krankheiten, Zielen, Proteinen usw.) und zum einen Einerseits kann es umfassende Trends liefern (vielleicht nicht so präzise, aber wahrscheinlich richtig, hilft uns, ein Fachgebiet schnell zu verstehen), andererseits kann es relevante und wertvolle Informationen zu einem bestimmten Thema liefern, was die Informationen zweifellos erheblich verbessern wird Bearbeitungseffizienz von Experten. Ein weiteres Beispiel ist, ob man einen KI-Arzt bauen kann, damit Patienten sich über Krankheitswissen und Behandlungsmethoden beraten können (durch technische Einschränkungen kann KI keine präzisen Antworten geben, geschweige denn Ärzte ersetzen), aber er kann viele Informationen als Referenz liefern und Für Vorschläge, was zu tun ist, wird die Erfahrung auf jeden Fall deutlich besser sein als bei heutigen Suchmaschinen. Es gibt immer noch viele wichtige Aufgaben, die im Bereich der Biowissenschaften nicht gelöst wurden, wie z. B. die Vorhersage der Konformation und Affinität der Bindung zwischen kleinen Molekülen und Proteinen, die Vorhersage der Protein-Protein-Wechselwirkung, die Darstellung und Eigenschaftsvorhersage kleiner Moleküle sowie die Vorhersage der Proteineigenschaften und die Erzeugung kleiner Moleküle, Proteindesign, Retrosyntheseroutendesign und andere Aufgaben. Derzeit sind diese Probleme noch nicht vollständig gelöst. Wenn bei diesen Aufgaben Durchbrüche erzielt werden, werden die Arzneimittelforschung und sogar der gesamte Bereich der Biowissenschaften große Veränderungen mit sich bringen. Der auf großen Modellen basierende AIGC-Bereich und der auf Experten- oder experimentellem Feedback basierende RLHF-Bereich werden von der Förderung von ChatGPT profitieren und definitiv zu einer neuen Runde des technologischen Fortschritts führen. Unter anderem hat die AIGC-Technologie (Artificial Intelligence Content Generation) im vergangenen Jahr gute Fortschritte in den Bereichen der Erzeugung kleiner Moleküle und des Proteindesigns gemacht. Wir gehen davon aus, dass in naher Zukunft die folgenden Aufgaben erheblich von der Entwicklung der AIGC-Erzeugungstechnologie profitieren und technologische Schritte hervorbringen werden: (1) Technologie zur Erzeugung und Optimierung kleiner Moleküle, d. h. wie man sich nicht auf Aktive verlassen kann Ligandeninformationen. Stattdessen basiert es auf Proteintaschenstrukturinformationen, um kleine Ligandenmoleküle zu erzeugen, die verschiedene Bedingungen wie Aktivität, Arzneimittelfähigkeit und Synthetisierbarkeit umfassend berücksichtigen. Dieser Teil der Technologie wird erheblich von der Entwicklung des AIGC-Bereichs profitieren (3) Protein, Peptid, Auch AAV und andere Bereiche des Sequenzdesigns werden definitiv von der Entwicklung der AIGC-Technologie profitieren. Die oben genannten AIGC-bezogenen Aufgaben sowie fast alle Aufgaben, die experimentelles Verifizierungsfeedback erfordern, einschließlich, aber nicht beschränkt auf Aktivitätsvorhersage, Eigenschaftsvorhersage, Entwurf synthetischer Routen usw., werden die Möglichkeit haben, davon zu profitieren die Dividenden, die die RLHF-Technologie mit sich bringt. Natürlich gibt es viele Herausforderungen. Begrenzt durch die Menge der verfügbaren Daten sind die im Life-Science-Bereich verwendeten Modelle der aktuellen Generation immer noch relativ flach, und es werden hauptsächlich flache Deep-Learning-Modelle wie GNN verwendet (GNN ist durch die reibungslose Nachrichtenübertragung und die Anzahl der Schichten begrenzt). kann nur auf etwa 3 Ebenen verwendet werden), obwohl der Generierungseffekt ein gutes Potenzial zeigt, ist er immer noch nicht so erstaunlich wie ChatGPT. Die auf Experten- oder experimentellem Feedback basierende Reinforcement-Learning-Technologie ist durch die Geschwindigkeit der experimentellen Datengenerierung und die unzureichende Darstellungsfähigkeit des generierten Modells begrenzt. Außerdem wird es eine gewisse Zeit dauern, bis beeindruckende Effekte erzielt werden. Wenn wir jedoch aus dem Entwicklungstrend der ChatGPT-Technologie urteilen, können wir ein großes generatives Modell trainieren, das tief genug ist und über ausreichend starke Darstellungsfähigkeiten verfügt, und Verstärkungslernen verwenden, um die Wirkung des großen Modells basierend auf einer kleinen Menge hoher Werte weiter zu verbessern Ob hochwertige experimentelle Daten oder Experten-Feedback – wir können davon ausgehen, dass es auf dem Gebiet der AIDD definitiv eine Revolution geben wird. Kurz gesagt, ChatGPT ist nicht nur ein technologischer Fortschritt im Bereich des Verstehens natürlicher Sprache, es wird auch eine neue Runde von Geschäftstrends im Bereich Informationsdienste und Inhaltsgenerierung auslösen Die auf umfangreichen Daten basierende Deep-Generation-Technologie und die auf menschlichem Feedback basierende Reinforcement-Learning-Technologie sind eine längerfristige treibende Kraft für den Fortschritt und werden zu einer schnellen Entwicklung in Bereichen wie den Biowissenschaften führen. Wir werden eine weitere Welle der Weiterentwicklung der KI-Technologie und der industriellen Umsetzung einleiten.

Das obige ist der detaillierte Inhalt vonDie technischen Gründe für den Erfolg von ChatGPT und seine Inspiration für den Bereich der Biowissenschaften. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Es ist nicht möglich, das Standard-Gateway des Computers zu reparieren

Es ist nicht möglich, das Standard-Gateway des Computers zu reparieren

So aktivieren Sie die gleiche Stadtfunktion auf Douyin

So aktivieren Sie die gleiche Stadtfunktion auf Douyin

Überprüfen Sie den Speicherplatz unter Linux

Überprüfen Sie den Speicherplatz unter Linux

So laden Sie Ouyiokx auf

So laden Sie Ouyiokx auf

iPad-Spiele haben keinen Ton

iPad-Spiele haben keinen Ton

besonderer Symbolpunkt

besonderer Symbolpunkt

Tastenkombinationen für Python-Kommentare

Tastenkombinationen für Python-Kommentare

Beliebte Erklärung, was Metaverse XR bedeutet

Beliebte Erklärung, was Metaverse XR bedeutet