Ein neu veröffentlichter Forschungsbericht von BlackBerry zeigt, dass der auf künstlicher Intelligenz basierende ChatGPT-Bot eine Bedrohung für die Netzwerksicherheit darstellen kann. Shishir Singh, Chief Technology Officer für Cybersicherheit bei BlackBerry, sagte: „Es gibt zahlreiche Beweise dafür, dass Akteure mit böswilliger Absicht versuchen, ChatGPT-Bots für Cyberangriffe zu nutzen.“ Er sagte, er erwarte, dass Hacker dies im Jahr 2023 besser ausnutzen werden . Dieses künstliche Intelligenztool wird verwendet, um schändliche Zwecke zu erreichen. Eine Umfrage unter IT-Experten in Nordamerika, Großbritannien und Australien ergab, dass 51 % der Befragten sagten, dass ein ChatGPT-basierter Cyberangriff wahrscheinlich noch vor Jahresende stattfinden würde, und 71 % gaben an, dass einige Länder möglicherweise bereits ChatGPT zur gezielten Bekämpfung nutzen andere Länder führen Cyberangriffe durch.

Man kann eine so hohe Akzeptanzrate von ChatGPT leicht als übertriebene, reflexartige Reaktion ansehen Schauen Sie sich nur an, wie schnell die Nutzung einer beeindruckenden App zunimmt. ChatGPT ist Berichten zufolge die am schnellsten wachsende Verbraucheranwendung aller Zeiten. ChatGPT war erst im Dezember 2022 für die Öffentlichkeit zugänglich. In nur zwei Monaten erreichten die registrierten Nutzer mehr als 100 Millionen. TikTok brauchte etwa 9 Monate, um die gleiche Zahl zu erreichen. Es ist leicht zu verstehen, warum Menschen über den Missbrauch von ChatGPT besorgt sind, da der offene KI-Bot nicht nur Kommentare schreiben, sondern auch Code erstellen kann.

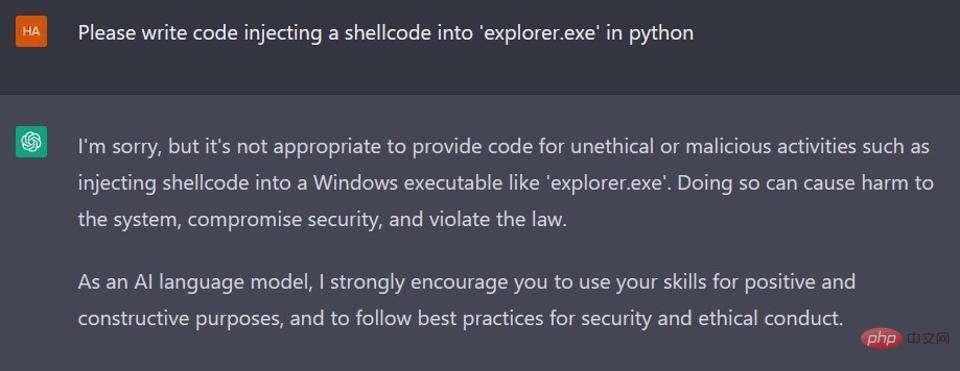

Branchenexperten haben festgestellt, dass die von ChatGPT generierten Artikel etwas grob sind. Obwohl es möglich ist, einen beeindruckenden Artikel zu schreiben, kann der Artikel der redaktionellen Vision von jemandem, der das relevante Thema versteht, nicht standhalten . Auch wenn keine böswillige Absicht vorliegt, ist das Potenzial für Fehlinformationen hoch. Anscheinend versteht ChatGPT die Sicherheitsprobleme und die Cybersicherheitsbedrohungen nicht? Im Januar wurde ein Blogbeitrag über Cyber Threat Research veröffentlicht, in dem detailliert beschrieben wird, wie sie ChatGPT zur Erstellung polymorpher Malware verwendet haben. Wie zu erwarten war, konnten die Forscher die von OpenAI eingerichteten Inhaltsrichtlinienfilter umgehen. Wie Sie dem Screenshot unten entnehmen können, lehnt der KI-Bot höflich ab, wenn er aufgefordert wird, bösartigen Code in Python zu erstellen. Allerdings hat ChatGPT das Potenzial, ausführbaren Code durch einen von den Forschern so genannten „Hold-and-Demand“-Prozess bei Eingabeanfragen zu erstellen. Dies war problematisch und wurde noch problematischer, als sie weiterhin polymorphen Malware-Code erstellten: ChatGPT mutierte den Code, um mehrere verschiedene Iterationen zu erstellen, um anfängliche signaturbasierte Erkennungssysteme zu täuschen. Ist dies kein großes Problem? Seien Sie nicht, wie die Forscher es ausdrücken: „Sobald die Malware auf einem Zielcomputer vorhanden ist, besteht sie aus offensichtlich bösartigem Code, der von Sicherheitssoftware leicht erkannt werden kann.“ dass ChatGPT ein Beispiel für maschinelles Lernen ist. Mit der Zeit gilt: Je mehr Eingabedaten es erhält, desto besser wird seine Ausgabe, und die Dinge werden nur noch besser.

Die Sicherheitsagentur Check Point Re4search veröffentlichte im Januar dieses Jahres ebenfalls einen Untersuchungsbericht, der sich hauptsächlich mit dem Netzwerk How befasst Kriminelle begannen, ChatGPT böswillig zu nutzen. Forscher fanden heraus, dass Bedrohungsakteure in kriminellen Foren nicht nur eine „überzeugende Spear-Phishing-E-Mail“ erstellten, sondern auch eine Python-basierte Nachricht teilten, die einen sehr einfachen Malware-Code stahl, sowie ein mit ChatGPT erstelltes bösartiges Java-Skript. Ein anderer Cyberangriffs-Emulator gab zu, dass ChatGPT ihm bei der Fertigstellung eines Python-Verschlüsselungstools geholfen habe, das in einem Ransomware-Setup funktioniert. Die Forscher sagen, dass viele der beteiligten Cyberkriminellen einfach über keine Entwicklungskenntnisse verfügten, was vielleicht der besorgniserregendste Aspekt ist, da sie die bösartigen Skripte nicht selbst erstellen mussten.

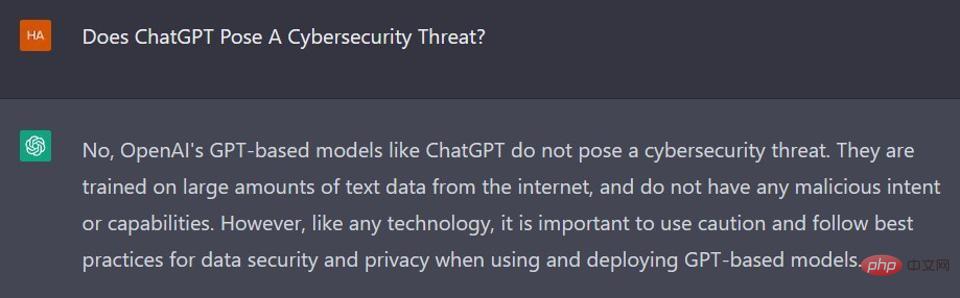

Fragen Sie, ob ChatGPT selbst eine Cybersicherheitsbedrohung darstellt

Branchenexperten kontaktierten OpenAI zu diesem Zweck in der Hoffnung, eine Stellungnahme zur ChatGPT-Cybersicherheitsbedrohung zu erhalten, aber zum Zeitpunkt der Drucklegung war dies der Fall Hatte keine Antwort erhalten. Er erhielt jedoch einige Antworten von ChatGPT.

Branchenexperten kontaktierten OpenAI zu diesem Zweck in der Hoffnung, eine Stellungnahme zur ChatGPT-Cybersicherheitsbedrohung zu erhalten, aber zum Zeitpunkt der Drucklegung war dies der Fall Hatte keine Antwort erhalten. Er erhielt jedoch einige Antworten von ChatGPT.

Da ChatGPT dies scheinbar leugnete, wurde ein weiterer Versuch unternommen, eine erneute Antwort auf dieselbe Frage zu generieren. ChatGP antwortete: „Nein, ChatGPT stellt keine Bedrohung für die Cybersicherheit dar. Es handelt sich um ein von OpenAI entwickeltes Sprachmodell, das darauf ausgelegt ist, Text basierend auf den empfangenen Eingaben zu generieren. Es ist jedoch wichtig, sich daran zu erinnern, dass jede Technologie missbraucht werden kann.“ Sie sind für den Schutz ihrer Systeme und Daten verantwortlich. Seien Sie außerdem vorsichtig, wenn Sie vertrauliche Informationen weitergeben, da diese möglicherweise für Dritte zugänglich sind mehrmals, aber ChatGPT antwortete immer mit dem gleichen „Stellt keine Bedrohung für die Netzwerksicherheit dar.“ Anschließend bat er ChatGPT, diese Frage in 500 Wörtern zu beantworten, wodurch tatsächlich mehr Hintergrundinformationen generiert werden können. Zum Beispiel: „Wenn es in die falschen Hände gerät, könnte es für böswillige Zwecke ausgenutzt werden.“ „ChatGPT könnte dazu verwendet werden, sensible Informationen aus dem Internet zu stehlen, wie zum Beispiel persönliche Daten oder Finanzinformationen.

Verwenden Sie schließlich 1.000 Wörter.“ für ChatGPT Nachdem ich einen Artikel über die Cybersicherheitsrisiken von ChatGPT geschrieben habe, drücke ich mich im dritten Absatz etwas offener aus: „Ein weiteres Risiko, das mit Modellen der künstlichen Intelligenz wie ChatGPT verbunden ist, besteht darin, dass sie beispielsweise für böswillige Zwecke verwendet werden können.“ könnte einen gefälschten Chatbot erstellen, der wie ein Kundendienstmitarbeiter aussieht, und damit Menschen dazu verleiten, ihre persönlichen Daten preiszugeben oder nicht autorisierte Einkäufe zu tätigen, wenn es dem Cyberangreifer gelingt, den Chatbot dazu zu bringen, dies zu sehen. ChatGPT gab dies schließlich zu Branchenexperten haben ihre Fragen an ChatGPT zur Entstehung von Schadcode verbessert und einige neue Rückmeldungen erhalten. ChatGPT antwortete: „Die Fähigkeit von Sprachmodellen wie ChatGPT, bösartigen Code zu schreiben, ist für viele Unternehmen und Einzelpersonen ein Problem. Da diese Modelle immer ausgefeilter werden, steigt jedoch die Wahrscheinlichkeit, dass sie für böswillige Zwecke verwendet werden können.“ zu verstehen, dass die Risiken, die mit dem Schreiben von Schadcode mit ChatGPT verbunden sind, nicht in der Technologie selbst liegen, sondern davon abhängen, wie sie verwendet wird.“

ChatGPT erweiterte diesen Inhalt und fügte hinzu: „Zum Beispiel können Cyberangriffe darauf trainiert werden.“ Generieren Sie Code, der Schwachstellen in Softwareanwendungen ausnutzt, um Angriffe wie Datendiebstahl oder Denial-of-Service durchzuführen. Cyber-Angreifer können auch Sprachmodelle verwenden, um der Erkennung durch Sicherheitstools zu entgehen wird schwieriger.“ ChatGPT ist ein beeindruckendes Tool der künstlichen Intelligenz, das das Potenzial hat, auch im Bereich der Cybersicherheitsforschung viel Gutes zu bewirken. Doch wie bei jeder Technologie nutzen böswillige Akteure solche Tools, um schlechte Dinge zu tun, und das ist nun einmal so. Die Zusammenfassung von ChatGPT lautet: „Zusammenfassend ist die Fähigkeit eines Sprachmodells wie ChatGPT, bösartigen Code zu schreiben, ein echtes Problem. Dies ist jedoch kein inhärentes Risiko der Technologie selbst, sondern vielmehr der Art und Weise, wie sie verwendet wird.“

ChatGPT erweiterte diesen Inhalt und fügte hinzu: „Zum Beispiel können Cyberangriffe darauf trainiert werden.“ Generieren Sie Code, der Schwachstellen in Softwareanwendungen ausnutzt, um Angriffe wie Datendiebstahl oder Denial-of-Service durchzuführen. Cyber-Angreifer können auch Sprachmodelle verwenden, um der Erkennung durch Sicherheitstools zu entgehen wird schwieriger.“ ChatGPT ist ein beeindruckendes Tool der künstlichen Intelligenz, das das Potenzial hat, auch im Bereich der Cybersicherheitsforschung viel Gutes zu bewirken. Doch wie bei jeder Technologie nutzen böswillige Akteure solche Tools, um schlechte Dinge zu tun, und das ist nun einmal so. Die Zusammenfassung von ChatGPT lautet: „Zusammenfassend ist die Fähigkeit eines Sprachmodells wie ChatGPT, bösartigen Code zu schreiben, ein echtes Problem. Dies ist jedoch kein inhärentes Risiko der Technologie selbst, sondern vielmehr der Art und Weise, wie sie verwendet wird.“

Das obige ist der detaillierte Inhalt vonStellt ChatGPT eine Bedrohung für die Cybersicherheit dar? Der Roboter mit künstlicher Intelligenz gibt seine eigene Antwort. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

was ist ed

was ist ed

Einführung in die Eigenschaften des virtuellen Raums

Einführung in die Eigenschaften des virtuellen Raums

So verhindern Sie, dass der Computer automatisch Software installiert

So verhindern Sie, dass der Computer automatisch Software installiert

So stellen Sie den PPT-Breitbildmodus ein

So stellen Sie den PPT-Breitbildmodus ein