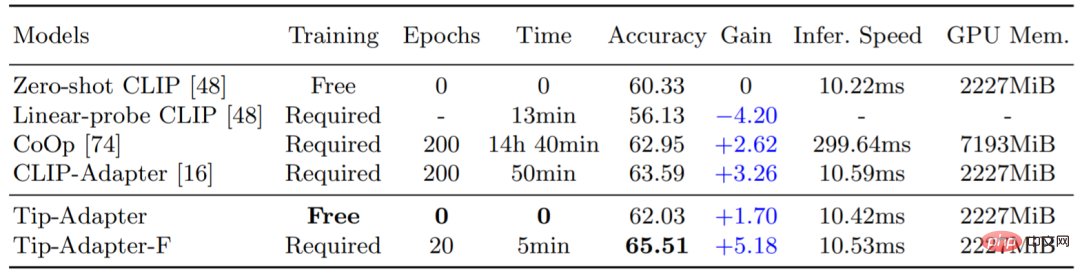

Das Contrastive Image Language Pre-Training Model (CLIP) hat kürzlich starke Fähigkeiten zur visuellen Domänenübertragung gezeigt und kann eine Zero-Shot-Bilderkennung für einen neuen Downstream-Datensatz durchführen. Um die Migrationsleistung von CLIP weiter zu verbessern, verwenden bestehende Methoden Fow-Shot-Einstellungen wie CoOp und CLIP-Adapter, die eine kleine Menge an Trainingsdaten für nachgelagerte Datensätze bereitstellen, sodass CLIP bessere Entscheidungen für verschiedene visuelle Szenarien treffen kann . Anpassung. Dieser zusätzliche Schulungsschritt wird jedoch einen erheblichen zeitlichen und räumlichen Ressourcenaufwand mit sich bringen, der sich in gewissem Maße auf die inhärente schnelle Wissenstransferfähigkeit von CLIP auswirkt. Daher schlagen wir Tip-Adapter vor, eine Methode zur Bildklassifizierung mit wenigen Bildern, die kein zusätzliches Downstream-Training erfordert und die Genauigkeit von CLIP erheblich verbessern kann. Auf dieser Grundlage haben wir eine Lösung vorgeschlagen, die mit nur geringem Feinabstimmungsaufwand eine Leistung auf dem neuesten Stand der Technik erzielen kann: Tip-Adapter-F, die den besten Kompromiss zwischen Effizienz und Leistung erzielt. Wie in Tabelle 1 unten gezeigt, benötigt Tip-Adapter keine Trainingszeit, wodurch die Genauigkeit von CLIP im ImageNet-Datensatz um +1,7 % (Accuracy) verbessert werden kann, während Tip-Adapter-F nur ein Zehntel der Trainingszeit benötigt der vorherigen Lösung (Epochen, Zeit) kann die beste vorhandene Klassifizierungsleistung erreicht werden.

Tabelle 1: Vergleich der Genauigkeit der 16-Aufnahmen-Bildklassifizierung und der Trainingszeit verschiedener Schemata im ImageNet-Datensatz

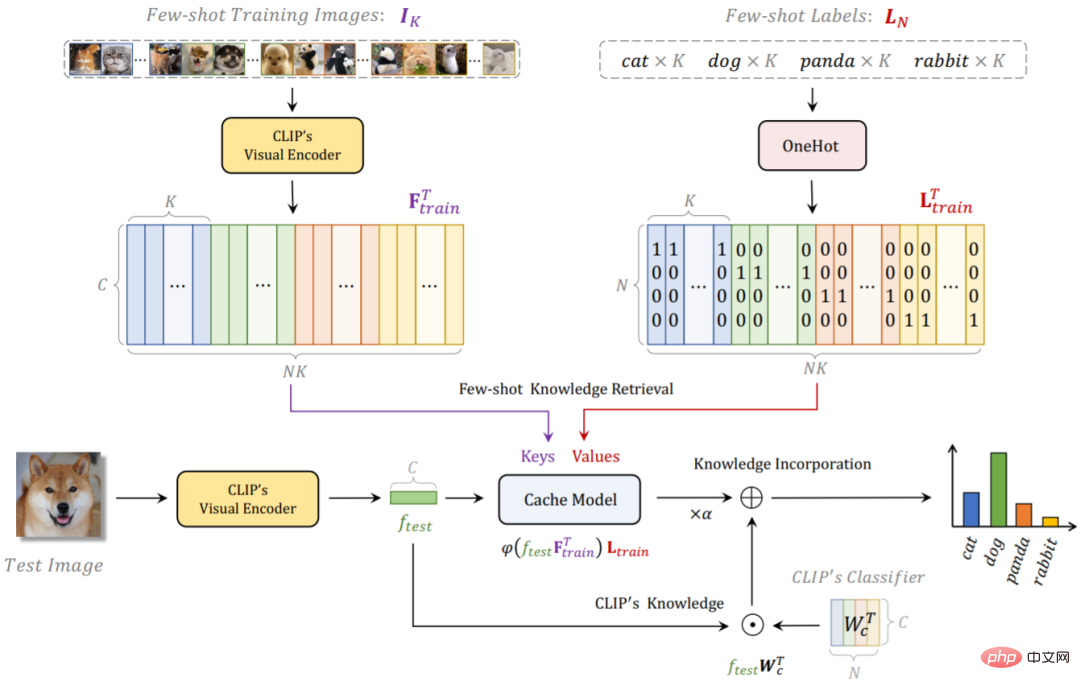

Die gesamte Netzwerkstruktur von Tip-Adapter ist in Abbildung 1 unten dargestellt. Für einen bestimmten Trainingsdatensatz und Etiketten mit wenigen Schüssen verwenden wir CLIP, um einen Cache für Nicht-Trainingslösungen zu erstellen Modell, das Klassifizierungswissen aus nachgelagerten Trainingsdaten speichert; Tip-Adapter erhält bessere endgültige Klassifizierungsergebnisse, indem es die Vorhersagen des Cache-Modells und die Vorhersagen des ursprünglichen CLIP linear addiert.

Im Detail verwenden wir den vorab trainierten visuellen Encoder von CLIP, um die Merkmale aller Bilder im Trainingssatz mit wenigen Aufnahmen als Schlüssel des Cache-Modells zu extrahieren und die entsprechenden Bildbezeichnungen in eins umzuwandeln. Hot-Codierungsform, als Werte des Cache-Modells. Diese Konstruktionsmethode des Schlüsselwert-Cache-Modells erfordert keinen Trainingsaufwand, da sie den vorab trainierten visuellen Encoder verwendet und da der Trainingssatz mit wenigen Aufnahmen nur eine kleine Anzahl von Bildern für jede Kategorie enthält (1 bis 16 Aufnahmen). Das Cache-Modell beansprucht außerdem nahezu keinen zusätzlichen Grafikspeicher-Overhead. Siehe die GPU-Speicherindikatoren in Tabelle 1.

Für ein Testbild verwenden wir zunächst den Visual Encoder von CLIP, um seine Funktionen abzurufen, und behandeln die Funktionen dann als Abfrage, um einen Wissensabruf für Downstream-Daten mit wenigen Aufnahmen im Cache-Modell durchzuführen. Da Schlüssel auch vom Visual Encoder von CLIP extrahiert werden, haben sie denselben Ursprung wie die Testbildfunktion. Abfrage. Wir können die Kosinusähnlichkeit zwischen ihnen direkt berechnen, um eine Schlüssel-Abfrage-Adjazenzmatrix zu erhalten. Diese Matrix kann als entsprechendes Gewicht angesehen werden zum Wert. Daher können wir die gewichtete Summe der Werte berechnen, um die Klassifizierungsvorhersage für dieses Testbild zu erhalten, das durch Abrufen des Cache-Modells erhalten wird. Darüber hinaus können wir auch die Zero-Shot-Vorhersage von CLIP erhalten, indem wir die Testbildfunktionen mit den Textfunktionen des Textual Encoder von CLIP abgleichen. Durch lineares Gewichten der Summe beider erhalten wir die endgültige Klassifizierungsvorhersage, die sowohl das durch CLIP vorab trainierte kontrastive Wissen der Bildsprache als auch das Wenig-Schuss-Wissen des neuen Downstream-Datensatzes enthält, sodass genauere Vorhersagen erzielt werden können. Hohe Bildklassifizierungsgenauigkeit.

Basierend auf der Netzwerkstruktur von Tip-Adapter können wir den Schlüsselteil im Cache-Modell weiter in Lernparameter umwandeln, die durch Training aktualisiert werden können. Diese Lösung ist Tip-Adapter-F. Mit Hilfe des bereits erstellten Cache-Modells benötigt Tip-Adapter-F nur ein Zehntel der Trainingsrunden und Zeit des vorhandenen CLIP-Adapters, um eine höhere Leistung zu erzielen, wie in Tabelle 1 gezeigt.

Abbildung 1: Netzwerkflussdiagramm von Tip-Adapter und Tip-Adapter-F

2. Unterschiede und Zusammenhänge zwischen Tip-Adapter und bestehenden Lösungen

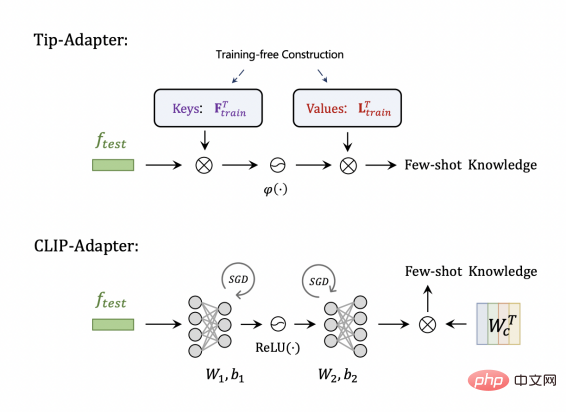

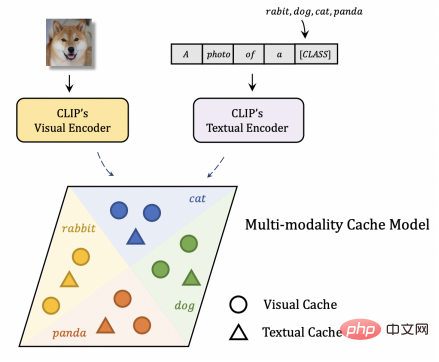

Vergleich CLIP-Adapter Wie in Abbildung 2 dargestellt, können die im Tip-Adapter gespeicherten Schlüssel und Werte tatsächlich den beiden linearen Schichten der Adapterstruktur im CLIP-Adapter entsprechen. Ersteres erfordert jedoch kein Training zum Erstellen und letzteres ist zufällig Anschließend ist Training erforderlich, um die optimalen Parameter zu erlernen. Abbildung 2: Tip-Adapter im Vergleich zu CLIP-Adapter Cache ist eine multimodale visuelle Sprache. Da die vom Text-Encoder von CLIP ausgegebenen Merkmale als Schlüsselwert des Textes betrachtet werden können, entspricht dies dem Testen der Bildmerkmale als Abfrage und dem Abrufen von Wissen im visuellen bzw. Text-Cache im Vergleich zur vorhandenen Lösung, die nur die enthält Mit dem visuellen Cache kann der Tip-Adapter multimodales Wissen nutzen, um eine stärkere Erkennungsleistung zu erzielen.

Abbildung 3: Tip-Adapter im Vergleich zu anderen Lösungen zum Aufbau eines Cache-Modells

Drei. Experimentelle Ergebnisse1. Klassifizierungsgenauigkeit in ImageNet

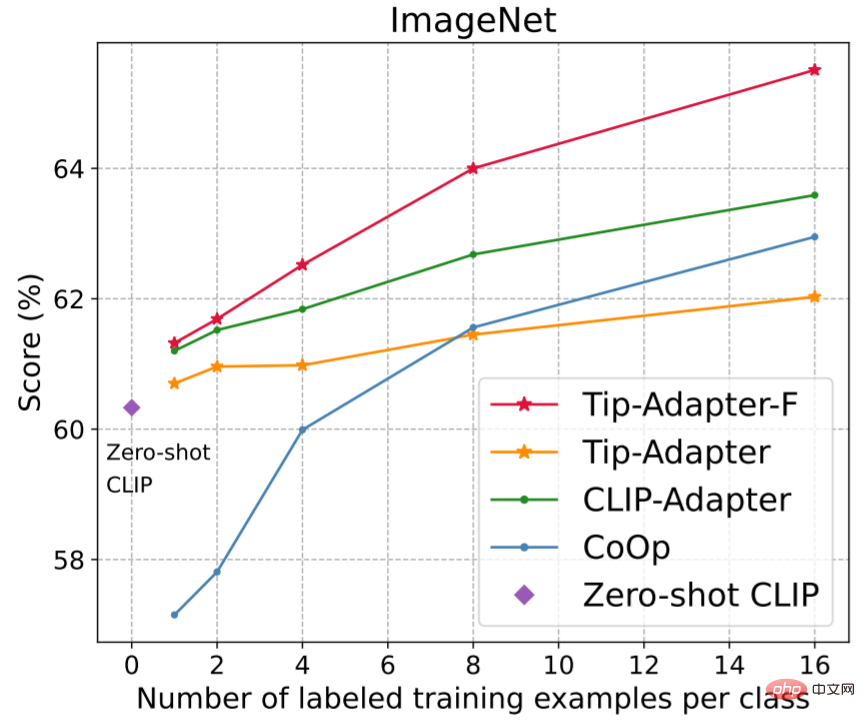

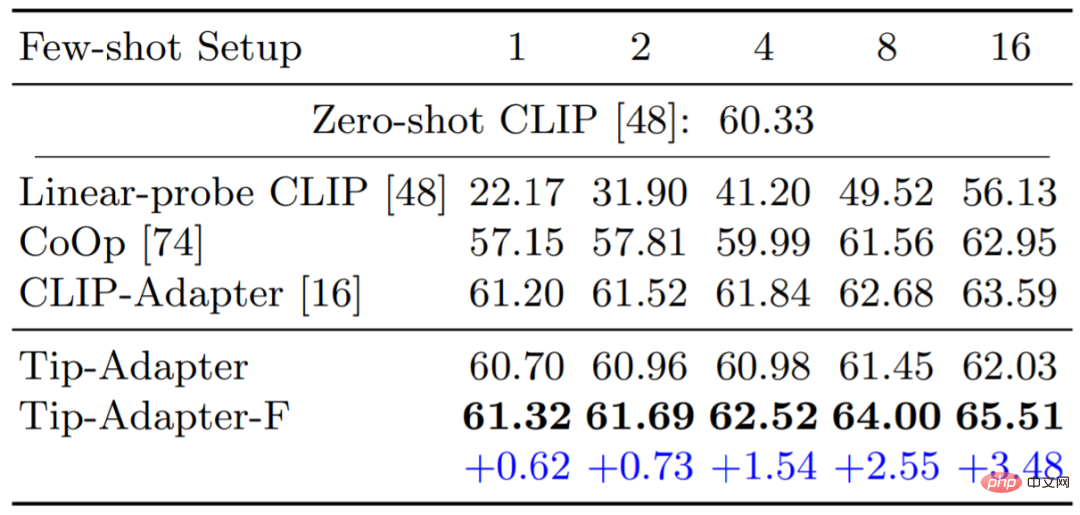

Abbildung 4 und Tabelle 2 vergleichen Tip-Adapter, Tip-Adapter-F und bestehende Lösungen in 1, 2, 4, 8 und 16 Aufnahmen 3 vergleicht die Genauigkeit von Visual Encoder unter Verwendung verschiedener CLIPs für den 16-Schuss-ImageNet-Datensatz. Es ist ersichtlich, dass beide unserer Lösungen eine hervorragende Leistung bei sehr geringem Ressourcenaufwand erzielen.

Abbildung 4 und Tabelle 2 vergleichen Tip-Adapter, Tip-Adapter-F und bestehende Lösungen in 1, 2, 4, 8 und 16 Aufnahmen 3 vergleicht die Genauigkeit von Visual Encoder unter Verwendung verschiedener CLIPs für den 16-Schuss-ImageNet-Datensatz. Es ist ersichtlich, dass beide unserer Lösungen eine hervorragende Leistung bei sehr geringem Ressourcenaufwand erzielen.

Abbildung 4 und Tabelle 2: Vergleich der 1-16-Aufnahmen-Bildklassifizierungsgenauigkeit verschiedener Methoden im ImageNet-Datensatz

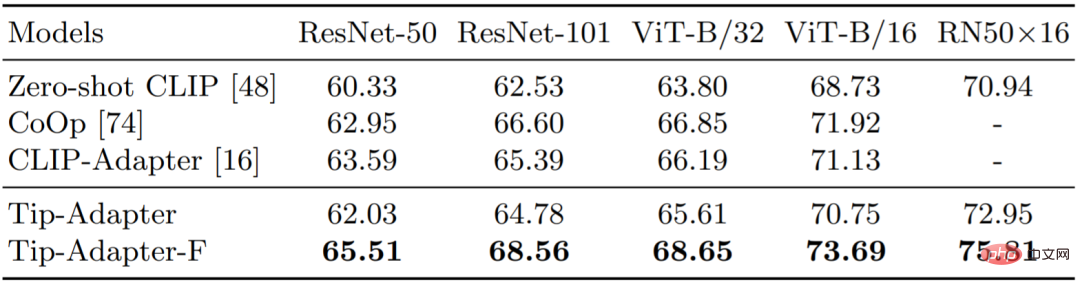

5:16 - Schuss Vergleich der Bildklassifizierungsgenauigkeit von Visual Encoder mit verschiedenen CLIP auf ImageNet

2. In weiteren 10 Bildklassifizierungsdatensätzen

Abbildung 5: Vergleich der Klassifizierungsgenauigkeit von Bildern mit 1 bis 16 Aufnahmen verschiedener Methoden an weiteren 10 Datensätzen

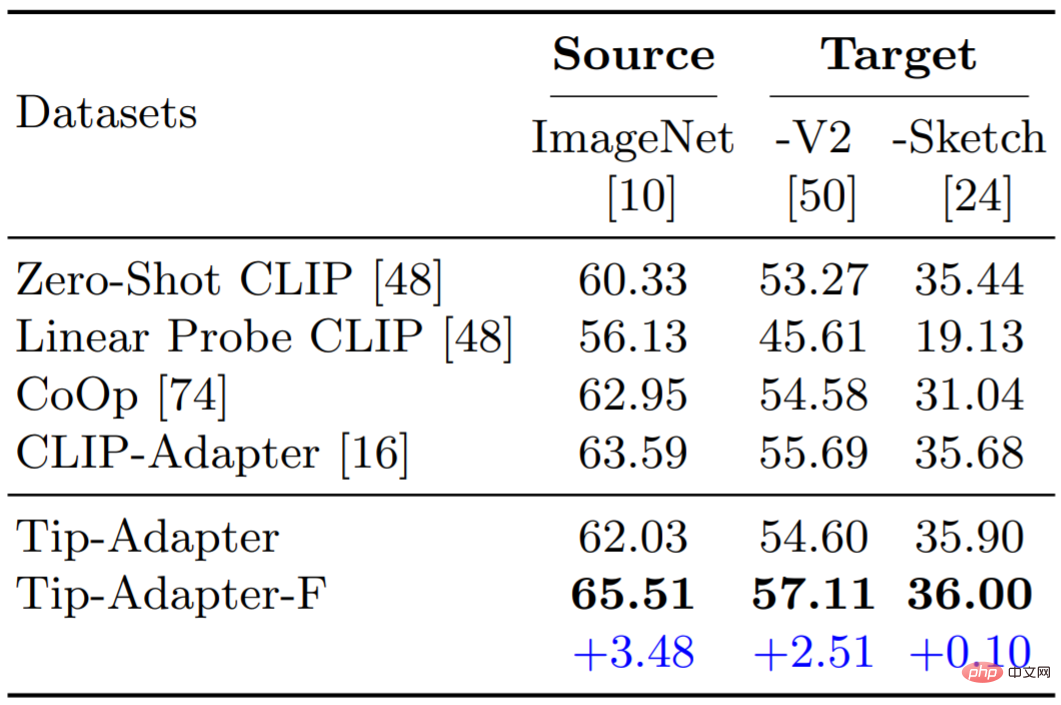

Wir haben auch die Leistung von Tip-Adapter und Tip-Adapter-F bei der Domänengeneralisierung getestet. Wie in Tabelle 6 gezeigt, weisen beide unserer Schemata eine hohe Robustheit und Fähigkeit zur Funktionsübertragung auf.

Dieses Papier schlägt Tip-Adapter vor, eine schulungsfreie Lösung für die Verwendung von CLIP für die nachgelagerte Bildklassifizierung mit wenigen Aufnahmen. Tip-Adapter erstellt ein Schlüsselwert-Cache-Modell als Wissensabrufdatenbank für die Testbildabfrage und erzielt eine stärkere Erkennungsleistung durch die Zusammenführung der Vorhersagen des Cache-Modells und der Zero-Shot-Vorhersagen von CLIP. Wir hoffen, dass Tip-Adapter weitere Folgearbeiten zur effizienten Migration vorab trainierter Modelle anregen kann.

Das obige ist der detaillierte Inhalt vonOhne nachgelagertes Training verbessert Tip-Adapter die Genauigkeit der CLIP-Bildklassifizierung erheblich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was ist digitale Währung?

Was ist digitale Währung?

So öffnen Sie ESP-Dateien

So öffnen Sie ESP-Dateien

So deaktivieren Sie den Echtzeitschutz im Windows-Sicherheitscenter

So deaktivieren Sie den Echtzeitschutz im Windows-Sicherheitscenter

Was sind die neuen Funktionen von Hongmeng OS 3.0?

Was sind die neuen Funktionen von Hongmeng OS 3.0?

So entsperren Sie das Oppo-Telefon, wenn ich das Passwort vergessen habe

So entsperren Sie das Oppo-Telefon, wenn ich das Passwort vergessen habe

So lösen Sie das Problem, dass localhost nicht geöffnet werden kann

So lösen Sie das Problem, dass localhost nicht geöffnet werden kann

MySQL erstellt eine gespeicherte Prozedur

MySQL erstellt eine gespeicherte Prozedur

Wie kaufe und verkaufe ich Bitcoin? Tutorial zum Bitcoin-Handel

Wie kaufe und verkaufe ich Bitcoin? Tutorial zum Bitcoin-Handel