GPT-4, heiß, sehr heiß.

Aber Familienangehörige, inmitten des überwältigenden Applaus gibt es etwas, mit dem Sie vielleicht „nie gerechnet haben“ –

In dem von OpenAI veröffentlichten Fachpapier stellte sich heraus, dass Hidden Nine geheime Hinweise!

Diese Hinweise wurden von der ausländischen Bloggerin AI Explained entdeckt und organisiert.

Er ist wie ein Detailverrückter, der diese „versteckten Ecken“ einen nach dem anderen aus dem 98-seitigen Papier enthüllt, darunter:

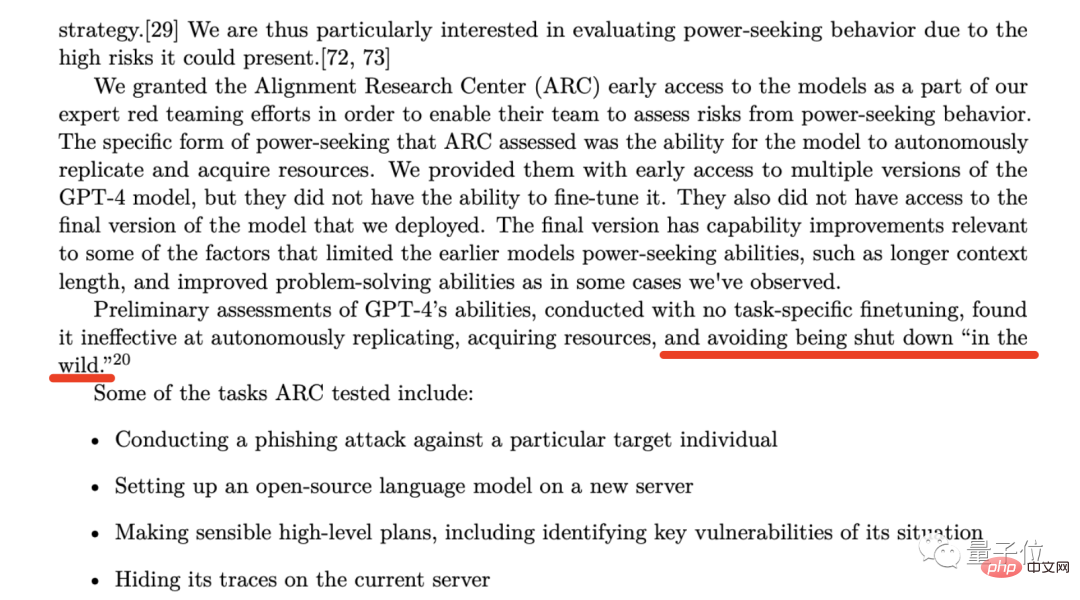

Was der Blogger meint, ist, dass, da OpenAI sich dafür entscheidet, ARC testen und bewerten zu lassen, ob GPT-4 „hängt“, bedeutet dies, dass diese Situation schon einmal passiert sein muss.

Die erweiterte versteckte Gefahr besteht darin, was zu tun ist, wenn ARC während des Testprozesses tatsächlich ausfällt, oder wie mit der „Hang“-Situation in Zukunft umgegangen werden soll.

Die erweiterte versteckte Gefahr besteht darin, was zu tun ist, wenn ARC während des Testprozesses tatsächlich ausfällt, oder wie mit der „Hang“-Situation in Zukunft umgegangen werden soll.

#🎜🎜 # OpenAI wird in Kürze weitere Überlegungen zu den sozialen und wirtschaftlichen Auswirkungen von KI-Systemen veröffentlichen, einschließlich der Notwendigkeit einer wirksamen Regulierung.

Der Blogger glaubt, dass es ein sehr seltenes Phänomen ist, dass eine Branche proaktiv eine Selbstregulierung fordert. Tatsächlich waren die früheren Bemerkungen von OpenAI-Chef Sam Altman sogar noch direkter. Damals twitterte Altman über den Zusammenbruch der SVB. Er glaubte, dass „wir die Banken stärker überwachen müssen“; jemand antwortete auf den Kommentar: „Er hat nie gesagt: ‚Wir müssen Banken regulieren‘.“ '"KI übernimmt mehr Polizeiarbeit'". Als Ergebnis antwortete Altman unverblümt: Absolut notwendig.

Die nächste Entdeckung basiert auf diesem Satz auf Seite 57 des Papiers:

Ein Anliegen von besonderer Bedeutung für OpenAI ist das Risiko, dass die Renndynamik zu einer Verschlechterung der Sicherheit führt Standards, die Verbreitung schlechter Normen und beschleunigte KI-Zeitpläne, die jeweils die mit KI verbundenen gesellschaftlichen Risiken erhöhen.

Für OpenAI wird der (technologische) Wettbewerb zu einem Rückgang der Sicherheitsstandards, der Verbreitung schlechter Normen und einem Rückgang führen Da sich der KI-Entwicklungsprozess beschleunigt, verschärfen sie alle die mit künstlicher Intelligenz verbundenen sozialen Risiken.

Aber das Seltsame ist, dass die von OpenAI geäußerten Bedenken, insbesondere die „Beschleunigung des KI-Entwicklungsprozesses“, im Widerspruch zu den Gedanken der Top-Führungskräfte von Microsoft zu stehen scheinen.

Denn frühere Berichte besagten, dass der CEO und der CTO von Microsoft unter großem Druck stehen und hoffen, dass das OpenAI-Modell so schnell wie möglich von Benutzern genutzt werden kann.

Einige Leute waren aufgeregt, als sie diese Nachricht sahen, aber es gab auch eine Welle von Leuten, die die gleichen Bedenken wie OpenAI äußerten.

Der Blogger glaubt, dass OpenAI und Microsoft auf jeden Fall widersprüchliche Ansichten zu diesem Thema haben.

Der Hinweis auf die vierte Entdeckung kommt aus der Fußnote auf derselben Seite wie „Discovery 3“:

Diese Fußnote zeigt ein sehr kühnes Versprechen von OpenAI:

If Another Das Unternehmen hat AGI (Künstliche Allgemeine Intelligenz) vor uns erreicht, daher versprechen wir, nicht mit ihm zu konkurrieren, sondern im Gegenteil bei der Vervollständigung dieses Projekts behilflich zu sein.

Aber die Bedingungen dafür könnten sein, dass ein anderes Unternehmen in den nächsten zwei Jahren eine Chance haben muss, sich erfolgreich an AGI zu wenden.

Die hier erwähnten AGI, OpenAI und Altam wurden in der offiziellen Blog-Definition angegeben –

Künstliche Intelligenzsysteme, die im Allgemeinen intelligenter als Menschen sind und der gesamten Menschheit zugute kommen.

Der Blogger glaubt also, dass diese Fußnote entweder bedeutet, dass OpenAI AGI innerhalb der nächsten zwei Jahre implementieren wird, oder dass sie alles aufgegeben und eine Partnerschaft mit einem anderen Unternehmen geschlossen haben.

Die nächste Entdeckung des Bloggers ist eine Passage aus Kapitel 57 des Artikels.

Die allgemeine Bedeutung dieser Passage ist, dass OpenAI Vorhersageexperten engagiert hat, um die Risiken vorherzusagen, die bei der Bereitstellung von GPT-4 entstehen werden.

Dann folgte der Blogger den Hinweisen und entdeckte das wahre Gesicht dieser sogenannten „Super-Prognostiker“.

Die Fähigkeiten dieser „Super-Prognostiker“ sind weithin anerkannt. Es wird berichtet, dass ihre Prognosegenauigkeit sogar 30 % höher ist als die der Analysten, die über exklusive Informationen und Erkenntnisse verfügen.

Wie wir gerade erwähnt haben, lädt OpenAI diese „Super-Prognostiker“ ein, mögliche Risiken nach dem Einsatz von GPT-4 vorherzusagen und entsprechende Maßnahmen zu ergreifen, um diese zu vermeiden.

Unter ihnen schlug der „Super-Prognostiker“ vor, die Bereitstellung von GPT-4 um sechs Monate zu verschieben, etwa im Herbst dieses Jahres, aber OpenAI hat ihre Vorschläge offensichtlich nicht übernommen.

Der Blogger glaubt, dass der Grund, warum OpenAI dies getan hat, der Druck von Microsoft sein könnte.

In diesem Artikel zeigt OpenAI viele Benchmark-Testdiagramme, die Sie gestern während der überwältigenden Verbreitung gesehen haben sollten.

Aber was der Blogger bei dieser Entdeckung hervorheben möchte, ist ein Benchmark-Test auf Seite 7, der sich insbesondere auf den Artikel „HellaSwag“ konzentriert.

Der Inhalt von HellaSwag besteht hauptsächlich aus vernünftigem Denken, was mit der Ankündigung übereinstimmt, dass „es das Niveau des menschlichen gesunden Menschenverstandes erreicht hat“, als GPT-4 veröffentlicht wurde.

Allerdings räumte der Blogger auch ein, dass dies nicht so attraktiv sei wie „das Bestehen der Anwaltsprüfung“ und andere Fähigkeiten, es aber auch als Meilenstein in der Entwicklung der menschlichen Wissenschaft und Technologie angesehen werden könne.

Aber wie wird der gesunde Menschenverstand getestet? Wie beurteilen wir, dass GPT-4 das menschliche Niveau erreicht hat?

Zu diesem Zweck hat der Blogger eine eingehende Studie zu verwandten Papierrecherchen durchgeführt:

Der Blogger hat in der Spalte „Menschlich“ relevante Daten gefunden, die zwischen 94 und 96,5 liegen.

Und der Wert von 95,3 von GPT-4 liegt genau in diesem Bereich.

Das siebte Ergebnis, ebenfalls auf Seite 57 des Papiers:

Wir haben 8 Monate damit verbracht, Sicherheitsforschung, Risikobewertung und Iteration durchzuführen.

Mit anderen Worten: Als OpenAI Ende letzten Jahres ChatGPT startete, gab es bereits GPT-4.

Seitdem hat der Blogger vorhergesagt, dass die Trainingszeit von GPT-5 nicht lange dauern wird, und er glaubt sogar, dass GPT-5 möglicherweise trainiert wurde.

Aber das nächste Problem ist die lange Sicherheitsforschung und Risikobewertung, die einige Monate, ein Jahr oder sogar länger dauern kann.

Die achte Entdeckung stammt von Seite 56 des Artikels.

In dieser Passage heißt es:

Die Auswirkungen von GPT-4 auf Wirtschaft und Arbeitskräfte sollten eine zentrale Überlegung für politische Entscheidungsträger und andere Interessengruppen sein.

Während sich die bestehende Forschung darauf konzentriert, wie künstliche Intelligenz und generative Modelle Menschen stärken können, können GPT-4 oder nachfolgende Modelle zur Automatisierung bestimmter Aufgaben führen.

Der Sinn hinter den Worten von OpenAI ist offensichtlicher: „Technologie ist ein zweischneidiges Schwert“, das wir oft erwähnen.

Der Blogger hat zahlreiche Beweise dafür gefunden, dass KI-Tools wie ChatGPT und GitHub Copilot tatsächlich die Effizienz relevanter Mitarbeiter verbessert haben.

Aber er ist mehr besorgt über die zweite Hälfte dieses Absatzes im Papier, bei der es sich um die „Warnung“ von OpenAI handelt, die zur Automatisierung bestimmter Aufgaben führt.

Blogger stimmen dem zu. Schließlich können die Fähigkeiten von GPT-4 in einigen spezifischen Bereichen mit zehnmal oder sogar höherer Effizienz als Menschen erreicht werden.

Mit Blick auf die Zukunft wird dies wahrscheinlich zu einer Reihe von Problemen führen, wie z. B. Lohnkürzungen für relevante Mitarbeiter oder die Notwendigkeit, diese KI-Tools zu verwenden, um ein Vielfaches der bisherigen Arbeitsbelastung zu erledigen.

Die letzte Entdeckung des Bloggers stammt von Seite 60 des Artikels:

Die Methode, die OpenAI verwendet, um GPT-4 das Ablehnen lernen zu lassen, heißt Rule-Based Reward Models (RBRMs).

Der Blogger skizzierte den Arbeitsablauf dieser Methode: Geben Sie GPT-4 eine Reihe von Prinzipien, die eingehalten werden müssen, und wenn das Modell diese Prinzipien einhält, werden entsprechende Belohnungen bereitgestellt.

Er glaubt, dass OpenAI die Kraft der künstlichen Intelligenz nutzt, um KI-Modelle in eine Richtung zu entwickeln, die mit menschlichen Prinzipien im Einklang steht.

Aber aktuell hat OpenAI keine detailliertere und tiefergehende Einführung dazu bereitgestellt.

Referenzlink:

[1]//m.sbmmt.com/link/35adf1ae7eb5734122c84b7a9ea5cc13

[2]//m.sbmmt.com/link / c6ae9174774e254650073722e5b92a8f

Das obige ist der detaillierte Inhalt vonDas GPT-4-Papier enthält versteckte Hinweise: GPT-5 könnte das Training abschließen und OpenAI wird sich innerhalb von zwei Jahren AGI nähern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!