In der heutigen datengesteuerten Forschung im Bereich der künstlichen Intelligenz können die durch einzelne Modaldaten bereitgestellten Informationen die Anforderungen zur Verbesserung der kognitiven Fähigkeiten von Maschinen nicht mehr erfüllen. Ähnlich wie Menschen vielfältige Sinnesinformationen wie Sehen, Hören, Riechen und Tasten nutzen, um die Welt wahrzunehmen, müssen auch Maschinen die menschliche Synästhesie simulieren, um das kognitive Niveau zu verbessern.

Gleichzeitig haben Forscher mit der Explosion multimodaler räumlich-zeitlicher Daten und der Verbesserung der Rechenleistung eine Vielzahl von Methoden vorgeschlagen, um damit umzugehen die wachsenden vielfältigen Bedürfnisse. Derzeitiges multimodales kognitives Computing beschränkt sich jedoch immer noch auf die Nachahmung menschlicher scheinbarer Fähigkeiten und verfügt über keine theoretische Grundlage auf kognitiver Ebene. Angesichts komplexerer intelligenter Aufgaben ist die Schnittstelle zwischen Kognitionswissenschaft und Informatik unumgänglich geworden.

Kürzlich veröffentlichte Professor Li Xuelong von der Northwestern Polytechnical University den Artikel „Multimodal Cognitive Computing“ in der Zeitschrift „Chinese Science: Information Science“ mit dem Thema „Vertrauen“. und Vertrauen“ „(Informationskapazität) als Grundlage, etablierte ein Informationsübertragungsmodell des kognitiven Prozesses und vertrat die Ansicht, dass „Multimodales kognitives Computing die Fähigkeit der Maschine zur Informationsextraktion verbessern kann“ theoretisch Verschiedene Aufgaben des multimodalen Cognitive Computing werden vereinheitlicht.

Li Xuelong glaubt, dass Multimodales kognitives Computing einer der Schlüssel zur Verwirklichung allgemeiner künstlicher Intelligenz ist Das Fachgebiet bietet breite Anwendungsaussichten. Dieser Artikel untersucht das einheitliche kognitive Modell von Menschen und Maschinen und liefert Inspiration zur Förderung der Forschung zum multimodalen kognitiven Computing.

Zitierformat: Xuelong Li, „Multi-Modal Cognitive Computing“, SCIENTIA SINICA Informationis, DOI: 10.1360/SSI-2022-0226

Li Xuelong ist Professor an der Northwestern Polytechnical University und konzentriert sich auf die intelligente Erfassung, Verarbeitung und Verwaltung hoher -dimensionale Datenbeziehung, die in Anwendungssystemen wie „Vicinagearth Security“ eine Rolle spielt. Er wurde 2011 zum IEEE Fellow gewählt und war der erste Festlandwissenschaftler, der in das Exekutivkomitee der International Association for Artificial Intelligence (AAAI) gewählt wurde.

AI Technology Review fasste die Kernpunkte des Artikels „Multimodal Cognitive Computing“ zusammen und führte ein ausführliches Gespräch mit Professor Li Xuelong in diese Richtung.

Basierend auf der Informationstheorie schlug Li Xuelong vor: multi -Modalität Kognitives Computing kann die Informationsextraktionsfähigkeiten von Maschinen verbessern, und diese Idee wurde theoretisch modelliert (unten).

Zunächst müssen wir verstehen, wie Menschen Ereignisinformationen extrahieren.

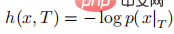

Im Jahr 1948 schlug Shannon, der Begründer der Informationstheorie, das Konzept der „Informationsentropie“ vor, um den Grad der Unsicherheit von Zufallsvariablen darzustellen Je mehr Informationen ein Ereignis liefert, desto größer ist die Informationsmenge. Das heißt, in einer gegebenen kognitiven Aufgabe T ist die Informationsmenge, die durch das Eintreten des Ereignisses x gebracht wird, umgekehrt proportional zur Wahrscheinlichkeit des Ereignisses p(x):

# 🎜 🎜#

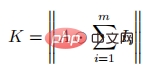

Und Informationen werden unter Verwendung verschiedener Modalitäten als Träger übertragen. Nehmen Sie an, dass der Ereignisraum X die Wahrnehmungsmodalität (m), der Raum (s) und die Zeit (t) ist. Tensor, dann kann die Menge an Informationen, die ein Individuum aus dem Ereignisraum erhält, wie folgt definiert werden: Die Aufmerksamkeit innerhalb des räumlich-zeitlichen Bereichs ist begrenzt (wird mit 1 angenommen), sodass Menschen dies nicht ständig tun müssen, wenn sich räumlich-zeitliche Ereignisse von einer Einzelmodalität zu einer Multimodalität ändern Passen Sie ihre Aufmerksamkeit an und konzentrieren Sie sich auf unbekannte Ereignisinformationen, um die maximale Menge an Informationen zu erhalten:

Das kann man sehen Je mehr Modalitäten ein Raum-Zeit-Ereignis enthält, desto wahrscheinlicher ist es, dass ein Individuum es erhält. Je größer die Informationsmenge, desto höher das kognitive Niveau.

Kommt eine Maschine also umso näher an die kognitive Ebene des Menschen, je größer die Menge an Informationen ist, die sie erhält?

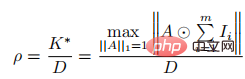

Die Antwort ist nicht so. Um die kognitiven Fähigkeiten der Maschine zu messen, drückte Li Xuelong den Prozess der Informationsextraktion der Maschine aus dem Ereignisraum wie folgt aus, basierend auf der „Konfidenz“-Theorie. Unter diesen ist D die Datenmenge des Ereignisraums x.

Die kognitive Fähigkeit einer Maschine kann also als die Fähigkeit definiert werden, aus einer Dateneinheit die maximale Informationsmenge zu gewinnen. Auf diese Weise wird das kognitive Lernen von Menschen und Maschinen zu einem Prozess vereint zur Verbesserung der Informationsnutzung.

Wie kann man also die Nutzung multimodaler Daten durch die Maschine verbessern und dadurch die Fähigkeiten des multimodalen kognitiven Rechnens verbessern?So wie die Verbesserung der menschlichen Kognition untrennbar mit Assoziation, Argumentation, Induktion und Schlussfolgerung der realen Welt verbunden ist, müssen Sie, wenn Sie die maschinelle Kognition verbessern möchten, auch von den entsprechenden drei Aspekten ausgehen:

Assoziation, Generation, Zusammenarbeit, Dies sind auch die drei Grundaufgaben der heutigen multimodalen Analyse. 2 Maximierung der Informationsmenge mit möglichst wenigen Daten.

Multimodale Korrelation

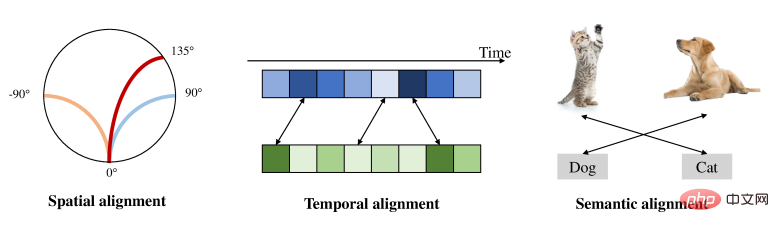

Wie können Inhalte unterschiedlicher Modalitäten auf räumlicher, zeitlicher und semantischer Ebene korreliert werden? Dies ist das Ziel multimodaler Assoziationsaufgaben und die Voraussetzung für eine verbesserte Informationsnutzung.Die Ausrichtung multimodaler Informationen auf räumlicher, zeitlicher und semantischer Ebene ist die Grundlage der multimodalen Wahrnehmung, die beispielsweise auf multimediale Suchtechnologien zurückgreift können wir Vokabeln eingeben, um Videoclips abzurufen.

Bildunterschrift: Diagramm der multimodalen Ausrichtung Inspiriert durch den Mechanismus der intersensorischen Wahrnehmung des Menschen haben KI-Forscher berechenbare Modelle für das Lippenlesen und fehlende Modalitäten im Cross-Modal verwendet Wahrnehmungsaufgaben wie Generierung,

Inspiriert durch den Mechanismus der intersensorischen Wahrnehmung des Menschen haben KI-Forscher berechenbare Modelle für das Lippenlesen und fehlende Modalitäten im Cross-Modal verwendet Wahrnehmungsaufgaben wie Generierung,

unterstützen auch weiterhin die modalübergreifende Wahrnehmung von Behindertengruppen. Zukünftig werden die Hauptanwendungsszenarien der modalübergreifenden Wahrnehmung nicht mehr auf Wahrnehmungsersatzanwendungen für Menschen mit Behinderungen beschränkt sein, sondern stärker in die intersensorische Wahrnehmung des Menschen integriert werden, um das Niveau der multisensorischen Wahrnehmung des Menschen zu verbessern.

Heutzutage nehmen digitale modale Inhalte rasant zu und auch die Anwendungsanforderungen für die modalübergreifende Abfrage werden immer umfangreicher. Dies bietet zweifellos neue Möglichkeiten und Herausforderungen für das multimodale Assoziationslernen.

Intermodale Generierung

Wenn wir die Handlung eines Romans lesen, erscheint das entsprechende Bild ganz natürlich in unserem Kopf. Dies ist ein Spiegelbild der intermodalen Denk- und Generierungsfähigkeiten des Menschen.

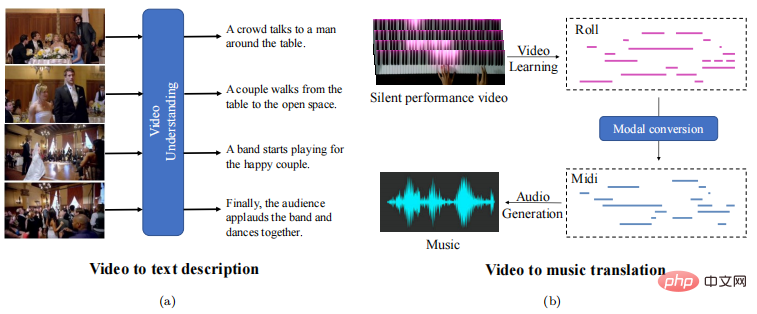

Ähnlich besteht beim multimodalen kognitiven Computing das Ziel der modalübergreifenden Generierungsaufgabe darin, der Maschine die Fähigkeit zu geben, unbekannte modale Entitäten zu generieren. Aus Sicht der Informationstheorie besteht der Kern dieser Aufgabe darin, die kognitiven Fähigkeiten der Maschine innerhalb multimodaler Informationskanäle zu verbessern. Es gibt zwei Möglichkeiten: Die eine besteht darin, die Informationsmenge zu erhöhen, dh die modalübergreifende Synthese, und die andere besteht darin, die Datenmenge zu reduzieren, d. h. eine modalübergreifende Konvertierung.

Die Aufgabe der modalübergreifenden Synthese besteht darin, bei der Generierung neuer modaler Entitäten vorhandene Informationen anzureichern und dadurch die Informationsmenge zu erhöhen. Nehmen wir als Beispiel die Bildgenerierung basierend auf Text: In den frühen Tagen wurde hauptsächlich die Entitätsassoziation verwendet, die oft stark auf Abrufbibliotheken beruhte. Heutzutage basiert die Bilderzeugungstechnologie hauptsächlich auf generativen kontradiktorischen Netzwerken, die realistische und qualitativ hochwertige Bilder erzeugen können. Allerdings ist die Generierung von Gesichtsbildern immer noch eine große Herausforderung, da auf der Informationsebene selbst kleine Veränderungen des Gesichtsausdrucks eine sehr große Menge an Informationen vermitteln können.

Gleichzeitig kann die Umwandlung komplexer Modalitäten in einfache Modalitäten und die Suche nach prägnanteren Ausdrücken die Datenmenge reduzieren und die Informationserfassungsfähigkeiten verbessern.

Bildunterschrift: Häufige modalübergreifende Konvertierungsaufgaben

Als Modell für die Kombination von Computer Vision und Technologien zur Verarbeitung natürlicher Sprache kann die modalübergreifende Konvertierung die Effizienz des Online-Abrufs erheblich verbessern. Geben Sie beispielsweise eine kurze Beschreibung in natürlicher Sprache für ein längeres Video oder generieren Sie Audiosignale, die sich auf eine Videoinformation beziehen.

Die beiden aktuellen gängigen generativen Modelle, VAE (Variational Autoencoder) und GAN (Generative Adversarial Network), haben jeweils ihre eigenen Stärken und Schwächen müssen sinnvoll kombiniert werden. Ein besonders wichtiger Punkt besteht darin, dass die Herausforderung multimodaler Generierungsaufgaben nicht nur in der Qualität der Generierung liegt, sondern auch in den Semantik- und Darstellungslücken zwischen verschiedenen Modalitäten. Es muss gelöst werden in der Zukunft.

Multimodale Zusammenarbeit

Im menschlichen kognitiven Mechanismus spielen Induktion und Deduktion eine wichtige Rolle. Wir können verstehen, was wir sehen, hören, riechen, berühren usw. Verwenden Sie modernste Wahrnehmung Induktion, Fusion und gemeinsame Deduktion als Grundlage für die Entscheidungsfindung durchzuführen.

In ähnlicher Weise erfordert multimodales kognitives Computing auch die Koordination von zwei oder mehr modalen Daten, die Zusammenarbeit, um komplexere multimodale Aufgaben zu erledigen, und die Verbesserung der Genauigkeit und Generalisierungsfähigkeiten. Aus Sicht der Informationstheorie besteht ihr Kern in der gegenseitigen Verschmelzung multimodaler Informationen, um den Zweck der Informationsergänzung zu erreichen, und in der Optimierung der Aufmerksamkeit.

Zuallererst besteht die Modalfusion darin, die Probleme multimodaler Datenunterschiede zu lösen, die durch Datenformat, räumlich-zeitliche Ausrichtung, Rauschinterferenz usw. verursacht werden. Derzeit umfassen die Fusionsmethoden der Zufallsregeln serielle Fusion, parallele Fusion und gewichtete Fusion, und die lernbasierten Fusionsmethoden umfassen Aufmerksamkeitsmechanismusmodell, Transferlernen und Wissensdestillation.

Zweitens ist nach Abschluss der Fusion multimodaler Informationen ein gemeinsames Lernen modaler Informationen erforderlich, um dem Modell dabei zu helfen, die Beziehung zwischen modalen Daten zu ermitteln und Hilfs- oder Komplementärverbindungen zwischen Modi herzustellen.

Durch gemeinsames Lernen kann es einerseits die modale Leistung verbessern, wie z. B. visuelle Audioführung, Audioführungsvision, Tiefenführungsvision und andere Anwendungen, andererseits können Aufgaben gelöst werden, die bisher schwierig waren in der Vergangenheit in einzelnen Modalitäten erreicht werden, wie z. B. komplexe Emotionen Computing, Audio-Matching-Gesichtsmodellierung, audiovisuell geführte Musikgenerierung usw. sind allesamt Entwicklungsrichtungen des multimodalen kognitiven Computings in der Zukunft.

In den letzten Jahren hat die Deep-Learning-Technologie die theoretische und technische Entwicklung des multimodalen kognitiven Computings stark vorangetrieben. Heutzutage werden die Anwendungsanforderungen jedoch immer vielfältiger und die Geschwindigkeit der Dateniteration beschleunigt sich, was neue Herausforderungen und viele Möglichkeiten für das multimodale kognitive Computing mit sich bringt.

Wir können vier Ebenen der Verbesserung der kognitiven Fähigkeiten von Maschinen betrachten:

Auf der Datenebene trennt die traditionelle multimodale Forschung die Datenerfassung und -berechnung in zwei unabhängige Prozesse. Auf diese Weise bestehen Nachteile. Die menschliche Welt besteht aus kontinuierlichen analogen Signalen, während Maschinen diskrete digitale Signale verarbeiten. Der Umwandlungsprozess führt zwangsläufig zu Informationsverzerrungen und -verlusten.

In dieser Hinsicht glaubt Li erheblich verbessert werden.

Auf der Informationsebene liegt der Schlüssel zum kognitiven Computing in derVerarbeitung von Semantiken auf hoher Ebene in Informationen, wie Positionsbeziehungen beim Sehen, dem Stil von Bildern, der Emotion von Musik usw. Derzeit beschränken sich multimodale Aufgaben auf einfache Ziele und Interaktionen in Szenarien und können keine tiefe logische Semantik oder subjektive Semantik verstehen. Beispielsweise kann eine Maschine das Bild einer blühenden Blume auf einer Wiese erzeugen, aber sie kann den gesunden Menschenverstand nicht verstehen, dass Blumen im Winter verwelken.

Der Bau einer Kommunikationsbrücke zwischen komplexer Logik und sensorischen semantischen Informationen in verschiedenen Modalitäten und die Einrichtung eines einzigartigen maschinellen Messsystems ist also ein wichtiger Trend im multimodalen kognitiven Computing der Zukunft.Auf der Ebene des Fusionsmechanismus stellt die Durchführung einer qualitativ hochwertigen Optimierung multimodaler Modelle, die aus heterogenen Komponenten bestehen, derzeit eine Schwierigkeit dar. Die meisten aktuellen multimodalen kognitiven Berechnungen optimieren das Modell unter einem einheitlichen Lernziel. Bei dieser Optimierungsstrategie fehlen gezielte Anpassungen an den heterogenen Komponenten innerhalb des Modells, was zu großen Problemen bei der Unteroptimierung führt kann aus mehreren Aspekten wie multimodalem maschinellem Lernen und optimierungstheoretischen Methoden angegangen werden.

Auf der Aufgabenebene variiert die kognitive Lernmethode der Maschine je nach Aufgabe. Wir müssen eine Lernstrategie für das Aufgabenfeedback entwerfen, um die Fähigkeit zur Lösung verschiedener verwandter Aufgaben zu verbessern.

Darüber hinaus können wir angesichts der Unzulänglichkeiten der aktuellen „Zuschauerstil“-Lernmethode des maschinellen Lernens, die Welt aus Bildern, Texten und anderen Daten zu verstehen, aus den Forschungsergebnissen der Kognitionswissenschaft lernen, wie z

Verkörperte KI Es ist eine mögliche Lösung: Intelligente Agenten müssen multimodal mit der Umgebung interagieren, um sich kontinuierlich weiterzuentwickeln und die Fähigkeit zur Lösung komplexer Aufgaben zu entwickeln.

4Li Xuelong:Vielen Dank für Ihre Frage. Der Grund, warum wir multimodalen Daten Aufmerksamkeit schenken und sie untersuchen, liegt darin, dass künstliche Intelligenz im Wesentlichen datenabhängig ist. Die Informationen, die monomodale Daten liefern können, sind immer sehr begrenzt, während multimodale Daten mehrere hierarchische, multiperspektivische Informationen liefern können Da die objektive physische Welt andererseits multimodal ist, kann die Erforschung vieler praktischer Probleme nicht von multimodalen Daten getrennt werden, z. B. die Suche nach Bildern anhand von Text, die Identifizierung von Objekten durch das Hören von Musik usw.

Wir analysieren multimodale Probleme aus der Perspektive des kognitiven Rechnens, ausgehend von der Essenz der künstlichen Intelligenz. Durch den Aufbau eines multimodalen Analysesystems, das menschliche kognitive Muster simulieren kann, hoffen wir, dass Maschinen ihre Umgebung intelligent wahrnehmen können. Komplexe und verschachtelte multimodale Informationen bringen auch viel Rauschen und Redundanz mit sich, was den Lerndruck des Modells erhöht und in einigen Fällen die Leistung multimodaler Daten schlechter macht als die einer einzelnen Modalität, was zu Problemen führt ein Problem für den Modellentwurf und die Optimierung stellt größere Herausforderungen dar.

AI Technology Review: Welche Ähnlichkeiten bestehen aus informationstheoretischer Sicht zwischen menschlichem kognitivem Lernen und maschinellem kognitivem Lernen? Welche leitende Bedeutung hat die Erforschung menschlicher kognitiver Mechanismen für das multimodale kognitive Computing? Mit welchen Schwierigkeiten wird das multimodale kognitive Computing konfrontiert sein, ohne die menschliche Kognition zu verstehen?

Li

Menschen erhalten von Geburt an eine große Menge externer Informationen und bauen nach und nach ein Selbsterkennungssystem durch Wahrnehmung, Gedächtnis, Argumentation usw. auf, während die Lernfähigkeit von Maschinen durch das Training großer Datenmengen erreicht wird. hauptsächlich um Wahrnehmung und menschliches Wissen zu finden. Nach Platons Standpunkt ist das, was Maschinen lernen, noch kein Wissen. Wir haben in dem Artikel die Theorie der „Informationskapazität“ zitiert und versucht, ausgehend von der Fähigkeit, Informationen zu extrahieren, eine kognitive Verbindung zwischen Menschen und Maschinen herzustellen.Menschen übermitteln multimodale Informationen über mehrere Sinneskanäle wie Sehen, Hören, Riechen, Schmecken, Berühren usw. an das Gehirn, was zu einer gemeinsamen Stimulation der Großhirnrinde führt. Die psychologische Forschung hat herausgefunden, dass die kombinierte Wirkung mehrerer Sinne kognitive Lernmodelle wie „multisensorische Integration“, „Synästhesie“, „Wahrnehmungsreorganisation“ und „Wahrnehmungsgedächtnis“ hervorbringen kann Inspiration, wie die Ableitung typischer multimodaler Analyseaufgaben wie multimodale Zusammenarbeit, multimodale Assoziation und modalübergreifende Generierung. Es hat auch zu lokalem Teilen, Lang- und Kurzzeitgedächtnis und Aufmerksamkeitsmechanismen geführt . und andere typische maschinelle Analysemechanismen. Derzeit ist der menschliche kognitive Mechanismus tatsächlich nicht klar. Ohne die Anleitung menschlicher kognitiver Forschung tappt das multimodale kognitive Computing in die Falle der Datenanpassung Wir können auch nicht beurteilen, ob das Modell das Wissen gelernt hat, das Menschen benötigen Derzeit leidet ein umstrittener Punkt. KI-Technologie Kommentar: Aus der Perspektive der Informationstheorie haben Sie vorgeschlagen, dass „multimodales kognitives Computing die Informationsextraktionsfähigkeiten der Maschine verbessern kann“ Welche Beweise gibt es, um diesen Standpunkt bei bestimmten multimodalen Cognitive-Computing-Aufgaben zu stützen? Li Xuelong: Diese Frage kann aus zwei Aspekten beantwortet werden. Erstens können multimodale Informationen die Leistung einer einzelnen Modalität bei verschiedenen Aufgaben verbessern. Eine umfangreiche Arbeit hat bestätigt, dass durch das Hinzufügen von Toninformationen die Leistung von Computer-Vision-Algorithmen, wie z. B. Zielerkennung, Szenenverständnis usw., erheblich verbessert wird. Wir haben auch eine Umweltkamera gebaut und herausgefunden, dass durch die Fusion multimodaler Informationen von Sensoren wie Temperatur und Luftfeuchtigkeit die Bildqualität der Kamera verbessert werden kann. Zweitens bietet die gemeinsame Modellierung multimodaler Informationen die Möglichkeit, komplexere intelligente Aufgaben zu erfüllen. Beispielsweise haben wir die Arbeit „Listen to the Image“ durchgeführt Durch die Kodierung visueller Informationen in Ton können blinde Menschen die Szene vor sich „sehen“. Dies beweist auch, dass multimodales kognitives Computing Maschinen dabei hilft, mehr Informationen zu extrahieren. AI Technology Review: Wie ist die Wechselwirkung zwischen Ausrichtung, Wahrnehmung und Abruf bei multimodalen Assoziationsaufgaben?#🎜🎜 # Li Xuelong: Die Beziehung zwischen diesen drei ist relativ komplizierter Natur. In diesem Artikel gebe ich nur an einige vorläufige Meinungen von mir. Die Voraussetzung für die Korrelation unterschiedlicher Modalitäten ist, dass sie gemeinsam die gleiche/ähnliche objektive Existenz beschreiben. Diese Korrelation ist jedoch schwierig zu bestimmen, wenn externe Informationen kompliziert sind oder miteinander in Konflikt geraten dazugehörige Korrespondenz. Dann wird auf der Grundlage der Ausrichtung die Wahrnehmung von einer Modalität zu einer anderen Modalität erreicht. Wenn wir nur die Lippenbewegungen einer Person sehen, scheinen wir zu hören, was sie sagt. Auch dieses Phänomen beruht auf der Korrelation und Ausrichtung visueller Elemente (Viseme) und Phoneme (Phoneme). Im wirklichen Leben haben wir diese modalübergreifende Wahrnehmung weiter auf Anwendungen wie das Abrufen, das Abrufen von Bildern oder Videoinhalten von Produkten durch Text und die Realisierung berechenbarer multimodaler Korrelationsanwendungen angewendet. AI Technology Review: Das kürzlich sehr beliebte DALL-E und andere Modelle sind ein Beispiel für modalübergreifende Generierungsaufgaben Wird im Text verwendet. Es eignet sich gut für die Generierung von Bildaufgaben, es gibt jedoch immer noch große Einschränkungen hinsichtlich der semantischen Relevanz und Interpretierbarkeit der generierten Bilder. Wie sollte dieses Problem Ihrer Meinung nach gelöst werden? Was ist die Schwierigkeit? 李学龙: Das Generieren von Bildern aus Text ist eine „imaginäre“ Aufgabe, die Menschen sehen oder hören Satz, verstehen Sie die darin enthaltenen semantischen Informationen und verlassen Sie sich dann auf das Gehirngedächtnis, um sich die am besten geeignete Szene vorzustellen, um einen „Bildsinn“ zu erzeugen. Derzeit befindet sich DALL-E noch in der Phase, in der statistisches Lernen für die Datenanpassung verwendet wird, um große Datensätze zusammenzufassen und zusammenzufassen, was Deep Learning derzeit am besten kann. Wenn Sie jedoch wirklich die „Phantasie“ der Menschen lernen möchten, müssen Sie auch das menschliche kognitive Modell berücksichtigen, um ein „hohes Maß“ an Intelligenz zu erreichen. Dies erfordert die übergreifende Integration von Neurowissenschaften, Psychologie und Informationswissenschaft ist sowohl eine Herausforderung als auch eine Chance. In den letzten Jahren haben auch viele Teams Spitzenarbeit geleistet. Durch die übergreifende Integration mehrerer Disziplinen ist die Erforschung der Berechenbarkeitstheorie menschlicher kognitiver Modelle auch eine der Arbeitsrichtungen unseres Teams. Wir glauben, dass dies auch zu neuen Durchbrüchen bei der Intelligenz auf „hohem Niveau“ führen wird. AI Technology Review: Wie lassen Sie sich in Ihrer Forschungsarbeit von der Kognitionswissenschaft inspirieren? Welche kognitionswissenschaftliche Forschung interessiert Sie besonders? Li Xuelong: Fragen Sie ihn, wie klar er ist? Kommen Sie, um lebendiges Wasser aus einer Quelle zu holen. Ich beobachte und denke oft über einige interessante Phänomene aus meinem täglichen Leben nach. Als ich vor zwanzig Jahren auf der Webseite auf die Musik klickte, hatte ich das Gefühl, dort zu sein Mit der Zeit begann ich, aus kognitiver Sicht über die Beziehung zwischen Hören und Sehen nachzudenken. Während meines Studiums der Kognitionswissenschaft lernte ich das Phänomen der „Synästhesie“ kennen. In Kombination mit meiner eigenen wissenschaftlichen Forschungsrichtung verfasste ich einen Artikel mit dem Titel „Visuelle Musik und musikalisches Sehen“, der auch der erste war. „Synästhesie“ wurde in den Informationsbereich eingeführt. Später eröffnete ich den ersten Cognitive-Computing-Kurs im Informationsbereich und gründete auch das Cognitive Computing Technical Committee des IEEE SMC, um zu versuchen, die Grenzen zwischen Kognitionswissenschaft und Wissenschaft zu durchbrechen Die Grenzen der Wissenschaft definierten damals auch das kognitive Rechnen, so die aktuelle Beschreibung auf der Homepage des Fachausschusses. Im Jahr 2002 habe ich die Fähigkeit vorgeschlagen, Informationen pro Datenmenge bereitzustellen, was das Konzept der „Informationskapazität“ ist, und habe versucht, die kognitiven Fähigkeiten von Maschinen zu messen. Es ist mir eine Ehre, es im Jahr 2020 mit dem Titel „Multi“ vorzustellen -modal“ „Cognitive Computing“ gewann den Tencent Scientific Exploration Award. Bis jetzt habe ich weiterhin auf die neuesten Entwicklungen in der Synästhesie und Wahrnehmung geachtet. In der Natur gibt es viele Modi, die über die fünf menschlichen Sinne hinausgehen, und es gibt sogar potenzielle Modi, die noch nicht klar sind. Beispielsweise kann die Quantenverschränkung zeigen, dass der dreidimensionale Raum, in dem wir leben, nur eine Projektion eines hochdimensionalen Raums ist Wenn dies tatsächlich der Fall ist, sind auch unsere Erkennungsmethoden begrenzt. Vielleicht können diese potenziellen Modi genutzt werden, um es Maschinen zu ermöglichen, sich der menschlichen Wahrnehmung zu nähern oder sie sogar zu übertreffen. KI-Technologie Kommentar: Zur Frage, wie menschliche Kognition besser mit künstlicher Intelligenz kombiniert werden kann, haben Sie vorgeschlagen, eine „Meta- „Modal“ (Meta-Modal) ist das zentrale modale Interaktionsnetzwerk. Können Sie diesen Standpunkt vorstellen? Was ist seine theoretische Grundlage? Li Xuelong: Metamodalität selbst ist ein Konzept, das aus dem Bereich der kognitiven Neurowissenschaften stammt Das Gehirn verfügt über eine solche Organisation, dass es bei der Ausführung einer bestimmten Funktion oder Darstellungsoperation keine spezifischen Annahmen über die sensorische Kategorie der Eingabeinformationen trifft, aber dennoch eine gute Ausführungsleistung erzielen kann. Metamodalität ist im Wesentlichen die Integration von Phänomenen und Mechanismen durch Kognitionswissenschaftler wie modalübergreifende Wahrnehmung und neuronale Plastizität . Es inspiriert uns auch dazu, effiziente Lernarchitekturen und -methoden zwischen verschiedenen Modalitäten zu entwickeln, um allgemeinere modale Darstellungsmöglichkeiten zu erreichen. AI Technology Review: Was sind die Hauptanwendungen des multimodalen kognitiven Computings in der realen Welt? Nennen Sie Beispiele. Li Xuelong: Multimodales kognitives Computing ist eine Forschung, die sehr nah an praktischen Anwendungen ist. Unser Team hat bereits an der modalübergreifenden Wahrnehmung gearbeitet, die visuelle Informationen in Tonsignale umwandelt und den primären visuellen Kortex der Großhirnrinde stimuliert. Sie wurde bei der Unterstützung behinderter Menschen eingesetzt, um blinden Menschen dabei zu helfen, die Außenwelt zu sehen. Im täglichen Leben nutzen wir häufig multimodale kognitive Computertechnologie. Beispielsweise kombinieren Kurzvideoplattformen Sprach-, Bild- und Text-Tags, um Videos zu empfehlen, die für Benutzer von Interesse sein könnten. Im weiteren Sinne hat multimodales kognitives Computing auch eine breite Palette von Anwendungen in der lokalen Sicherheit, die im Artikel erwähnt werden, wie zum Beispiel intelligente Such- und Rettungsdienste, Drohnen und Bodenroboter Verschiedene Daten wie Ton, Bilder, Temperatur und Luftfeuchtigkeit müssen gesammelt und aus kognitiver Sicht analysiert werden, und je nach Situation vor Ort können unterschiedliche Such- und Rettungsstrategien umgesetzt werden. Es gibt viele ähnliche Anwendungen, wie z. B. intelligente Inspektion, domänenübergreifende Fernerkundung usw. KI-Technologie Kommentar: Sie haben im Artikel einmal erwähnt, dass aktuelle multimodale Aufgaben auf einfache Ziele und Interaktionen in Szenarien beschränkt sind Da es sich um eine tiefere logische Semantik oder eine subjektive Semantik handelt, wird es schwierig sein. Ist dies also eine Chance für die Renaissance der symbolischen künstlichen Intelligenz? Welche anderen praktikablen Lösungen stehen zur Verfügung, um die Fähigkeit von Maschinen zu verbessern, semantische Informationen auf hoher Ebene zu verarbeiten? Li Xuelong:Russell glaubt, dass der größte Wert des Wissens in seiner Unsicherheit liegt. Das Erlernen von Wissen erfordert Wärme und die Fähigkeit, mit der Außenwelt zu interagieren und Feedback zu geben. Die meiste Forschung, die wir derzeit sehen, ist monomodal, passiv und orientiert sich an gegebenen Daten, was den Forschungsbedarf einiger einfacher Ziele und Szenarien erfüllen kann. Für eine tiefere logische Semantik oder subjektive Semantik ist es jedoch notwendig, Situationen vollständig zu erforschen und auszugraben, die in Raum und Zeit mehrdimensional sind, durch mehr Modalitäten unterstützt werden und zu aktiver Interaktion fähig sind. Um dieses Ziel zu erreichen, könnten Forschungsmethoden und -methoden stärker auf die Kognitionswissenschaft zurückgreifen. Beispielsweise haben einige Forscher die „verkörperte Erfahrung“-Hypothese in der Kognitionswissenschaft in den Bereich der künstlichen Intelligenz eingeführt, um zu erforschen, wie Maschinen neues Lernen ermöglichen Im Kontext aktiver Interaktion mit der Außenwelt und multimodaler Informationseingabe wurden Probleme und Aufgaben entwickelt und teilweise erfreuliche Ergebnisse erzielt. Dies zeigt auch die Rolle und positive Bedeutung des multimodalen Cognitive Computing bei der Verbindung von künstlicher Intelligenz und Kognitionswissenschaft. KI-Technologie Kommentar: Intelligente Optoelektronik ist auch eine Ihrer Forschungsrichtungen. Sie haben in Ihrem Artikel erwähnt, dass intelligente Optoelektronik explorative Lösungen für die Digitalisierung von Informationen bringen kann. Was kann intelligente Optoelektronik im Hinblick auf die Erfassung und Berechnung multimodaler Daten leisten? Li Xuelong: Lichtsignale und elektrische Signale sind die wichtigsten Möglichkeiten für Menschen, die Welt zu verstehen. Darüber hinaus stammen visuelle Informationen hauptsächlich aus Licht . Die fünf menschlichen Sinne Sehen, Hören, Riechen, Schmecken und Berühren wandeln außerdem verschiedene Empfindungen wie Licht, Schallwellen, Druck, Geruch und Stimulation in elektrische Signale für eine anspruchsvollere Wahrnehmung um. Daher ist Photoelektrizität die wichtigste Informationsquelle für den Menschen, um die Welt wahrzunehmen. In den letzten Jahren haben wir mit Hilfe verschiedener fortschrittlicher optoelektronischer Geräte neben sichtbarem Licht und hörbaren Schallwellen noch mehr Informationen erfasst. Man kann sagen, dass fotoelektrische Geräte im Vordergrund der menschlichen Wahrnehmung der Welt stehen. Die Forschung im Bereich der intelligenten Optoelektronik, an der wir beteiligt sind, konzentriert sich auf die Erforschung der Integration fotoelektrischer Sensorhardware und intelligenter Algorithmen, die Einführung physikalischer Prioritäten in den Algorithmusentwurfsprozess, die Verwendung von Algorithmusergebnissen als Leitfaden für den Hardwareentwurf und die Bildung einer gegenseitigen Rückmeldung zwischen „Erfassen“ und „Berechnung“. ". Erweitern Sie die Grenzen der Wahrnehmung und erreichen Sie das Ziel, die multimodale Wahrnehmung des Menschen zu imitieren oder sogar zu übertreffen. AI Technology Review: Welche Forschungsarbeiten betreiben Sie derzeit in Richtung multimodales kognitives Computing? Was sind Ihre zukünftigen Forschungsziele? Danke für die Frage. Mein aktueller Schwerpunkt liegt auf multimodalem kognitivem Computing bei Vicinagearth Security. Unter Sicherheit im herkömmlichen Sinne versteht man meist die städtische Sicherheit. Gegenwärtig hat sich der menschliche Aktivitätsraum auf niedrige Höhen, am Boden und unter Wasser ausgeweitet. Wir müssen ein dreidimensionales Sicherheits- und Verteidigungssystem im bodennahen Raum einrichten, um eine Reihe praktischer Aufgaben wie domänenübergreifende Erkennung und autonome unbemannte Systeme auszuführen Systeme. Ein großes Problem für die Sicherheit vor Ort besteht darin, eine große Menge multimodaler Daten, die von verschiedenen Sensoren generiert werden, intelligent zu verarbeiten, beispielsweise um es Maschinen zu ermöglichen, die gleichzeitigen Beobachtungen von Drohnen und Bodenüberwachungsgeräten aus menschlicher Sicht zu verstehen . Dabei handelt es sich um multimodales kognitives Computing und die Kombination von multimodalem kognitivem Computing und intelligenter Optoelektronik. In Zukunft werde ich weiterhin die Anwendung multimodaler kognitiver Computer in der lokalen Sicherheit untersuchen, in der Hoffnung, die Verbindung zwischen Datenerfassung und -verarbeitung zu öffnen und „Vorwärtserregungsrauschen“ (Pi-) sinnvoll zu nutzen. Lärm) , richten Sie ein Sicherheitssystem vor Ort ein, das durch multimodales kognitives Computing und intelligente Optoelektronik unterstützt wird.

Das obige ist der detaillierte Inhalt vonIEEE Fellow Li Xuelong: Multimodales kognitives Computing ist der Schlüssel zur Verwirklichung allgemeiner künstlicher Intelligenz. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So binden Sie Daten in einer Dropdown-Liste

So binden Sie Daten in einer Dropdown-Liste

Gründe, warum das Laden von CSS fehlgeschlagen ist

Gründe, warum das Laden von CSS fehlgeschlagen ist

Was tun, wenn das Laden der DLL fehlschlägt?

Was tun, wenn das Laden der DLL fehlschlägt?

Was ist der Unterschied zwischen einem Router und einer Katze?

Was ist der Unterschied zwischen einem Router und einer Katze?

Der Unterschied zwischen MySQL und SQL_Server

Der Unterschied zwischen MySQL und SQL_Server

Mindestkonfigurationsanforderungen für das Win10-System

Mindestkonfigurationsanforderungen für das Win10-System

Was tun mit der Grafikkarte?

Was tun mit der Grafikkarte?

So kaufen und verkaufen Sie Bitcoin auf Okex

So kaufen und verkaufen Sie Bitcoin auf Okex