In den letzten Jahren hat die Forschung zur Bildgenerierung auf Basis des Generative Adversarial Network (GAN) erhebliche Fortschritte gemacht. Neben der Möglichkeit, hochauflösende, realistische Bilder zu erzeugen, sind auch viele innovative Anwendungen entstanden, wie z. B. personalisierte Bildbearbeitung, Bildanimation usw. Allerdings ist die Verwendung von GAN zur Videogenerierung immer noch ein herausforderndes Problem.

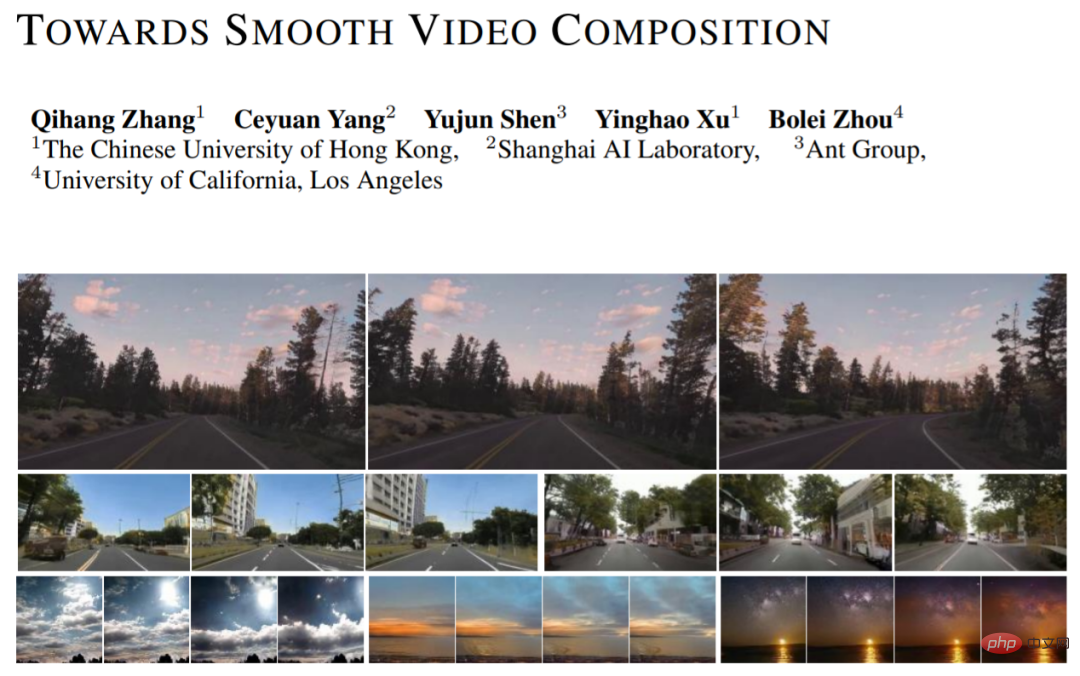

Neben der Modellierung von Einzelbildbildern erfordert die Videogenerierung auch das Erlernen komplexer zeitlicher Zusammenhänge. Kürzlich haben Forscher der Chinesischen Universität Hongkong, des Shanghai Artificial Intelligence Laboratory, des Ant Technology Research Institute und der University of California, Los Angeles eine neue Methode zur Videogenerierung vorgeschlagen (Towards Smooth Video Composition). In dem Artikel führten sie detaillierte Modellierungen und Verbesserungen der Zeitreihenbeziehungen verschiedener Zeitspannen (kurzfristiger Bereich, mittlerer Bereich, langer Bereich) durch und erzielten erhebliche Verbesserungen gegenüber früheren Arbeiten an mehreren Datensätzen. Diese Arbeit bietet einen einfachen und effektiven neuen Maßstab für die GAN-basierte Videogenerierung.

Das auf GAN basierende Bildgenerierungsnetzwerk kann wie folgt ausgedrückt werden: I = G(Z), wobei Z eine Zufallsvariable, G das Generierungsnetzwerk und I das generierte Bild ist. Wir können dieses Framework einfach auf die Kategorie der Videogenerierung erweitern: I_i=G(z_i), i=[1,...,N], wobei wir N Zufallsvariablen z_i gleichzeitig abtasten und jede Zufallsvariable z_i eine generiert entsprechender A-Rahmen des Bildes I_i. Das generierte Video kann durch Stapeln der generierten Bilder in der Zeitdimension erhalten werden.

MoCoGAN, StyleGAN-V und andere Arbeiten haben auf dieser Basis einen entkoppelten Ausdruck vorgeschlagen: I_i=G(u, v_i), i=[1,...,N], wobei u den Kontrollinhalt darstellt. Der Zufall Variable, v_i stellt die Zufallsvariable dar, die die Aktion steuert. Diese Darstellung geht davon aus, dass alle Frames denselben Inhalt haben und eine einzigartige Bewegung aufweisen. Durch diesen entkoppelten Ausdruck können wir Actionvideos mit konsistenten Inhaltsstilen und veränderbarem Realismus besser erstellen. Das neue Werk übernimmt das Design von StyleGAN-V und nutzt es als Basis.

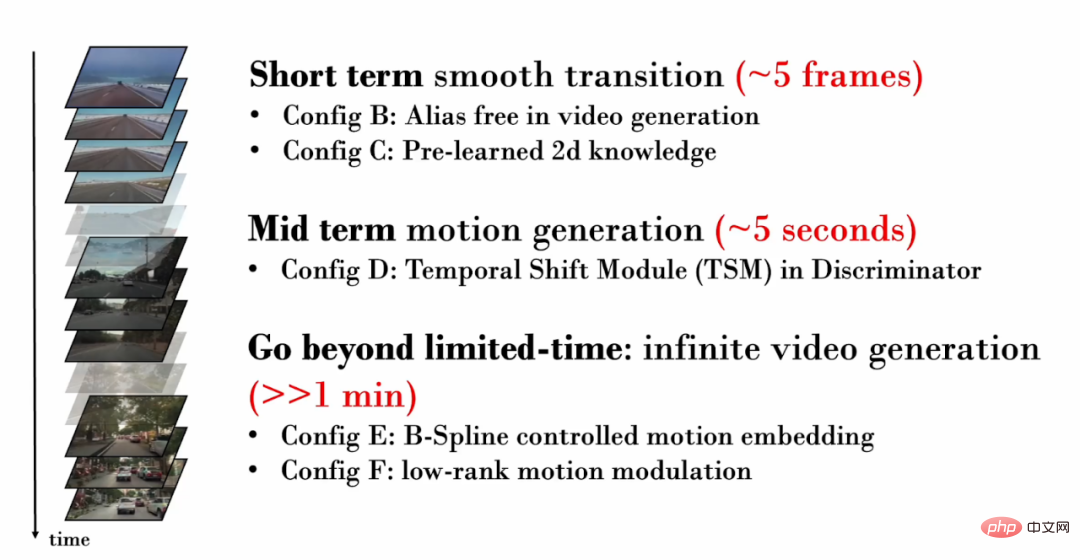

Die neue Arbeit konzentriert sich auf die zeitlichen Beziehungen verschiedener Zeitspannen (kurzer Zeitbereich, mittlerer Bereich, langer Bereich) und führt eine detaillierte Modellierung bzw. Verbesserung durch:

1. Kurze Zeit (~5 Frames ) Timing-Beziehung

Betrachten wir zunächst ein Video mit nur wenigen Bildern. Diese kurzen Videobilder enthalten oft sehr ähnliche Inhalte und zeigen nur sehr subtile Bewegungen. Daher ist es wichtig, subtile Bewegungen zwischen den Bildern realistisch zu erzeugen. In den von StyleGAN-V generierten Videos kommt es jedoch zu schwerwiegendem Textur-Sticking.

Texturhaftung bezieht sich auf die Tatsache, dass ein Teil des generierten Inhalts von bestimmten Koordinaten abhängig ist, wodurch das Phänomen des „Klebens“ an einem festen Bereich entsteht. Im Bereich der Bilderzeugung lindert StyleGAN3 das Problem der Texturanhaftung durch detaillierte Signalverarbeitung, erweiterten Füllbereich und andere Vorgänge. Diese Arbeit bestätigt, dass dieselbe Technik immer noch für die Videogenerierung effektiv ist.

In der folgenden Visualisierung verfolgen wir Pixel an derselben Stelle in jedem Frame des Videos. Es ist leicht zu erkennen, dass im StyleGAN-V-Video einige Inhalte lange Zeit an festen Koordinaten „klebrig“ waren und sich im Laufe der Zeit nicht bewegt haben, wodurch ein „Pinselphänomen“ in der Visualisierung entsteht. In den durch das neue Werk generierten Videos weisen alle Pixel eine natürliche Bewegung auf.

Forscher fanden jedoch heraus, dass die Referenzierung des Rückgrats von StyleGAN3 die Qualität der Bilderzeugung verringert. Um dieses Problem zu lösen, führten sie ein Vortraining auf Bildebene ein. In der Vortrainingsphase muss das Netzwerk nur die Generierungsqualität eines bestimmten Bildes im Video berücksichtigen und muss nicht die Modellierung des Zeitbereichs erlernen, was das Erlernen von Kenntnissen über die Bildverteilung erleichtert.

2. Zeitbeziehung mittlerer Länge (~5 Sekunden)

Da das generierte Video mehr Bilder hat, können spezifischere Aktionen angezeigt werden. Daher ist es wichtig sicherzustellen, dass das generierte Video realistische Bewegungen aufweist. Wenn wir beispielsweise ein Fahrvideo aus der ersten Person erstellen möchten, sollten wir eine sich allmählich zurückziehende Boden- und Straßenszene generieren und das herannahende Auto sollte ebenfalls einer natürlichen Fahrbahn folgen.

Im kontradiktorischen Training ist das diskriminierende Netzwerk von entscheidender Bedeutung, um sicherzustellen, dass das generative Netzwerk ausreichend Trainingsaufsicht erhält. Um sicherzustellen, dass das generative Netzwerk realistische Aktionen generieren kann, muss das diskriminierende Netzwerk daher bei der Videogenerierung die zeitlichen Beziehungen in mehreren Bildern modellieren und die erzeugte unrealistische Bewegung erfassen. In früheren Arbeiten verwendete das Diskriminanznetzwerk jedoch nur eine einfache Verkettungsoperation, um eine zeitliche Modellierung durchzuführen: y = cat (y_i), wobei y_i das Einzelbildmerkmal und y das Merkmal nach der Zeitbereichsfusion darstellt.

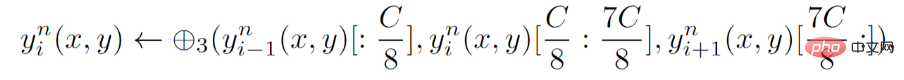

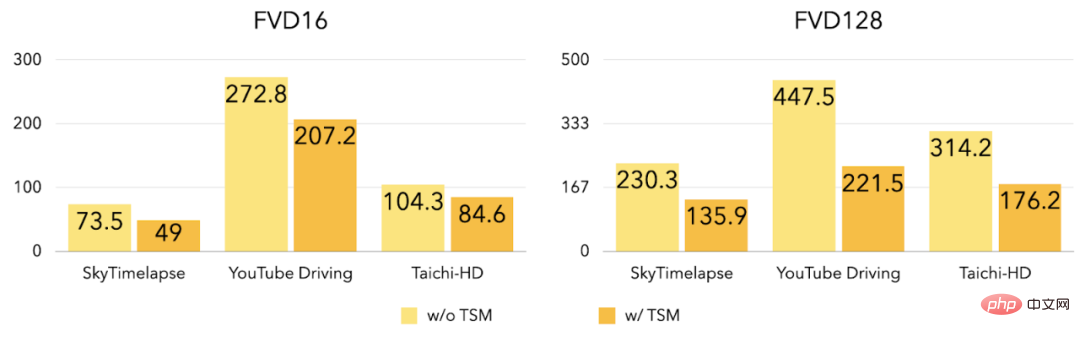

Für das Diskriminanznetzwerk schlägt die neue Arbeit eine explizite Timing-Modellierung vor, das heißt die Einführung des Temporal Shift Module (TSM) auf jeder Schicht des Diskriminanznetzwerks. TSM kommt aus dem Bereich der Aktionserkennung und realisiert den zeitlichen Informationsaustausch durch einfache Schichtoperationen:

Experimente zeigen, dass nach der Einführung von TSM FVD16 und FVD128 in den drei Datensätzen stark reduziert wurden.

3. Unendlich lange Videogenerierung

Die zuvor eingeführten Verbesserungen konzentrieren sich hauptsächlich auf die Generierung kurzer und mittellanger Videos, und das neue Werk untersucht weiter, wie man hochwertige Videos generiert. Hochwertige Videos in beliebiger Länge (einschließlich unbegrenzter Länge). Frühere Arbeiten (StyleGAN-V) können unendlich lange Videos erzeugen, aber das Video enthält sehr offensichtliches periodisches Jitter:

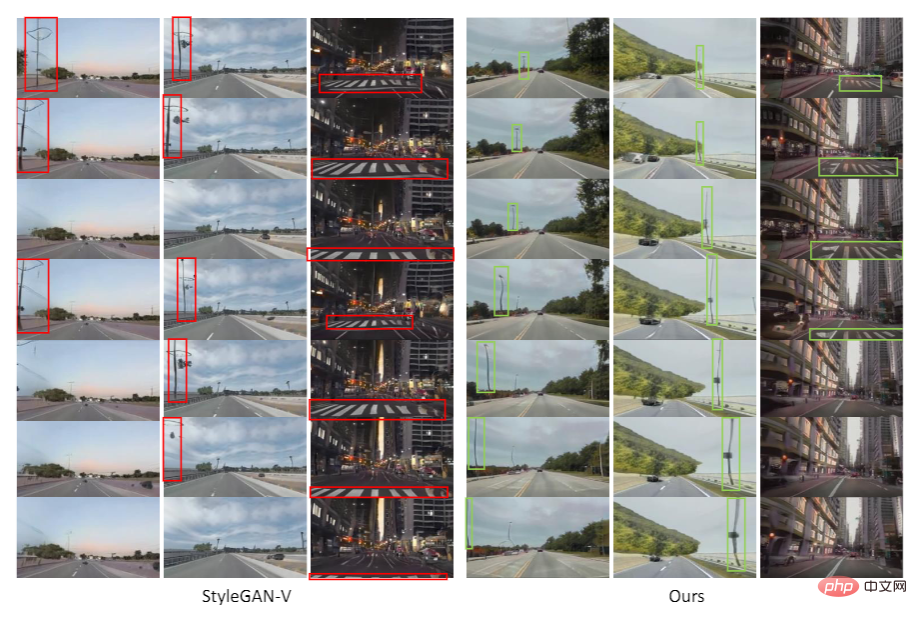

Wie in der Abbildung gezeigt, wurde das in StyleGAN-V generierte Video im Video als Das Fahrzeug bewegt sich vorwärts, der Zebrastreifen bewegte sich ursprünglich normal rückwärts, wechselte dann aber plötzlich zum Vorwärtsfahren. Diese Arbeit ergab, dass Diskontinuität in Bewegungsmerkmalen (Bewegungseinbettung) dieses Jitter-Phänomen verursachte.

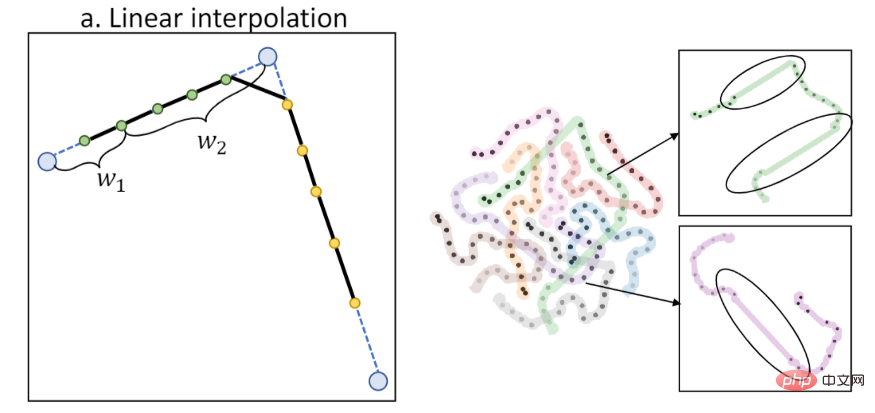

Frühere Arbeiten verwendeten lineare Interpolation zur Berechnung von Aktionsmerkmalen. Die lineare Interpolation führt jedoch zu einer Diskontinuität erster Ordnung, wie in der folgenden Abbildung dargestellt (links ist das Interpolationsdiagramm, rechts ist die T-SNE-Feature-Visualisierung). :

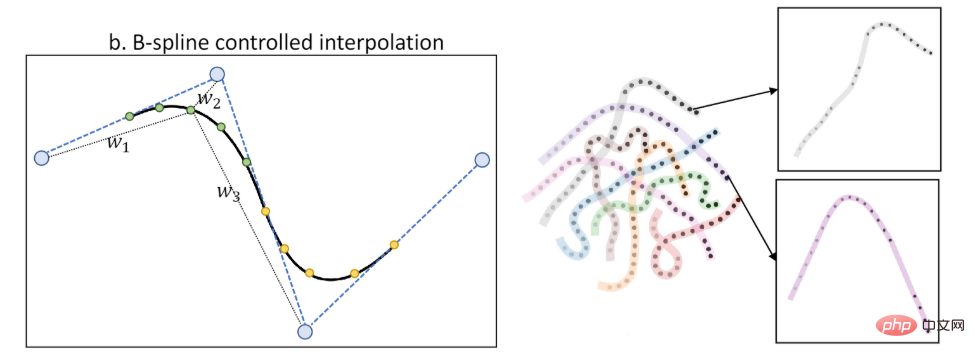

Diese Arbeit schlägt die Bewegungseigenschaften der B-Spline-Steuerung (B-Spline-basierte Bewegungseinbettung) vor. Durch Interpolation über B-Spline können zeitlich glattere Aktionsmerkmale erzielt werden, wie in der Abbildung gezeigt (links ist das Interpolationsdiagramm, rechts ist die T-SNE-Merkmalsvisualisierung):

Durch die Einführung der Aktionsmerkmale der B-Spline-Steuerung lindert die neue Arbeit das Jitter-Phänomen:

Wie in der Abbildung gezeigt, werden in dem von StyleGAN-V generierten Video Straßenlaternen und das Der Boden ändert plötzlich die Bewegungsrichtung. In den durch das neue Werk generierten Videos ist die Bewegungsrichtung einheitlich und natürlich.

Gleichzeitig schlägt das neue Werk auch eine Beschränkung der Aktionsfunktionen auf einen niedrigen Rang vor, um das Auftreten periodisch wiederkehrender Inhalte weiter zu verringern.

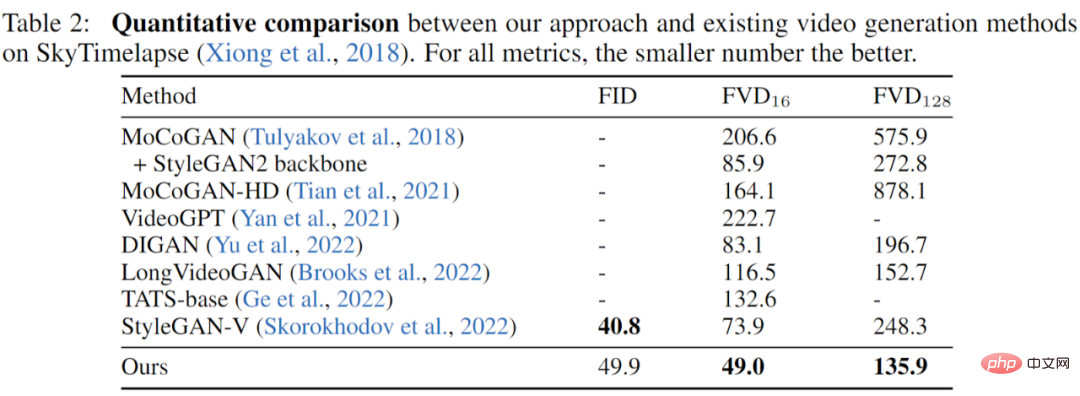

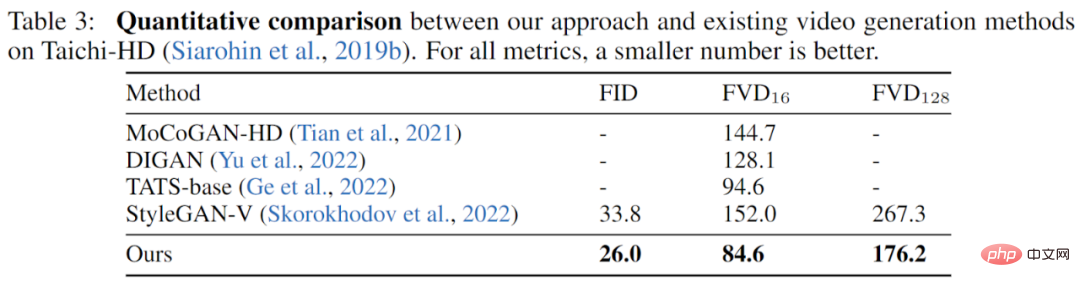

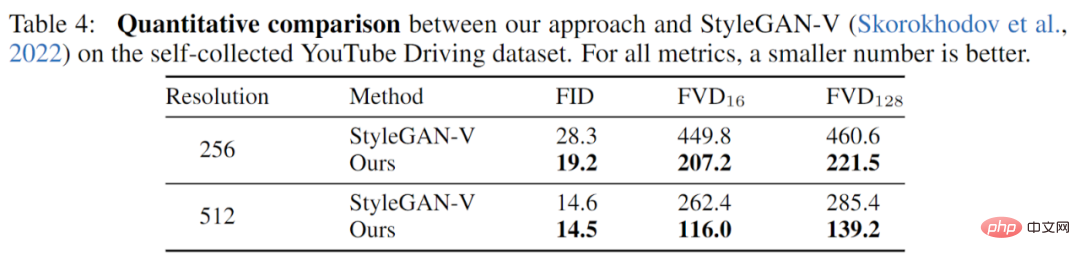

Die Arbeit wurde vollständig an drei Datensätzen (YouTube Driving, Timelapse, Taichi-HD) experimentiert und vollständig mit früheren Arbeiten verglichen. Die Ergebnisse zeigen, dass die neue Arbeit eine bessere Leistung in der Bildqualität (FID) aufweist. und die Videoqualität (FVD) wurde vollständig verbessert.

SkyTimelapse Experimentelle Ergebnisse:

Taichi-HD Experimentelle Ergebnisse:

Ergebnisse des YouTube-Fahrversuchs:

Die neue Arbeit schlägt einen neuen Benchmark für die Videogenerierung basierend auf dem GAN-Modell vor. Ausgehend von der zeitlichen Beziehung verschiedener Skalen werden neuartige und wirksame Verbesserungen vorgeschlagen. Experimente mit mehreren Datensätzen zeigen, dass das neue Werk erfolgreich eine Videoqualität erreicht, die die früherer Arbeiten deutlich übertrifft.

Das obige ist der detaillierte Inhalt vonBasierend auf GAN wird ein flüssiges Video generiert, und der Effekt ist sehr beeindruckend: keine Texturanhaftung, Reduzierung des Jitters. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was tun mit der Grafikkarte?

Was tun mit der Grafikkarte?

So laden Sie Videos von Douyin herunter

So laden Sie Videos von Douyin herunter

So lösen Sie das Problem, wenn der Computer eingeschaltet wird, der Bildschirm schwarz wird und der Desktop nicht aufgerufen werden kann

So lösen Sie das Problem, wenn der Computer eingeschaltet wird, der Bildschirm schwarz wird und der Desktop nicht aufgerufen werden kann

Der Windows Explorer funktioniert nicht mehr

Der Windows Explorer funktioniert nicht mehr

So beheben Sie einen DNS-Auflösungsfehler

So beheben Sie einen DNS-Auflösungsfehler

Die Hauptkomponenten, aus denen die CPU besteht

Die Hauptkomponenten, aus denen die CPU besteht

GeForce 940mx

GeForce 940mx

Kernelpanic-Lösung

Kernelpanic-Lösung