Es ist der gemeinsame Wunsch von Partei A und Partei B, das Bild allein durch Reden verändern zu können, aber normalerweise nur Party B. Erst dann wurde mir klar, wie traurig und traurig es war. Heute hat die KI eine Herausforderung für dieses schwierige Problem gestartet.

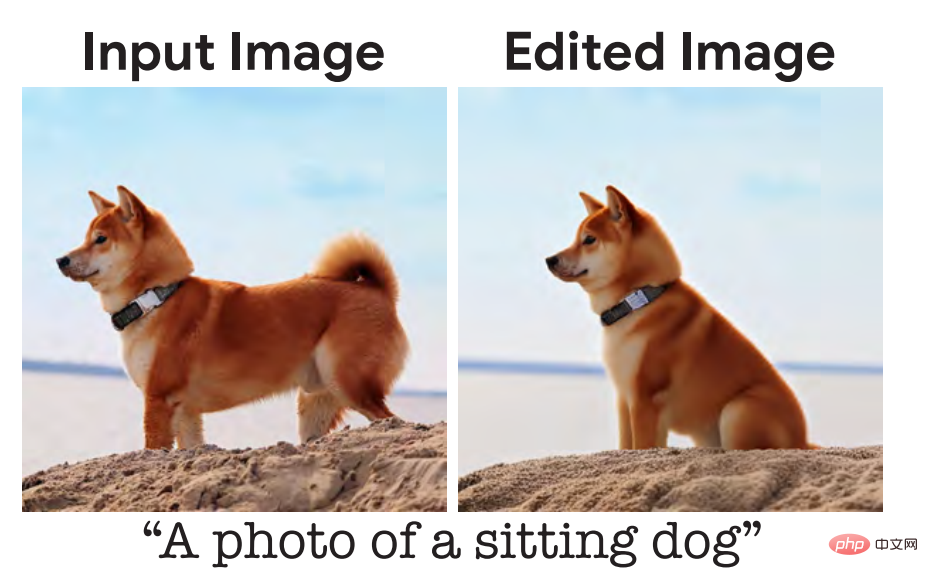

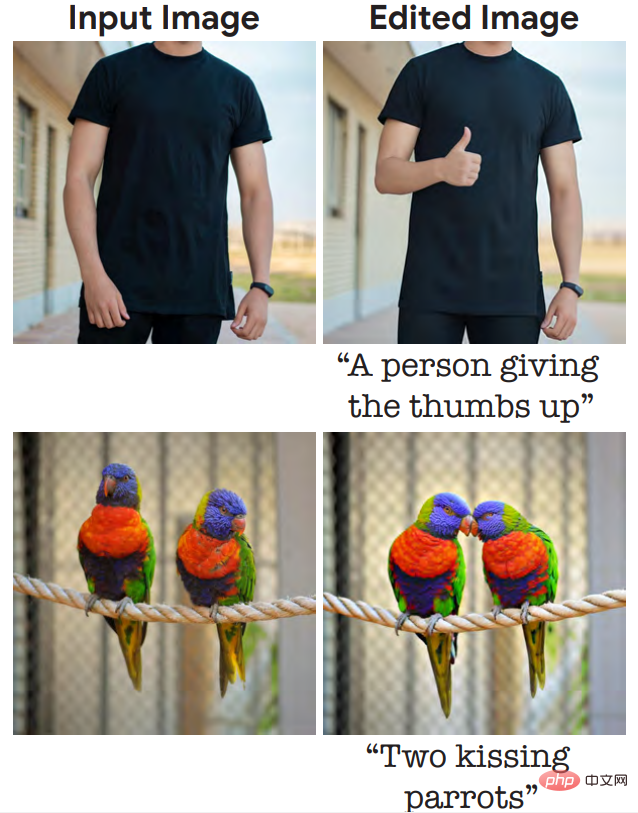

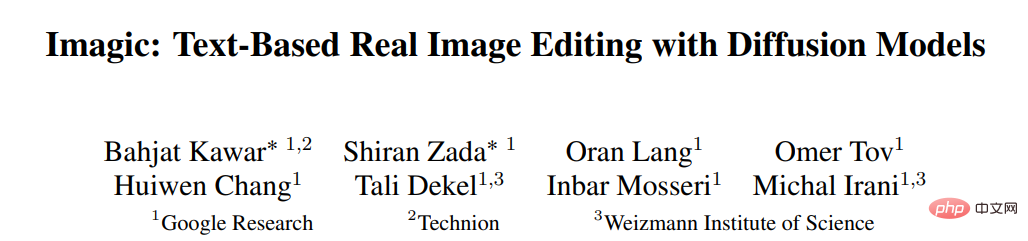

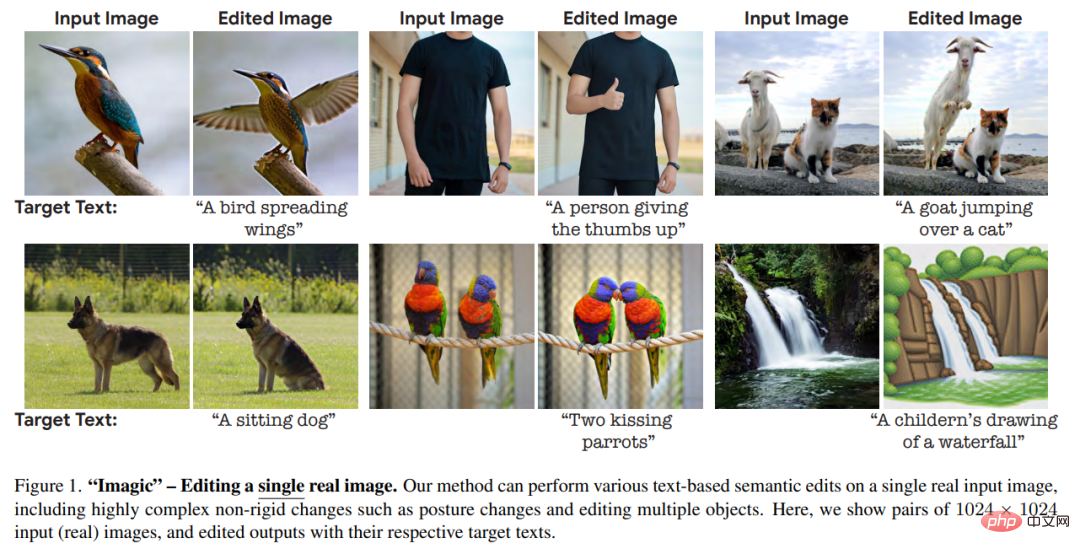

In einem am 17. Oktober auf arXiv hochgeladenen Artikel stellten Forscher von Google Research, dem Israel Institute of Technology und dem Weizmann Institute of Science in Israel Imagic vor, ein echtes Bild Bearbeitungsmethode, die auf dem Diffusionsmodell basiert, kann PS von echten Fotos nur mit Text realisieren, z. B. indem man eine Person bittet, einen Daumen nach oben zu geben oder zwei Papageien zum Küssen:

# 🎜🎜#

„Bitte helfen Sie mir mit einer Like-Geste: Keine.“ Das Problem liegt bei mir.

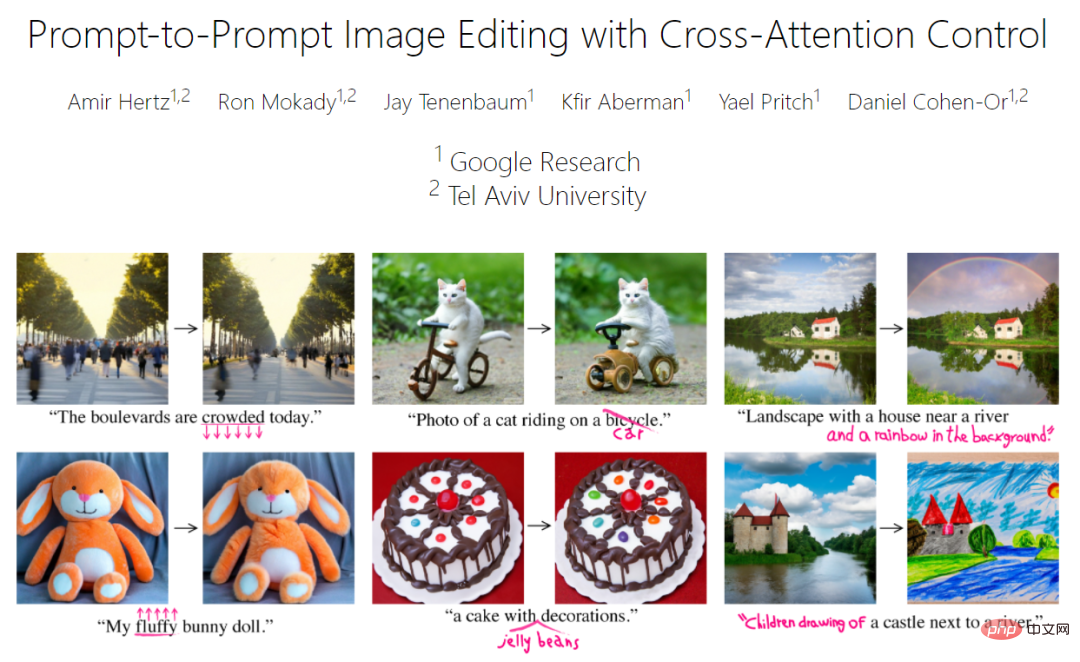

Aus den Bildern im Papier ist ersichtlich, dass die modifizierten Bilder immer noch sehr natürlich sind und keine anderen Informationen als die enthalten Es gab auch keine sichtbaren Schäden. Zu einer ähnlichen Forschung gehört das zuvor von Google Research und der Universität Tel Aviv in Israel durchgeführte Prompt-to-Prompt (Referenz [16] im Imagic-Artikel):

# 🎜🎜 #

#🎜 🎜# Deshalb sagten einige Leute voller Emotionen: „Das Tempo des Wandels in diesem Bereich ist etwas übertrieben.“ Von nun an kann Partei A allein mit seinen Worten wirklich alles ändern, was sie will.

Imagic Paper Übersicht

Papierlink:

Papierlink:

Die ständige Anwendung umfassender semantischer Bearbeitung auf echte Fotos ist eine interessante Aufgabe in der Bildverarbeitung. Diese Aufgabe hat in der Forschungsgemeinschaft großes Interesse geweckt, da Deep-Learning-basierte Systeme in den letzten Jahren erhebliche Fortschritte gemacht haben.

Die Verwendung einfacher Textaufforderungen in natürlicher Sprache zur Beschreibung der von uns gewünschten Bearbeitung (z. B. einen Hund bitten, sich zu setzen), entspricht in hohem Maße der Art und Weise, wie Menschen kommunizieren. Daher haben Forscher viele textbasierte Bildbearbeitungsmethoden entwickelt, und diese Methoden sind auch effektiv.

Allerdings haben die aktuellen Mainstream-Methoden mehr oder weniger Probleme, wie zum Beispiel:

1. Begrenzt auf einen bestimmten Satz von Bearbeitungen, wie z. B. Malen auf Bildern, Hinzufügen von Objekten oder Übertragen von Stilen [6, 28]; oder synthetisierte Bilder [16, 36]; , mehrere Bilder desselben Motivs oder Text, der das Originalbild beschreibt [6, 13, 40, 44].

In diesem Artikel wird eine semantische Bildbearbeitungsmethode „Imagic“ vorgeschlagen, um die oben genannten Probleme zu lindern. Anhand eines zu bearbeitenden Eingabebilds und einer einzelnen Textaufforderung, die die Zielbearbeitung beschreibt, ermöglicht diese Methode eine komplexe, nicht starre Bearbeitung echter hochauflösender Bilder. Die resultierende Bildausgabe stimmt gut mit dem Zieltext überein, während der Gesamtkontext, die Struktur und die Zusammensetzung des Originalbilds erhalten bleiben.

Wie in Abbildung 1 gezeigt, kann Imagic zwei Papageien dazu bringen, sich zu küssen, oder eine Person dazu bringen, den Daumen nach oben zu zeigen. Die textbasierte semantische Bearbeitung, die es bietet, ist das erste Mal, dass derart komplexe Vorgänge, einschließlich der Bearbeitung mehrerer Objekte, auf ein einziges echtes hochauflösendes Bild angewendet werden können. Zusätzlich zu diesen komplexen Änderungen ermöglicht Imagic eine Vielzahl von Bearbeitungen, einschließlich Stiländerungen, Farbänderungen und Objekthinzufügungen. Um dieses Kunststück zu erreichen, nutzten die Forscher das kürzlich erfolgreiche Textdiffusionsmodell zu Bildern. Diffusionsmodelle sind leistungsstarke generative Modelle, die eine qualitativ hochwertige Bildsynthese ermöglichen. Wenn es von einer Textaufforderung in natürlicher Sprache abhängig gemacht wird, ist es in der Lage, Bilder zu generieren, die mit dem angeforderten Text übereinstimmen. In dieser Arbeit verwendeten die Forscher sie, um reale Bilder zu bearbeiten, anstatt neue zu synthetisieren.

Wie in Abbildung 3 gezeigt, benötigt Imagic nur drei Schritte, um die obige Aufgabe abzuschließen: Optimieren Sie zunächst eine Texteinbettung, um ein Bild zu erzeugen, das dem Eingabebild ähnelt. Anschließend wird das vorab trainierte generative Diffusionsmodell feinabgestimmt, um das Eingabebild auf der Grundlage optimierter Einbettungen besser zu rekonstruieren. Schließlich wird eine lineare Interpolation zwischen der Zieltexteinbettung und der optimierten Einbettung durchgeführt, was zu einer Darstellung führt, die das Eingabebild und den Zieltext kombiniert. Diese Darstellung wird dann an einen generativen Diffusionsprozess mit einem fein abgestimmten Modell übergeben, der das endgültige bearbeitete Bild ausgibt.

Um die Stärke von Imagic zu beweisen, führten die Forscher mehrere Experimente durch, wandten die Methode auf zahlreiche Bilder in verschiedenen Bereichen an und erzielten bei allen Experimenten gute Ergebnisse. Beeindruckende Ergebnisse . Die von Imagic ausgegebenen hochwertigen Bilder sind den Eingabebildern sehr ähnlich und stimmen mit dem erforderlichen Zieltext überein. Diese Ergebnisse belegen die Vielseitigkeit, Vielseitigkeit und Qualität von Imagic. Die Forscher führten außerdem eine Ablationsstudie durch, die die Wirksamkeit jeder Komponente der vorgeschlagenen Methode hervorhob. Im Vergleich zu einer Reihe neuerer Methoden weist Imagic eine deutlich bessere Bearbeitungsqualität und Genauigkeit gegenüber dem Originalbild auf, insbesondere bei der Durchführung hochkomplexer, nicht starrer Bearbeitungsaufgaben.

MethodendetailsGegeben ein Eingabebild x und ein Zieltext, zielt dieser Artikel darauf ab, das Bild so zu bearbeiten, dass es den gegebenen Anforderungen entspricht Text, Gleichzeitig kann eine große Menge an Details in Bild x erhalten bleiben. Um dieses Ziel zu erreichen, nutzt dieser Artikel die Texteinbettungsschicht des Diffusionsmodells, um semantische Operationen auf eine Art und Weise durchzuführen, die den GAN-basierten Methoden ähnelt. Forscher suchen zunächst nach aussagekräftigen Darstellungen und durchlaufen dann einen generativen Prozess, der Bilder erzeugt, die dem Eingabebild ähneln. Anschließend wird das generative Modell optimiert, um das Eingabebild besser zu rekonstruieren. Der letzte Schritt besteht darin, die latente Darstellung zu verarbeiten, um das Bearbeitungsergebnis zu erhalten.

Wie in Abbildung 3 oben gezeigt, besteht die Methode dieses Artikels aus drei Schritten: (1) Optimieren Sie die Texteinbettung, um die beste Übereinstimmung für das gegebene Bild in der Nähe zu finden die Einbettung des Zieltextes; (2) Feinabstimmung des Diffusionsmodells, um es besser an das gegebene Bild anzupassen; (3) Durchführung einer linearen Interpolation zwischen der optimierten Einbettung und der Einbettung des Zieltextes, um eine Einbettung zu finden, die sowohl die Bildtreue als auch den Punkt erreicht an dem der Zieltext ausgerichtet ist.

Weitere spezifische Details sind wie folgt:

Texteinbettungsoptimierung

Zuerst wird der Zieltext in den Textencoder eingegeben, der die entsprechende Texteinbettung

ausgibt, wobei T die Anzahl der Token ist, die dem Zieltext gegeben sind , d ist die Token-Einbettungsdimension. Anschließend froren die Forscher die Parameter des generierten Diffusionsmodells f_θ ein und nutzten das Entrauschungsdiffusionsziel, um die Einbettung des Zieltextes zu optimieren.Wobei x das Eingabebild ist,  eine Rauschversion von x ist und θ das Gewicht des vorab trainierten Diffusionsmodells ist. Dadurch wird sichergestellt, dass die Texteinbettung so genau wie möglich mit dem Eingabebild übereinstimmt. Dieser Prozess läuft in relativ wenigen Schritten ab und hält sich an die ursprüngliche Einbettung des Zieltextes, was zu einem optimierten Einbettungs-e_opt führt.

eine Rauschversion von x ist und θ das Gewicht des vorab trainierten Diffusionsmodells ist. Dadurch wird sichergestellt, dass die Texteinbettung so genau wie möglich mit dem Eingabebild übereinstimmt. Dieser Prozess läuft in relativ wenigen Schritten ab und hält sich an die ursprüngliche Einbettung des Zieltextes, was zu einem optimierten Einbettungs-e_opt führt.

Modell-Feinabstimmung

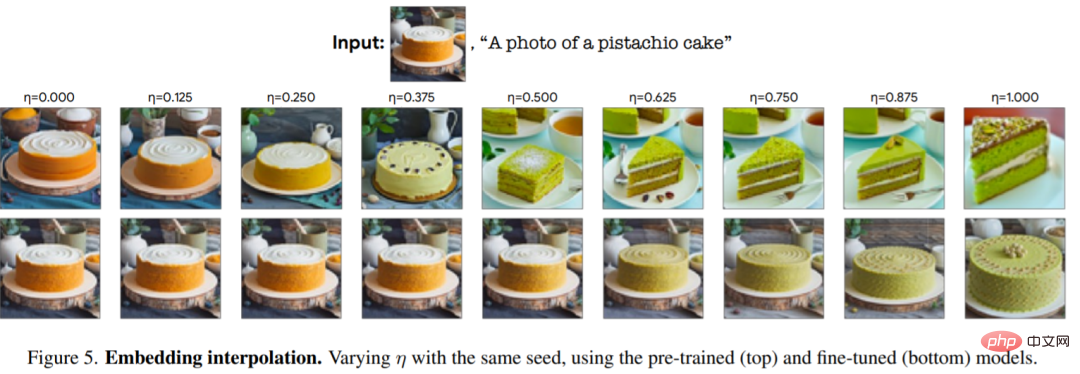

Hier ist zu beachten, dass die hier erhaltenen optimierten Einbettungs-e_opt beim Durchlaufen des Generierungsdiffusionsprozesses nicht unbedingt vollständig dem Eingabebild x ähneln, da sie nur ausgeführt werden eine kleine Anzahl von Optimierungsschritten (siehe oberes linkes Feld in Abbildung 5). Daher schließen die Autoren in der zweiten Stufe diese Lücke, indem sie die Modellparameter θ mithilfe derselben Verlustfunktion wie in Gleichung (2) optimieren und gleichzeitig die Optimierungseinbettung einfrieren.

Texteinbettungsinterpolation

Die dritte Stufe von Imagic ist eine einfache lineare Interpolation zwischen e_tgt und e_opt. Für einen gegebenen Hyperparameter  erhalten wir

erhalten wir  . Dann verwenden die Autoren ein fein abgestimmtes Modell, um den zugrunde liegenden generativen Diffusionsprozess unter der Bedingung von

. Dann verwenden die Autoren ein fein abgestimmtes Modell, um den zugrunde liegenden generativen Diffusionsprozess unter der Bedingung von  anzuwenden. Dadurch entsteht ein bearbeitetes Bild mit niedriger Auflösung, das dann mithilfe eines fein abgestimmten Hilfsmodells hochaufgelöst wird, um den Zieltext hochauflösend zu machen. Dieser Generierungsprozess gibt das endgültige, hochauflösende bearbeitete Bild aus

anzuwenden. Dadurch entsteht ein bearbeitetes Bild mit niedriger Auflösung, das dann mithilfe eines fein abgestimmten Hilfsmodells hochaufgelöst wird, um den Zieltext hochauflösend zu machen. Dieser Generierungsprozess gibt das endgültige, hochauflösende bearbeitete Bild aus  .

.

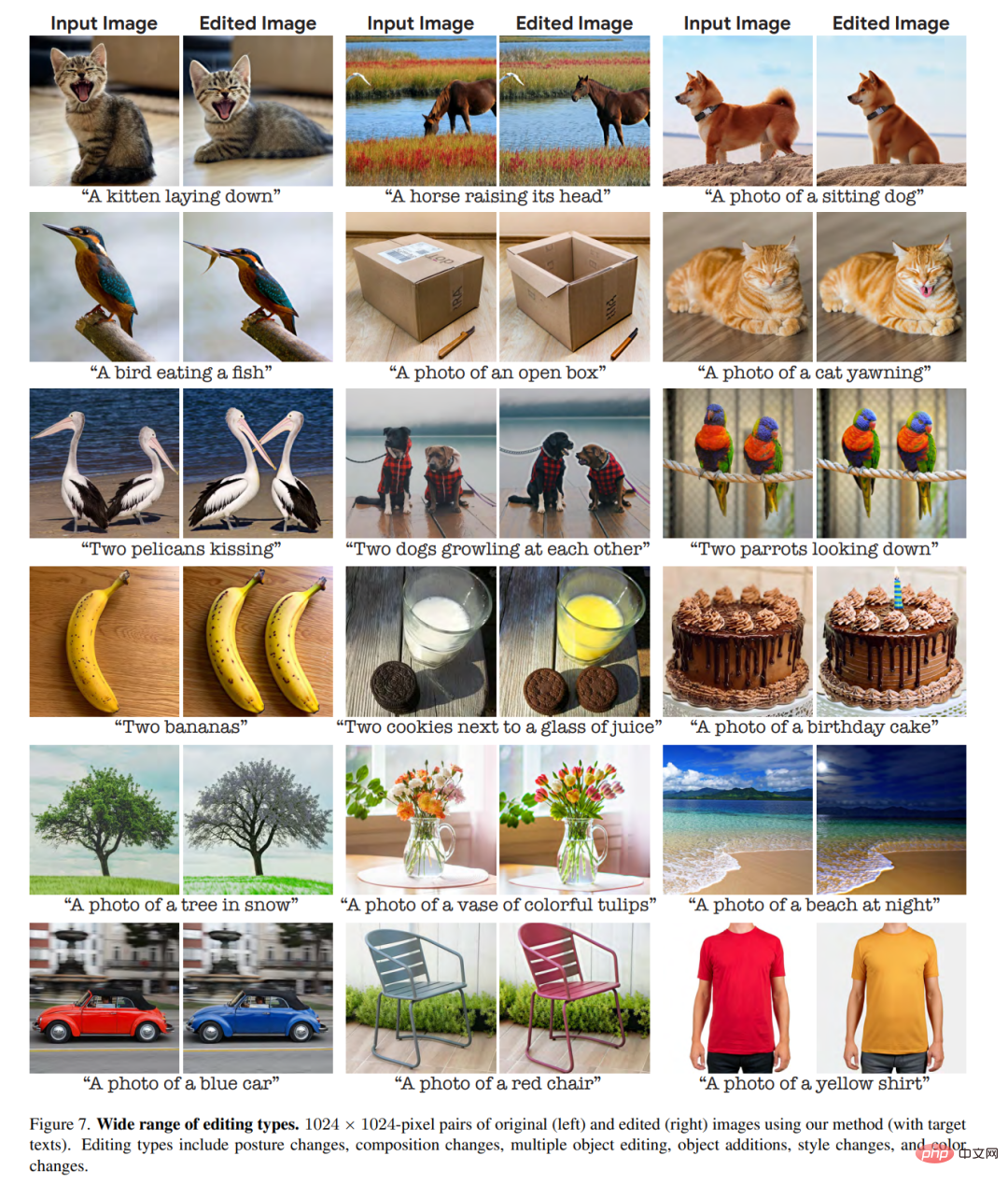

Um den Effekt zu testen, wandten die Forscher diese Methode auf eine große Anzahl realer Bilder aus verschiedenen Bereichen an und verwendeten einfache Textaufforderungen, um verschiedene Bearbeitungskategorien zu beschreiben, wie zum Beispiel: Stil, Aussehen, Farbe, Pose usw Zusammensetzung. Sie sammelten hochauflösende, kostenlos nutzbare Bilder von Unsplash und Pixabay, optimierten sie, um jede Bearbeitung mit 5 zufälligen Seeds zu generieren, und wählten die besten Ergebnisse aus. Imagic zeigt beeindruckende Ergebnisse mit seiner Fähigkeit, eine Vielzahl von Bearbeitungskategorien auf alle allgemeinen Eingabebilder und -texte anzuwenden, wie in den Abbildungen 1 und 7 dargestellt.

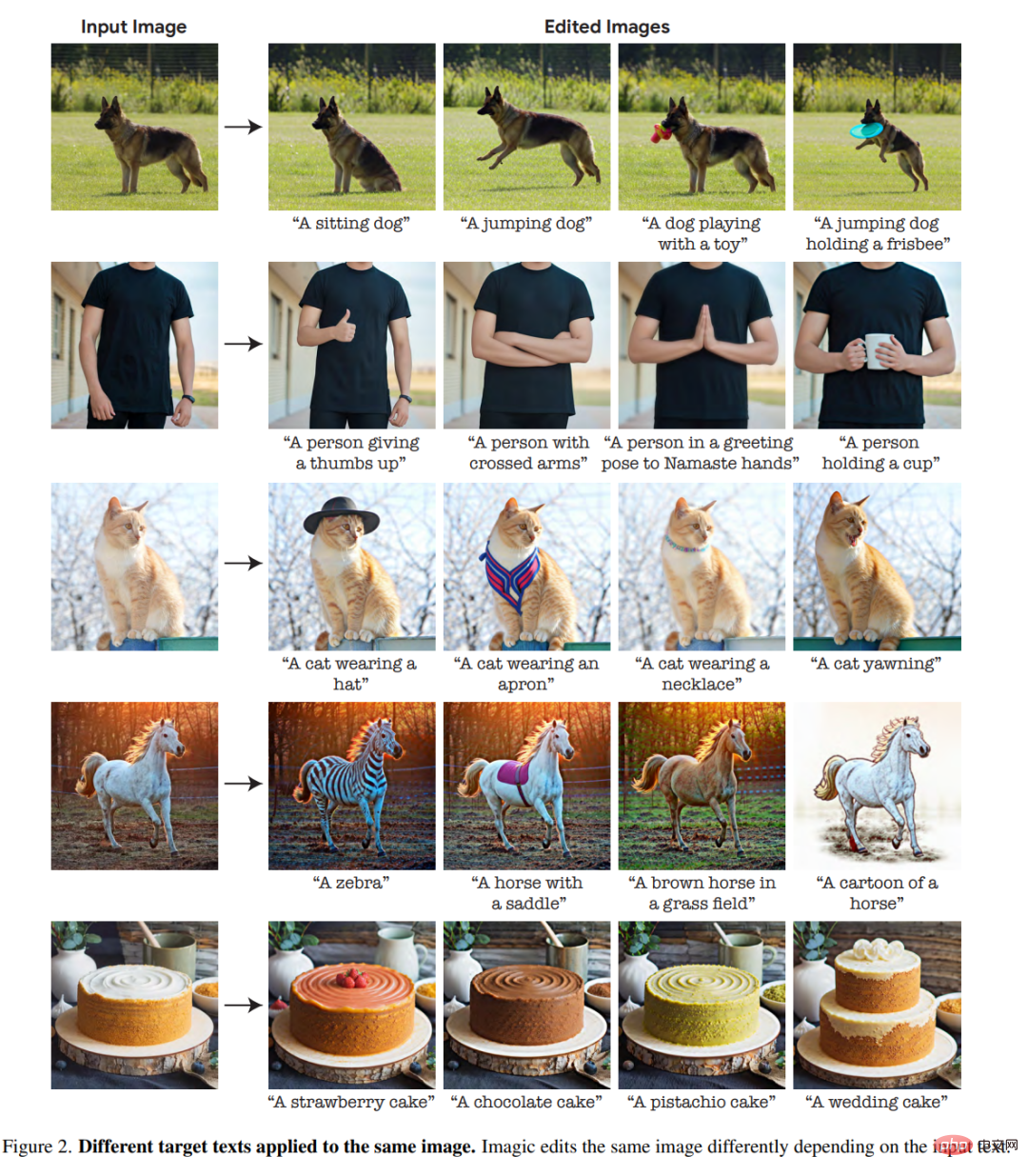

Abbildung 2 ist ein Experiment mit verschiedenen Textaufforderungen auf demselben Bild, das die Vielseitigkeit von Imagic zeigt.

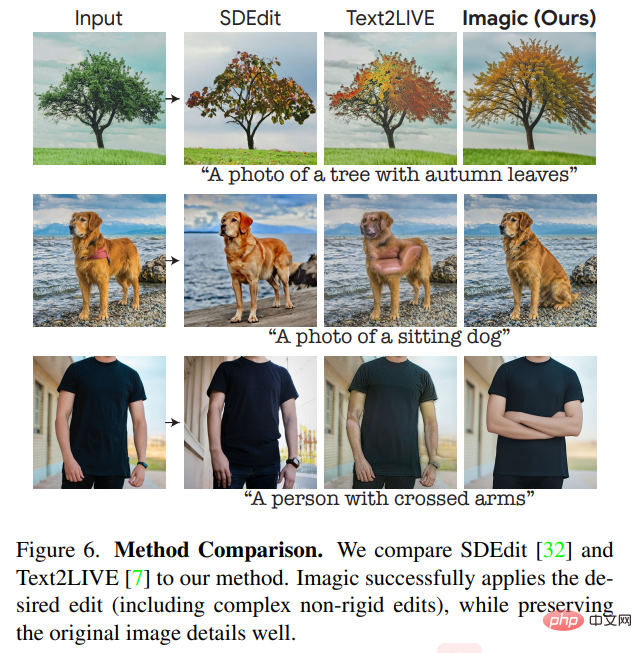

Da das von den Forschern zugrunde liegende generative Diffusionsmodell auf Wahrscheinlichkeit basiert, kann diese Methode für ein einzelnes Bild-Text-Paar unterschiedliche Ergebnisse generieren. Abbildung 4 zeigt mehrere Optionen für die Bearbeitung mit verschiedenen Zufalls-Seeds (mit geringfügigen Anpassungen des Eta für jeden Seed). Diese Zufälligkeit ermöglicht es Benutzern, zwischen diesen verschiedenen Optionen zu wählen, da Texteingabeaufforderungen in natürlicher Sprache im Allgemeinen mehrdeutig und ungenau sind. In der Studie wurde Imagic mit führenden Allzweckmethoden verglichen, die mit einer einzigen Eingabe realer Bilder arbeiten und diese auf der Grundlage einer Texteingabe bearbeiten. Abbildung 6 zeigt die Bearbeitungsergebnisse verschiedener Methoden wie Text2LIVE[7] und SDEdit[32].

Es ist ersichtlich, dass unsere Methode eine hohe Wiedergabetreue zum Eingabebild beibehält und gleichzeitig die erforderlichen Bearbeitungen angemessen durchführt. Bei komplexen, nicht starren Bearbeitungsaufgaben, wie zum Beispiel „den Hund zum Sitzen bringen“, übertrifft unsere Methode frühere Techniken deutlich. Imagic ist die erste Demo, die diese anspruchsvolle textbasierte Bearbeitung auf ein einzelnes reales Bild anwendet.

Das obige ist der detaillierte Inhalt vonIch kann es nicht aufhalten! Das Diffusionsmodell kann zum Photoshopieren von Fotos verwendet werden, bei denen nur Text verwendet wird. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!