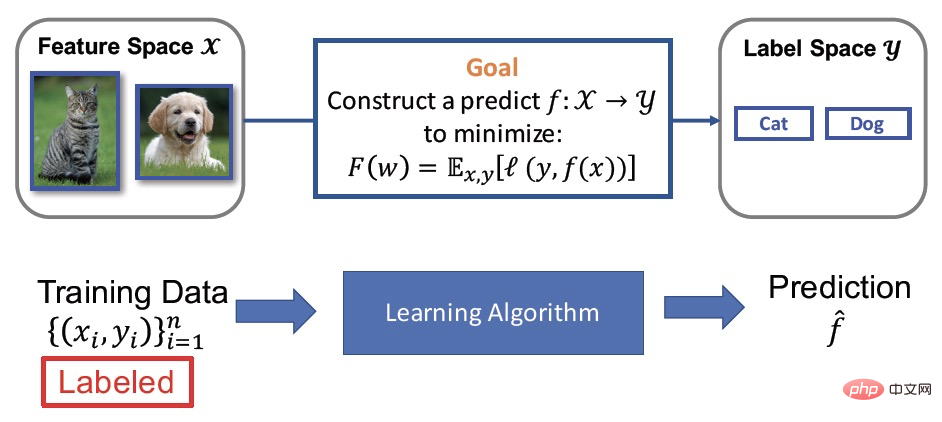

Überwachtes Lernen

Mathematisch gesehen kann dies als Lernen aus Daten (Mapping-Funktion) beschrieben werden von X) zur Anmerkung (y). Überwachtes Lernen ist eine der am häufigsten verwendeten Modelltrainingsmethoden. Die Verbesserung seiner Wirkung hängt von einer großen Menge gut gekennzeichneter Trainingsdaten ab, der sogenannten großen Menge gekennzeichneter Daten ((X, y)). Allerdings erfordert die Kennzeichnung von Daten häufig viel Personal, Material usw. Daher wird zwar die Wirkung verbessert, es entstehen jedoch auch hohe Kosten. In praktischen Anwendungen kommt es häufig vor, dass nur wenige beschriftete Daten und große Mengen unbeschrifteter Daten vorhanden sind. Das daraus resultierende halbüberwachte Lernen hat auch bei wissenschaftlichen Mitarbeitern immer mehr Aufmerksamkeit erregt.

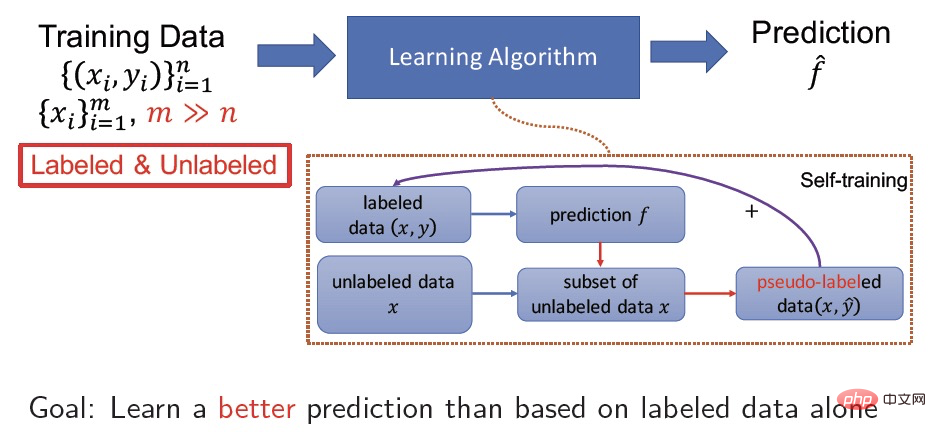

Halbüberwachtes Lernen

Halbüberwachtes Lernen lernt gleichzeitig eine kleine Menge beschrifteter Daten und eine große Menge unbeschrifteter Daten und dient dazu, unbeschriftete Daten zur Verbesserung des Modells zu verwenden Genauigkeit. Selbsttraining ist beispielsweise eine sehr verbreitete halbüberwachte Lernmethode. Der spezifische Prozess besteht darin, die Zuordnung von Daten von X zu Y für markierte Daten (X, Y) zu lernen und gleichzeitig das erlernte Modell zur Vorhersage zu verwenden Ein unbeschriftetes Daten-X-Pseudo-Label  hilft dem Modell, eine bessere Konvergenz zu erreichen und die Genauigkeit zu verbessern, indem es weiterhin überwachtes Lernen an den Pseudo-Label-Daten (X,

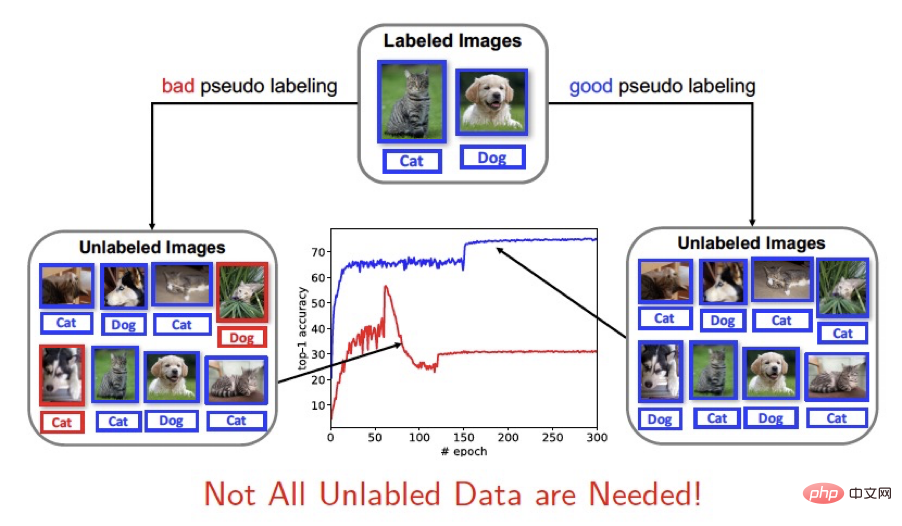

hilft dem Modell, eine bessere Konvergenz zu erreichen und die Genauigkeit zu verbessern, indem es weiterhin überwachtes Lernen an den Pseudo-Label-Daten (X,  ) durchführt. Lösung von Kernproblemen Schwellenwert Kartieren Sie Stichproben mit höherer Konfidenz für das Training (z. B. FixMatch). Da die Verwendung unbeschrifteter Daten durch halbüberwachtes Lernen von den vom aktuellen Modell vorhergesagten Pseudoetiketten abhängt, hat die Genauigkeit der Pseudoetiketten einen größeren Einfluss auf das Training des Modells. Gute Vorhersageergebnisse tragen zur Konvergenz und Genauigkeit bei Beim Lernen neuer Modelle beeinträchtigen schlechte Vorhersageergebnisse das Modelltraining. Deshalb denken wir:

) durchführt. Lösung von Kernproblemen Schwellenwert Kartieren Sie Stichproben mit höherer Konfidenz für das Training (z. B. FixMatch). Da die Verwendung unbeschrifteter Daten durch halbüberwachtes Lernen von den vom aktuellen Modell vorhergesagten Pseudoetiketten abhängt, hat die Genauigkeit der Pseudoetiketten einen größeren Einfluss auf das Training des Modells. Gute Vorhersageergebnisse tragen zur Konvergenz und Genauigkeit bei Beim Lernen neuer Modelle beeinträchtigen schlechte Vorhersageergebnisse das Modelltraining. Deshalb denken wir:

Technische Anwendung: https://modelscope.cn/models/damo/cv_manual_face-liveness_flrgb/summary

3. MethodeFixmatch-Trainingsrahmen

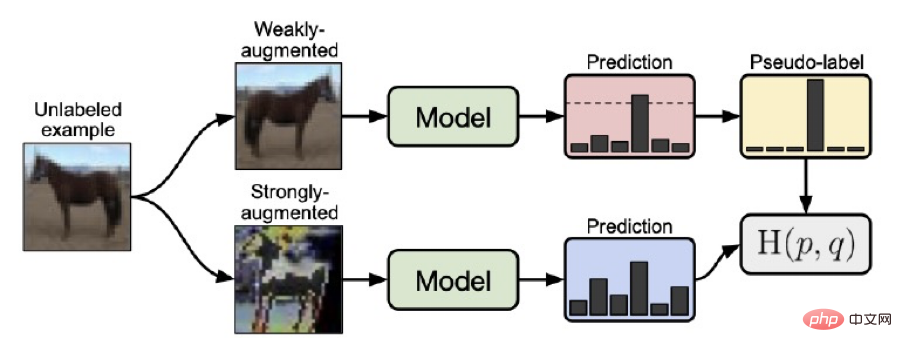

Bevor wir unsere Methode Dash vorstellen, stellen wir den von Google vorgeschlagenen FixMatch-Algorithmus vor, eine halbüberwachte Lernmethode, die einen festen Schwellenwert verwendet, um unbeschriftete Proben auszuwählen. Das FixMatch-Trainingsframework war die vorherige SOTA-Lösung. Die wichtigsten Punkte des gesamten Lernrahmens können wie folgt zusammengefasst werden:

1. Für Stichproben, die durch schwache Datenverbesserung (horizontales Spiegeln, Versetzen usw.) unbeschrifteter Daten erhalten werden, wird der vorhergesagte Wert durch den Strom ermittelt Modell

2 Für unbeschriftete Daten werden durch starke Datenverbesserung (RA oder CTA) gewonnene Stichproben verwendet, um vorhergesagte Werte durch das aktuelle Modell zu erhalten

3 Mit hoher Konfidenz werden durch eine Hot-Methode Pseudo-Label  gebildet und dann

gebildet und dann  und der vorhergesagte Wert von X

und der vorhergesagte Wert von X  verwendet, der durch starke Datenverbesserung erhalten wurde, um das Modell zu trainieren. Der Vorteil von

verwendet, der durch starke Datenverbesserung erhalten wurde, um das Modell zu trainieren. Der Vorteil von

fixmatch besteht darin, dass schwach verbesserte Daten zur Vorhersage von Pseudoetiketten verwendet werden, was die Genauigkeit von Pseudoetikettenvorhersagen erhöht und während des Trainingsprozesses zur Auswahl ein fester Schwellenwert von 0,95 (entspricht einem Verlust von 0,0513) verwendet wird Hohes Vertrauen (der Schwellenwert ist größer als 0,95, d. h. die vorhergesagten Stichproben mit einem Verlust von weniger als oder gleich 0,0513) erzeugen Pseudoetiketten, was den Trainingsprozess weiter stabilisiert.

Dash-Trainingsrahmen

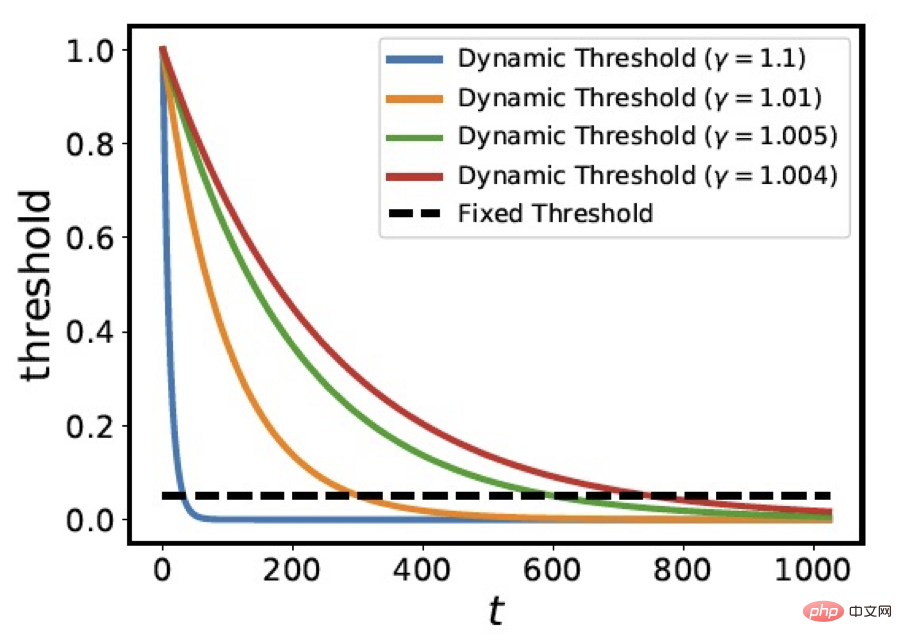

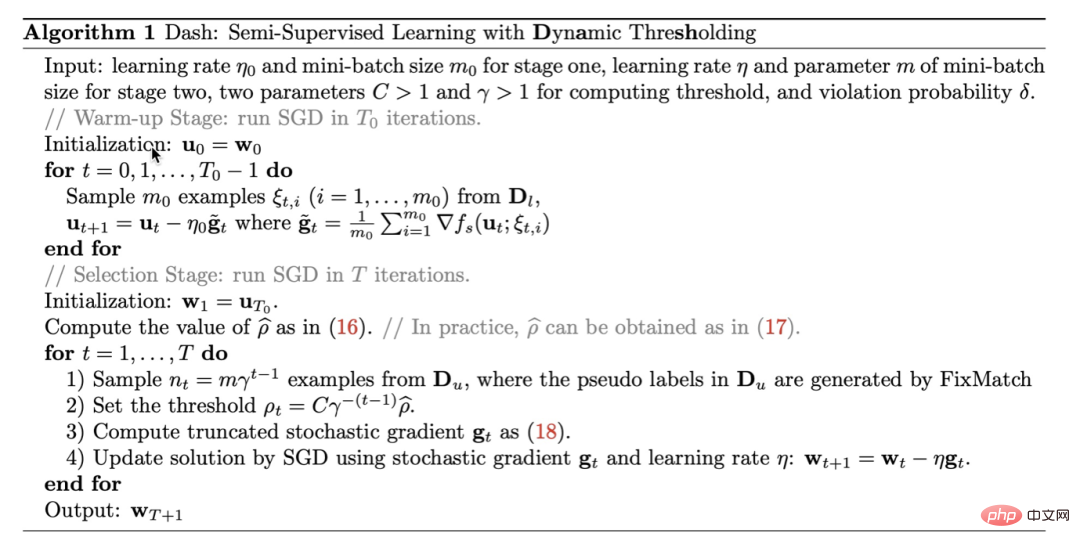

Mit Blick auf das Problem der Auswahl aller Pseudo-Labels und der Verwendung fester Schwellenwerte zur Auswahl von Pseudo-Labels schlagen wir innovativ eine Strategie zur Verwendung dynamischer Schwellenwerte für das Probenscreening vor. Das heißt, die dynamische Schwelle wird mit t

abgeschwächt

abgeschwächt

wobei C=1,0001,  der durchschnittliche Verlust markierter Daten nach der ersten Epoche ist, und wir wählen diese

der durchschnittliche Verlust markierter Daten nach der ersten Epoche ist, und wir wählen diese  unbeschrifteten Proben aus, um an der Gradienten-Backpropagation teilzunehmen. Die folgende Abbildung zeigt die Variationskurve des Schwellenwerts

unbeschrifteten Proben aus, um an der Gradienten-Backpropagation teilzunehmen. Die folgende Abbildung zeigt die Variationskurve des Schwellenwerts  bei verschiedenen

bei verschiedenen  Werten. Sie können sehen, dass der Parameter

Werten. Sie können sehen, dass der Parameter  die Abfallgeschwindigkeit der Schwellenwertkurve steuert. Die Änderungskurve von

die Abfallgeschwindigkeit der Schwellenwertkurve steuert. Die Änderungskurve von  ähnelt dem Abwärtstrend der Verlustfunktion bei der Simulation des Trainingsmodells.

ähnelt dem Abwärtstrend der Verlustfunktion bei der Simulation des Trainingsmodells.

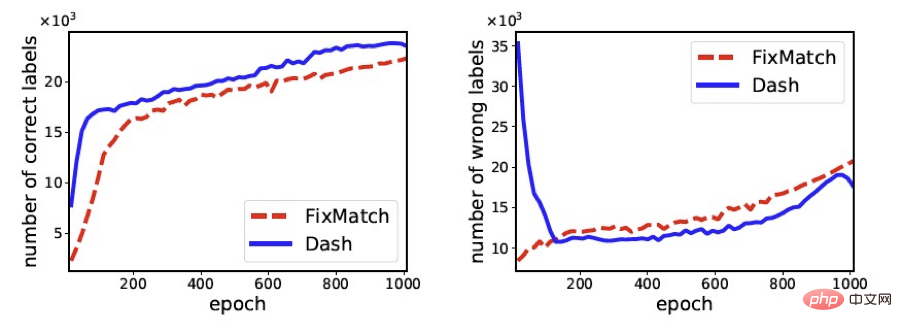

Die folgende Abbildung vergleicht die Anzahl der richtigen Proben und die Anzahl der falschen Proben, die FixMath und Dash während des Trainingsprozesses im Verlauf des Trainings ausgewählt haben (der verwendete Datensatz ist cifar100). Aus der Abbildung ist deutlich ersichtlich, dass Dash im Vergleich zu FixMatch mehr Proben mit korrekten Etiketten und weniger Proben mit falschen Etiketten auswählen kann, was letztendlich dazu beiträgt, die Genauigkeit des Trainingsmodells zu verbessern.

Unser Algorithmus lässt sich wie folgt zusammenfassen: Algorithmus 1. Dash ist eine allgemeine Strategie, die leicht in bestehende halbüberwachte Lernmethoden integriert werden kann. Der Einfachheit halber integrieren wir in den Experimenten dieses Artikels hauptsächlich Dash mit FixMatch. Weitere theoretische Beweise finden Sie im Artikel.

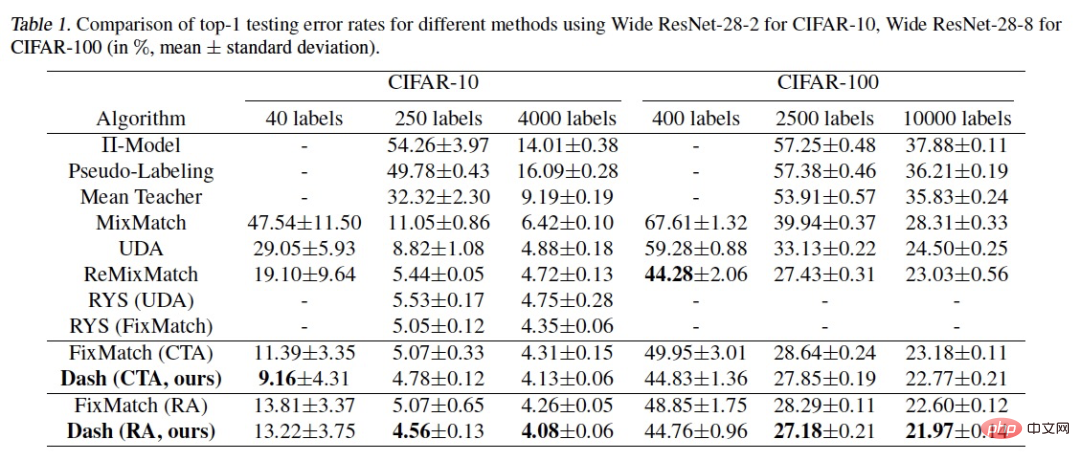

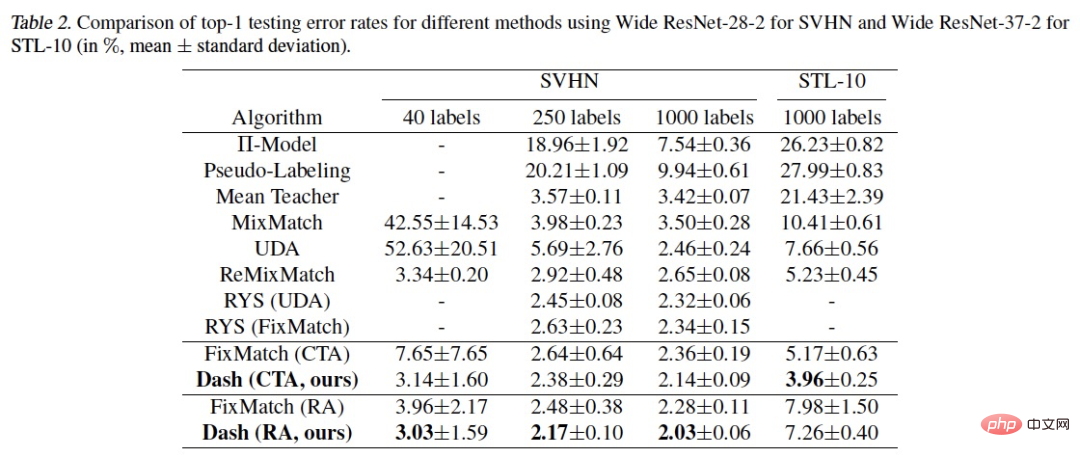

Wir haben den Algorithmus anhand häufig verwendeter halbüberwachter Lerndatensätze überprüft: CIFAR-10, CIFAR-100, STL-10 und SVHN. Die Ergebnisse sind wie folgt:

Es ist ersichtlich, dass unsere Methode in mehreren experimentellen Umgebungen bessere Ergebnisse erzielt hat als SOTA. Was erklärt werden muss, ist das Experiment für CIFAR-100 400label, ReMixMatch Using Der zusätzliche Trick der Datenausrichtung erzielt bessere Ergebnisse. Nach dem Hinzufügen des Datenausrichtungstricks zu Dash kann eine Fehlerrate von 43,31 % erreicht werden, was niedriger ist als die Fehlerrate von 44,28 % von ReMixMatch.

Im eigentlichen Entwicklungsprozess von an Aufgabendomänen orientierten Modellen wird häufig das semi-überwachte Dash-Framework eingesetzt. Als nächstes stelle ich Ihnen die kostenlosen Open-Source-Modelle vor, die wir in verschiedenen Bereichen entwickelt haben. Sie können sie gerne ausprobieren und herunterladen (Sie können sie auf den meisten Mobiltelefonen erleben):

Das obige ist der detaillierte Inhalt vonDas halbüberwachte Open-Source-Lernframework Dash der Damo Academy aktualisiert viele SOTA. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!