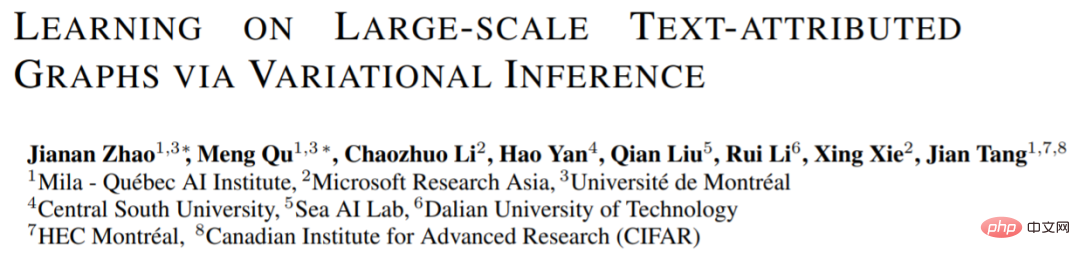

Abbildung 1: (a) Textdiagramm (b) Diagramm neuronales Netzwerk (c) Sprachmodell

Graph ist eine universelle Datenstruktur, die die strukturelle Beziehung zwischen Knoten modelliert. Im wirklichen Leben enthalten viele Knoten Rich-Text-Features, und dieses Diagramm wird als textattributiertes Diagramm bezeichnet [2]. Beispielsweise enthält das Zitationsnetzwerk den Text des Artikels und die Zitatbeziehung zwischen den Artikeln; das soziale Netzwerk enthält die Textbeschreibung des Benutzers und die direkte interaktive Beziehung des Benutzers. Das Repräsentationslernmodell für Textdiagramme kann auf Aufgaben wie Knotenklassifizierung und Linkvorhersage angewendet werden und hat einen breiten Anwendungswert.

Textdiagramm enthält zwei Informationsaspekte: Textinformationen von Knoten und Diagrammstrukturinformationen zwischen Knoten. Die Modellierung traditioneller Textdiagramme kann in zwei Perspektiven unterteilt werden: Textmodellierung und Diagrammmodellierung. Unter diesen verwendet die Textmodellierungsmethode (siehe Abbildung 1.b) normalerweise ein transformatorbasiertes Sprachmodell (LM), um die Textdarstellung eines einzelnen Knotens zu erhalten und die Zielaufgabe vorherzusagen ( Wie gezeigt). In Abbildung 1.c) wird normalerweise ein graphisches neuronales Netzwerk (GNN) verwendet, um die Interaktion zwischen Knotenmerkmalen zu modellieren und Zielaufgaben durch einen Nachrichtenverbreitungsmechanismus vorherzusagen.

Die beiden Modelle können jedoch jeweils nur Text- und Diagrammstrukturen in Textdiagrammen modellieren: Herkömmliche Sprachmodelle können Strukturinformationen nicht direkt berücksichtigen, und neuronale Diagrammnetze können Originaltextinformationen nicht direkt modellieren. Um Text- und Diagrammstrukturen gleichzeitig zu modellieren, versuchen Forscher, Sprachmodelle und grafische neuronale Netze zu integrieren und die Parameter der beiden Modelle gleichzeitig zu aktualisieren. Vorhandene Arbeiten [2, 3] können jedoch nicht viele Nachbartexte gleichzeitig modellieren, weisen eine schlechte Skalierbarkeit auf und können nicht auf große Textdiagramme angewendet werden.

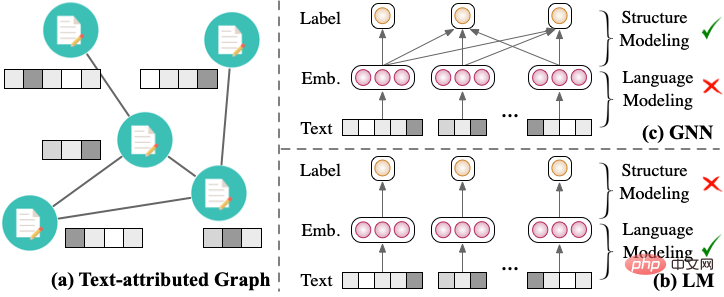

Um graphische neuronale Netze und Sprachmodelle effektiver zu integrieren, schlägt dieser Artikel das Graph und Language Learning by Expectation Maximization (GLEM) Framework vor . Das GLEM-Framework basiert auf dem Variational Expectation Maximum-Algorithmus (Variational EM) und lernt abwechselnd graphische neuronale Netze und Sprachmodelle und erreicht so eine gute Skalierbarkeit. Abbildung 2: GLEM-Framework

Sprachmodell ; Im M-Schritt trainiert GLEM ein graphisches neuronales Netzwerk basierend auf den realen Bezeichnungen und den vom Sprachmodell vorhergesagten Pseudobezeichnungen . Auf diese Weise extrahiert das GLEM-Framework effektiv lokale Textinformationen und globale strukturelle Interaktionsinformationen. Sowohl graphische neuronale Netze (GLEM-GNN) als auch Sprachmodelle (GLEM-LM), die über das GLEM-Framework trainiert wurden, können zur Vorhersage von Knotenbezeichnungen verwendet werden.

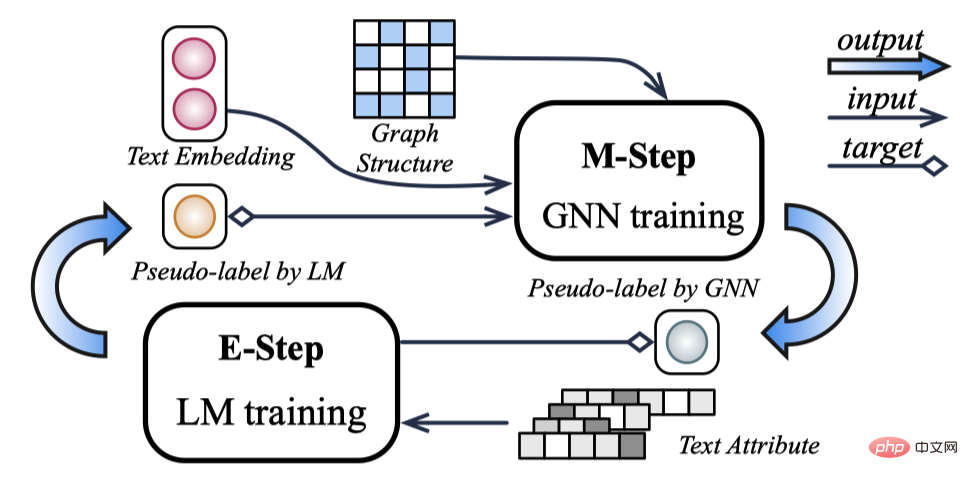

ExperimentDer experimentelle Teil des Papiers diskutiert hauptsächlich das GLEM-Framework unter folgenden Gesichtspunkten: Abbildung 3: GLEM-Framework gewann den ersten Platz im OGBN-arxiv, products, papers100M-Datensatz

Das obige ist der detaillierte Inhalt vonIntegrieren Sie effektiv Sprachmodelle, graphische neuronale Netze und das Textgraph-Trainings-Framework GLEM, um neue SOTA zu erreichen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Windows prüft den Portbelegungsstatus

Windows prüft den Portbelegungsstatus

Download-Adresse der offiziellen Website der Yiou Exchange-App

Download-Adresse der offiziellen Website der Yiou Exchange-App

Computerbildschirm zeigt kein Signal

Computerbildschirm zeigt kein Signal

Der Unterschied zwischen Java und Java

Der Unterschied zwischen Java und Java

Welche Datei ist windows.old?

Welche Datei ist windows.old?

Warum startet der Computer automatisch neu?

Warum startet der Computer automatisch neu?