ChatGPT hat eine Begeisterung für große Sprachmodelle ausgelöst. Wann kommt der GPT-Moment für einen weiteren wichtigen Bereich der KI – Vision?

Vor zwei Tagen stellte Machine Heart Metas neueste Forschungsergebnisse Segment Anything Model (SAM) vor. Diese Forschung hat in der KI-Community für breite Diskussionen gesorgt.

Soweit wir wissen, hat das Vision-Team des Intelligent Source Research Institute fast zeitgleich auch das allgemeine Segmentierungsmodell SegGPT (Segment Everything) auf den Markt gebracht Im Kontext) – Ein allgemeines visuelles Modell, das visuelle Eingabeaufforderungen verwendet, um beliebige Segmentierungsaufgaben auszuführen.

#🎜🎜 #SegGPT wurde gleichzeitig mit dem Meta AI-Bildsegmentierungs-Basismodell SAM veröffentlicht. Der Unterschied zwischen den beiden ist:

Ob „One Touch and Go“ oder „One Pass, One Hundert Connections“, Das bedeutet alles: Das Vision-Modell „versteht“ bereits die Bildstruktur. Durch die Kombination der Feinanmerkungsfunktionen von SAM und der universellen Segmentierungsannotationsfunktionen von SegGPT kann jedes Bild aus einem Pixelarray in eine visuelle Struktureinheit analysiert und jede Szene wie biologisches Sehen verstanden werden. Der Beginn der universellen visuellen GPT ist da.

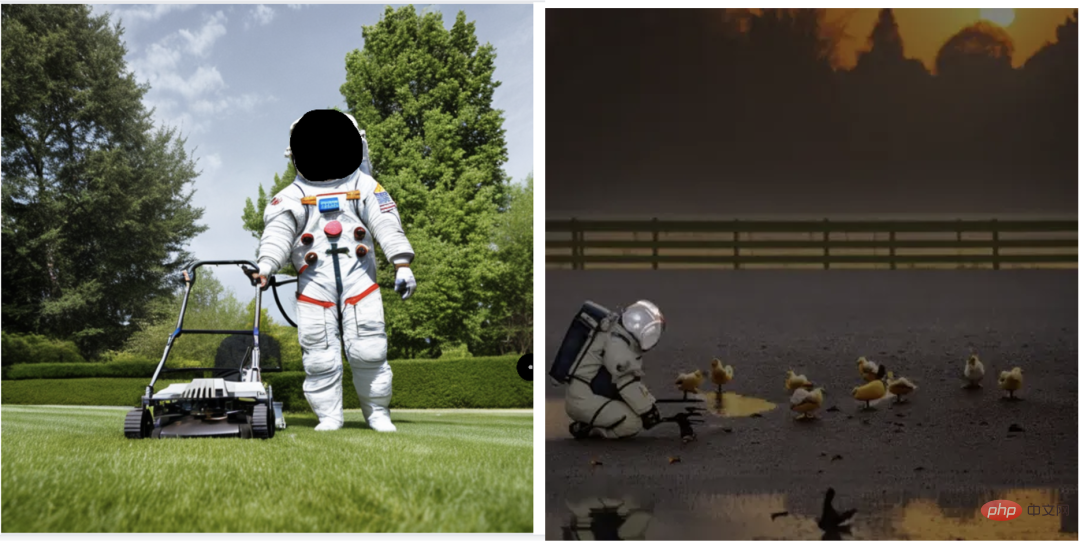

SegGPT ist ein abgeleitetes Modell des Intelligent Source General Vision Model Painter (CVPR 2023), optimiert für das Ziel, alle Objekte zu segmentieren. Nach Abschluss des SegGPT-Trainings ist keine Feinabstimmung erforderlich. Geben Sie einfach Beispiele an, um die entsprechenden Segmentierungsaufgaben automatisch zu begründen und abzuschließen, einschließlich Instanzen, Kategorien, Komponenten, Konturen, Text, Gesichtern usw. in Bildern und Videos.

Dieses Modell verfügt über die folgenden Vorteilsfähigkeiten:

1. Universelle Fähigkeit : Das Modell verfügt über kontextbezogene Argumentationsfunktionen, die auf den bereitgestellten Segmentierungsbeispielen (Eingabeaufforderung) basieren, um eine Segmentierung von „allem“ zu erreichen, einschließlich Instanzen , Kategorien, Komponenten, Konturen, Text, Gesichter, medizinische Bilder, Fernerkundungsbilder usw.

2. Flexible Denkfähigkeit: Unterstützt jede Zahleneingabe ; unterstützt abgestimmte Eingabeaufforderungen für bestimmte Szenarien; Masken unterschiedlicher Farbe können verwendet werden, um verschiedene Ziele darzustellen, um eine parallele Segmentierungsbegründung zu erreichen.

3. Automatische Videosegmentierungs- und Trackingfunktionen: Die Das erste Bild und die entsprechende Objektmaske werden als Kontextbeispiele verwendet. SegGPT kann nachfolgende Videobilder automatisch segmentieren und die Farbe der Maske als ID des Objekts verwenden, um eine automatische Verfolgung zu erreichen.

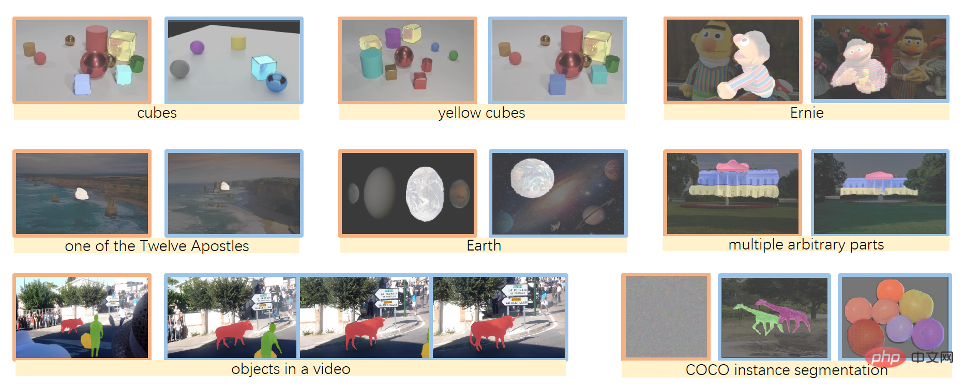

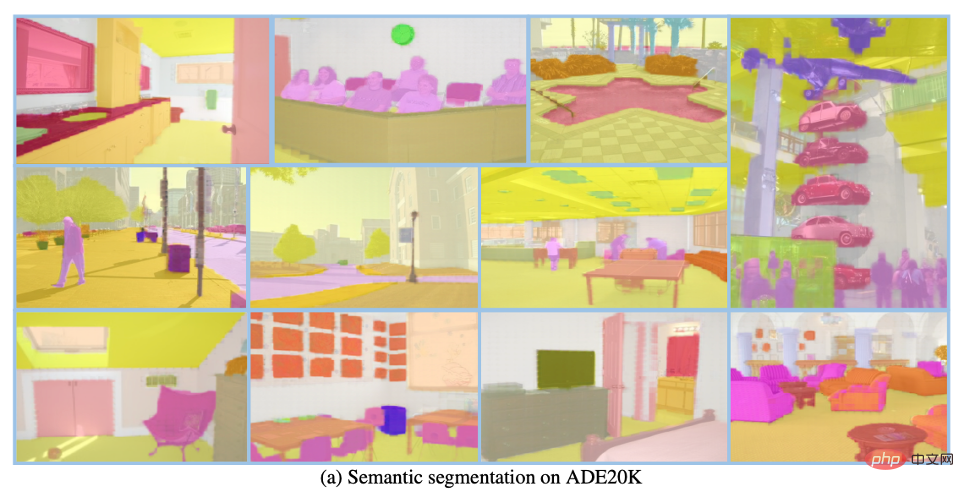

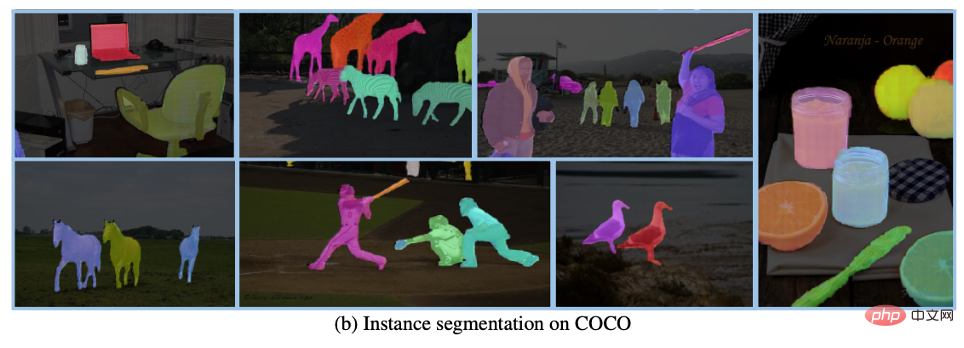

Fallpräsentation1 Der Autor bewertete SegGPT anhand einer Vielzahl von Aufgaben, einschließlich semantischer Segmentierung mit wenigen Aufnahmen, Segmentierung von Videoobjekten, Semantische Segmentierung und Panoramasegmentierung. Die folgende Abbildung zeigt speziell die Segmentierungsergebnisse von SegGPT für Instanzen, Kategorien, Komponenten, Umrisse, Text und beliebig geformte Objekte.

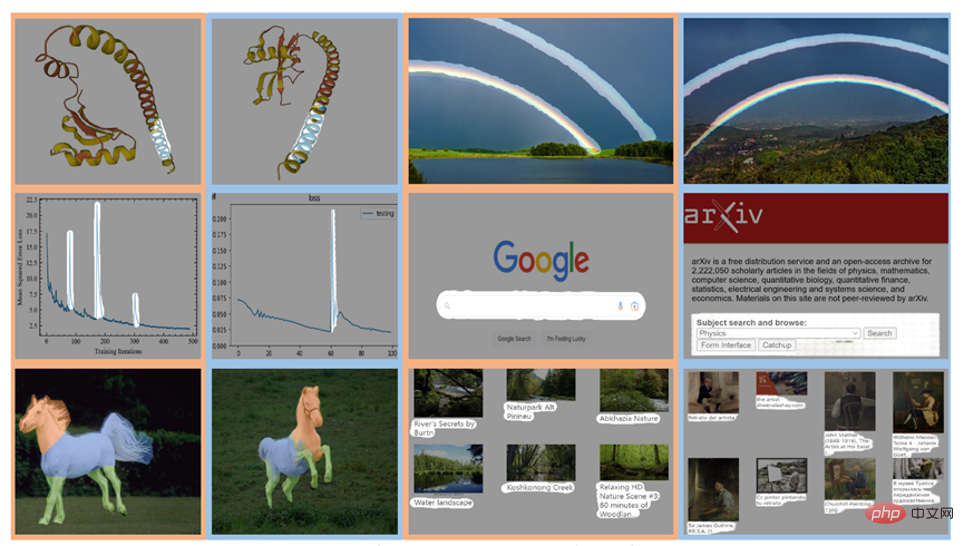

2. Markieren Sie den Regenbogen in einem Bild (Bild oben) und teilen Sie die Regenbögen stapelweise auf (Bild unten) 3. Kreisen Sie ihn mit einem Pinsel grob ein Planetenringgürtel (oberes Bild) und geben Sie den Planetenringgürtel im Zielbild (unteres Bild) in der Vorhersagekarte genau aus.

Trainingsmethode

SegGPT vereint verschiedene Segmentierungsaufgaben in einem gemeinsamen Kontext-Lernrahmen und vereinheitlicht verschiedene Datenformen durch Konvertieren verschiedener Segmentierungsdaten in Bilder desselben Formats.

Testzeittechniken

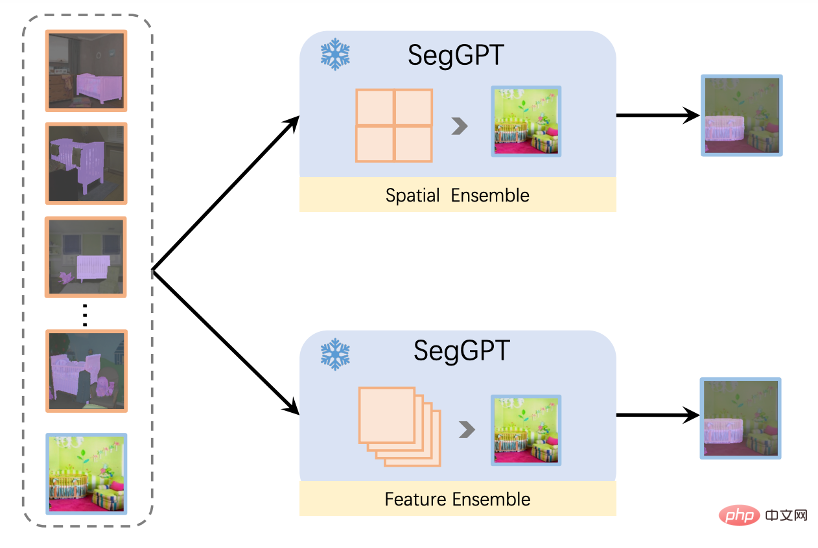

Wie man durch Testzeittechniken verschiedene Fähigkeiten freischaltet, ist ein Highlight des universellen Modells. Das SegGPT-Papier schlägt mehrere Technologien vor, um verschiedene Segmentierungsfunktionen freizuschalten und zu verbessern, wie beispielsweise die verschiedenen Kontext-Ensemble-Methoden, die in der folgenden Abbildung dargestellt sind. Die vorgeschlagene Feature-Ensemble-Methode kann eine beliebige Anzahl von Eingabeaufforderungsbeispielen unterstützen, um einen benutzerfreundlichen Argumentationseffekt zu erzielen.

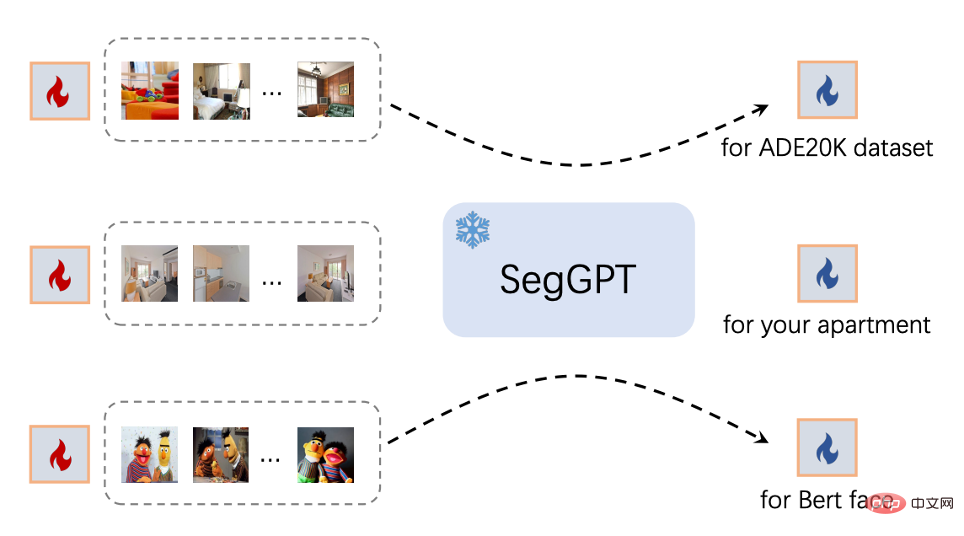

Darüber hinaus unterstützt SegGPT auch dedizierte Eingabeaufforderungen, die für bestimmte Szenarien optimiert sind. Für gezielte Nutzungsszenarien kann SegGPT durch Prompt-Tuning entsprechende Eingabeaufforderungen erhalten, ohne die Modellparameter an bestimmte Szenarien anzupassen. Erstellen Sie beispielsweise automatisch eine entsprechende Eingabeaufforderung für einen bestimmten Datensatz oder eine dedizierte Eingabeaufforderung für einen Raum. Wie in der folgenden Abbildung dargestellt:

Ergebnisanzeige

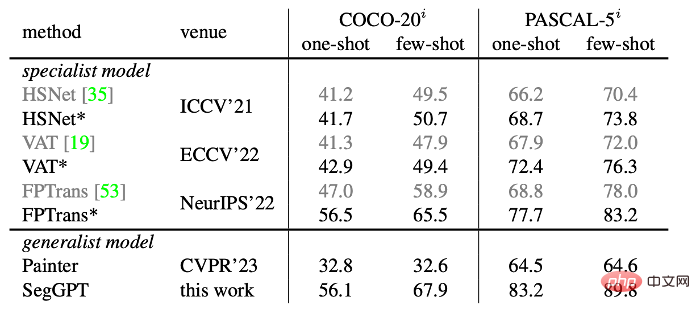

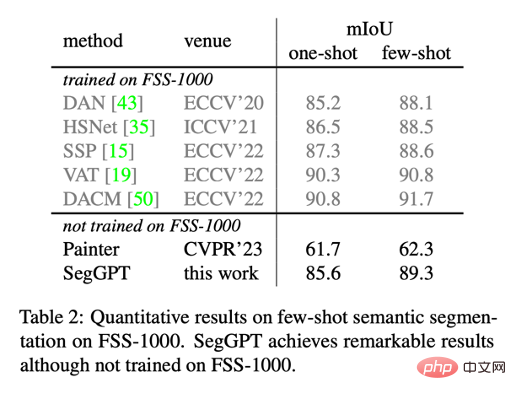

Das Modell erfordert nur wenige sofortige Beispiele und erzielt eine optimale Leistung bei den COCO- und PASCAL-Datensätzen. SegGPT weist starke Zero-Shot-Szenenübertragungsfähigkeiten auf, wie z. B. das Erreichen modernster Leistung auf dem semantischen Segmentierungstestset FSS-1000 mit wenigen Aufnahmen ohne Training.

Das Folgende ist eine Demonstration der Auswirkung einer abgestimmten Eingabeaufforderung auf semantische Segmentierungs- und Instanzsegmentierungsaufgaben:

Das obige ist der detaillierte Inhalt vonKommt der GPT-Moment der universellen Vision? Zhiyuan führt das universelle Segmentierungsmodell SegGPT ein. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So kündigen Sie die automatische Verlängerung bei Station B

So kündigen Sie die automatische Verlängerung bei Station B

Computer-Anwendungsbereiche

Computer-Anwendungsbereiche

Verwendung der Sortierfunktion sortieren

Verwendung der Sortierfunktion sortieren

Was passiert, wenn phpmyadmin nicht darauf zugreifen kann?

Was passiert, wenn phpmyadmin nicht darauf zugreifen kann?

Der Unterschied zwischen Unix und Linux

Der Unterschied zwischen Unix und Linux

Sortierfunktion Python-Nutzung

Sortierfunktion Python-Nutzung

So kehren Sie von einer HTML-Unterseite zur Startseite zurück

So kehren Sie von einer HTML-Unterseite zur Startseite zurück

Software zur Website-Erstellung

Software zur Website-Erstellung