Selbstüberwachtes Lernen ermöglicht es Computern, die Welt zu beobachten und zu verstehen, indem sie die Struktur von Bildern, Sprache oder Text lernen. Dies hat viele der jüngsten großen Fortschritte in der künstlichen Intelligenz vorangetrieben.

Während wissenschaftliche Forscher weltweit große Anstrengungen in diesem Bereich unternehmen, gibt es derzeit große Unterschiede in der Art und Weise, wie selbstüberwachte Lernalgorithmen aus Bildern, Sprache, Text und anderen Modalitäten lernen. Daher stellt das Forum für künstliche Intelligenz Analytics India Magazine den Lesern die zehn besten selbstüberwachten Lernmodelle im Jahr 2022 vor.

Papierlink: https://arxiv.org/pdf/2202.03555.pdf

Offener Quellcode: https://t.co/3x8VCwGI2x pic.twitter.com/Q9TNDg1paj

Meta AI hat im Januar den data2vec-Algorithmus für sprach-, bild- und textbezogene Computer-Vision-Modelle veröffentlicht. Nach Angaben des KI-Teams ist das Modell bei NLP-Aufgaben äußerst wettbewerbsfähig.

Es wird kein kontrastives Lernen oder eine Rekonstruktion verwendet, die auf Eingabebeispielen basiert. Das Meta AI-Team gab an, dass die Trainingsmethode von data2vec darin besteht, das Vorhersagemodell durch die Bereitstellung einer Teilansicht der Eingabedaten darzustellen.

Das Team sagte: „Wir kodieren zunächst die maskierten Trainingsbeispiele im Schülermodell. Anschließend kodieren wir im selben Modell die unmaskierten Eingabebeispiele, um das Trainingsziel zu erstellen. Dieses Modell (Lehrermodell) und das Schülermodell.“ unterscheiden sich nur in den Parametern. Dadurch entfällt die Abhängigkeit von modalitätsspezifischen Zielen in der Lernaufgabe. „ConvNext“ ext wird auch aufgerufen Das ConvNet-Modell für die 2020er Jahre ist ein Modell, das im März vom Meta AI-Team veröffentlicht wurde. Es basiert vollständig auf den Modulen von ConvNet und ist daher präzise, einfach im Design und skalierbar. ?? Invarianz Kovarianz Regularisierung (VICReg) kombiniert Varianzterme und einen Dekorrelationsmechanismus, der auf Redundanzreduktion mit Kovarianzregularisierung basiert, um den Zusammenbruch des Encoders zu vermeiden, der konstante oder nicht informative Vektoren erzeugt.

VICReg erfordert keine Techniken wie Gewichtsverteilung zwischen Zweigen, Batch-Normalisierung, Merkmalsnormalisierung, Ausgabequantisierung, Stoppgradienten, Speicherbänke usw. und erzielt bei mehreren Ergebnissen vergleichbare Ergebnisse mit dem Stand der Technik nachgelagerte Aufgaben. Darüber hinaus wurde experimentell gezeigt, dass der Varianz-Regularisierungsterm das Training anderer Methoden stabilisieren und Leistungsverbesserungen fördern kann.

Link zum Papier: https://arxiv.org/abs/2203.08414

Entwickelt vom Computer Science and Artificial Intelligence Laboratory des MIT in Zusammenarbeit mit Microsoft und der Cornell University. Selbstüberwachte Transformatoren für Energie -basierte Graphoptimierung (STEGO) lösen eine der schwierigsten Aufgaben in der Bildverarbeitung: die Zuweisung von Beschriftungen zu jedem Pixel eines Bildes ohne menschliche Aufsicht.

STEGO hat die „semantische Segmentierung“ gelernt – einfach ausgedrückt: jedem Pixel im Bild eine Beschriftung zuweisen.Semantische Segmentierung ist eine wichtige Fähigkeit für heutige Computer-Vision-Systeme, da Bilder durch Objekte gestört werden können. Erschwerend kommt hinzu, dass diese Objekte nicht immer in das Textfeld passen. Algorithmen eignen sich oft besser für diskrete „Dinge“ wie Menschen und Autos als für schwer zu quantifizierende Dinge wie Vegetation, den Himmel und Kartoffelpüree.

Nehmen Sie als Beispiel die Szene mit spielenden Hunden im Park. Frühere Systeme konnten möglicherweise nur Hunde identifizieren, aber durch die Zuweisung einer Beschriftung zu jedem Pixel des Bildes kann STEGO das Bild in mehrere Pixel zerlegen Hauptbestandteile: Hund, Himmel, Gras und sein Besitzer.

Maschinen, die „die Welt sehen“ können, sind für eine Vielzahl neuer Technologien wie selbstfahrende Autos und Vorhersagemodelle für die medizinische Diagnose von entscheidender Bedeutung. Da STEGO ohne Etiketten lernen kann, kann es Objekte in verschiedenen Bereichen erkennen, sogar Objekte, die Menschen noch nicht vollständig verstehen.

Papierlink: https: //arxiv.org/pdf/2210.04062.pdf

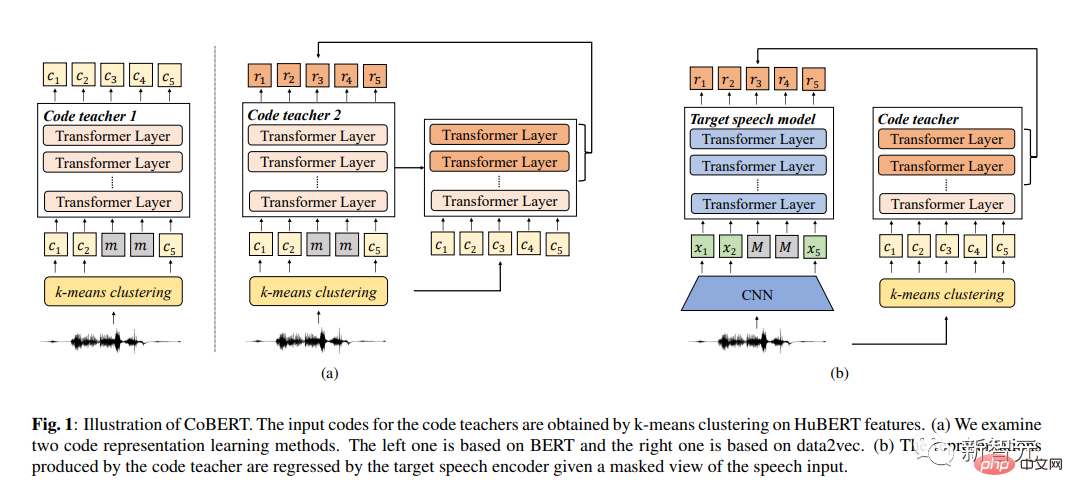

Für das selbstüberwachte Lernen der Sprachdarstellung schlugen Forscher der Chinesischen Universität Hongkong (Shenzhen) den Code BERT (CoBERT) vor. Im Gegensatz zu anderen Selbstdestillationsmethoden sagt ihr Modell Darstellungen aus verschiedenen Modalitäten voraus. Das Modell wandelt Sprache in eine Folge diskreter Codes für das Repräsentationslernen um.

Zunächst nutzte das Forschungsteam das vorab trainierte Codemodell von HuBERT, um im diskreten Raum zu trainieren. Anschließend verfeinerten sie das Codemodell zu einem Sprachmodell mit dem Ziel, ein besseres Lernen über alle Modalitäten hinweg zu ermöglichen. Die deutliche Verbesserung gegenüber der ST-Aufgabe lässt darauf schließen, dass die Darstellungen von CoBERT möglicherweise mehr sprachliche Informationen enthalten als frühere Arbeiten.

CoBERT übertrifft die Leistung modernster Algorithmen bei ASR-Aufgaben und bringt erhebliche Verbesserungen bei der SUPERB Speech Translation (ST)-Aufgabe.

Papierlink: https: //arxiv.org/abs/2207.09158

FedX ist ein unbeaufsichtigtes föderiertes Lernframework, das von Microsoft in Zusammenarbeit mit der Tsinghua-Universität und dem Korea Advanced Institute of Science and Technology eingeführt wurde. Durch lokale und globale Wissensextraktion und vergleichendes Lernen lernt der Algorithmus unverzerrte Darstellungen aus diskreten und heterogenen lokalen Daten. Darüber hinaus handelt es sich um einen anpassbaren Algorithmus, der als Zusatzmodul zu verschiedenen bestehenden selbstüberwachten Algorithmen in föderierten Lernszenarien verwendet werden kann.

Papierlink: https: //arxiv.org/pdf/2206.03012.pdf

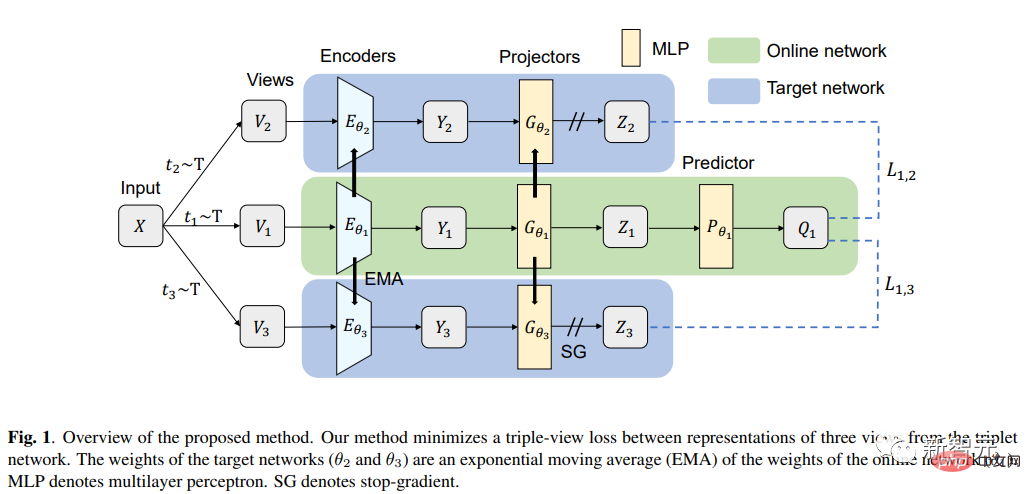

Die Hokkaido-Universität in Japan schlug TriBYOL für selbstüberwachtes Repräsentationslernen in kleinen Mengen vor. Bei diesem Modell benötigen Forscher keine großen Mengen an Rechenressourcen, um gute Darstellungen zu lernen. Dieses Modell verfügt über eine Triplett-Netzwerkstruktur und kombiniert einen Drei-Ansichts-Verlust, wodurch die Effizienz bei mehreren Datensätzen verbessert und mehrere selbstüberwachte Algorithmen übertroffen werden.

Papierlink: https://arxiv.org/pdf/2207.10023.pdf# 🎜🎜#

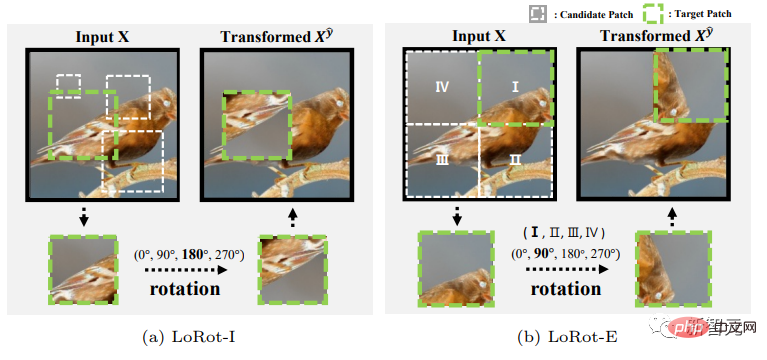

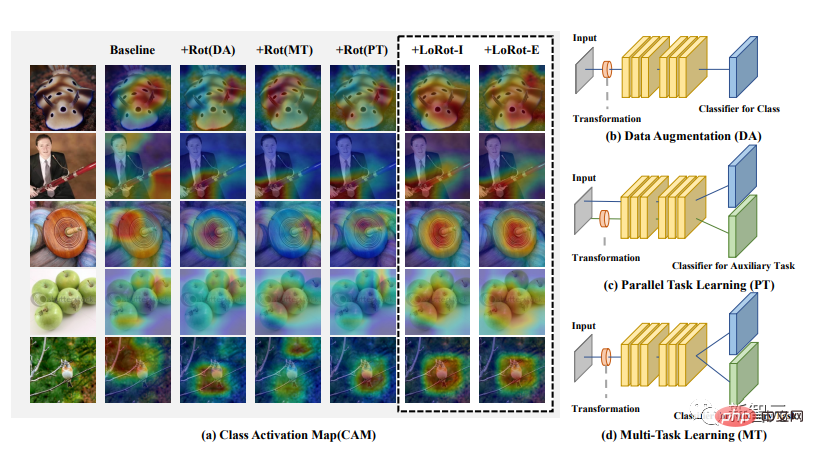

Das Forschungsteam der Sungkyunkwan-Universität schlug eine einfache selbstüberwachte Hilfsaufgabe vor, die lokalisierbare Rotationen (LoRot) mit drei Attributen vorhersagt, um das Überwachungsziel zu unterstützen.

Papierlink: https://arxiv.org/pdf/2106.10466.pdf

Microsoft und die Peking-Universität haben ein allgemeines Lernframework TS2Vec für das Lernen auf jeder semantischen Ebene vorgeschlagen Zeitreihen. Das Modell führt kontrastives Lernen in einer hierarchischen Technik in einer erweiterten Kontextansicht durch und bietet so eine starke Kontextdarstellung für einzelne Zeitstempel.

Referenz:

Das obige ist der detaillierte Inhalt von2022 Top10 selbstüberwachte Lernmodelle veröffentlicht! Acht Erfolge der USA und Chinas dominieren die Liste. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Computersprachen

Computersprachen

Algorithmus zum Ersetzen von Seiten

Algorithmus zum Ersetzen von Seiten

Computer-Anwendungsbereiche

Computer-Anwendungsbereiche

Welche Kodierung wird in einem Computer zur Verarbeitung von Daten und Anweisungen verwendet?

Welche Kodierung wird in einem Computer zur Verarbeitung von Daten und Anweisungen verwendet?

Der Hauptgrund, warum Computer Binärdateien verwenden

Der Hauptgrund, warum Computer Binärdateien verwenden

Was sind die Hauptmerkmale von Computern?

Was sind die Hauptmerkmale von Computern?

Was sind die Grundkomponenten eines Computers?

Was sind die Grundkomponenten eines Computers?

Auf welche Tasten beziehen sich Pfeile in Computern?

Auf welche Tasten beziehen sich Pfeile in Computern?