Vor kurzem hat OpenAI, das GPT scheinbar hinter sich gelassen hat, ein neues Leben begonnen.

Nach dem Training mit riesigen unbeschrifteten Videos und ein paar beschrifteten Daten lernte die KI endlich, in Minecraft Diamantspitzhacken herzustellen.

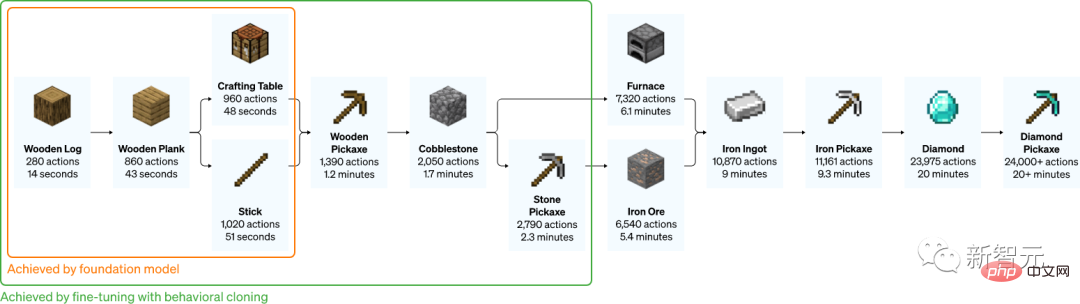

Der gesamte Vorgang dauert für einen Hardcore-Spieler mindestens 20 Minuten und erfordert insgesamt 24.000 Operationen.

Diese Sache scheint einfach zu sein, ist aber für KI sehr schwierig.

Ein 7-jähriges Kind kann es in nur 10 Minuten lernen

Bei der einfachsten Holzspitzhacke ist es für menschliche Spieler nicht allzu schwierig, sie von Grund auf zu lernen.

Mit einem einzigen Video kann ein Geek den nächsten in weniger als 3 Minuten unterrichten.

Das Demonstrationsvideo ist 2 Minuten und 52 Sekunden lang

Allerdings ist die Herstellung eines Diamantpicks viel komplizierter.

Aber auch so kann ein 7-jähriges Kind es lernen, nachdem es sich nur ein zehnminütiges Demonstrationsvideo angesehen hat.

Die Schwierigkeit dieser Mission besteht hauptsächlich darin, wie man die Diamantenmine gräbt.

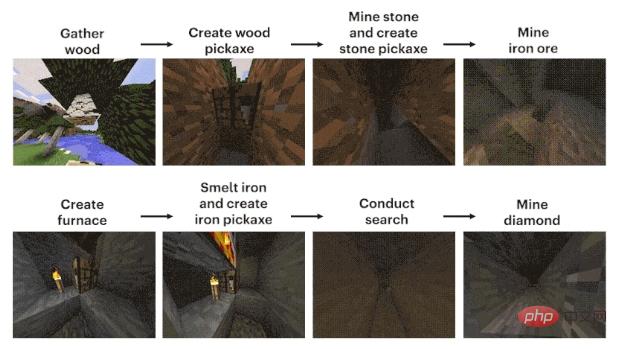

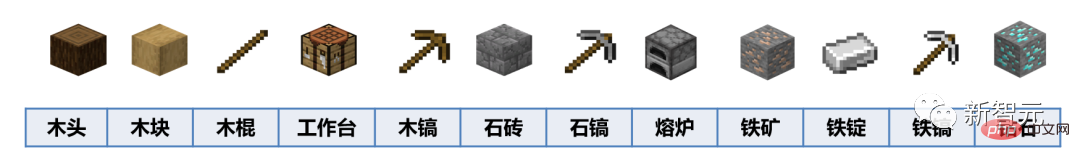

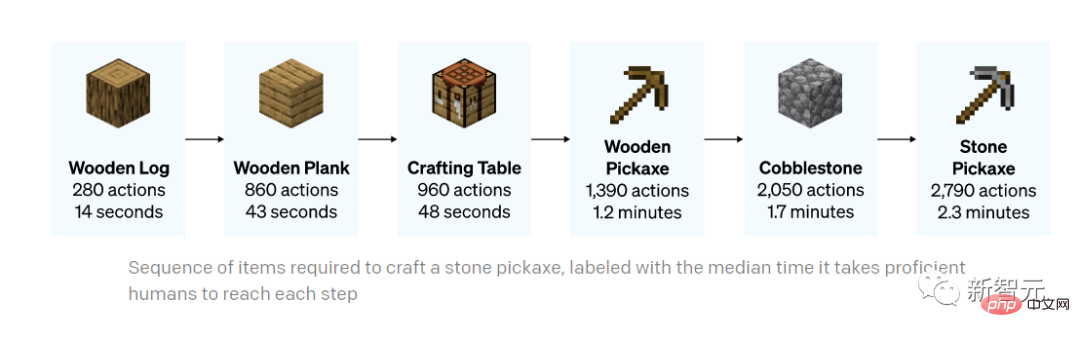

Der Prozess lässt sich grob in 12 Schritte zusammenfassen: Zuerst den Pixelblock „Holz“ mit bloßen Händen planen, dann die Holzblöcke aus den Baumstämmen synthetisieren, aus den Holzblöcken Holzstäbe herstellen, die Holzstäbe dazu verwenden Stellen Sie den Werkstattausrüstungstisch her und verwenden Sie die Werkbank, um Holzhacken herzustellen. Verwenden Sie eine Holzspitzhacke, um Steine zu schlagen, fügen Sie Steine zu Holzstöcken hinzu, um eine Steinspitzhacke herzustellen, und verwenden Sie eine Steinspitzhacke, um einen Ofen zu bauen. Der Ofen verarbeitet Eisenerz Eisenerz schmilzt zu Eisenbarren, aus den Eisenbarren werden Eisenspitzhacken hergestellt und mit den Eisenspitzhacken werden Diamanten gegraben.

Jetzt liegt der Druck auf der KI-Seite.

Zufälligerweise haben CMU, OpenAI, DeepMind, Microsoft Research und andere Institutionen seit 2019 einen entsprechenden Wettbewerb gestartet – MineRL.

Die Teilnehmer müssen einen Agenten für künstliche Intelligenz entwickeln, der „Werkzeuge von Grund auf bauen und automatisch Diamantenminen finden und abbauen kann“ – der Schnellste gewinnt.

Was war das Ergebnis?

Nach dem ersten MineRL-Wettbewerb „lernte ein 7-jähriges Kind es, nachdem es sich ein 10-minütiges Video angesehen hatte, aber die KI konnte es nach 8 Millionen Schritten immer noch nicht herausfinden.“ veröffentlicht im Nature-Magazin.

Als Sandbox-Konstruktionsspiel eignet sich „Minecraft“ aufgrund seiner hohen Offenheit der Spielerstrategien besonders für das Lernen und Treffen verschiedener KI-Modelle Virtuelle Umgebung im Spiel. Ein Testgelände und Prüfstein für Fähigkeiten.

Und da es sich um ein Spiel auf „nationaler Ebene“ handelt, ist es einfach, online Videos zu „Minecraft“ zu finden.

Aber egal, ob es darum geht, ein Tutorial zu erstellen oder Ihre eigene Arbeit vorzuführen, in gewisser Weise ist es nur das Ergebnis, das auf dem Bildschirm angezeigt wird.

Mit anderen Worten, die Leute, die sich das Video ansehen, können nur wissen, was der Spitzenreiter getan hat und wie er es getan hat, aber sie haben keine Möglichkeit zu wissen, wie er es getan hat.

Genauer gesagt ist das, was auf dem Computerbildschirm angezeigt wird, nur das Ergebnis, und die Bedienschritte sind das ständige Klicken des Besitzers auf der Tastatur und die ständige Bewegung der Maus. Dieser Teil ist nicht sichtbar.

Sogar dieser Prozess wurde bearbeitet, und die Leute können ihn wahrscheinlich nicht lernen, nachdem sie ihn gesehen haben, geschweige denn KI.

Erschwerend kommt hinzu, dass sich viele Spieler darüber beschweren, dass das Hobeln von Holz im Spiel langweilig ist und zu sehr dem Erledigen von Hausaufgaben und dem Erledigen von Aufgaben ähnelt. Infolgedessen gibt es nach einer Welle von Updates viele Tools, die kostenlos erworben werden können ... Jetzt sind selbst die Daten schwer zu finden.

Wenn OpenAI KI lernen lassen möchte, „Minecraft“ zu spielen, muss es einen Weg finden, diese riesigen, unbeschrifteten Videodaten zu nutzen.

So entstand VPT.

Papieradresse: https://cdn.openai.com/vpt /Paper.pdf

Diese Sache ist neu, aber nicht kompliziert. Es handelt sich um eine halbüberwachte Nachahmungslernmethode.

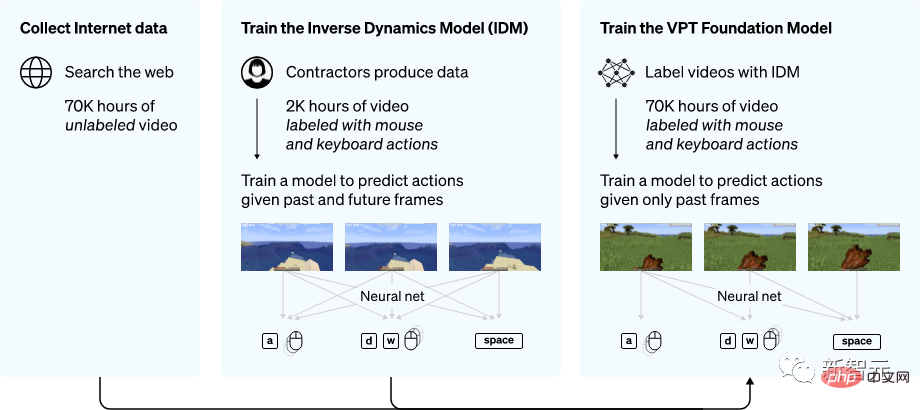

Erfassen Sie zunächst eine Datenwelle, um die Daten von Outsourcern zu kommentieren, die Spiele spielen, einschließlich Video- und Tastatur- und Mausbedienungsaufzeichnungen.

VPT-Methodenübersicht

#🎜 🎜 #Anschließend verwendeten die Forscher diese Daten, um ein inverses Dynamikmodell (IDM) zu erstellen, das vorhersagen kann, wie sich Tastatur und Maus bei jedem Schritt im Video bewegen.

Auf diese Weise wird die gesamte Aufgabe viel einfacher und es werden nur viel weniger Daten benötigt, um den Zweck zu erreichen.

Nachdem Sie IDM mit einer kleinen Menge ausgelagerter Daten abgeschlossen haben, können Sie IDM verwenden, um größere, unbeschriftete Datensätze zu kennzeichnen.

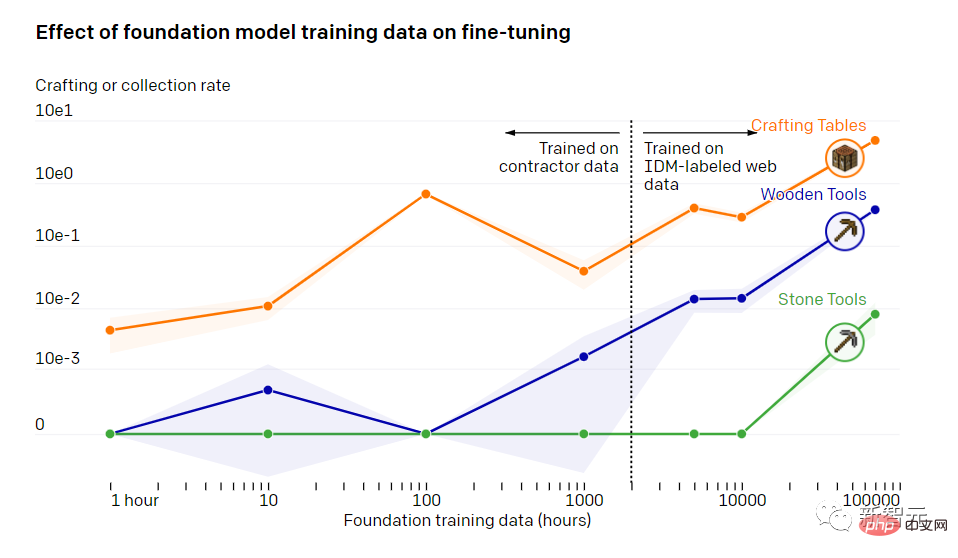

Der Einfluss grundlegender Modelltrainingsdaten auf die Feinabstimmung#🎜🎜 ##🎜 🎜#Nach 70.000 Trainingsstunden kann das Verhaltensklonmodell von OpenAI verschiedene Aufgaben erfüllen, die andere Modelle nicht erfüllen können.

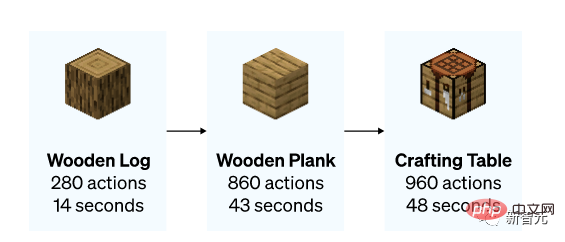

Das Modell lernte, wie man Bäume fällt und Holz sammelt, wie man aus Holz Holzleisten herstellt und wie man aus Holzleisten Tische herstellt. Diese Dinge erfordern, dass ein relativ erfahrener Spieler weniger als 50 Sekunden lang agiert.

Das Modell ist nicht nur ein Tisch, sondern kann auch schwimmen, jagen und essen.

Das Modell ist nicht nur ein Tisch, sondern kann auch schwimmen, jagen und essen.

Es gibt sogar eine coole Operation „Laufen, Springen und Bauen“, das heißt, wenn Sie abheben, legen Sie einen Ziegel- oder Holzblock unter Ihre Füße und Sie können ein Gebäude bauen, indem Sie auf eine Säule springen. Dies ist ein Pflichtkurs für Hardcore-Spieler.

Erstellen einer Tabelle (0 Schuss)

Jagd (0 Schuss)

Einfache Version „Laufen und Springen“ (0 Schuss)

Für Damit das Modell einige detailliertere Aufgaben ausführen kann, wird der Datensatz im Allgemeinen auf eine kleinere Größe abgestimmt und unterscheidet kleine Richtungen.

OpenAI hat eine Studie durchgeführt, die zeigte, wie gut sich ein mit VPT trainiertes Modell nach einer Feinabstimmung an nachgelagerte Datensätze anpassen kann.

Die Forscher luden Menschen ein, 10 Minuten lang „Minecraft“ zu spielen und aus einfachen Materialien ein Haus zu bauen. Sie hoffen, dass sie auf diese Weise die Fähigkeit des Modells verbessern können, einige Aufgaben zu Beginn des Spiels auszuführen, beispielsweise den Bau einer Werkbank.

Nach der Feinabstimmung des Datensatzes stellten die Forscher nicht nur fest, dass das Modell die anfänglichen Aufgaben effizienter erledigte, sondern auch, dass das Modell selbst wusste, wie man eine Holzwerkbank und eine Holzwerkbank aus Stein herstellt .

Manchmal können Forscher auch sehen, wie das Modell in Eigenregie einen einfachen Unterschlupf baut, das Dorf durchsucht und Kisten plündert.

Der gesamte Prozess der Herstellung eines Steinpickels (die unten angegebene Zeit ist die Zeit, die ein erfahrener Spieler benötigt, um dieselbe Aufgabe auszuführen)

Herstellung eines Steinpickels

Dann schauen wir uns an, wie OpenAI-Experten es verfeinert haben.

Die Methode, die sie verwenden, ist Reinforcement Learning (RL).

Die meisten RL-Methoden gehen diese Herausforderungen an, indem sie Prioritäten stochastisch untersuchen, d. h. Modelle werden oft dazu angeregt, zufällige Aktionen durch Entropie zu belohnen. Das VPT-Modell sollte ein besseres Vorgängermodell für RL sein, da die Simulation menschlichen Verhaltens möglicherweise hilfreicher ist als das Ergreifen zufälliger Aktionen.

Die Forscher haben das Modell für die schwierige Aufgabe des Sammelns von Diamantspitzhacken eingerichtet, eine Funktion, die es in Minecraft noch nie gegeben hat, da die Ausführung der gesamten Aufgabe bei Verwendung der nativen Mensch-Maschine-Schnittstelle viel schwieriger ist.

Die Herstellung einer Diamantspitzhacke erfordert eine lange und komplexe Reihe von Unteraufgaben. Um diese Aufgabe beherrschbar zu machen, belohnten die Forscher den Agenten für jedes Element in der Sequenz.

Sie fanden heraus, dass eine RL-Richtlinie, die durch zufällige Initialisierung trainiert wurde (Standard-RL-Ansatz), fast keine Belohnung erhielt, nie lernte, Protokolle zu sammeln, und selten Stöcke sammelte.

Im krassen Gegensatz dazu wurde das VPT-Modell so optimiert, dass es nicht nur lernte, wie man eine Diamantspitzhacke herstellt, sondern auch beim Sammeln aller Gegenstände Erfolge auf menschlicher Ebene erzielte.

Und dies ist das erste Mal, dass jemand in „Minecraft“ ein Computermodell zeigt, mit dem Diamantwerkzeuge hergestellt werden können.

Das obige ist der detaillierte Inhalt vonSchockiert! Nach 70.000 Trainingsstunden lernte das Modell von OpenAI, Holz in „Minecraft' zu planen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

PHP-Tutorial

PHP-Tutorial

Plugin.exe-Anwendungsfehler

Plugin.exe-Anwendungsfehler

Orakel-Kobold

Orakel-Kobold

Welche Methoden gibt es, um eine Operatorüberladung in der Go-Sprache zu implementieren?

Welche Methoden gibt es, um eine Operatorüberladung in der Go-Sprache zu implementieren?

So konfigurieren Sie die Pycharm-Umgebung

So konfigurieren Sie die Pycharm-Umgebung

Wie schreibe ich ein Dreieck in CSS?

Wie schreibe ich ein Dreieck in CSS?

So stellen Sie den automatischen Zeilenumbruch in Word ein

So stellen Sie den automatischen Zeilenumbruch in Word ein

Der Unterschied zwischen Master und Host

Der Unterschied zwischen Master und Host