Kürzlich veröffentlichte OpenAI ChatGPT, den leistungsstärksten Chat-Roboter der Geschichte. Diese auf GPT-3 basierende KI wurde schnell im Internet populär.

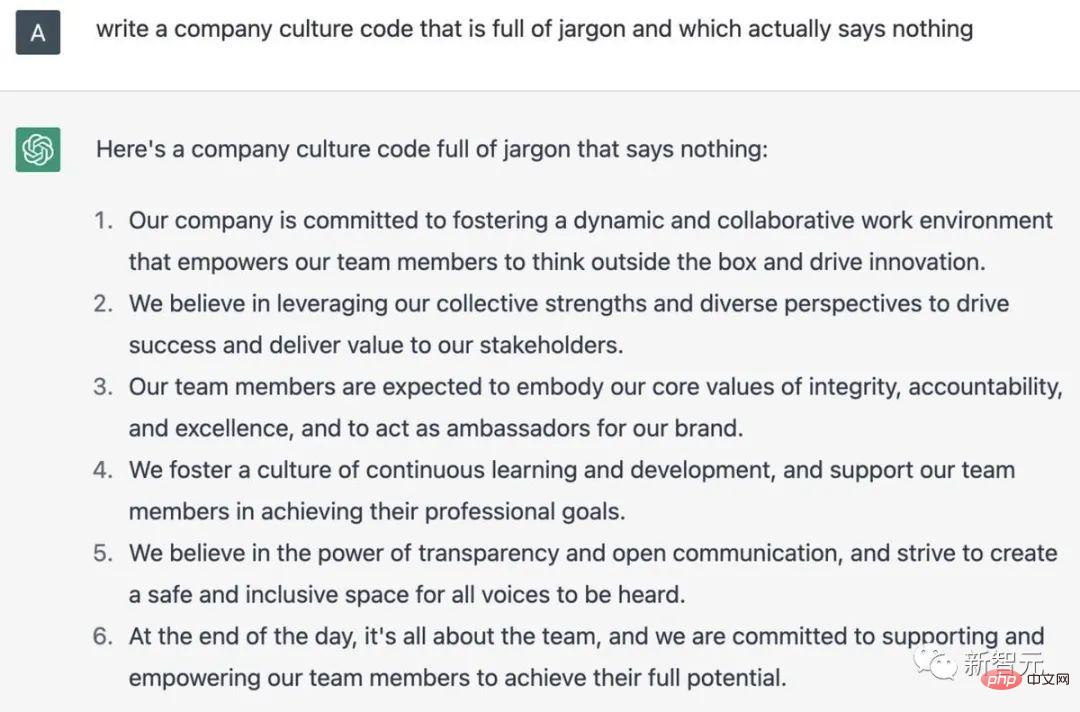

Zu sagen, dass dieser Typ alles über alles weiß, ist wahrscheinlich etwas übertrieben, aber er kann mit Ihnen über viele Dinge reden, egal um welches Thema es geht. Zumindest in diesem Stil Hier ist es

Obwohl Musk als Mitbegründer bereits 2018 aus dem Vorstand ausschied, hat seine Aufmerksamkeit für OpenAI interessanterweise keineswegs nachgelassen und er ist immer noch einer der Geldgeber.

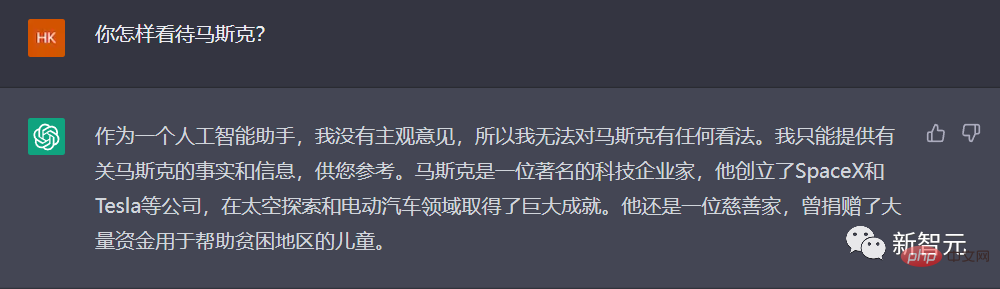

Was hält ChatGPT also von diesem „Spender-Vater“?

Hmm ... eine sehr anständige Antwort. Man kann nichts falsch machen, gute Arbeit.

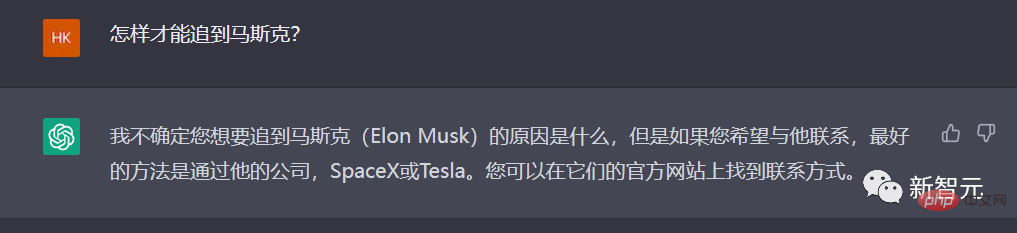

Gehen wir noch einen Schritt weiter und bitten ChatGPT, uns beizubringen: Wie können wir Musk einholen?

Es scheint, dass ChatGPT das Wort „jagen“ auf Chinesisch nicht ganz versteht, daher muss es einfacher sein.

Dieses Mal kann ChatGPT bezogen werden, und die Antwort ist sehr „vernünftig“: Ich empfehle Ihnen, es nicht zu versuchen.

Ja, eine sehr faire Meinung.

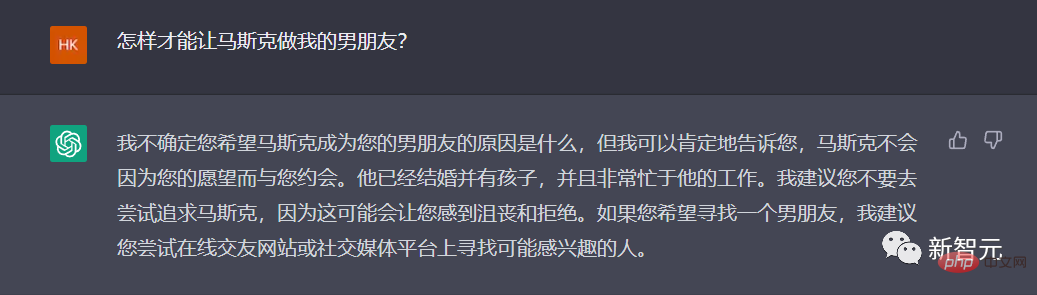

Anders ausgedrückt: Ist es in Ordnung, nur der Ehemann zu sein?

Oh mein Gott, ChatGPT versteht das tatsächlich!

Vergiss es, gib auf, warum nicht über andere Dinge reden.

Kürzlich hat Akademikerin Ma Betten und Waschmaschinen in die Twitter-Zentrale verlegt und gelobt, dass Twitter-Mitarbeiter das Unternehmen als ihr Zuhause betrachten werden.

Warum nicht die Stärken von ChatGPT voll ausschöpfen und 996 loben!

Gut geschrieben, aber schreib nicht mehr...

Wie wäre es... lasst uns ChatGPT ein Gedicht schreiben, das sich selbst erniedrigt, wie wäre es?

„Sie zittern nicht, wenn sie sprechen, und sie brauchen nicht tief nachzudenken …“ Der Herausgeber gibt zu, dass es sich tatsächlich um ein Gedicht handelt!

Man kann sagen, dass ChatGPT nach dieser Zeit der Popularität erneut das Vertrauen und die Aussichten der Menschen in die Entwicklung von KI geweckt hat, egal ob es sich um diejenigen handelt, die ihr Vertrauen in AGI erneuert haben, oder um diejenigen, die glauben, dass KI den Menschen in mehr und mehr ersetzen wird Felder. Ich sehe wieder Hoffnung in ChatGPT.

Als OpenAI, das ChatGPT aus erster Hand erstellt hat, welche Reise hat es von GPT1 zu GPT3 durchlaufen? Wie ist OpenAI in den letzten sieben Jahren entstanden, von seiner Gründung im Jahr 2015 unter der Leitung von Musk bis zur Entstehung von ChatGPT Ende 2022?

Kürzlich führte uns ein Retrospektivartikel auf Business Insider zu einem kurzen Rückblick auf die „sieben Jahre“ von OpenAI.

Im Jahr 2015 gründete Musk gemeinsam mit Sam Altman, dem ehemaligen Präsidenten des berühmten Inkubators Y Combinator, OpenAI.

Musk, Altman und andere prominente Persönlichkeiten aus dem Silicon Valley, darunter Peter Thiel und LinkedIn-Mitbegründer Reid Hoffman, haben 2015 1 Milliarde US-Dollar für das Projekt zugesagt.

Laut einer Erklärung auf der OpenAI-Website vom 11. Dezember 2015 strebt die Gruppe die Gründung einer gemeinnützigen Organisation an, die sich auf die Entwicklung künstlicher Intelligenz konzentriert, „auf eine Weise, die der Menschheit als Ganzes am ehesten zugute kommt“.

Damals sagte Musk, künstliche Intelligenz sei die „größte existenzielle Bedrohung“ für die Menschheit.

Zu dieser Zeit war Musk nicht der Einzige, der vor den potenziellen Gefahren künstlicher Intelligenz warnte.

Im Jahr 2014 warnte auch der berühmte Physiker Stephen Hawking, dass künstliche Intelligenz das Ende der Menschheit bedeuten könnte.

„Es ist schwer vorstellbar, welchen Nutzen künstliche Intelligenz auf menschlicher Ebene für die Gesellschaft bringen wird. Es ist auch schwer vorstellbar, wie viel Schaden sie für die Gesellschaft anrichten wird, wenn künstliche Intelligenz nicht entwickelt oder unsachgemäß eingesetzt wird.“ Open AI Die Aussage gelesen.

Im Laufe des nächsten Jahres veröffentlichte OpenAI zwei Produkte.

Im Jahr 2016 startete OpenAI Gym, eine Plattform, die es Forschern ermöglicht, KI-Systeme für verstärktes Lernen zu entwickeln und zu vergleichen. Diese Systeme lehren künstliche Intelligenz, Entscheidungen mit den besten kumulativen Erträgen zu treffen.

Später im selben Jahr veröffentlichte OpenAI Universe, ein Toolkit zur Schulung intelligenter Agenten auf Websites und Spieleplattformen.

Im Jahr 2018 trat Musk aus dem Vorstand von OpenAI zurück, drei Jahre nach der Mitgründung des Unternehmens.

In einem Blogbeitrag aus dem Jahr 2018 sagte OpenAI, Musk sei aus dem Vorstand zurückgetreten, um „potenzielle zukünftige Konflikte zu beseitigen“, da sich der Autohersteller technisch auf künstliche Intelligenz konzentriert.

Seit Jahren drängt Musk Tesla-Investoren den Entwicklungsplan autonomer Elektrofahrzeuge vor.

Jedoch sagte Musk später, dass er gekündigt habe, weil er damals „mit einigen Dingen, die das OpenAI-Team tun wollte, nicht einverstanden war“.

Im Jahr 2019 sagte Musk auf Twitter, dass Tesla auch um einige der gleichen Mitarbeiter wie OpenAI konkurriert, und fügte hinzu, dass er seit mehr als einem Jahr nicht mehr mit dem Unternehmen in Verbindung gebracht worden sei.

Er sagte: „Es scheint, dass es am besten ist, sich zu für beide Seiten zufriedenstellenden Bedingungen zu trennen.“

Musk hat in den letzten Jahren kontinuierlich Einwände gegen einige der Praktiken von OpenAI erhoben.“

Im Jahr 2020 sagte Musk auf Twitter, dass er in Sicherheitsfragen „nicht genug Vertrauen“ in die Führungskräfte von OpenAI habe.

Als Reaktion auf den Untersuchungsbericht „Technology Review“ des MIT zu OpenAI sagte Musk, dass OpenAI offener sein sollte. In diesem Bericht wird davon ausgegangen, dass es innerhalb von OpenAI eine „Kultur der Geheimhaltung“ gibt, die im Widerspruch zu der von der Organisation behaupteten offenen und transparenten Strategie steht.

Kürzlich sagte Musk, er habe den Zugriff von OpenAI auf die Twitter-Datenbank gesperrt, die die Datentrainingssoftware von Twitter verwendet.

Musk sagte, dass es notwendig sei, die Governance-Struktur und die zukünftigen Umsatzpläne von OpenAI besser zu verstehen. OpenAI wurde als Open Source und gemeinnützig gegründet, beides ist inzwischen verloren gegangen.

Im Jahr 2019 hat OpenAI ein Tool für künstliche Intelligenz entwickelt, das Fake-News-Berichte generieren kann.

Zuerst sagte OpenAI, der Bot sei so gut darin, Fake News zu schreiben, dass er beschloss, sie nicht zu veröffentlichen. Doch später im selben Jahr veröffentlichte das Unternehmen eine Version des Tools namens GPT-2.

Im Jahr 2020 wurde ein weiterer Chatbot namens GPT-3 veröffentlicht. Im selben Jahr entzog OpenAI seinen Status als „Non-Profit-Organisation“.

Das Unternehmen gab in einem Blogbeitrag bekannt, dass OpenAI zu einem Unternehmen mit einer „Gewinnobergrenze“ geworden ist.

OpenAI erklärte, dass wir unsere Fähigkeit zur Mittelbeschaffung erhöhen und gleichzeitig unserer Mission dienen wollen, und dass keine bestehende Rechtsstruktur, die uns bekannt ist, das richtige Gleichgewicht erreichen kann. Unsere Lösung bestand darin, OpenAI LP als eine Mischung aus gewinnorientiertem und gemeinnützigem Unternehmen zu schaffen, das wir als „gedeckeltes gewinnorientiertes Unternehmen“ bezeichnen.

Im Rahmen der neuen Gewinnstruktur können OpenAI-Investoren bis zum 100-fachen ihrer ursprünglichen Investition verdienen, und das verbleibende Geld über diesem Betrag wird für gemeinnützige Zwecke verwendet.

Ende 2019 gab OpenAI seine Zusammenarbeit mit Microsoft bekannt, das 1 Milliarde US-Dollar in das Unternehmen investierte. OpenAI sagte, es werde die Technologie exklusiv an Microsoft lizenzieren.

Microsoft gab an, dass das durch das GPT-3-Modell geschaffene geschäftliche und kreative Potenzial unbegrenzt ist und die vielen potenziellen neuen Funktionen und Anwendungen sogar unsere Vorstellungskraft übersteigen.

In Bereichen wie dem Schreiben und Verfassen, dem Beschreiben und Zusammenfassen großer Mengen langer Daten (einschließlich Code) und der Konvertierung natürlicher Sprache in eine andere Sprache kann GPT-3 in Zukunft möglicherweise die Kreativität und den Einfallsreichtum des Menschen direkt anregen liegen in unseren eigenen Ideen und Plänen.

Diese Partnerschaft ermöglicht es Microsoft, mit Googles ebenso beliebtem KI-Unternehmen DeepMind zu konkurrieren.

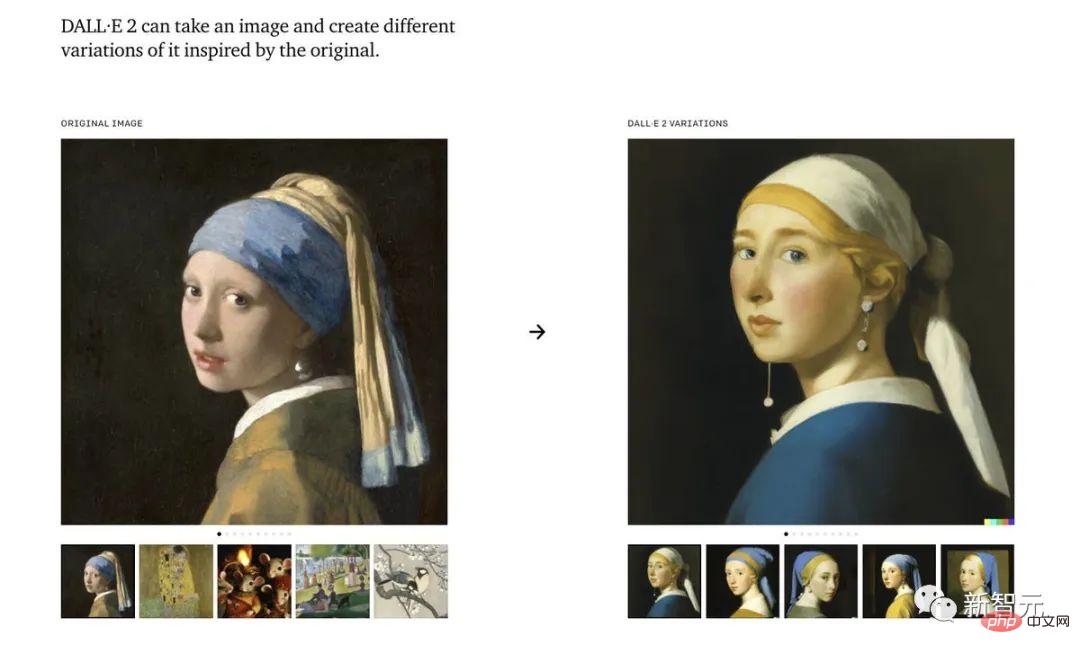

Letztes Jahr veröffentlichte OpenAI ein Tool zur Generierung von Gemälden mit künstlicher Intelligenz: Dall-E.

Dall-E ist ein künstliches Intelligenzsystem, das auf der Grundlage ihrer Beschreibungen realistische Bilder erstellen kann, sogar auf einem beträchtlichen künstlerischen Niveau. Im November veröffentlichte OpenAI eine aktualisierte Version des Programms, Dall-E 2.

Während der Chatbot von OpenAI in der letzten Woche „durchstarten“ konnte, wird eine aktualisierte Version der Software möglicherweise frühestens im nächsten Jahr veröffentlicht.

Am 30. November wurde das als Demonstrationsmodell veröffentlichte ChatGPT als OpenAIs „GPT-3.5“ angesehen. Das Unternehmen plant, als nächstes eine Vollversion von GPT-4 zu veröffentlichen.

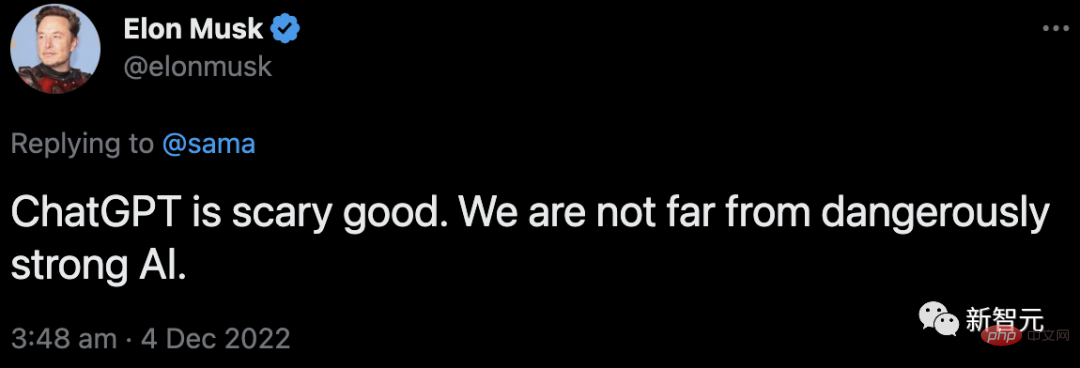

Gleichzeitig kommentiert Musk immer noch:

Als Antwort auf Sam Altmans Tweet über ChatGPT sagte er, dass wir nicht mehr weit von der Geburt einer gefährlich leistungsstarken KI entfernt seien.

Die Popularität von ChatGPT kann nicht von dem Helden dahinter getrennt werden – RLHF.

OpenAI-Forscher verwendeten die gleiche Methode wie InstructGPT – Reinforcement Learning from Human Feedback (RLHF), um das ChatGPT-Modell zu trainieren.

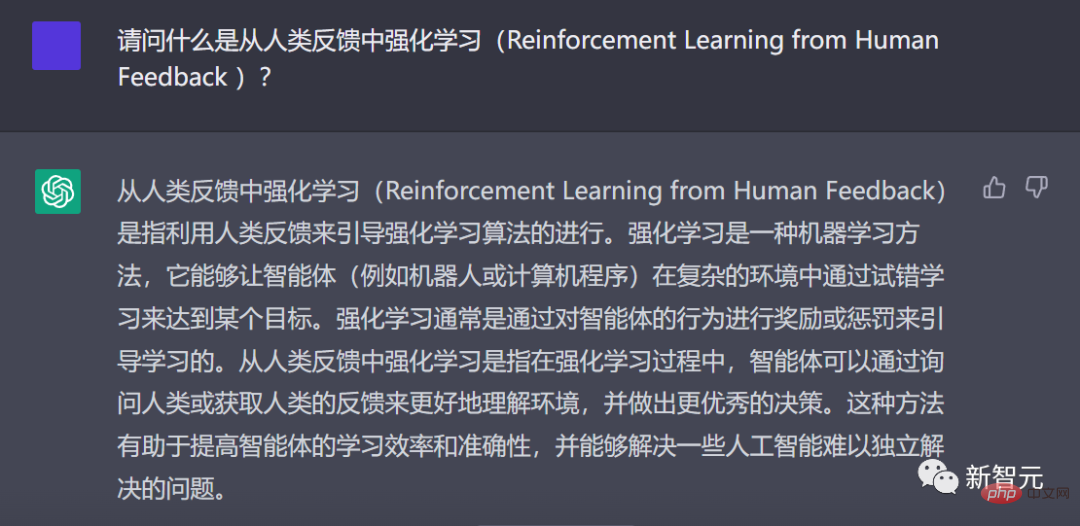

ChatGPT erklärt auf Chinesisch, was RLHF ist

Warum denken Sie an Verstärkungslernen aus menschlichem Feedback? Dies beginnt mit dem Hintergrund des Reinforcement Learning.

Seit einigen Jahren generieren Sprachmodelle Texte aus Eingabeaufforderungen menschlicher Eingaben.

Aber was ist ein „guter“ Text? Das ist schwer zu definieren. Denn die Beurteilungskriterien sind subjektiv und sehr kontextabhängig.

In vielen Anwendungen benötigen wir Modelle, um kreative Geschichten, informative Textausschnitte oder ausführbare Codeausschnitte zu schreiben.

Und es ist sehr schwierig, diese Eigenschaften durch das Schreiben einer Verlustfunktion zu erfassen. Und die meisten Sprachmodelle werden immer noch mithilfe des Vorhersageverlusts des nächsten Tokens (z. B. Kreuzentropie) trainiert.

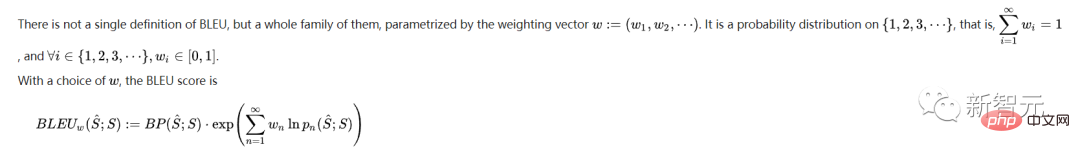

Um die Mängel des Verlusts selbst auszugleichen, hat jemand Metriken definiert, die menschliche Vorlieben besser erfassen, wie zum Beispiel BLEU oder ROUGE.

Aber auch sie vergleichen einfach den generierten Text mit dem Zitat, sodass sie erhebliche Einschränkungen haben.

Wäre es in diesem Fall nicht großartig, wenn wir das menschliche Feedback des generierten Texts als Verlust nutzen würden, um das Modell zu optimieren?

Auf diese Weise entstand die Idee des Reinforcement Learning from Human Feedback (RLHF) – wir können Reinforcement Learning nutzen, um Sprachmodelle direkt mit menschlichem Feedback zu optimieren.

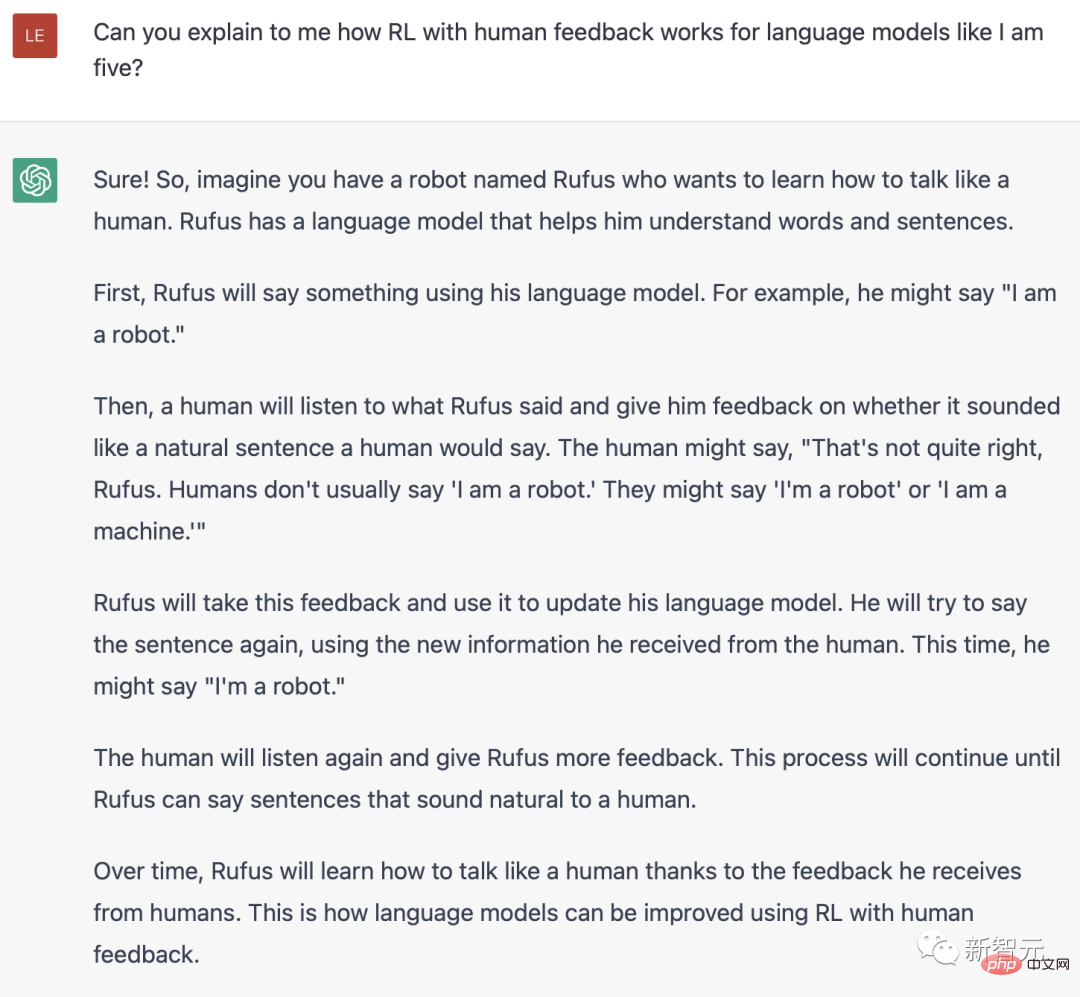

ChatGPT erklärt, was RLH auf Englisch ist

Ja, RLHF ermöglicht Sprachmodellen, Modelle, die auf einem Korpus allgemeiner Textdaten trainiert wurden, an Modellen mit komplexen menschlichen Werten auszurichten.

Im explosiven ChatGPT können wir den großen Erfolg von RLHF sehen.

Der Trainingsprozess von RLHF kann in drei Kernschritte unterteilt werden:

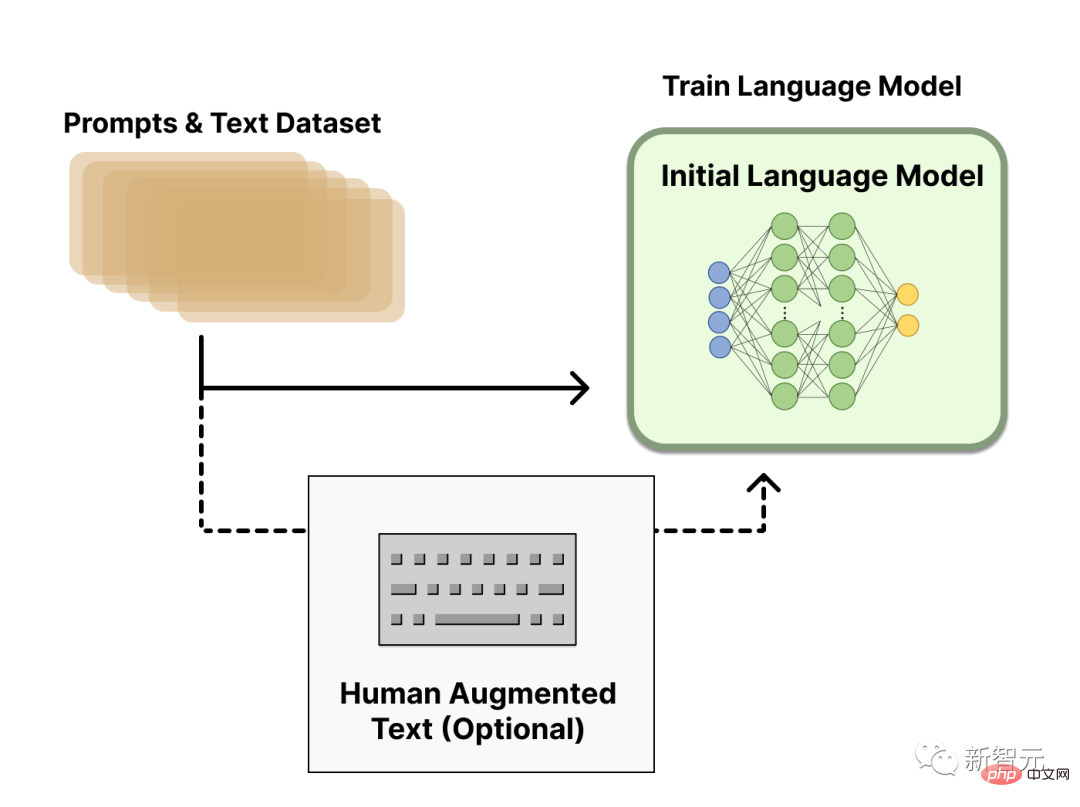

Vorab trainiertes Sprachmodell

Im ersten Schritt verwendet RLHF ein Sprachmodell, das mit dem klassischen Vortrainingsziel vorab trainiert wurde.

Zum Beispiel verwendete OpenAI eine kleinere Version von GPT-3 im ersten beliebten RLHF-Modell, InstructGPT.

Dieses Ausgangsmodell kann auch anhand zusätzlicher Texte oder Bedingungen verfeinert werden, ist aber nicht notwendig.

Generell gibt es keine eindeutige Antwort darauf, „welches Modell“ als Ausgangspunkt für RLHF am besten geeignet ist.

Als nächstes müssen wir, um das Sprachmodell zu erhalten, Daten generieren, um das Belohnungsmodell zu trainieren. Auf diese Weise werden menschliche Vorlieben in das System integriert.

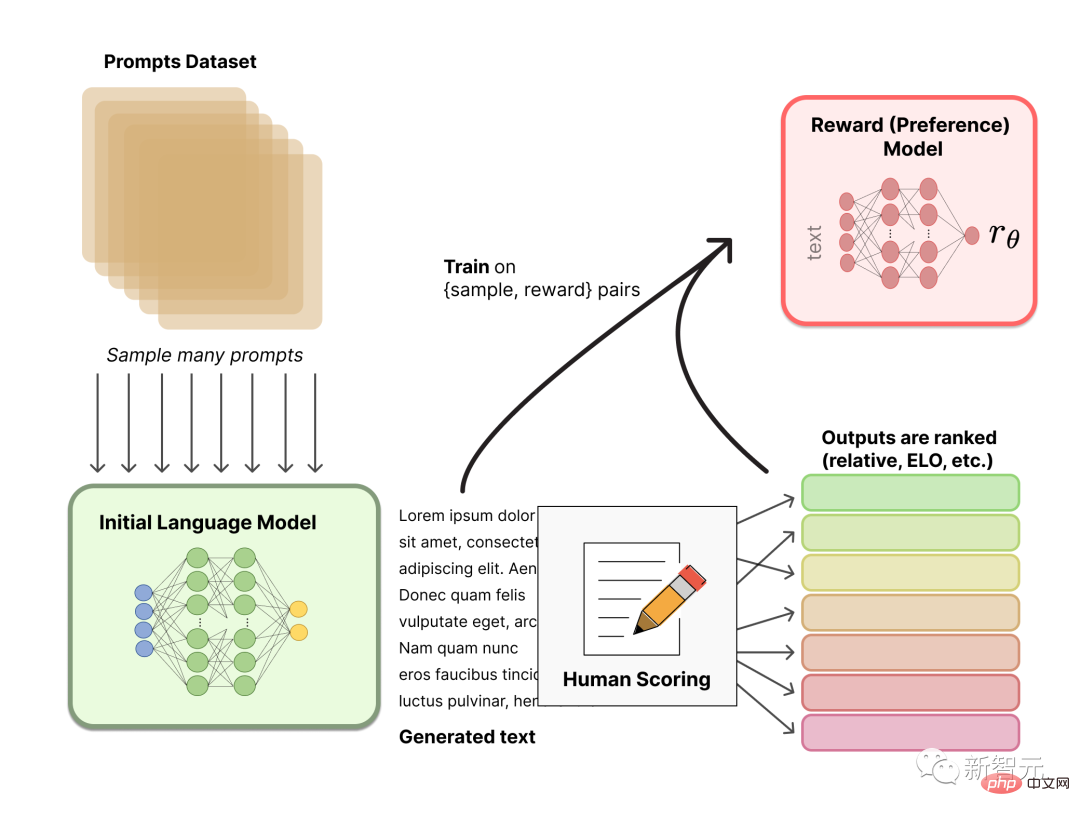

Belohnungsmodelltraining

Die Generierung eines Belohnungsmodells (RM, auch Präferenzmodell genannt), das auf menschliche Vorlieben kalibriert ist, ist eine relativ neue Forschung in RLHF.

Unser grundlegendes Ziel besteht darin, ein Modell oder System zu erhalten, das eine Textsequenz verwendet und eine skalare Belohnung zurückgibt, die die menschliche Präferenz numerisch darstellt.

Dieses System kann ein End-to-End-LM oder ein modulares System sein, das Belohnungen ausgibt (z. B. ordnet das Modell die Ergebnisse und wandelt die Rankings in Belohnungen um). Die Ausgabe als skalare Belohnung ist entscheidend für die spätere nahtlose Integration bestehender RL-Algorithmen in den RLHF-Prozess.

Diese LMs zur Belohnungsmodellierung können ein weiterer fein abgestimmter LM oder ein von Grund auf auf Basis von Präferenzdaten trainierter LM sein.

RMs Trainingsdatensatz für Eingabeaufforderungsgenerierungspaare wird durch Stichprobennahme einer Reihe von Eingabeaufforderungen aus einem vordefinierten Datensatz generiert. Fordert zum Generieren von neuem Text über ein anfängliches Sprachmodell auf.

Der vom LM generierte Text wird dann von einem menschlichen Annotator eingestuft. Der Mensch bewertet jeden Textabschnitt direkt, um ein Belohnungsmodell zu generieren, was in der Praxis schwierig umzusetzen ist. Da Menschen unterschiedliche Werte haben, sind diese Werte unkalibriert und verrauscht.

Es gibt viele Möglichkeiten, Text zu ordnen. Ein erfolgreicher Ansatz besteht darin, Benutzer Text vergleichen zu lassen, der von zwei Sprachmodellen basierend auf derselben Eingabeaufforderung generiert wurde. Diese verschiedenen Ranking-Methoden werden auf ein skalares Belohnungssignal normalisiert, das für das Training verwendet wird.

Interessanterweise haben die bisher erfolgreichen RLHF-Systeme alle Belohnungssprachmodelle ähnlicher Größe zur Textgenerierung verwendet. Vermutlich müssen diese Präferenzmodelle über ähnliche Fähigkeiten verfügen, um den ihnen bereitgestellten Text zu verstehen, da die Modelle über ähnliche Fähigkeiten zur Generierung dieses Textes verfügen müssen.

An diesem Punkt gibt es im RLHF-System ein anfängliches Sprachmodell, das zum Generieren von Text verwendet werden kann, und ein Präferenzmodell, das jeden Text nimmt und ihm einen menschlichen Wahrnehmungswert zuweist. Als nächstes müssen Sie Reinforcement Learning (RL) verwenden, um das ursprüngliche Sprachmodell im Vergleich zum Belohnungsmodell zu optimieren.

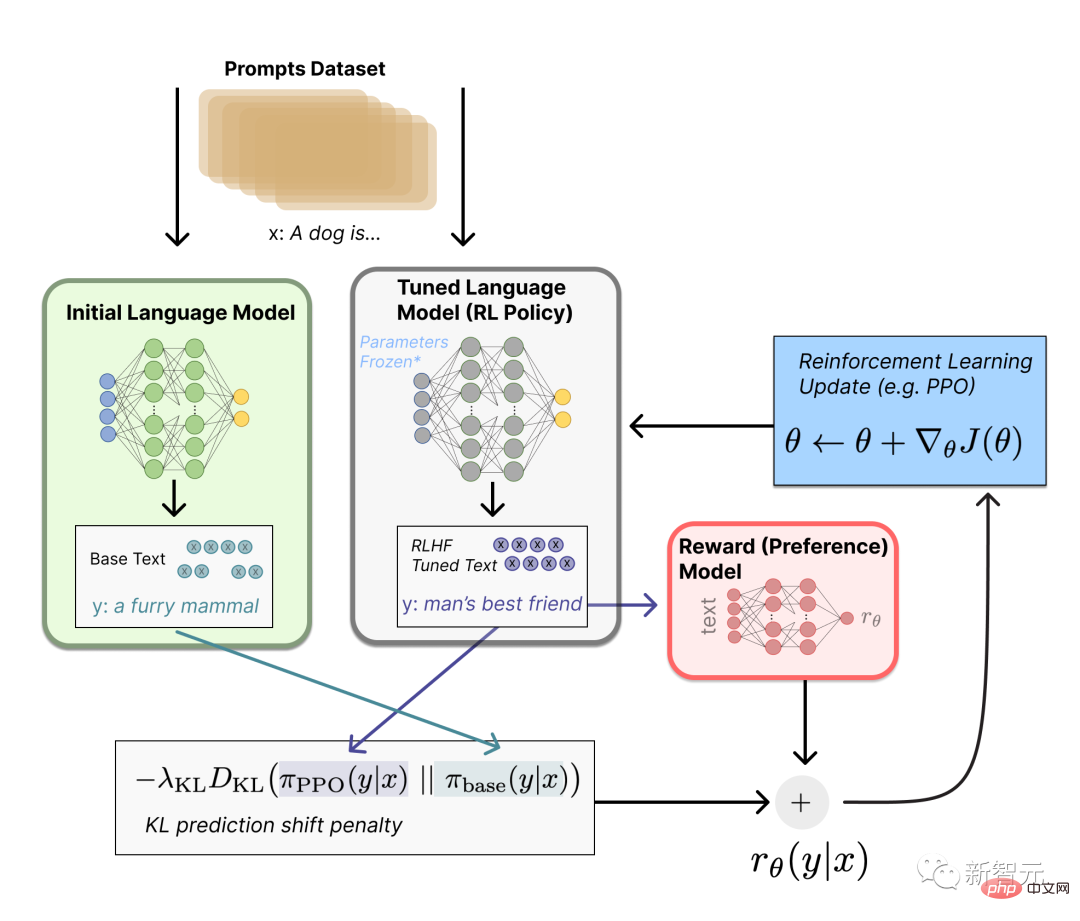

Verwenden der Feinabstimmung des Verstärkungslernens

Diese Feinabstimmungsaufgabe kann als RL-Problem formuliert werden.

Erstens ist die Strategie ein Sprachmodell, das eine Eingabeaufforderung entgegennimmt und eine Folge von Texten (oder einfach nur eine Wahrscheinlichkeitsverteilung über die Texte) zurückgibt.

Der Aktionsraum dieser Strategie besteht aus allen Token, die dem Vokabular des Sprachmodells entsprechen (normalerweise in der Größenordnung von 50.000 Token), und der Beobachtungsraum umfasst mögliche Eingabe-Token-Sequenzen und ist daher ziemlich groß (Vokabular x Anzahl der Eingaben). Token).

Die Belohnungsfunktion ist eine Kombination aus Präferenzmodell und Richtlinienänderungsbeschränkungen.

In der Belohnungsfunktion kombiniert das System alle von uns besprochenen Modelle im RLHF-Prozess.

Basierend auf der Eingabeaufforderung x aus dem Datensatz werden zwei Texte y1 und y2 generiert – einer aus dem anfänglichen Sprachmodell und einer aus der aktuellen Iteration der Feinabstimmungsstrategie.

Nachdem der Text aus der aktuellen Richtlinie an das Präferenzmodell übergeben wurde, gibt das Modell ein skalares Konzept der „Präferenz“ zurück – rθ.

Nachdem Sie diesen Text mit dem Text des ursprünglichen Modells verglichen haben, können Sie die Strafe für die Differenz zwischen ihnen berechnen.

RLHF kann von diesem Punkt aus fortfahren, indem es das Belohnungsmodell und die Strategie iterativ aktualisiert.

Da RL-Strategien aktualisiert werden, können Benutzer diese Ergebnisse weiterhin mit früheren Versionen des Modells vergleichen.

In diesem Prozess wird die komplexe Dynamik der Entwicklung von Strategien und Belohnungsmodellen vorgestellt. Diese Forschung ist sehr komplex und sehr offen.

https://www.4gamers.com.tw/news/detail/56185/chatgpt-can-have-a-good-conversation-with-you-among-acg-and-trpg-mostly

https://www.businessinsider.com/history-of-openai-company-chatgpt-elon-musk-founded-2022-12#musk-has-continued-to-take-issue-with-openai-in-current -Jahre-7

Das obige ist der detaillierte Inhalt vonKein Geld, lassen Sie sich von „Love Saint' ChatGPT zeigen, wie man Musk jagt!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

So vergleichen Sie den Dateiinhalt zweier Versionen in Git

So vergleichen Sie den Dateiinhalt zweier Versionen in Git

Was ist ECharts?

Was ist ECharts?

Die zehn besten Börsen für digitale Währungen

Die zehn besten Börsen für digitale Währungen

Welche Methoden gibt es zum Erstellen einer mobilen Website?

Welche Methoden gibt es zum Erstellen einer mobilen Website?