Die Ansichtssynthese ist ein zentrales Problem an der Schnittstelle von Computer Vision und Computergrafik. Sie bezieht sich auf die Erstellung einer neuen Ansicht einer Szene aus mehreren Bildern der Szene.

Um eine neue Ansicht einer Szene genau zu synthetisieren, muss ein Modell mehrere Arten von Informationen aus einem kleinen Satz von Referenzbildern erfassen, z. B. detaillierte 3D-Struktur, Materialien und Beleuchtung usw.

Seit Forscher im Jahr 2020 das Neural Radiation Field (NeRF)-Modell vorgeschlagen haben, hat dieses Thema auch immer mehr Aufmerksamkeit erhalten, was die Leistung der Synthese neuer Ansichten erheblich gefördert hat.

Einer der ganz Großen ist Google, das auch viele Artikel im Bereich NeRF veröffentlicht hat. In diesem Artikel stellen wir Ihnen zwei von Google auf der CVPR 2022 und der ECCV 2022 veröffentlichte Artikel zum Thema vor Light Field Neural Die Entwicklung von Rendering-Modellen .

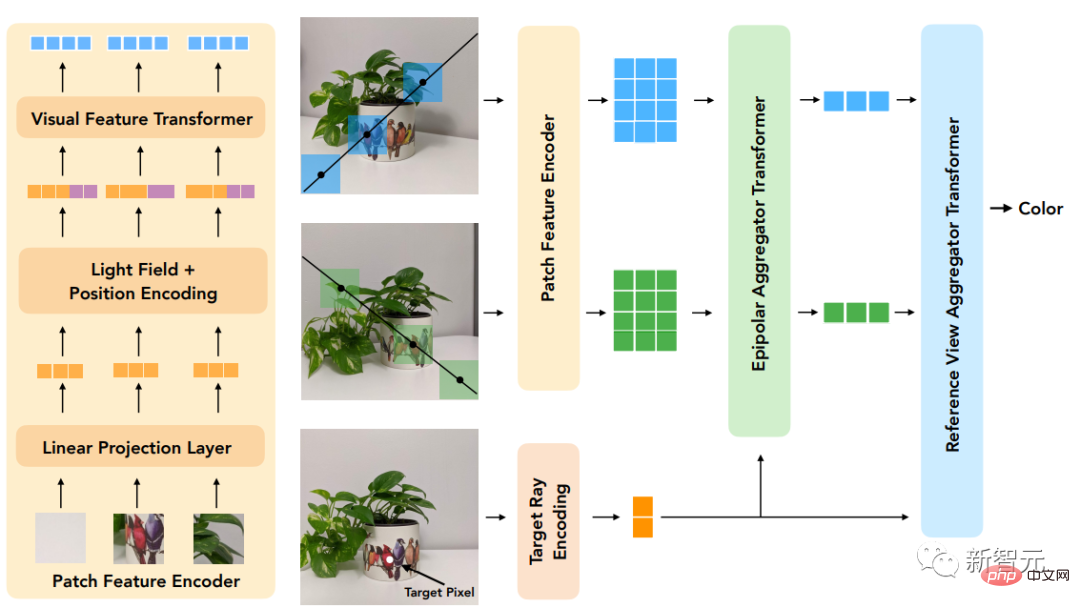

Der erste Artikel schlägt ein Transformer-basiertes zweistufiges Modell vor, um zu lernen, Referenzpixelfarben zu kombinieren, indem zunächst Merkmale entlang der Epipolarlinie (Epipolarlinie) und dann Merkmale entlang der Referenzansicht erhalten werden, um die Farbe der Zielstrahlen zu erzeugen , verbessert die Genauigkeit der Ansichtswiedergabe erheblich .

Link zum Dokument: https://arxiv.org/pdf/2112.09687.pdf und Transluzenz, erfordert jedoch eine dichte Ansicht der Szene. Auf geometrischer Rekonstruktion basierende Methoden erfordern nur spärliche Ansichten, können jedoch nicht-Lambertsche Effekte, d. h. nichtideale Streuung, nicht genau modellieren.

Das in der Arbeit vorgeschlagene neue Modell kombiniert die Vorteile dieser beiden Richtungen und mildert ihre Einschränkungen

Durch die Arbeit mit einer vierdimensionalen Darstellung des Lichtfeldes kann das Modell lernen, die Sicht genau darzustellen. damit verbundene Effekte. Die Szenengeometrie wird implizit aus einer spärlichen Menge an Ansichten gelernt, indem während des Trainings und der Inferenz geometrische Einschränkungen erzwungen werden.

Das Modell übertrifft modernste Modelle bei mehreren Vorwärts- und 360°-Datensätzen und verfügt über einen größeren Spielraum bei Szenen mit starken sichtlinienabhängigen Änderungen.

Ein weiterer Artikel befasst sich mit dem

Ein weiterer Artikel befasst sich mit dem

der Synthese unsichtbarer Szenen durch die Verwendung von Transformer-Sequenzenmit kanonisierter Positionskodierung. Nachdem das Modell an einer Reihe von Szenen trainiert wurde, kann es zum Synthetisieren von Ansichten neuer Szenen verwendet werden.

Link zum Papier: https://arxiv.org/pdf/2207.10662.pdf Mit dieser Methode kann die Farbe des Zielstrahls in der neuen Szene direkt vorhergesagt werden, indem einfach der Patchsatz aus der Szene abgetastet wird.

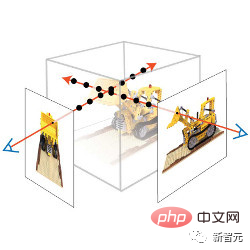

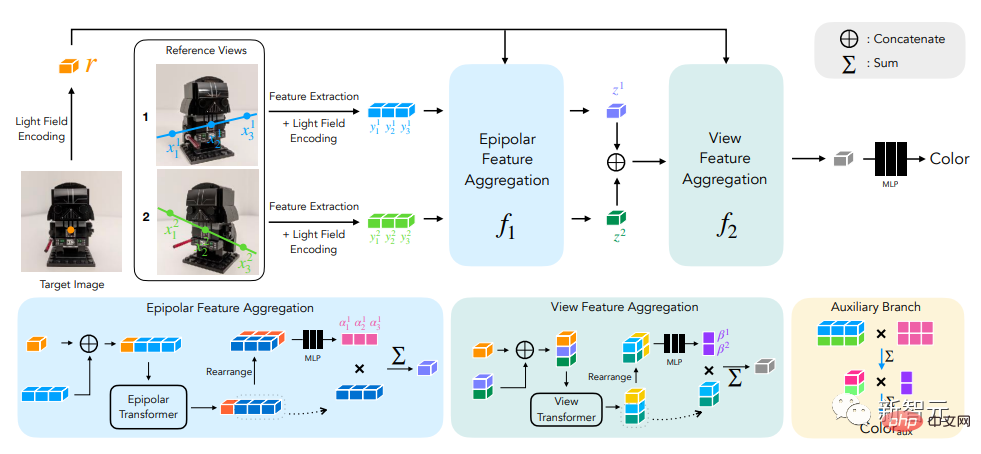

Für die Positionskodierung parametrisieren die Forscher die Strahlen auf ähnliche Weise wie bei der Lichtfelddarstellungsmethode. Der Unterschied besteht darin, dass die Koordinaten relativ zum Zielstrahl normiert werden, was die Methode auch unabhängig vom Referenzrahmen macht und verbessert Allgemeinheit. Sex . Abschließende experimentelle Ergebnisse zeigen, dass diese Methode andere Methoden bei der Synthese neuer Ansichten unsichtbarer Szenen übertrifft, selbst wenn sie trainiert wird. Light Field Neural Rendering Um ein neues Bild zu generieren, müssen wir von den Kameraparametern des Eingabebildes ausgehen, zunächst die Koordinaten des Zielstrahls ermitteln (jeweils einem Pixel entsprechen) und für jede Koordinate eine Modellabfrage durchführen. Die Lösung der Forscher bestand nicht darin, jedes Referenzbild vollständig zu verarbeiten, sondern nur auf die Bereiche zu schauen, die die Zielpixel beeinflussen könnten. Diese Regionen können durch epipolare Geometrie bestimmt werden, indem jedes Zielpixel einer Linie in jedem Referenzrahmen zugeordnet wird. Aus Sicherheitsgründen müssen Sie einen kleinen Bereich um einige Punkte auf der Epipolarlinie auswählen, um einen Satz von Patches zu bilden, der tatsächlich vom Modell verarbeitet wird, und dann den Transformer auf diesen Satz von Patches anwenden Ermitteln Sie die Farbe des Zielpixels.

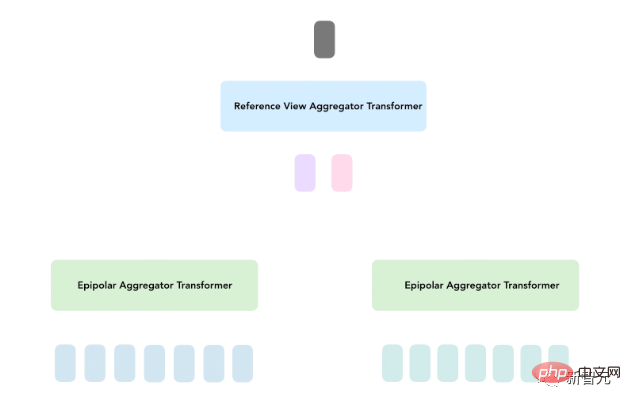

Beim Light Field Neural Rendering (LFNR) verwenden Forscher zwei Transformer-Sequenzen, um eine Sammlung von Patches auf Zielpixelfarben abzubilden. Der erste Transformer aggregiert Informationen entlang jeder Epipolarlinie und der zweite Transformer aggregiert Informationen entlang jedes Referenzbildes. Diese Methode kann den ersten Transformer so interpretieren, dass er potenzielle Entsprechungen von Zielpixeln in jedem Referenzrahmen findet, während der zweite Transformer Überlegungen zu Verdeckungs- und Sichtlinien-abhängigen Effekten anstellt, was ebenfalls bildbasiert ist Rendern.

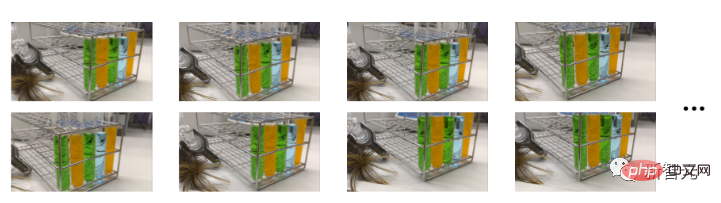

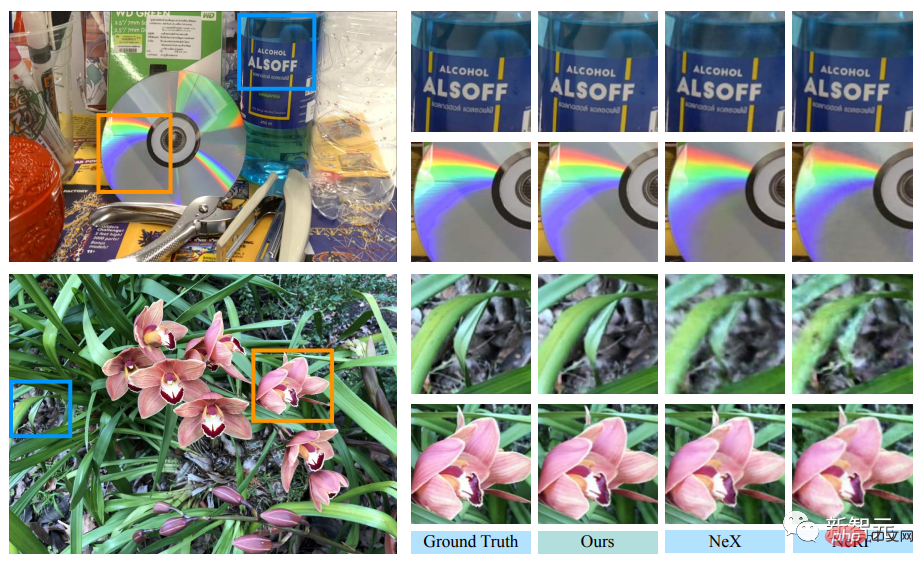

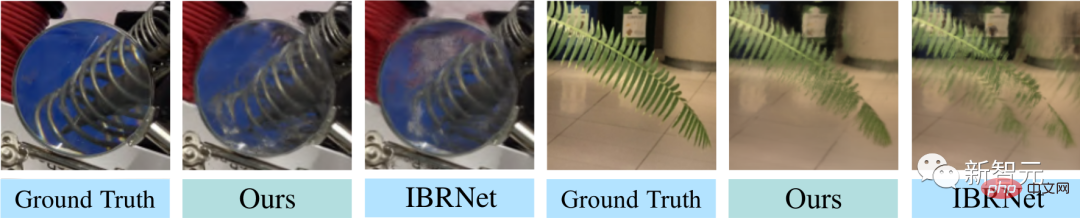

LFNR kann einige der schwierigeren sichtlinienabhängigen Effekte im NeX/Shiny-Datensatz reproduzieren, wie zum Beispiel Regenbögen und Reflexionen auf CDs, Reflexionen, Brechungen und Transluzenz auf Flaschen.

Einmal trainieren und auf neue Szenen verallgemeinern Der erste Transformer faltet die Informationen entlang jeder Epipolarlinie unabhängig für jedes Referenzbild. Dies bedeutet auch, dass das Modell nur auf der Grundlage der ausgegebenen Strahlkoordinaten und Patches jedes Referenzbildes entscheiden kann funktioniert gut in Trainingsszenen (wie die meisten neuronalen Rendering-Methoden), lässt sich jedoch nicht auf verschiedene Szenen verallgemeinern. Generalisierbare Modelle sind wichtig, weil sie ohne Umschulung direkt auf neue Szenarien angewendet werden können. Forscher schlugen ein allgemeines Patch-basiertes Neural-Rendering-Modell (GPNR) vor, um dieses Manko von LFNR zu beheben. Durch Hinzufügen eines Transformers zum Modell, sodass dieser vor den beiden anderen Transformern läuft und Informationen zwischen Punkten gleicher Tiefe in allen Referenzbildern austauscht. GPNR besteht aus einer Sequenz von drei Transformern, die eine Reihe von Patches, die entlang epipolarer Linien extrahiert wurden, in Pixelfarben abbilden. Bildfelder werden durch lineare Projektionsebenen auf anfängliche Merkmale abgebildet, und diese Merkmale werden dann vom Modell kontinuierlich verfeinert und aggregiert, um schließlich Merkmale und Farben zu bilden. Nachdem der erste Transformer beispielsweise die Patch-Sequenz aus „Park Bench“ extrahiert hat, kann das neue Modell Hinweise wie „Blumen“ verwenden, die in beiden Ansichten in entsprechenden Tiefen erscheinen, um das Vorhandensein einer möglichen Übereinstimmung anzuzeigen. Eine weitere Schlüsselidee dieser Arbeit besteht darin, die Positionskodierung entsprechend dem Zielstrahl zu normalisieren, denn wenn Sie in verschiedenen Szenarien verallgemeinern möchten, müssen Sie die Größen in einem relativen und nicht in einem absoluten Referenzsystem darstellen Um die Generalisierungsleistung des Modells zu bewerten, trainierten die Forscher GPNR anhand einer Reihe von Szenarien und testeten es anhand neuer Szenarien. GPNR verbessert sich bei mehreren Benchmarks (nach IBRNet- und MVSNeRF-Protokollen) im Durchschnitt um 0,5–1,0 dB, insbesondere beim IBRNet-Benchmark übertrifft GPNR das Basismodell, obwohl nur 11 % der Trainingsszenarien verwendet werden. GPNR generierte Ansichtsdetails zu gepflegten Szenen in NeX/Shiny und LLFF ohne Feinabstimmung. GPNR reproduziert Details auf den Lamellen und der Brechung durch die Linse genauer als IBRNet.  Die Innovation des Modells besteht darin, dass es ein bildbasiertes Rendering durchführt, bei dem die Farbe und Eigenschaften des Referenzbilds kombiniert werden, um eine neue Ansicht zu rendern. Es basiert ausschließlich auf Transformer und arbeitet mit dem Bild-Patch-Set . Und sie nutzen 4D-Lichtfelddarstellungen zur Positionskodierung und helfen so, ansichtsbezogene Effekte zu simulieren.

Die Innovation des Modells besteht darin, dass es ein bildbasiertes Rendering durchführt, bei dem die Farbe und Eigenschaften des Referenzbilds kombiniert werden, um eine neue Ansicht zu rendern. Es basiert ausschließlich auf Transformer und arbeitet mit dem Bild-Patch-Set . Und sie nutzen 4D-Lichtfelddarstellungen zur Positionskodierung und helfen so, ansichtsbezogene Effekte zu simulieren. Die Eingabe in das Modell besteht aus einem Satz von Referenzbildern, den entsprechenden Kameraparametern (Brennweite, Position und räumliche Ausrichtung) und den Koordinaten des Zielstrahls, dessen Farbe der Benutzer wünscht bestimmen.

Transformer ist in diesem Fall besonders nützlich, da der Selbstaufmerksamkeitsmechanismus natürlich die Patch-Sammlung als Eingabe verwenden kann und die Aufmerksamkeitsgewichtung selbst verwendet werden kann, um die Ausgabepixel in Kombination mit Farben und Funktionen der Referenzansicht vorherzusagen . Farbe.

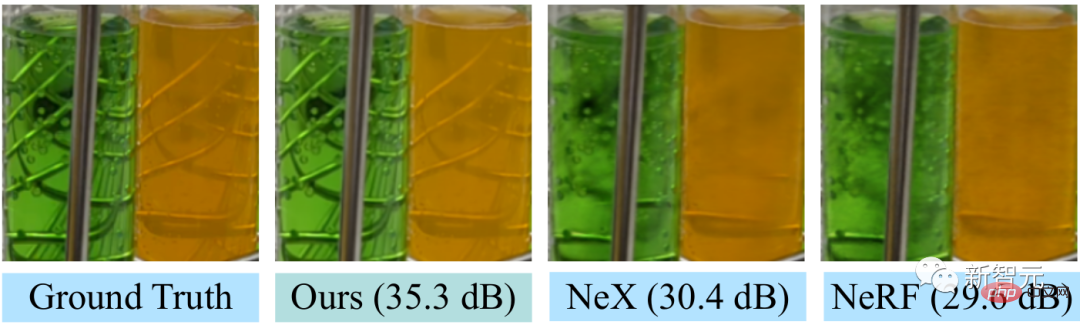

Transformer ist in diesem Fall besonders nützlich, da der Selbstaufmerksamkeitsmechanismus natürlich die Patch-Sammlung als Eingabe verwenden kann und die Aufmerksamkeitsgewichtung selbst verwendet werden kann, um die Ausgabepixel in Kombination mit Farben und Funktionen der Referenzansicht vorherzusagen . Farbe.  LFNR verbessert das Spitzen-Signal-Rausch-Verhältnis (PSNR) um bis zu 5 dB im Vergleich zum Sota-Modell bei den beliebtesten View-Synthese-Benchmarks (NeRFs Blender und Real Forward-Facing Scenes und NeXs Shiny). was ziemlich ist. Dadurch wird der Fehler auf Pixelebene um das 1,8-fache reduziert.

LFNR verbessert das Spitzen-Signal-Rausch-Verhältnis (PSNR) um bis zu 5 dB im Vergleich zum Sota-Modell bei den beliebtesten View-Synthese-Benchmarks (NeRFs Blender und Real Forward-Facing Scenes und NeXs Shiny). was ziemlich ist. Dadurch wird der Fehler auf Pixelebene um das 1,8-fache reduziert.  Im Vergleich zu früheren Methoden wie NeX und NeRF sind sie nicht in der Lage, Sichtlinieneffekte wie die Transluzenz und den Brechungsindex von Reagenzgläsern in der Laborszene im NeX/Shiny-Datensatz zu reproduzieren .

Im Vergleich zu früheren Methoden wie NeX und NeRF sind sie nicht in der Lage, Sichtlinieneffekte wie die Transluzenz und den Brechungsindex von Reagenzgläsern in der Laborszene im NeX/Shiny-Datensatz zu reproduzieren .

Aber LFNR hat auch Einschränkungen.

Das obige ist der detaillierte Inhalt vonTrainieren Sie einfach einmal, um neue 3D-Szenen zu generieren! Die Entwicklungsgeschichte von Googles „Light Field Neural Rendering'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!