GPT4All ist ein Chatbot, der auf der Grundlage einer großen Menge sauberer Assistentendaten (einschließlich Code, Geschichten und Konversationen) trainiert wird. Die Daten umfassen ca. 800.000 von GPT-3.5-Turbo generierte Daten. Er basiert auf LLaMa und kann auf M1 ausgeführt werden Mac, Windows und andere Umgebungen. Vielleicht ist, wie der Name schon sagt, die Zeit gekommen, in der jeder persönliche GPT nutzen kann.

Seit OpenAI ChatGPT veröffentlicht hat, sind Chatbots in den letzten Monaten immer beliebter geworden.

Obwohl ChatGPT leistungsstark ist, ist es für OpenAI fast unmöglich, es als Open Source zu veröffentlichen. Viele Leute arbeiten an Open Source, wie zum Beispiel LLaMA, das vor einiger Zeit von Meta als Open Source bereitgestellt wurde. Es ist ein allgemeiner Begriff für eine Reihe von Modellen mit Parametermengen im Bereich von 7 Milliarden bis 65 Milliarden. Darunter kann das 13-Milliarden-Parameter-LLaMA-Modell das 175-Milliarden-Parameter-GPT-3 „bei den meisten Benchmarks“ übertreffen.

Von der offenen Quelle von LLaMA haben viele Forscher profitiert. Beispielsweise hat Stanford LLaMA um Instruct-Tuning erweitert und ein neues 7-Milliarden-Parameter-Modell namens Alpaca (basierend auf LLaMA 7B) trainiert. Die Ergebnisse zeigen, dass die Leistung von Alpaca, einem leichten Modell mit nur 7B-Parametern, mit sehr großen Sprachmodellen wie GPT-3.5 vergleichbar ist.

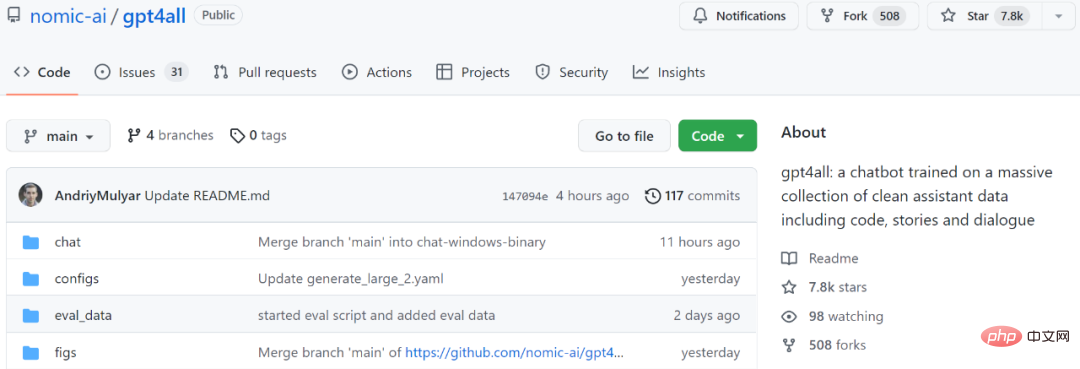

Als weiteres Beispiel ist das Modell, das wir als nächstes vorstellen werden, GPT4All, ebenfalls ein neues 7B-Sprachmodell, das auf LLaMA basiert. Zwei Tage nach dem Start des Projekts hat die Anzahl der Stars 7,8.000 überschritten.

Projektadresse: https://github.com/nomic-ai/gpt4all

Einfach ausgedrückt wird GPT4All auf 800.000 Daten von GPT-3.5-Turbo trainiert, einschließlich Textfragen, Story-Beschreibungen und mehr Dialog und Code umwandeln.

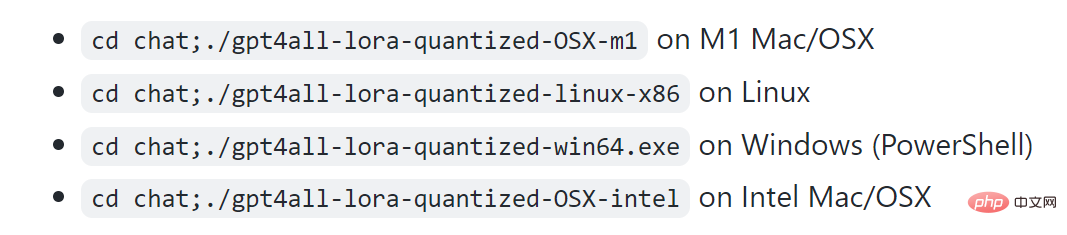

Dem Projekt zufolge kann M1 auf Mac, Windows und anderen Umgebungen ausgeführt werden.

Schauen wir uns zunächst die Wirkung an. Wie in der Abbildung unten gezeigt, können Benutzer ohne Hindernisse mit GPT4All kommunizieren, z. B. indem sie das Modell fragen: „Kann ich ein großes Sprachmodell auf einem Laptop ausführen?“ Die Antwort von GPT4All lautet: „Ja, Sie können einen Laptop zum Trainieren und Verwenden verwenden.“ Testen Sie neuronale Netze oder Modelle für maschinelles Lernen für andere natürliche Sprachen (wie Englisch oder Chinesisch). Wichtig ist, dass Sie genügend verfügbaren Speicher (RAM) benötigen, um der Größe dieser Modelle gerecht zu werden …“ Wenn Sie nicht genau wissen, wie viel Speicher Sie benötigen, können Sie auch weiterhin bei GPT4All nachfragen, dann erhalten Sie eine Antwort. Den Ergebnissen nach zu urteilen ist die Fähigkeit von GPT4All, mehrere Dialogrunden durchzuführen, immer noch sehr stark.

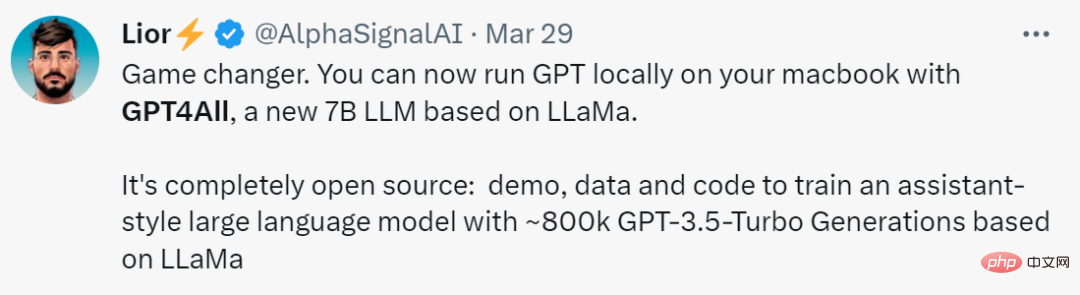

Manche Leute nennen diese Forschung „einen Game Changer. Mit dem Segen von GPT4All können Sie GPT jetzt lokal auf dem MacBook ausführen.“

Ähnlich Zu GPT-4 stellt GPT4All auch einen „technischen Bericht“ zur Verfügung.

Ähnlich Zu GPT-4 stellt GPT4All auch einen „technischen Bericht“ zur Verfügung.

Adresse des technischen Berichts: https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf

Adresse des technischen Berichts: https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf

Dieser vorläufige technische Bericht beschreibt kurz die Konstruktionsdetails von GPT4All. Die Forscher legten die gesammelten Daten, Datenverarbeitungsverfahren, Trainingscode und endgültigen Modellgewichte offen, um offene Forschung und Reproduzierbarkeit zu fördern. Sie veröffentlichten auch eine quantisierte 4-Bit-Version des Modells, was bedeutet, dass fast jeder das Modell auf einer CPU ausführen kann.

Als nächstes wollen wir sehen, was in diesem Bericht geschrieben steht.

GPT4All Technical Report

1. Datenerfassung und -sortierungVom 20. März 2023 bis zum 26. März 2023 verwendeten Forscher die GPT-3.5-Turbo OpenAI API, um etwa 1 Million Paare von Eingabeaufforderungen zu sammeln.

Zuerst sammelten die Forscher verschiedene Frage-/Eingabeproben, indem sie drei öffentlich verfügbare Datensätze nutzten:

Siehe das Alpaca-Projekt der Stanford University (Taori et al., 2023), Forscher haben viel dafür bezahlt Aufmerksamkeit für die Datenaufbereitung und -kuratierung. Nachdem sie den ersten Datensatz der durch Eingabeaufforderungen generierten Paare gesammelt hatten, luden sie die Daten in Atlas, um sie zu organisieren und zu bereinigen. Dabei wurden alle Proben entfernt, in denen GPT-3.5-Turbo nicht auf Eingabeaufforderungen reagierte und eine fehlerhafte Ausgabe erzeugte. Dadurch reduziert sich die Gesamtzahl der Stichproben auf 806199 hochwertige, durch Eingabeaufforderungen generierte Paare. Als nächstes haben wir die gesamte Bigscience/P3-Teilmenge aus dem endgültigen Trainingsdatensatz entfernt, da ihre Ausgabevielfalt sehr gering war. P3 enthält viele homogene Eingabeaufforderungen, die kurze und homogene Antworten von GPT-3.5-Turbo generieren.

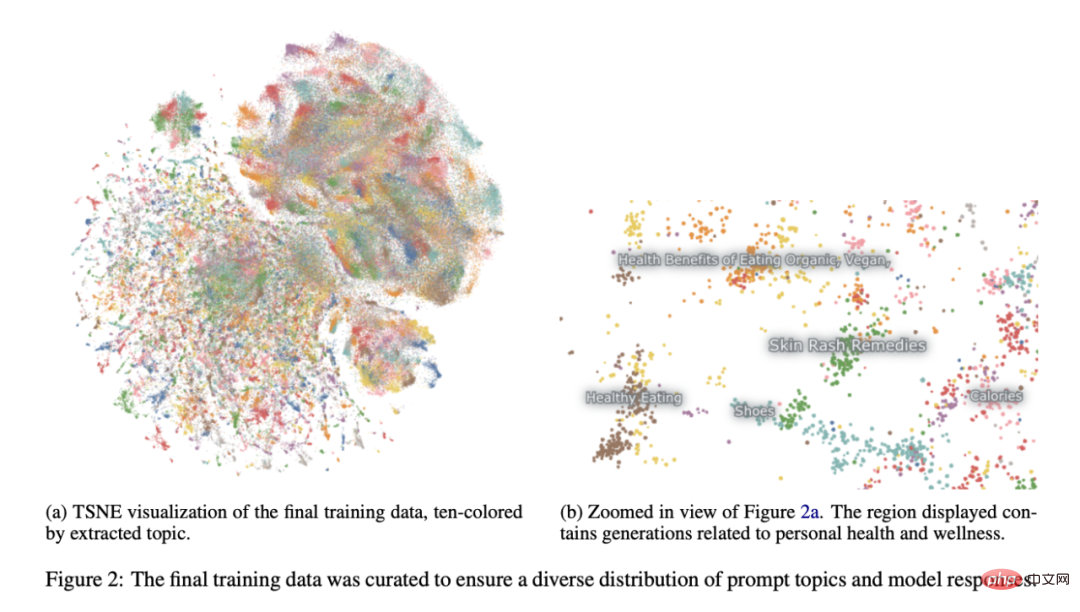

Diese Eliminierungsmethode führte zu einer endgültigen Teilmenge von 437.605 durch Eingabeaufforderung generierten Paaren, wie in Abbildung 2 dargestellt.

Modelltraining

Die Forscher haben mehrere Modelle in einer Instanz von LLaMA 7B verfeinert (Touvron et al., 2023). Das mit ihrer ersten öffentlichen Veröffentlichung verbundene Modell wurde mit LoRA (Hu et al., 2021) in 4 Epochen an 437.605 nachbearbeiteten Beispielen trainiert. Detaillierte Modellhyperparameter und Trainingscode finden Sie in der entsprechenden Ressourcenbibliothek und den Modelltrainingsprotokollen.

Reproduzierbarkeit

Die Forscher haben alle Daten (einschließlich ungenutzter P3-Generationen), Trainingscode und Modellgewichte zur Reproduktion für die Community freigegeben. Interessierte Forscher finden die neuesten Daten, Trainingsdetails und Prüfpunkte im Git-Repository.

Kosten

Die Forscher brauchten etwa vier Tage, um diese Modelle zu erstellen, und die GPU-Kosten betrugen 800 US-Dollar (gemietet von Lambda Labs und Paperspace, einschließlich mehrerer fehlgeschlagener Schulungen) und zusätzlich 500 US-Dollar an OpenAI-API-Gebühren.

Das endgültig veröffentlichte Modell gpt4all-lora kann in etwa 8 Stunden auf dem DGX A100 8x 80 GB von Lambda Labs trainiert werden, was einem Gesamtpreis von 100 US-Dollar entspricht.

Dieses Modell kann auf einem normalen Laptop ausgeführt werden: „Es fallen keine Kosten außer der Stromrechnung an.“

Der Forscher verwendete das SelfInstruct-Papier (Wang et al., 2022). Eine vorläufige Bewertung des Modells wurde anhand menschlicher Bewertungsdaten durchgeführt. Der Bericht vergleicht auch die Grundwahrheitsproblematik dieses Modells mit dem bekanntesten öffentlichen Alpaka-Lora-Modell (beigetragen vom Huggingface-Benutzer Chainyo). Sie fanden heraus, dass alle Modelle bei einer kleinen Anzahl von Aufgaben sehr große Ratlosigkeiten aufwiesen und bis zu 100 Ratlosigkeiten meldeten. Modelle, die anhand dieses gesammelten Datensatzes verfeinert wurden, zeigten im Vergleich zu Alpaca eine geringere Verwirrung bei der Self-Instruct-Bewertung. Die Forscher sagen, dass diese Bewertung nicht erschöpfend ist und noch Raum für weitere Bewertungen besteht. Sie laden die Leser dazu ein, das Modell auf einer lokalen CPU auszuführen (Dokumentation auf Github verfügbar) und sich ein qualitatives Verständnis seiner Fähigkeiten zu verschaffen.

Abschließend ist es wichtig anzumerken, dass die Autoren Daten und Trainingsdetails in der Hoffnung veröffentlicht haben, dass sie die offene LLM-Forschung beschleunigen, insbesondere in den Bereichen Ausrichtung und Interpretierbarkeit. GPT4Alle Modellgewichte und -daten dienen ausschließlich Forschungszwecken und sind gegen jegliche kommerzielle Nutzung lizenziert. GPT4All basiert auf LLaMA, das über eine nichtkommerzielle Lizenz verfügt. Assistentendaten wurden von GPT-3.5-Turbo von OpenAI gesammelt, dessen Nutzungsbedingungen die Entwicklung von Modellen verbieten, die kommerziell mit OpenAI konkurrieren.

Das obige ist der detaillierte Inhalt vonEin Ersatz für ChatGPT, der auf einem Laptop ausgeführt werden kann, ist hier, zusammen mit einem vollständigen technischen Bericht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Computersprachen

Computersprachen

Computer-Anwendungsbereiche

Computer-Anwendungsbereiche

Welche Kodierung wird in einem Computer zur Verarbeitung von Daten und Anweisungen verwendet?

Welche Kodierung wird in einem Computer zur Verarbeitung von Daten und Anweisungen verwendet?

Der Hauptgrund, warum Computer Binärdateien verwenden

Der Hauptgrund, warum Computer Binärdateien verwenden

Was sind die Hauptmerkmale von Computern?

Was sind die Hauptmerkmale von Computern?

Was sind die Grundkomponenten eines Computers?

Was sind die Grundkomponenten eines Computers?

Auf welche Tasten beziehen sich Pfeile in Computern?

Auf welche Tasten beziehen sich Pfeile in Computern?

So stellen Sie den Browserverlauf auf dem Computer wieder her

So stellen Sie den Browserverlauf auf dem Computer wieder her