Chinesische Ärzte und Google-Wissenschaftler haben kürzlich das vorab trainierte visuelle Sprachmodell Vid2Seq vorgeschlagen, das mehrere Ereignisse in einem Video unterscheiden und beschreiben kann. Dieses Papier wurde vom CVPR 2023 angenommen.

Kürzlich haben Forscher von Google ein vorab trainiertes visuelles Sprachmodell zur Beschreibung von Videos mit mehreren Ereignissen vorgeschlagen – Vid2Seq, das von CVPR23 akzeptiert wurde.

Früher war das Verstehen von Videoinhalten eine herausfordernde Aufgabe, da Videos oft mehrere Ereignisse enthielten, die in unterschiedlichen Zeitskalen stattfanden.

Zum Beispiel umfasst ein Video, in dem ein Musher einen Hund an einen Schlitten bindet und der Hund dann zu rennen beginnt, einen langen Vorgang (die Hundeschlittenfahrt) und einen kurzen Vorgang (der Hund ist an den Schlitten angebunden).

Eine Möglichkeit, die Forschung zum Videoverständnis voranzutreiben, ist die Aufgabe der dichten Videoannotation, bei der alle Ereignisse in einem einminütigen Video zeitlich lokalisiert und beschrieben werden.

Papieradresse: https://arxiv.org/abs/2302.14115

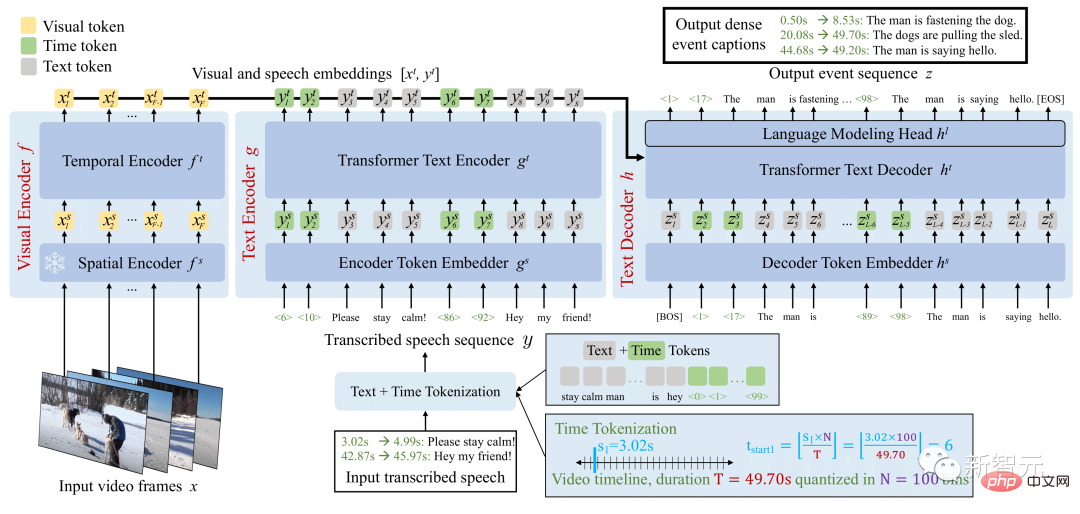

Die Vid2Seq-Architektur erweitert das Sprachmodell mit speziellen Zeitstempeln und ermöglicht so die nahtlose Vorhersage von Ereignisgrenzen und Textbeschreibungen in derselben Ausgabesequenz.

Um dieses einheitliche Modell vorab zu trainieren, nutzten die Forscher unbeschriftete Erzählvideos, indem sie die Satzgrenzen der transkribierten Sprache in Pseudo-Ereignis-Grenzen umformulierten und die transkribierten Sprachsätze als Pseudo-Ereignis-Anmerkungen verwendeten.

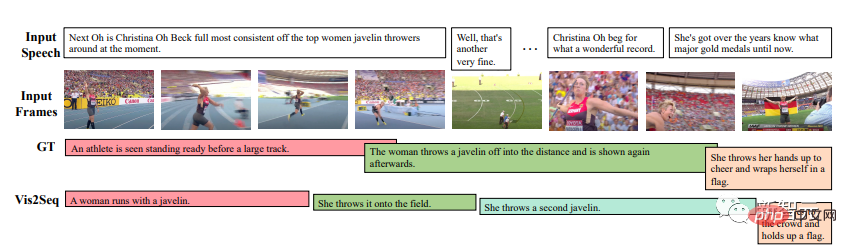

Übersicht über das Vid2Seq-Modell

Das resultierende Vid2Seq-Modell ist auf Millionen von kommentierten Videos vorab trainiert und verbessert so den Stand der Technik bei verschiedenen Benchmarks für dichte Videoanmerkungen, darunter YouCook2, ViTT und ActivityNet Captions.

Vid2Seq eignet sich auch gut für Videoanmerkungseinstellungen mit wenigen Aufnahmen, Videosegmentanmerkungsaufgaben und Standard-Videoanmerkungsaufgaben.

Die multimodale Transformer-Architektur hat die SOTA verschiedener Videoaufgaben, wie z. B. Aktionserkennung, aktualisiert. Die Anpassung einer solchen Architektur an die komplexe Aufgabe, Ereignisse in minutenlangen Videos gemeinsam zu lokalisieren und zu kommentieren, ist jedoch nicht einfach.

Um dieses Ziel zu erreichen, erweitern Forscher das visuelle Sprachmodell mit speziellen Zeitmarkierungen (z. B. Textmarkierungen), die diskrete Zeitstempel im Video darstellen, ähnlich wie Pix2Seq im räumlichen Bereich.

Für eine gegebene visuelle Eingabe kann das resultierende Vid2Seq-Modell sowohl die Eingabe akzeptieren als auch Text und zeitgetaggte Sequenzen generieren.

Erstens ermöglicht dies dem Vid2Seq-Modell, die zeitlichen Informationen der transkribierten Spracheingabe zu verstehen, die als einzelne Sequenz von Token projiziert wird. Zweitens ermöglicht dies Vid2Seq, gemeinsam zeitlich dichte Ereignisanmerkungen innerhalb des Videos vorherzusagen und gleichzeitig eine einzelne Sequenz von Markierungen zu generieren.

Die Vid2Seq-Architektur umfasst einen visuellen Encoder und einen Text-Encoder, die Videobilder bzw. transkribierte Spracheingaben kodieren. Die resultierenden Kodierungen werden dann an einen Textdecoder weitergeleitet, der automatisch die Ausgabesequenz dichter Ereignisanmerkungen sowie deren zeitliche Positionierung im Video vorhersagt. Die Architektur wird mit einem starken visuellen Rückgrat und einem starken Sprachmodell initialisiert.

Das manuelle Sammeln von Anmerkungen für eine dichte Videoanmerkung ist aufgrund des intensiven Charakters der Aufgabe besonders kostspielig.

Daher trainierten die Forscher das Vid2Seq-Modell vorab mit unbeschrifteten Erzählvideos, die in großem Maßstab leicht verfügbar sind. Sie verwendeten auch den YT-Temporal-1B-Datensatz, der 18 Millionen kommentierte Videos aus einem breiten Spektrum von Bereichen umfasst.

Zur Überwachung nutzen die Forscher transkribierte Sprachsätze und ihre entsprechenden Zeitstempel, die als einzelne Token-Sequenz projiziert werden.

Vid2Seq wird dann mit einem generativen Ziel vorab trainiert, das dem Decoder beibringt, bei visueller Eingabe nur transkribierte Sprachsequenzen vorherzusagen, und einem Entrauschungsziel, das multimodales Lernen fördert und erfordert, dass das Modell verrauschte transkribierte Sprache vorhersagt und Masken im Kontext vorhersagt von Reihenfolge und visuellem Input. Insbesondere wird der Sprachsequenz durch zufälliges Maskieren von Span-Tokens Rauschen hinzugefügt.

Das resultierende vorab trainierte Vid2Seq-Modell kann über ein einfaches Maximum-Likelihood-Ziel, das Lehrerzwang nutzt, auf Downstream-Aufgaben verfeinert werden (d. h. unter Berücksichtigung des vorherigen Ground-Truth-Tokens wird das nächste Token vorhergesagt).

Nach der Feinabstimmung übertrifft Vid2Seq SOTA bei drei Standard-Downstream-Benchmarks für dichte Videoanmerkungen (ActivityNet Captions, YouCook2 und ViTT) und zwei Videoclip-Annotationsbenchmarks (MSR-VTT, MSVD).

In der Arbeit gibt es zusätzliche Ablationsstudien, qualitative Ergebnisse und Ergebnisse in der Einstellung mit wenigen Aufnahmen und Anmerkungsaufgaben für Videoabsätze.

Die Ergebnisse zeigen, dass Vid2Seq aussagekräftige Ereignisgrenzen und -anmerkungen vorhersagen kann und dass sich die vorhergesagten Anmerkungen und Grenzen erheblich von der transkribierten Spracheingabe unterscheiden (dies zeigt auch die Bedeutung visueller Markierungen in der Eingabe).

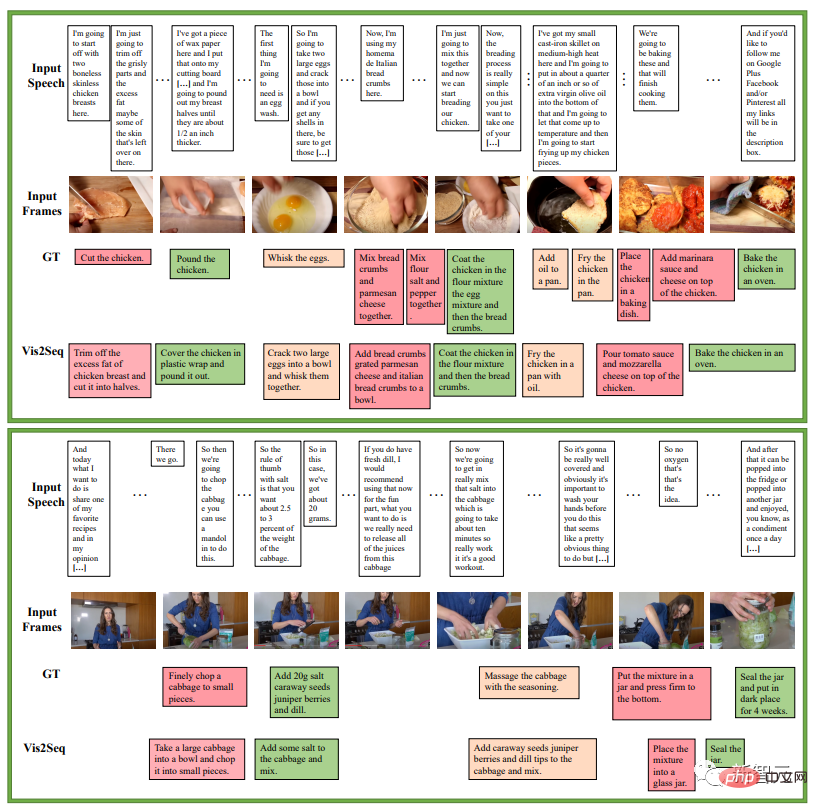

Das nächste Beispiel handelt von einer Reihe von Anweisungen in einem Kochrezept. Es ist ein Beispiel für die Vorhersage dichter Ereignisanmerkungen von Vid2Seq auf dem YouCook2-Validierungssatz:

Das nächste Beispiel ist die dichte Ereignisanmerkung von Vid2Seq Validierungssatz für ActivityNet-Untertitel. Vorhersagebeispiele. In all diesen Videos gibt es keine transkribierte Sprache.

Es wird jedoch immer noch Fälle von Fehlern geben, wie zum Beispiel das unten rot markierte Bild, in dem Vid2Seq besagt, dass es sich um eine Person handelt, die vor der Kamera ihren Hut abnimmt.

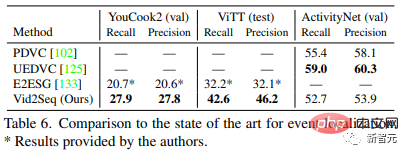

Tabelle 5 vergleicht Vid2Seq mit den fortschrittlichsten dichten Videoannotationsmethoden: Vid2Seq aktualisiert SOTA für drei Datensätze: YouCook2, ViTT und ActivityNet Captions.

Vid2Seqs SODA-Indikatoren auf YouCook2 und ActivityNet Captions sind 3,5 bzw. 0,3 Punkte höher als PDVC und UEDVC. Und E2ESG verwendet domäneninternes Klartext-Vortraining auf Wikihow, und Vid2Seq ist besser als diese Methode. Diese Ergebnisse zeigen, dass das vorab trainierte Vid2Seq-Modell über eine starke Fähigkeit verfügt, dichte Ereignisse zu kennzeichnen.

Tabelle 6 bewertet die Ereignislokalisierungsleistung des dichten Videoannotationsmodells. Im Vergleich zu YouCook2 und ViTT ist Vid2Seq besser darin, dichte Videoanmerkungen als einzelne Sequenzgenerierungsaufgabe zu verarbeiten.

Allerdings schneidet Vid2Seq bei ActivityNet-Untertiteln im Vergleich zu PDVC und UEDVC nicht gut ab. Im Vergleich zu diesen beiden Methoden beinhaltet Vid2Seq weniger Vorwissen über die zeitliche Lokalisierung, während die anderen beiden Methoden aufgabenspezifische Komponenten wie Ereigniszähler umfassen oder ein Modell separat für die Teilaufgabe der Lokalisierung trainieren. Details zur Implementierung

Der Autor verwendet den Adam-Optimierer, β=(0,9, 0,999), ohne Gewichtsabnahme.

Während des Vortrainings wird eine Lernrate von 1e^-4 verwendet, in den ersten 1000 Iterationen linear aufgewärmt (beginnend bei 0) und in den verbleibenden Iterationen konstant gehalten.

Fazit

Vid2Seq ist ein neues visuelles Sprachmodell für dichte Videoanmerkungen. Es kann effektiv ein umfangreiches Vortraining für unbeschriftete Erzählvideos durchführen und verschiedene nachgelagerte dichte Videoanmerkungen für den Benchmark durchführen.

Vorstellung des Autors

Erster Autor des Artikels: Antoine YangAntoine Yang ist Doktorand im dritten Jahr im WILLOW-Team von Inria und der École Normale Supérieure in Paris. Seine Betreuer sind Antoine Miech, Josef Sivic, Ivan Laptev und Cordelia Schmid.

Aktuelle Forschung konzentriert sich auf das Erlernen visueller Sprachmodelle für das Videoverständnis. Er absolvierte 2019 ein Praktikum im Noah's Ark Laboratory von Huawei, erhielt einen Ingenieurabschluss von der Ecole Polytechnique in Paris und einen Master-Abschluss in Mathematik, Vision und Lernen von der Nationalen Universität Paris-Saclay im Jahr 2020 und absolvierte 2022 ein Praktikum bei Google Research.

Das obige ist der detaillierte Inhalt vonGoogle führt multimodales Vid2Seq ein, um den Video-IQ online zu verstehen, Untertitel werden nicht offline sein CVPR 2023. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!