Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

IT Industrie

IT Industrie

Fortgeschrittene KI -Modelle generieren bis zu 50 -mal mehr CO ₂ Emissionen als häufigere LLMs bei der Beantwortung der gleichen Fragen

Fortgeschrittene KI -Modelle generieren bis zu 50 -mal mehr CO ₂ Emissionen als häufigere LLMs bei der Beantwortung der gleichen Fragen

Fortgeschrittene KI -Modelle generieren bis zu 50 -mal mehr CO ₂ Emissionen als häufigere LLMs bei der Beantwortung der gleichen Fragen

Je genauer wir versuchen, KI -Modelle zu funktionieren, desto größer werden ihre Kohlenstoffemissionen - mit bestimmten Aufforderungen, die laut einer kürzlich durchgeführten Studie bis zu 50 -mal mehr Kohlendioxid erzeugen als andere.

Argumentationsmodelle wie Claude von Anthropic, OpenAIs O3 und Deepseeks R1 sind erweiterte Großsprachenmodelle (LLMs), die zusätzliche Zeit- und Rechenressourcen zuweisen, um genauere Antworten im Vergleich zu früheren Versionen zu liefern.

Obwohl diese Modelle beeindruckende Ergebnisse erzielten, haben sie auch schwerwiegende Einschränkungen bei der Lösung komplexer Probleme gezeigt. Jetzt haben Forscher einen weiteren Nachteil aufgedeckt - ihren erheblichen CO2 -Fußabdruck. Ihre Ergebnisse wurden am 19. Juni in der Journal Frontiers in Kommunikation veröffentlicht.

"Die Umwelteinflüsse von Abfragen geschulter LLMs wird stark von ihrer Argumentationsmethode beeinflusst, wobei explizite Argumentationsmethoden die Energieverbrauch und die Kohlenstoffemissionen erheblich erhöhen", sagte Maximilian Dauner , ein Forscher an der Hochschule München Universität angewandter Wissenschaften in Deutschland, in einer Aussage . "Wir haben beobachtet, dass maßstreichende Modelle bis zu 50-mal mehr Co₂ emittiert als Modelle, die für kürzere Antworten optimiert wurden."

Wenn Sie auf Eingabeaufforderungen reagieren, verarbeiten LLMs Sprache, indem sie sie in Token aufteilt - Segmente von Wörtern, die in numerische Sequenzen umgewandelt wurden, bevor sie von neuronalen Netzwerken verarbeitet werden. Diese Netzwerke werden unter Verwendung von Trainingsdaten verfeinert, die die Wahrscheinlichkeit spezifischer Muster bestimmt. Basierend auf diesen Wahrscheinlichkeiten generieren sie Antworten.

Um die Genauigkeit zu verbessern, verwenden Argumentationsmodelle eine Methode, die als "Kette der Gedanken" bezeichnet wird. Dies beinhaltet die Aufschlüsselung eines komplexen Problems in kleinere, logische Schritte, ähnlich wie die Menschen das gleiche Problem lösen könnten.

Verwandte: KI "Halluzinaten", aber es gibt eine Möglichkeit, es zu beheben

Melden Sie sich für den Live Science Daily Newsletter an, das kautiert wird. Diese Modelle erfordern viel mehr Energie als Standard -LLMs und schaffen möglicherweise eine wirtschaftliche Herausforderung für Unternehmen und Benutzer, die sie implementieren möchten. Trotz einiger bestehender Untersuchungen zu den Umweltkonsequenzen der Erweiterung der KI -Nutzung bleiben direkte Vergleiche der CO2 -Fußabdrücke zwischen verschiedenen Modellen begrenzt.

Die Kosten für die Argumentation

Um die CO₂ -Emissionen aus verschiedenen Modellen zu bewerten, stellten die Forscher hinter dieser neuen Studie in mehreren Themen auf 14 LLM 1.000 Fragen. Die Modelle variierten in der Größe von 7 bis 72 Milliarden Parametern.

Diese Berechnungen wurden unter Verwendung des Perun -Frameworks - der die LLM -Leistung und den Stromverbrauch bewertet - bei einer NVIDIA A100 GPU durchgeführt. Das Team übersetzte dann den Energieverbrauch in CO₂-Emissionen, vorausgesetzt, jede Kilowattstunde erzeugt 480 Gramm Co₂ .

Ihre Ergebnisse zeigen, dass die Argumentationsmodelle im Durchschnitt 543,5 Token pro Frage generierten, verglichen mit nur 37,7 Token für präzise Modelle. Diese zusätzlichen Token bedeuteten erhöhte rechnerische Arbeitsbelastungen, was zu höheren CO₂ -Emissionen für genauere Argumentationsmodelle führte.

Das genaueste Modell war das 72 -Milliarden -Parameter -Cogito -Modell, das 84,9% der Benchmark -Fragen korrekt beantwortete. Cogito emittierte jedoch dreimal mehr Co₂ als Modelle mit ähnlich großer Größe, die kürzere Antworten erzeugen sollen.

"Gegenwärtig beobachten wir einen deutlichen Kompromiss zwischen Genauigkeit und Nachhaltigkeit in LLM-Technologien", erklärte Dauner. "Keines der Modelle, die die Emissionen unter 500 Gramm CO₂ -Äquivalent [Gesamtgase für Treibhausgase] aufrechterhalten haben, gelang es, mehr als 80% Genauigkeit bei der korrekten Beantwortung der 1.000 Fragen zu erreichen."

Das obige ist der detaillierte Inhalt vonFortgeschrittene KI -Modelle generieren bis zu 50 -mal mehr CO ₂ Emissionen als häufigere LLMs bei der Beantwortung der gleichen Fragen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Stock Market GPT

KI-gestützte Anlageforschung für intelligentere Entscheidungen

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Die neuen Elternkontrollen und psychische Gesundheitsschutz für Chatgpt zielen darauf ab, die KI für Teenager sicherer zu machen.

Sep 15, 2025 am 12:06 AM

Die neuen Elternkontrollen und psychische Gesundheitsschutz für Chatgpt zielen darauf ab, die KI für Teenager sicherer zu machen.

Sep 15, 2025 am 12:06 AM

OpenAI-Einsendungen der elterlichen Steuerelemente für Chatgptparenten können sich jetzt mit den Konten ihrer Teenager verbinden, Funktionen beschränken und Warnungen abrufen, wenn emotionale Bedrängnis Gespräche erfasst wird, die von speziell abgestimmten Modellen geschrieben werden, die zur Unterstützung der Verwendung geschult wurden, behandelt werden

Die AI -Podcast -Hosts von Google Notebooklm können jetzt in ein Argument über Ihre Notizen geraten

Sep 16, 2025 am 07:12 AM

Die AI -Podcast -Hosts von Google Notebooklm können jetzt in ein Argument über Ihre Notizen geraten

Sep 16, 2025 am 07:12 AM

NotebookLM von Google bietet jetzt neue Audioübersichtsformate: Kurz-, Kritik- und Debatethese-Ergänzungen bringen lebendigere Interaktionen und strukturierte Diskussionen zum Hochladen von Inhalten. Die Verbesserung bringt das Tool näher an interaktiver KI im Podcast-Stil.

KI bedeutet, dass Datenverletzungen jetzt viel weniger kosten - aber sie sind immer noch eine große Bedrohung für Unternehmen

Sep 21, 2025 am 12:24 AM

KI bedeutet, dass Datenverletzungen jetzt viel weniger kosten - aber sie sind immer noch eine große Bedrohung für Unternehmen

Sep 21, 2025 am 12:24 AM

KI verknüpft die Zeit, die für die Erkennung und Reaktion auf Datenverletzungen benötigt wird. Berichte von AI-Anwendern sparen bis zu 600.000 GBP pro Verstoß im Vergleich zu nicht sanftüber nicht 33% der britischen Organisationen, die KI in ihren Sicherheitsstrategien in den richtigen Erkenntnissen von IBM in umgesetzt haben

Microsoft warnt vor langsamem Azure -Verkehr

Sep 17, 2025 am 05:33 AM

Microsoft warnt vor langsamem Azure -Verkehr

Sep 17, 2025 am 05:33 AM

Microsoft hat eine Warnung vor einer erhöhten Netzwerklatenz veröffentlicht, die Azure -Dienste aufgrund von Störungen der im Roten Meer befindlichen Unterwasserkabel betrifft und das Unternehmen dazu zwingt, den Verkehr über alternative Routen umzuleiten.

GPT 5 gegen GPT 4O: Was ist besser?

Sep 18, 2025 am 03:21 AM

GPT 5 gegen GPT 4O: Was ist besser?

Sep 18, 2025 am 03:21 AM

Die neueste Veröffentlichung von GPT-5 hat die Welt im Sturm erobert. Das neueste Flaggschiff -Modell von OpenAI hat gemischte Kritiken erhalten - während einige seine Fähigkeiten loben, andere unterstreichen seine Mängel. Das hat mich gefragt: Ist gpt-

FBI warn

Sep 14, 2025 am 12:42 AM

FBI warn

Sep 14, 2025 am 12:42 AM

Das FBI hat eine kritische Sicherheitswarnung veröffentlicht und warnte, dass das berüchtigte Hacking-Kollektiv als Salt Typhoon seine Cyber-Operationen weltweit verstärkt. Für die Agentur ist diese chinesische staatlich unterstützte Gruppe weit verbreitet.

Das AI Trust Paradox: Wie regulierte Industrien in einer KI-gesteuerten Welt glaubwürdig bleiben können

Sep 21, 2025 am 12:36 AM

Das AI Trust Paradox: Wie regulierte Industrien in einer KI-gesteuerten Welt glaubwürdig bleiben können

Sep 21, 2025 am 12:36 AM

Wenn Sie vor fünf Jahren einen Raum voller risikoaverse Versicherungsmanager mitgeteilt hätten, dass fast die Hälfte der britischen Verbraucher bald die Gesundheitsberatung von KI begrüßen würden, wären Sie mit ernsthafter Skepsis, wenn nicht sogar gelacht.

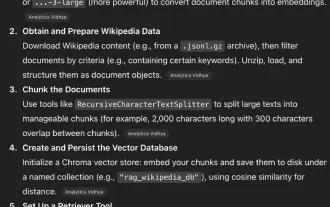

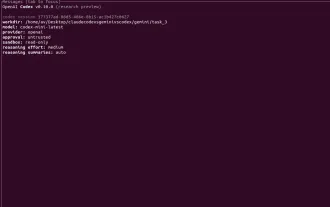

Codex Cli vs Gemini Cli gegen Claude Code: Welches ist das Beste?

Sep 18, 2025 am 04:06 AM

Codex Cli vs Gemini Cli gegen Claude Code: Welches ist das Beste?

Sep 18, 2025 am 04:06 AM

Im Jahr 2025 wird eine Reihe von AI -Programmierassistenten, auf die direkt vom Terminal aus zugegriffen werden kann, nacheinander freigegeben. Codex CLI, Gemini CLI und Claude Code sind einige dieser beliebten Tools, die große Sprachmodelle in Befehlszeilen -Workflows einbetten. Diese Programmierwerkzeuge können Code durch natürliche Sprachanweisungen generieren und reparieren und sehr leistungsfähig sind. Wir haben die Leistung dieser drei Tools in verschiedenen Aufgaben überprüft, um zu bestimmen, welcher praktischer ist. Jeder Assistent basiert auf fortschrittlichen KI-Modellen wie O4-Mini, Gemini 2.5 Pro oder Claude Sonnet 4, die zur Verbesserung der Entwicklungseffizienz entwickelt wurden. Wir setzen die drei in derselben Umgebung und verwenden bestimmte Metriken