Deep Learning, eine leistungsstarke Untergruppe des maschinellen Lernens, ermöglicht Computern, aus Beispielen zu lernen, und spiegelt das menschliche Lernen wider. Stellen Sie sich vor, Sie beibringen einen Computer, um Katzen zu identifizieren - anstatt explizit Funktionen zu definieren, zeigen Sie ihm unzählige Katzenbilder. Der Computer identifiziert autonom gemeinsame Muster und lernt, Katzen zu erkennen. Dies ist das Kernprinzip des tiefen Lernens.

Technisch gesehen nutzt Deep Learning künstliche neuronale Netze, die von der Struktur des menschlichen Gehirns inspiriert sind. Diese Netzwerke umfassen miteinander verbundene Knoten (Neuronen), die in Schichten angeordnet sind und Informationen nacheinander verarbeiten. Je mehr Schichten, desto "tiefer" das Netzwerk, das das Erlernen immer komplexerer Muster und die Ausführung komplexer Aufgaben ermöglicht.

Die von Gehirn inspirierte Architektur neuronaler Netze

Das maschinelle Lernen, selbst ein Zweig der künstlichen Intelligenz (KI), ermöglicht Computern, aus Daten zu lernen und Entscheidungen ohne explizite Programmierung zu treffen. Es umfasst verschiedene Techniken, mit denen Systeme Muster erkennen, die Ergebnisse vorhersagen und die Leistung im Laufe der Zeit verbessern können. Deep Learning erweitert maschinelles Lernen, indem sie Aufgaben automatisieren, die bisher menschliches Know -how benötigen.

Deep Learning unterscheidet sich durch den Einsatz neuronaler Netzwerke mit drei oder mehr Schichten. Diese Netzwerke versuchen, die Funktionalität des menschlichen Gehirns nachzuahmen und aus riesigen Datensätzen zu lernen.

Feature Engineering umfasst das Auswählen, Transformieren oder Erstellen der relevantesten Variablen (Funktionen) aus Rohdaten für die Verwendung in maschinellen Lernmodellen. Beispielsweise können bei der Wettervorhersage Rohdaten Temperatur, Luftfeuchtigkeit und Windgeschwindigkeit umfassen. Feature Engineering bestimmt, welche Variablen am prädiktivsten sind, und transformiert sie (z. B. Umwandlung von Fahrenheit in Celsius) für eine optimale Modellleistung.

Traditionelles maschinelles Lernen erfordert häufig manuelle und zeitaufwändige Feature-Engineering und erfordert Domain-Expertise. Ein wesentlicher Vorteil von Deep Learning ist die Fähigkeit, relevante Funktionen aus Rohdaten automatisch zu lernen und die manuelle Intervention zu minimieren.

Die Dominanz von Deep Learning ergibt sich aus mehreren wichtigen Vorteilen:

Dieser Leitfaden befasst sich mit den Kernkonzepten von Deep Learning und bereitet Sie auf eine Karriere in der KI vor. Betrachten Sie für praktische Übungen unseren Kurs "Einführung in das Deep Learning in Python".

Vor der Erforschung von tiefen Lernalgorithmen und Anwendungen ist das Verständnis der grundlegenden Konzepte von entscheidender Bedeutung. In diesem Abschnitt werden die Bausteine eingeführt: neuronale Netze, tiefe neuronale Netzwerke und Aktivierungsfunktionen.

Der Kern von Deep Learning ist das künstliche neuronale Netzwerk, ein vom menschlicher Gehirn inspiriertes Computermodell. Diese Netzwerke bestehen aus miteinander verbundenen Knoten ("Neuronen"), die Informationen gemeinsam verarbeiten und Entscheidungen treffen. Ähnlich wie bei den speziellen Regionen des Gehirns haben neuronale Netze Ebenen für bestimmte Funktionen.

Ein "tiefes" neuronales Netzwerk wird durch seine mehreren Schichten zwischen Eingabe und Ausgabe unterschieden. Diese Tiefe ermöglicht das Lernen hochkomplexer Merkmale und genauere Vorhersagen. Die Tiefe ist die Quelle des Namens von Deep Learning und deren Kraft bei der Lösung komplizierter Probleme.

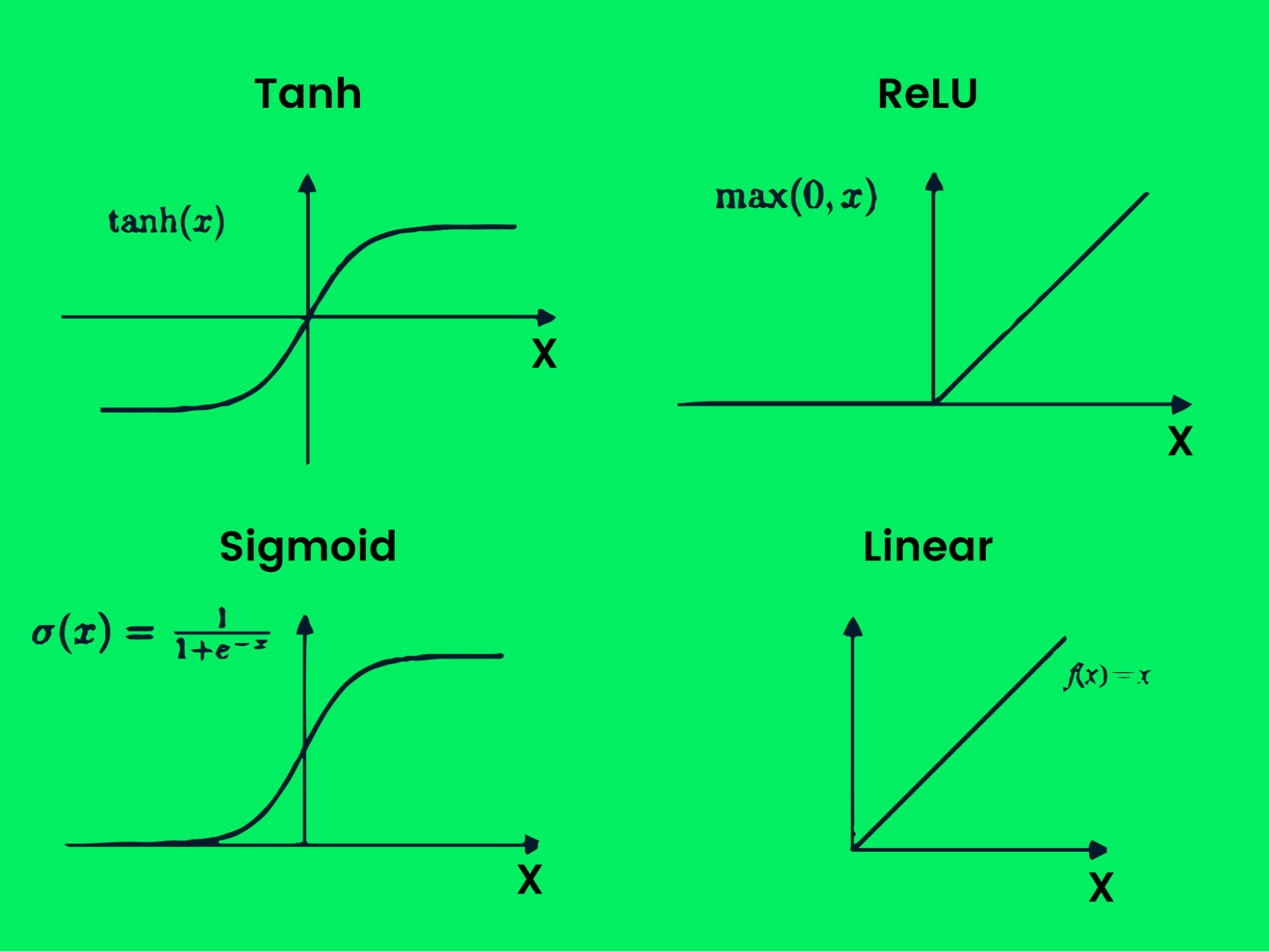

Aktivierungsfunktionen fungieren als Entscheidungsträger in einem neuronalen Netzwerk und bestimmen, welche Informationen in die nächste Schicht erfolgen. Diese Funktionen bringen Komplexität ein und ermöglichen es dem Netzwerk, aus Daten zu lernen und differenzierte Entscheidungen zu treffen.

Deep Learning verwendet die Feature -Extraktion, um ähnliche Merkmale im selben Etikett zu erkennen und verwendet Entscheidungsgrenzen, um Funktionen genau zu klassifizieren. In einem Katze -Hund -Klassifizierer unterteilt die Modellextrakte wie Augenform, Gesichtsstruktur und Körperform sie dann in verschiedene Klassen.

Deep Learning -Modelle nutzen tiefe neuronale Netze. Ein einfaches neuronales Netzwerk verfügt über eine Eingangsschicht, eine versteckte Schicht und eine Ausgangsschicht. Deep Learning -Modelle haben mehrere versteckte Schichten, die die Genauigkeit mit jeder zusätzlichen Ebene verbessern.

Eine einfache Illustration des neuronalen Netzwerks

Eine einfache Illustration des neuronalen Netzwerks

Eingabebenen empfangen Rohdaten und übergeben sie an versteckte Schichtknoten. Versteckte Ebenen klassifizieren Datenpunkte basierend auf den Zielinformationen und verengen den Umfang schrittweise, um genaue Vorhersagen zu erzeugen. Die Ausgabeschicht verwendet versteckte Schichtinformationen, um die wahrscheinlichste Beschriftung auszuwählen.

Beantwortung einer gemeinsamen Frage: Ist Deep lernen eine Form künstlicher Intelligenz? Die Antwort lautet ja. Deep Learning ist eine Untergruppe des maschinellen Lernens, was wiederum eine Teilmenge von KI ist.

Die Beziehung zwischen AI, ML und DL

Die Beziehung zwischen AI, ML und DL

AI zielt darauf ab, intelligente Maschinen zu schaffen, die die menschliche Intelligenz nachahmen oder übertreffen. AI verwendet maschinelles Lernen und tiefgreifende Lernmethoden, um menschliche Aufgaben zu erledigen. Deep Learning, der fortschrittlichste Algorithmus, ist eine entscheidende Komponente der Entscheidungsfunktionen von AI.

Deep Learning macht zahlreiche Anwendungen, von Netflix -Filmempfehlungen bis hin zu Amazon Warehouse Management Systems.

Computer Vision (CV) wird in selbstfahrenden Autos zur Vermeidung von Objekterkennungen und zur Kollision sowie zur Erkennung von Gesicht, zur Einschätzung von Posen, zur Bildklassifizierung und zur Erkennung von Anomalie verwendet.

Gesichtserkennung durch tiefes Lernen angetrieben

Gesichtserkennung durch tiefes Lernen angetrieben

ASR ist in Smartphones allgegenwärtig, aktiviert durch Sprachbefehle wie "Hey, Google" oder "Hi, Siri". Es wird auch für die Erkennung von Text-zu-Sprach-, Audioklassifizierung und Sprachaktivität verwendet.

Sprachmustererkennung

Sprachmustererkennung

Generative AI, ein Beispiel durch die Erstellung von Kryptopunks-NFTs und das GPT-4-Modell von Openai (Powering ChatGPT) erzeugt synthetische Kunst, Text, Video und Musik.

Generative Kunst

Generative Kunst

Deep Learning erleichtert die Sprachübersetzung, die Übersetzung von Foto-zu-Text-Übersetzung (OCR) und Text-zu-Image-Übersetzung.

Sprachübersetzung

Sprachübersetzung

Deep Learning prognostiziert Marktunfälle, Aktienkurse und Wettermuster, die für finanzielle und andere Branchen von entscheidender Bedeutung sind.

Zeitreihenprognose

Zeitreihenprognose

Deep Learning automatisiert Aufgaben wie Lagermanagement und Roboterkontrolle und ermöglicht es KI, menschliche Spieler in Videospielen zu übertreffen.

Roboterarm, der durch tiefes Lernen kontrolliert wird

Roboterarm, der durch tiefes Lernen kontrolliert wird

Deep Learning Processing Customer Feedback und Powers Chatbot -Anwendungen für den nahtlosen Kundenservice.

Kundenfeedback -Analyse

Kundenfeedback -Analyse

Deep Learning unterstützt die Erkennung von Krebs, die Entwicklung von Arzneimitteln, die Erkennung von Anomalie in der medizinischen Bildgebung und die Unterstützung medizinischer Geräte.

Analyse von DNA -Sequenzen

Analyse von DNA -Sequenzen

In diesem Abschnitt werden verschiedene tiefe Lernmodelle und ihre Funktionen untersucht.

Das überwachte Lernen verwendet beschriftete Datensätze, um Modelle zur Klassifizierung oder Vorhersage zu trainieren. Der Datensatz enthält Funktionen und Zielbezeichnungen, sodass der Algorithmus lernen kann, indem der Unterschied zwischen vorhergesagten und tatsächlichen Beschriftungen minimiert wird. Dies umfasst Klassifizierungs- und Regressionsprobleme.

Klassifizierungsalgorithmen kategorisieren Daten basierend auf extrahierten Merkmalen. Beispiele sind ResNet50 (Bildklassifizierung) und Bert (Textklassifizierung).

Einstufung

Einstufung

Regressionsmodelle prognostizieren die Ergebnisse, indem sie die Beziehung zwischen Eingabe- und Ausgangsvariablen lernen. Sie werden für die Vorhersageanalyse, die Wettervorhersage und die Vorhersage von Aktienmarkten verwendet. LSTM und RNN sind beliebte Regressionsmodelle.

Lineare Regression

Lineare Regression

Unüberwachte Lernalgorithmen identifizieren Muster in nicht morschenden Datensätzen und erstellen Cluster. Deep Learning -Modelle lernen verborgene Muster ohne menschliche Intervention, die häufig in Empfehlungssystemen verwendet werden. Anwendungen umfassen Artengruppierung, medizinische Bildgebung und Marktforschung. Tiefe eingebettete Clustering ist ein gemeinsames Modell.

Datenclustering

Datenclustering

RL umfasst Agenten Lernverhalten aus einer Umgebung durch Versuch und Irrtum, wodurch die Belohnungen maximiert werden. RL wird für Automatisierung, selbstfahrende Autos, Spielspiel und Raketenlandung verwendet.

Verstärkungslernrahmen

Verstärkungslernrahmen

Gans verwenden zwei neuronale Netzwerke (Generator und Diskriminator), um synthetische Instanzen von Originaldaten zu erstellen. Sie werden verwendet, um synthetische Kunst, Video, Musik und Text zu generieren.

Generatives kontroverses Netzwerkrahmen

Generatives kontroverses Netzwerkrahmen

GNNs arbeiten direkt auf Grafikstrukturen, die in großen Datensatzanalysen, Empfehlungssystemen und Computer Vision für Knotenklassifizierung, Link -Vorhersage und Clustering verwendet werden.

Eine gerichtete Grafik

Eine gerichtete Grafik

Ein Grafiknetzwerk

Ein Grafiknetzwerk

NLP verwendet Deep Learning, um Computern die menschliche Sprache, Verarbeitung von Sprache, Text und Bildern zu ermöglichen. Transferlernen verbessert NLP durch Feinabstimmungsmodelle mit minimalen Daten, um eine hohe Leistung zu erzielen.

Unterkategorien von NLP

Unterkategorien von NLP

Aktivierungsfunktionen erzeugen Ausgangsentscheidungsgrenzen und verbessern die Modellleistung. Sie führen die Nichtlinearität in Netzwerke ein. Beispiele sind Tanh, Relu, Sigmoid, Linear, Softmax und Swish.

Aktivierungsfunktion Graph

Aktivierungsfunktion Graph

Die Verlustfunktion misst die Differenz zwischen tatsächlichen und vorhergesagten Werten und Tracking -Modellleistung. Beispiele sind Binärkreuzentropie, kategorisches Scharnier, mittlerer quadratischer Fehler, Huber und spärliche kategorische Kreuzentropie.

Die Backpropagation passt die Netzwerkgewichte an, um die Verlustfunktion zu minimieren und die Modellgenauigkeit zu verbessern.

Stochastischer Gradientenabruf optimiert die Verlustfunktion, indem sie iterativ Gewichte mithilfe von Probenstapeln einstellen und die Effizienz verbessern.

Hyperparameter sind einstellbare Parameter, die die Modellleistung beeinflussen, wie Lernrate, Chargengröße und Anzahl der Epochen.

CNNS -Prozess strukturierte Daten (Bilder) effektiv, hervorzuheben bei der Mustererkennung.

Faltungsarchitektur Neuronales Netzwerk

Faltungsarchitektur Neuronales Netzwerk

RNNs verarbeiten sequentielle Daten, indem sie die Ausgabe wieder in die Eingabe einfügen, was für die Zeitreihenanalyse und NLP nützlich ist.

Wiederkehrende neuronale Netzwerkarchitektur

Wiederkehrende neuronale Netzwerkarchitektur

LSTMs sind fortgeschrittene RNNs, die sich mit dem Verlustgradientenproblem befassen und die langfristigen Abhängigkeiten in sequentiellen Daten besser beibehalten.

LSTM -Architektur

LSTM -Architektur

Es gibt mehrere tiefe Lernrahmen, jeweils mit Stärken und Schwächen. Hier sind einige der beliebtesten:

TensorFlow ist eine Open-Source-Bibliothek zur Erstellung von Deep-Learning-Anwendungen, die CPU, GPU und TPU unterstützt. Es umfasst Tensorboard für die Experimentanalyse und integriert Keras für eine einfachere Entwicklung.

Keras ist eine benutzerfreundliche API für neuronale Netzwerke, die auf mehreren Backends (einschließlich Tensorflow) ausgeführt wird, was schnelle Experimente ermöglicht.

Pytorch ist bekannt für seine Flexibilität und Benutzerfreundlichkeit, die bei Forschern beliebt ist. Es verwendet Tensoren zur schnellen Berechnung und unterstützt die GPU- und TPU -Beschleunigung.

Dieser Leitfaden lieferte einen umfassenden Überblick über Deep Learning und behandelte seine Kernkonzepte, Anwendungen, Modelle und Frameworks. Um Ihr Lernen voranzutreiben, betrachten Sie unser tiefes Lernen in Python -Track oder tiefem Lernen mit Keras in R -Kursen.

Das obige ist der detaillierte Inhalt vonWas ist Deep Learning? Ein Tutorial für Anfänger. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!