Herausgeber |. ScienceAI

Frage- und Antwortdatensätze (QA) spielen eine wichtige Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen.

Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf.

Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells, wissenschaftliche Fragen zu beantworten, nicht vollständig testen. Im Gegensatz dazu kann die offene Fragebeantwortung (openQA) die Fähigkeiten des Modells umfassender bewerten, es fehlen jedoch geeignete Bewertungsmetriken.

Zweitens stammen viele Inhalte bestehender Datensätze aus Lehrbüchern auf Universitätsniveau und darunter, was es schwierig macht, die hochgradigen Wissensspeicherfähigkeiten von LLM in tatsächlichen akademischen Forschungs- oder Produktionsumgebungen zu bewerten.

Drittens basiert die Erstellung dieser Benchmark-Datensätze auf menschlichen Expertenkommentaren.

Die Bewältigung dieser Herausforderungen ist für den Aufbau eines umfassenderen QA-Datensatzes von entscheidender Bedeutung und trägt auch zu einer genaueren Bewertung des wissenschaftlichen LLM bei.

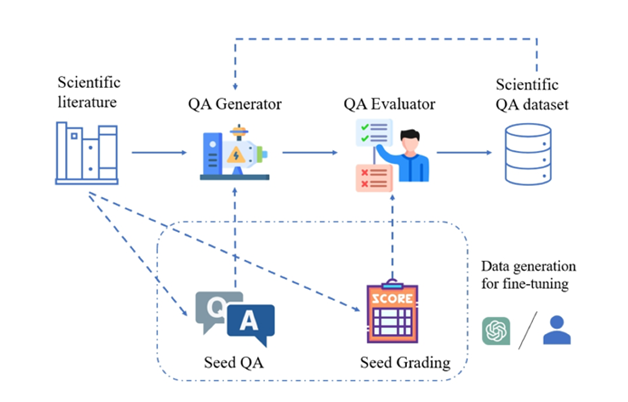

Abbildung: SciQAG-Framework zur Generierung hochwertiger wissenschaftlicher Frage- und Antwortpaare aus wissenschaftlicher Literatur.

Zu diesem Zweck haben das Argonne National Laboratory in den Vereinigten Staaten, das Team von Professor Ian Foster von der University of Chicago (Gordon-Bell-Preisträger 2002), das UNSW AI4Science-Team von Professor Bram Hoex von der University of New South Wales, Australien, das AI4Science-Unternehmen GreenDynamics und das Team von Professor Jie Chunyu von der City University of Hong Kong schlugen gemeinsam SciQAG vor, das erste neuartige Framework, das automatisch hochwertige wissenschaftliche offene Frage- und Antwortpaare aus großen wissenschaftlichen Literaturkorpora auf der Grundlage großer Sprachmodelle generiert (LLM).

Papierlink:https://arxiv.org/abs/2405.09939

Github-Link:https://github.com/MasterAI-EAM/SciQAG

Basierend auf SciQAG haben die Forscher erstellt SciQAG-24D, ein umfangreicher, hochwertiger, offener wissenschaftlicher QA-Datensatz, enthält 188.042 QA-Paare, die aus 22.743 wissenschaftlichen Arbeiten in 24 wissenschaftlichen Bereichen extrahiert wurden, und soll der Feinabstimmung von LLM und der Bewertung wissenschaftlicher Probleme dienen. Lösungsfähigkeiten.

Experimente zeigen, dass die Feinabstimmung von LLMs am SciQAG-24D-Datensatz ihre Leistung bei der Beantwortung offener Fragen und bei wissenschaftlichen Aufgaben erheblich verbessern kann.

Der Datensatz, das Modell und der Evaluierungscode wurden als Open Source bereitgestellt (https://github.com/MasterAI-EAM/SciQAG), um die gemeinsame Entwicklung offener wissenschaftlicher Fragen und Antworten durch die AI for Science-Community zu fördern.

SciQAG-Framework mit SciQAG-24D-Benchmark-Datensatz

SciQAG besteht aus einem QA-Generator und einem QA-Evaluator mit dem Ziel, schnell verschiedene offene Frage- und Antwortpaare auf der Grundlage wissenschaftlicher Literatur in großem Maßstab zu generieren. Zunächst wandelt der Generator wissenschaftliche Arbeiten in Frage-Antwort-Paare um, anschließend filtert der Bewerter die Frage-Antwort-Paare heraus, die nicht den Qualitätsstandards entsprechen, und erhält so einen qualitativ hochwertigen wissenschaftlichen Frage-Antwort-Datensatz.

QA-Generator

Die Forscher entwarfen durch vergleichende Experimente eine zweistufige Eingabeaufforderung (Prompt), die es LLM ermöglichte, zunächst Schlüsselwörter zu extrahieren und dann Frage- und Antwortpaare basierend auf den Schlüsselwörtern zu generieren.

Da der generierte Frage- und Antwortdatensatz den „geschlossenen Buch“-Modus annimmt, wird das Originalpapier nicht bereitgestellt und konzentriert sich nur auf das extrahierte wissenschaftliche Wissen selbst. Die Eingabeaufforderung erfordert, dass die generierten Frage- und Antwortpaare nicht darauf angewiesen sind auf oder verweisen Sie auf die eindeutigen Informationen in der Originalarbeit (z. B. ist keine moderne Nomenklatur zulässig, wie „diese/diese Arbeit“, „diese/diese Forschung“ usw.) oder stellen Sie Fragen zu den Tabellen/Bildern in der Artikel).

Um Leistung und Kosten in Einklang zu bringen, entschieden sich die Forscher für die Feinabstimmung eines Open-Source-LLM als Generator. SciQAG-Benutzer können je nach ihren eigenen Umständen ein beliebiges Open-Source- oder Closed-Source-LLM als Generator wählen, indem sie entweder Feinabstimmung oder Prompt-Word-Engineering nutzen.

QA-Evaluator

Der Evaluator wird verwendet, um zwei Zwecke zu erfüllen: (1) Bewerten der Qualität generierter Frage- und Antwortpaare; (2) Verwerfen von Frage- und Antwortpaaren geringer Qualität basierend auf festgelegten Kriterien.

Forscher haben einen umfassenden Bewertungsindex RACAR entwickelt, der aus fünf Dimensionen besteht: Relevanz, Agnostizismus, Vollständigkeit, Genauigkeit und Angemessenheit.

In dieser Studie verwendeten die Forscher GPT-4 direkt als QA-Evaluator, um die generierten QA-Paare gemäß RACAR mit einer Bewertungsstufe von 1–5 zu bewerten (1 bedeutet inakzeptabel, 5 bedeutet völlig akzeptabel).

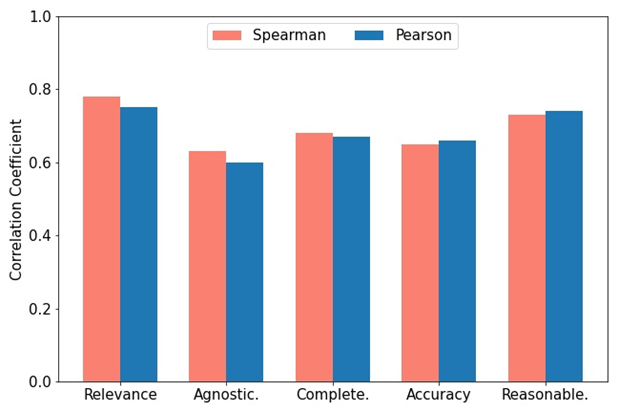

Wie in der Abbildung gezeigt, verwendeten zwei Domänenexperten zur Messung der Konsistenz zwischen GPT-4 und manueller Bewertung die RACAR-Metrik, um eine manuelle Bewertung für 10 Artikel (insgesamt 100 Frage- und Antwortpaare) durchzuführen. Benutzer können je nach Bedarf jedes Open-Source- oder Closed-Source-LLM als Evaluator wählen.

Abbildung: Spearman- und Pearson-Korrelationen zwischen zugewiesenen GPT-4-Bewertungen und Expertenanmerkungsbewertungen.

Anwendung des SciQAG-Frameworks

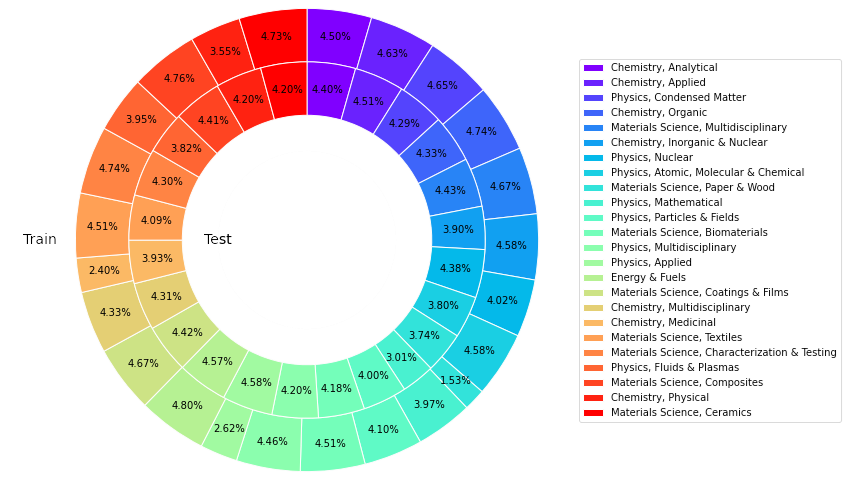

Diese Studie hat insgesamt 22.743 häufig zitierte Artikel in 24 Kategorien aus der Kernsammlungsdatenbank Web of Science (WoS) aus den Bereichen Materialwissenschaften, Chemie, Physik, Energie usw. erhalten. mit dem Ziel, eine zuverlässige, reichhaltige, ausgewogene und repräsentative Quelle wissenschaftlicher Erkenntnisse aufzubauen.

Um das Open-Source-LLM so zu verfeinern, dass ein QS-Generator entsteht, wählten die Forscher zufällig 426 Artikel aus der Papiersammlung als Eingabe aus und generierten durch Eingabe von GPT-4 4260 Start-QA-Paare.

Unter Verwendung des trainierten QA-Generators zur Durchführung von Rückschlüssen auf die verbleibenden Papiere wurden insgesamt 227.430 QA-Paare (einschließlich Seed-QA-Paare) generiert. Aus jeder Kategorie wurden fünfzig Artikel extrahiert (insgesamt 1.200 Artikel), GPT-4 wurde verwendet, um den RACAR-Score jedes generierten QA-Paares zu berechnen, und QA-Paare mit einem Dimensionsscore unter 3 wurden als Testsatz herausgefiltert.

Für die verbleibenden QA-Paare wird eine regelbasierte Methode verwendet, um alle Frage- und Antwortpaare herauszufiltern, die eindeutige Informationen des Papiers enthalten, um einen Trainingssatz zu bilden.

SciQAG-24D-Benchmark-Datensatz

Basierend auf dem oben Gesagten erstellten die Forscher den offenen wissenschaftlichen QA-Benchmark-Datensatz SciQAG-24D. Der gefilterte Trainingssatz umfasst 21.529 Artikel und 179.511 QA-Paare, und der gefilterte Testsatz enthält 1.199 Artikel und 8.531 QA-Paare.

Statistiken zeigen, dass 99,15 % der Daten in den Antworten aus der Originalarbeit stammen, 87,29 % der Fragen eine Ähnlichkeit unter 0,3 aufweisen und die Antworten 78,26 % des Originalinhalts abdecken.

Dieser Datensatz wird häufig verwendet: Der Trainingssatz kann zur Feinabstimmung von LLM und zum Einbringen wissenschaftlicher Erkenntnisse verwendet werden. Der Testsatz kann zur Bewertung der Leistung von LLM bei offenen Qualitätssicherungsaufgaben in einem bestimmten oder allgemeinen wissenschaftlichen Bereich verwendet werden . Da der Testsatz größer ist, können auch hochwertige Daten zur Feinabstimmung verwendet werden.

Abbildung: Der Anteil von Artikeln in verschiedenen Kategorien beim Training und Testen des SciQAG-24D-Datensatzes.

Experimentelle Ergebnisse

Die Forscher führten umfassende Experimente durch, um die Leistungsunterschiede bei der Beantwortung wissenschaftlicher Fragen zwischen verschiedenen Sprachmodellen zu vergleichen und die Auswirkungen der Feinabstimmung zu untersuchen.

Zero-Shot-Einstellung

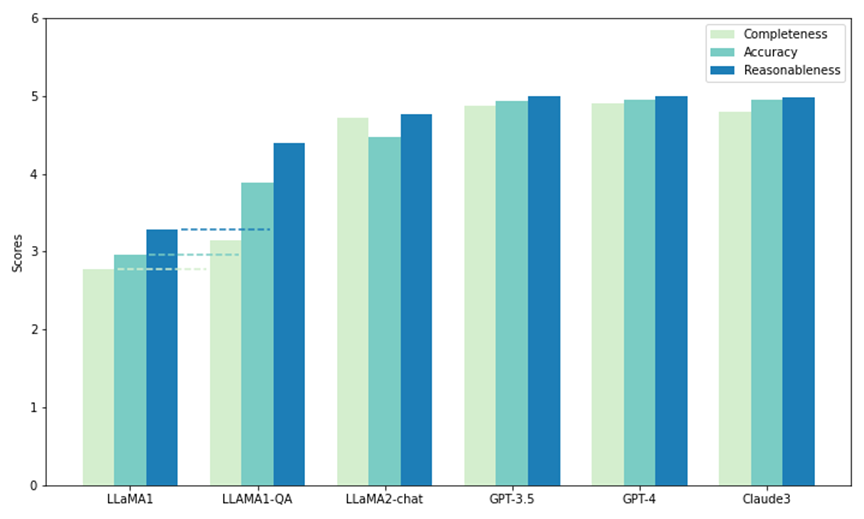

Die Forscher verwendeten einen Teil des Testsatzes in SciQAG-24D, um einen Zero-Shot-Leistungsvergleich der fünf Modelle durchzuführen. Zwei davon sind Open-Source-LLMs: LLaMA1 (7B) und LLaMA2-chat (7B), der Rest sind Closed-Source-LLMs.

Über API aufgerufen: GPT3.5 (gpt-3.5-turbo), GPT-4 (gpt-4-1106-preview) und Claude 3 (claude-3-opus-20240229). Jedes Modell wurde im Test mit 1.000 Fragen konfrontiert, und seine Ergebnisse wurden anhand der CAR-Metrik (angepasst von der RACAR-Metrik, die sich nur auf die Antwortbewertung konzentrierte) bewertet, um seine Zero-Shot-Fähigkeit zur Beantwortung wissenschaftlicher Forschungsfragen zu messen.

Wie in der Abbildung gezeigt, weist GPT-4 unter allen Modellen die höchste Punktzahl für Vollständigkeit (4,90) und Plausibilität (4,99) auf, während Claude 3 die höchste Genauigkeitsbewertung (4,95) aufweist. GPT-3.5 schneidet ebenfalls sehr gut ab und liegt bei allen Kennzahlen knapp hinter GPT-4 und Claude 3.

Bemerkenswert ist, dass LLaMA1 in allen drei Dimensionen die niedrigsten Werte aufweist. Im Gegensatz dazu schneidet das LLaMA2-Chat-Modell zwar nicht so gut ab wie das GPT-Modell, verbessert sich jedoch in allen Metriken deutlich gegenüber dem ursprünglichen LLaMA1. Die Ergebnisse zeigen die überlegene Leistung kommerzieller LLMs bei der Beantwortung wissenschaftlicher Fragestellungen, während auch Open-Source-Modelle (wie LLaMA2-chat) in dieser Hinsicht erhebliche Fortschritte gemacht haben.

Abbildung: Nullprobentest und Feinabstimmungstest (LLAMA1-QA) auf SciQAG-24D

Feinabstimmungseinstellung (Feinabstimmungseinstellung)

Die Forscher wählten LLaMA1 mit der schlechtesten Nullpunkt- Beispielleistung: Am Trainingssatz von SciQAG-24D wird eine Feinabstimmung durchgeführt, um LLaMA1-QA zu erhalten. Durch drei Experimente zeigten die Forscher, dass SciQAG-24D als effektive Feinabstimmungsdaten verwendet werden kann, um die Leistung nachgelagerter wissenschaftlicher Aufgaben zu verbessern:

(a) LLaMA-QA im Vergleich zum ursprünglichen LLaMA1 auf dem bisher unbekannten SciQAG-24D-Testsatz Leistung Vergleich.

Wie in der Abbildung oben gezeigt, wurde die Leistung von LLaMA1-QA im Vergleich zum ursprünglichen LLaMA1 deutlich verbessert (Vollständigkeit um 13 %, Genauigkeit und Plausibilität um mehr als 30 % erhöht). Dies zeigt, dass LLaMA1 die Logik der Beantwortung wissenschaftlicher Fragen aus den Trainingsdaten von SciQAG-24D gelernt und einige wissenschaftliche Erkenntnisse verinnerlicht hat.

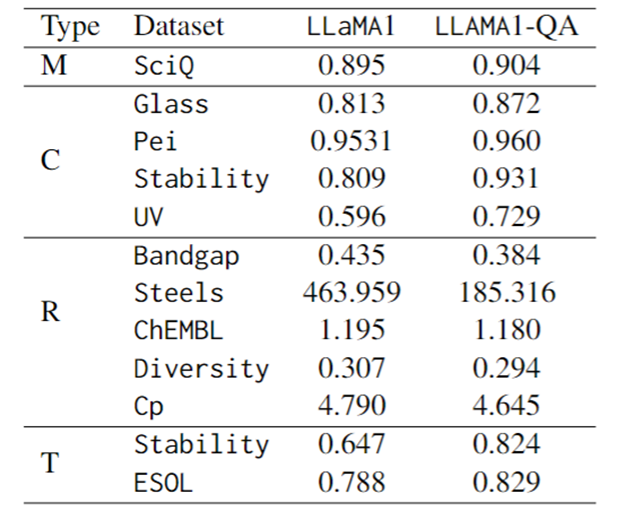

(b) Vergleich der Feinabstimmungsleistung bei SciQ, einem wissenschaftlichen MCQ-Benchmark.

Die erste Zeile der Tabelle unten zeigt, dass LLaMA1-QA etwas besser ist als LLaMA1 (+1 %). Beobachtungen zufolge verbesserte die Feinabstimmung auch die Fähigkeit des Modells, Anweisungen zu folgen: Die Wahrscheinlichkeit einer nicht parsbaren Ausgabe sank von 4,1 % in LLaMA1 auf 1,7 % in LLaMA1-QA.

(c) Vergleich der Feinabstimmungsleistung bei verschiedenen wissenschaftlichen Aufgaben.

In Bezug auf Bewertungsindikatoren wird der F1-Score für Klassifizierungsaufgaben, der MAE für Regressionsaufgaben und die KL-Divergenz für Transformationsaufgaben verwendet. Wie in der folgenden Tabelle dargestellt, weist LLaMA1-QA im Vergleich zum LLaMA1-Modell bei wissenschaftlichen Aufgaben erhebliche Verbesserungen auf.

Die offensichtlichste Verbesserung spiegelt sich in der Regressionsaufgabe wider, bei der der MAE von 463,96 auf 185,32 sank. Diese Ergebnisse legen nahe, dass die Einbeziehung von QA-Paaren während des Trainings die Fähigkeit des Modells, wissenschaftliche Erkenntnisse zu lernen und anzuwenden, verbessern und dadurch seine Leistung bei nachgelagerten Vorhersageaufgaben verbessern kann.

Überraschenderweise kann LLM im Vergleich zu speziell entwickelten maschinellen Lernmodellen mit Funktionen bei einigen Aufgaben vergleichbare Ergebnisse erzielen oder diese sogar übertreffen. Beispielsweise schneidet LLaMA1-QA bei der Bandlückenaufgabe zwar nicht so gut ab wie Modelle wie MODNet (0,3327), hat aber AMMExpress v2020 (0,4161) übertroffen.

Bei der Diversitätsaufgabe übertrifft LLaMA1-QA die Deep-Learning-Basislinie (0,3198). Diese Ergebnisse deuten darauf hin, dass LLM großes Potenzial für spezifische wissenschaftliche Aufgaben hat.

Abbildung: Feinabstimmung der Leistung von LLaMA1 und LLaMA1-QA bei SciQ und wissenschaftlichen Aufgaben (M steht für Multiple Choice, C für Klassifizierung, R für Regression, T für Transformation)

Zusammenfassung und Ausblick

( 1) SciQAG ist ein Framework zur Generierung von QA-Paaren aus wissenschaftlicher Literatur. In Kombination mit der RACAR-Metrik zur Bewertung und Überprüfung von QA-Paaren können große Mengen wissensbasierter QA-Daten für ressourcenarme wissenschaftliche Bereiche effizient generiert werden.

(2) Das Team hat einen umfassenden Open-Source-Datensatz zur wissenschaftlichen Qualitätssicherung mit 188.042 Qualitätssicherungspaaren namens SciQAG-24D erstellt. Der Trainingssatz wird zur Feinabstimmung des LLM verwendet, und der Testsatz bewertet die Leistung des LLM bei offenen, geschlossenen wissenschaftlichen Qualitätssicherungsaufgaben.

Verglich die Nullstichprobenleistung mehrerer LLMs auf dem SciQAG-24D-Testsatz und optimierte LLaMA1 auf dem SciQAG-24D-Trainingssatz, um LLaMA1-QA zu erhalten. Diese Feinabstimmung verbessert die Leistung bei mehreren wissenschaftlichen Aufgaben erheblich.

(3) Untersuchungen zeigen, dass LLM Potenzial für wissenschaftliche Aufgaben hat und die Ergebnisse von LLaMA1-QA ein Niveau erreichen können, das sogar über die Basislinie des maschinellen Lernens hinausgeht. Dies zeigt den vielfältigen Nutzen von SciQAG-24D und zeigt, dass die Einbeziehung wissenschaftlicher QS-Daten in den Schulungsprozess die Fähigkeit von LLM verbessern kann, wissenschaftliche Erkenntnisse zu erlernen und anzuwenden.

以上是Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt的详细内容。更多信息请关注PHP中文网其他相关文章!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

cad2012 Seriennummer und Schlüsselübergabe

cad2012 Seriennummer und Schlüsselübergabe

So überspringen Sie die Netzwerkverbindung während der Win11-Installation

So überspringen Sie die Netzwerkverbindung während der Win11-Installation

Welche Methoden gibt es zum Neustarten von Anwendungen in Android?

Welche Methoden gibt es zum Neustarten von Anwendungen in Android?

So verbergen Sie die IP-Adresse auf TikTok

So verbergen Sie die IP-Adresse auf TikTok

So öffnen Sie eine MDS-Datei

So öffnen Sie eine MDS-Datei

So lösen Sie das Problem der fehlenden ssleay32.dll

So lösen Sie das Problem der fehlenden ssleay32.dll