AIxiv 칼럼은 본 사이트에 학술적, 기술적 내용을 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

최근 몇 년간 단편 동영상 생태계가 급부상했고, 단편 동영상을 중심으로 한 창의적이고 편집 도구인 Meitu의 전문적인 Wink가 지속적으로 등장하고 있습니다. 모바일 영상 편집 툴은 독보적인 영상 품질 복원 기능으로 선두를 달리고 있으며, 국내외 사용자가 지속적으로 증가하고 있습니다. Wink의 이미지 품질 복구 기능의 인기 뒤에는 비디오 편집 애플리케이션에 대한 수요가 가속화되는 가운데 흐릿한 이미지, 심각한 노이즈, 낮은 이미지 품질과 같은 사용자의 비디오 제작 문제점에 대한 Meitu의 통찰력이 있습니다. 또한, 이는 또한 Meitu Imaging Research Institute(MT Lab)의 강력한 비디오 복원 및 비디오 향상 기술 지원을 기반으로 현재 이미지 품질 복원 - HD, 이미지 품질 복원 - Ultra HD, 이미지 품질 복원 - 인물 향상, 및 해상도 개선 및 기타 기능. 최근 메이투 이미징 연구소(MT Lab)와 중국과학원은 조명 깜박임 저하를 처리하는 획기적인 새로운 STE 기반 블라인드 비디오 디플리커링(BVD) 방법인 BlazeBVD를 제안했습니다. 원본 영상 내용의 무결성과 색상을 최대한 유지한 알 수 없는 저화질 영상이 최고의 컴퓨터 비전 컨퍼런스인 ECCV 2024에 채택되었습니다.

- Papierlink: https://arxiv.org/pdf/2403.06243v1

Videoflimmern kann leicht die Zeitkonsistenz beeinträchtigen, und Zeitkonsistenz ist ein Muss Bedingung für die Videoausgabe, selbst ein schwaches Videoflimmern kann das Seherlebnis ernsthaft beeinträchtigen. Der Grund liegt im Allgemeinen in einer schlechten Aufnahmeumgebung und Hardwareeinschränkungen der Aufnahmeausrüstung. Wenn Bildverarbeitungstechnologie auf Videobilder angewendet wird, wird dieses Problem häufig noch verschärft. Darüber hinaus treten bei neueren Videogenerierungsaufgaben häufig Flimmerartefakte und Farbverzerrungen auf, einschließlich solcher, die auf generativen gegnerischen Netzwerken (GAN) und Diffusionsmodellen (DM) basieren. Daher ist es in verschiedenen Videoverarbeitungsszenarien von entscheidender Bedeutung, Blind Video Deflickering (BVD) zu untersuchen, um Videoflimmern zu beseitigen und die Integrität von Videoinhalten aufrechtzuerhalten. Die BVD-Aufgabe wird nicht von der Ursache und dem Ausmaß des Videoflimmerns beeinflusst und bietet ein breites Anwendungsspektrum. Der aktuelle Schwerpunkt auf solchen Aufgaben umfasst hauptsächlich die Restaurierung alter Filme, Hochgeschwindigkeitskameraaufnahmen und die Verarbeitung von Farbverzerrungen usw. und Videoflimmertypen, Aufgaben, die nichts mit dem Flimmergrad zu tun haben, und Aufgaben, die nur ein einzelnes Flimmervideo bearbeiten müssen, ohne dass zusätzliche Führungsinformationen wie Videoflimmertyp, Referenzvideoeingang usw. erforderlich sind. Darüber hinaus konzentriert sich BVD heute hauptsächlich auf traditionelle Filterung, erzwungene zeitliche Konsistenz und Atlas-Methoden. Obwohl Deep-Learning-Methoden bei BVD-Aufgaben erhebliche Fortschritte gemacht haben, werden sie auf Anwendungsebene aufgrund mangelnder Vorkenntnisse stark behindert. BVD steht immer noch vor vielen Herausforderungen. BlazeBVD: Effektive Verbesserung des Effekts zur Entflimmerung blinder VideosInspiriert durch die klassische Flimmerentfernungsmethode Scale-Time Equalization (STE) stellt BlazeBVD eine histogrammgestützte Lösung vor. Das Bildhistogramm ist als Verteilung von Pixelwerten definiert. Es wird häufig in der Bildverarbeitung verwendet, um die Helligkeit oder den Kontrast eines Bildes anzupassen. Bei einem beliebigen Video kann STE das Histogramm mithilfe der Gaußschen Filterung glätten und jedes Bild mithilfe der Histogrammentzerrung korrigieren. Pixelwerte im Frame, wodurch die visuelle Stabilität des Videos verbessert wird. Obwohl STE nur bei einigen geringfügigen Flimmern wirksam ist, bestätigt es:

- Histogramme sind viel kompakter als Pixelwerte und können Licht- und Flimmerinformationen gut darstellen.

- Das Video weist nach der Glättung der Histogrammsequenz kein erkennbares visuelles Flimmern auf.

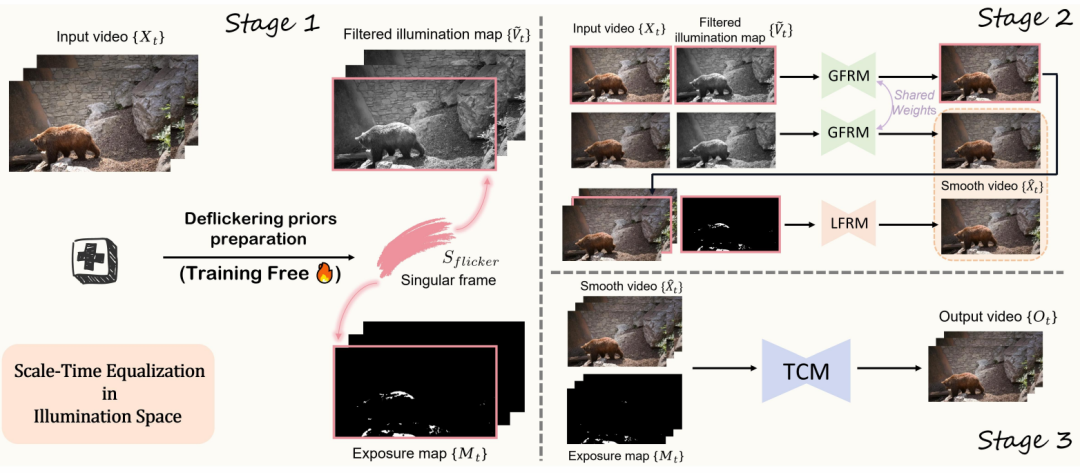

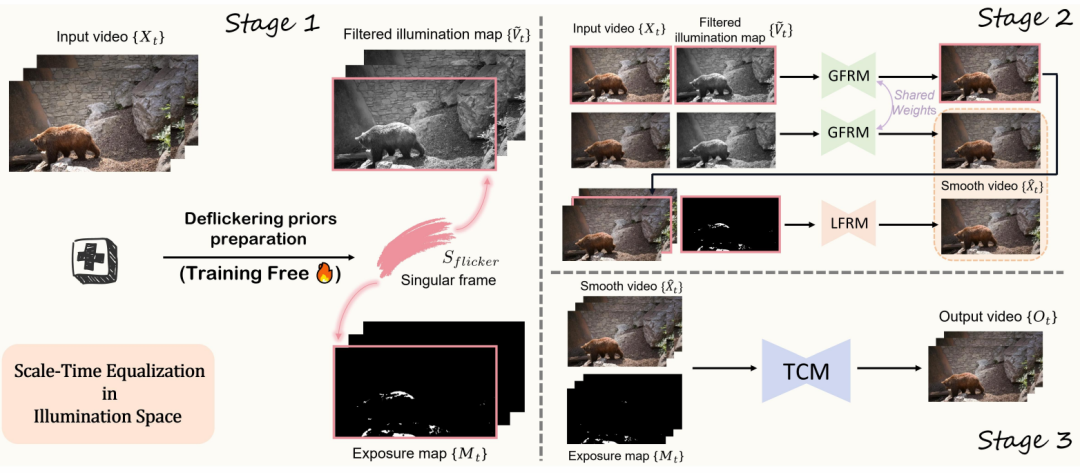

Daher ist es möglich, Hinweise aus STE und Histogrammen zu nutzen, um die Qualität und Geschwindigkeit der Blindvideo-Entflackerung zu verbessern. BlazeBVD generiert einzelne Frame-Sammlungen, gefilterte Lichtkarten und Belichtungsmaskenkarten, indem es diese Histogramme glättet, um eine schnelle und stabile Texturwiederherstellung bei Lichtschwankungen und Über- oder Unterbelichtung zu erreichen. Im Vergleich zu früheren Deep-Learning-Methoden verwendet BlazeBVD erstmals sorgfältig Histogramme, um die Lernkomplexität von BVD-Aufgaben zu reduzieren und so die Komplexität und den Ressourcenverbrauch von Lernvideodaten zu vereinfachen. Sein Kern besteht darin, das Flimmern vor STE zu verwenden, auch für A-Filter Beleuchtungskarte, die die Entfernung von globalem Flimmern steuert, ein einzelner Frame-Satz, der Flicker-Frame-Indizes identifiziert, und eine Belichtungskarte, die Regionen identifiziert, die lokal von Überbelichtung oder Dunkelheit betroffen sind. Gleichzeitig kombiniert BlazeBVD mithilfe von Flicker-Prioritäten ein globales Flicker-Entfernungsmodul (GFRM) und ein lokales Flicker-Entfernungsmodul (LFRM), um die globale Beleuchtung und die lokale Belichtungstextur einzelner benachbarter Bilder effektiv zu korrigieren. Um die Konsistenz zwischen Frames zu verbessern, ist außerdem ein Lightweight Timing Network (TCM) integriert, das die Leistung verbessert, ohne viel Zeit zu verbrauchen.

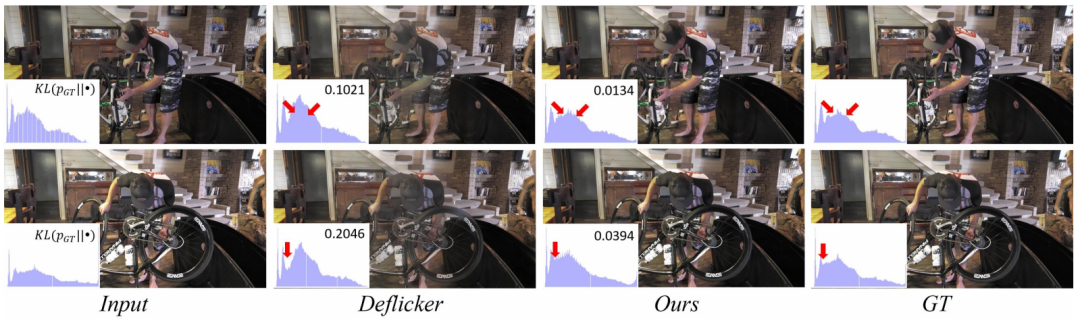

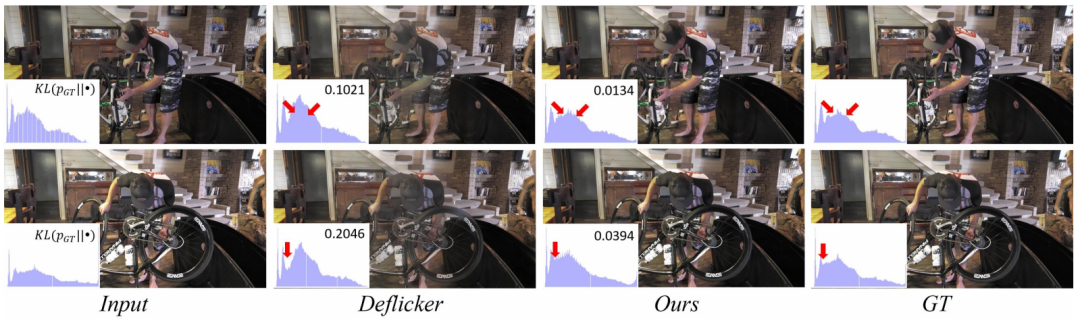

Abbildung 1: Vergleich der Ergebnisse zwischen der BlazEBVD-Methode und vorhandenen Methoden zur Aufgabe des Blind Video De-Flicker Insbesondere enthält BlazEBVD drei Stufen:

- First, stellen Sie Ste the the vor Die Histogrammsequenz der Videobilder im Beleuchtungsraum wird korrigiert und der Flicker-Prior einschließlich des einzelnen Bildsatzes, der gefilterten Beleuchtungskarte und der Belichtungskarte wird extrahiert.

- Zweitens werden die gefilterten Beleuchtungskarten, da sie eine stabile zeitliche Leistung aufweisen, als Cue-Bedingungen für das Global Flicker Removal Module (GFRM) verwendet, das ein 2D-Netzwerk zur Steuerung der Farbkorrektur von Videobildern enthält. Andererseits stellt das Local Flicker Removal Module (LFRM) überbelichtete oder dunkle Bereiche wieder her, die durch lokale Belichtungskarten markiert sind, basierend auf optischen Flussinformationen.

- Abschließend wird ein Lightweight Temporal Network (TCM) zur Verarbeitung aller Frames eingeführt, in dem ein adaptiver maskengewichteter Verlust die Videokonsistenz verbessern soll.

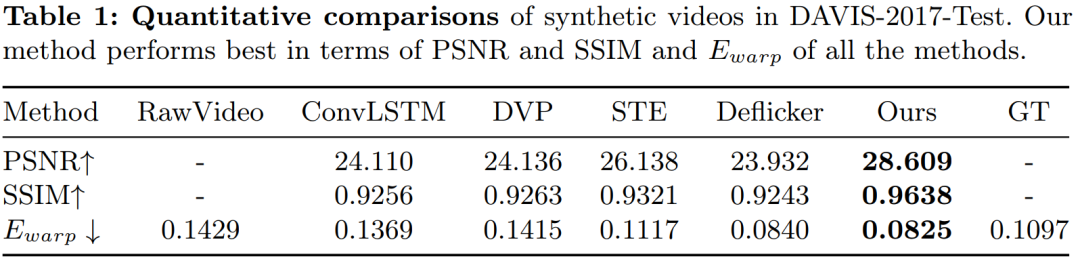

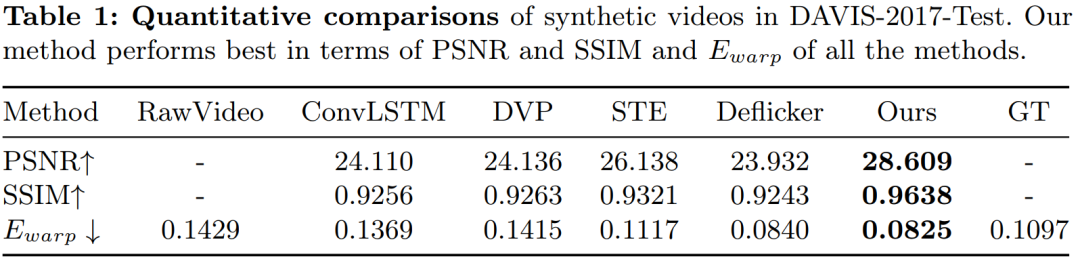

Durch umfassende Experimente mit synthetischen Videos, realen Videos und generierten Videos demonstrieren wir die überlegenen qualitativen und quantitativen Ergebnisse von BlazeBVD und erreichen Modellinferenzgeschwindigkeiten, die zehnmal schneller sind als bei Modellen auf dem neuesten Stand der Technik Inferenzgeschwindigkeiten.

Abbildung 2: Das Trainings- und Inferenzprozess von Blazebvd Experimentelle Ergebnisse Eine große Anzahl von Experimenten haben gezeigt, dass Blazebvd, eine allgemeine Methode für blinde Videoblitzaufgaben,. ist effektiv bei der Synthese. Es ist besser als frühere Arbeiten an Datensätzen und realen Datensätzen, und Ablationsexperimente bestätigen auch die Wirksamkeit des von BlazeBVD entwickelten Moduls.

Abbildung 3: Visueller Vergleich mit der Basismethode

Abbildung 3: Visueller Vergleich mit der Basismethode

Abbildung 4: Ablationsexperiment Das Papier schlägt BlazeBVD vor, eine allgemeine Methode für blinde Videoflimmeraufgaben, die 2D-Netzwerke verwendet, um Flimmern geringer Qualität zu reparieren, die durch Beleuchtungsänderungen oder lokale Belichtungsprobleme verursacht werden. Sein Kern besteht darin, Flicker-Prioris innerhalb des STE-Filters im Beleuchtungsraum vorzuverarbeiten und diese Priors dann in Kombination mit dem globalen Flicker-Entfernungsmodul (GFRM) und dem lokalen Flicker-Entfernungsmodul (LFRM) zu verwenden, um globales Flicker und lokale Belichtungstexturen zu korrigieren; Schließlich wird ein Lightweight Temporal Network (TCM) verwendet, um die Kohärenz und Inter-Frame-Konsistenz des Videos zu verbessern und außerdem eine 10-fache Beschleunigung der Modellinferenz zu erreichen.

Als Forscher im Bereich Bildgebung und Design in China führt Meitu weiterhin praktische und effiziente KI-Funktionen ein, um Benutzern innovative Dienste und Erfahrungen zu bieten. Als zentrales Forschungs- und Entwicklungszentrum ist das Meitu Imaging Research Institute (MT Lab) tätig. wird die KI-Fähigkeiten weiterhin iterativ verbessern, um Videokünstlern neue Methoden zur Videoerstellung bereitzustellen und eine breitere Welt zu eröffnen. Das obige ist der detaillierte Inhalt vonHier ist ECCV 2024|BlazeBVD, eine allgemeine Methode zur blinden Video-Flimmerentfernung, die gemeinsam von Meitu und der National University of Science and Technology of China vorgeschlagen wurde. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Abbildung 3: Visueller Vergleich mit der Basismethode

Abbildung 3: Visueller Vergleich mit der Basismethode

C-Sprache, sonst Verwendung der if-Anweisung

C-Sprache, sonst Verwendung der if-Anweisung

Der Unterschied zwischen Server und Cloud-Host

Der Unterschied zwischen Server und Cloud-Host

Welche Plug-Ins werden benötigt, damit vscode HTML ausführen kann?

Welche Plug-Ins werden benötigt, damit vscode HTML ausführen kann?

So löschen Sie leere Seiten in Word

So löschen Sie leere Seiten in Word

Verwendung von #include in der C-Sprache

Verwendung von #include in der C-Sprache

Linux-Netzwerkkarte anzeigen

Linux-Netzwerkkarte anzeigen

So lösen Sie das Problem, dass der DNS-Server nicht reagiert

So lösen Sie das Problem, dass der DNS-Server nicht reagiert

So lesen Sie Dateien und konvertieren sie in Java in Strings

So lesen Sie Dateien und konvertieren sie in Java in Strings