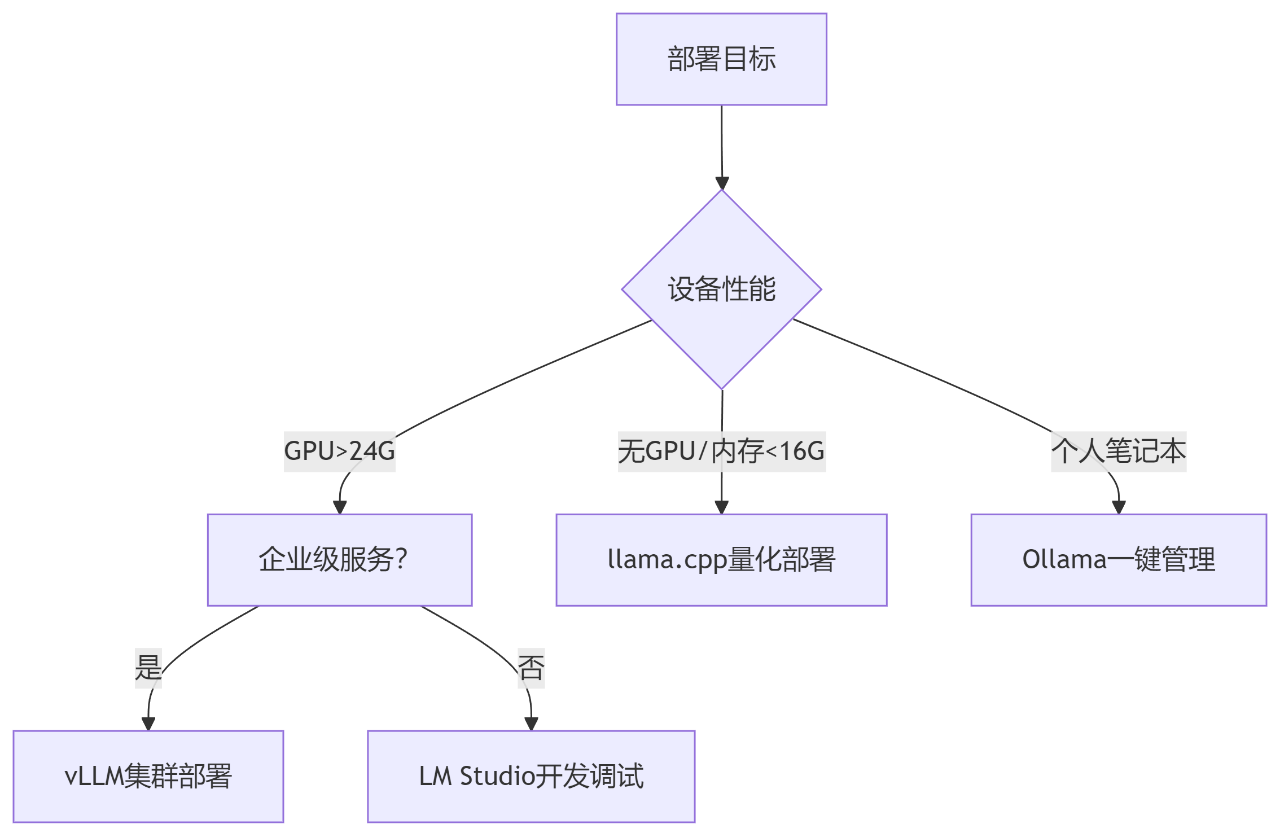

随着大模型应用场景的爆发式增长,如何针对不同需求选择最优部署方案,成为技术团队的核心挑战。本文将深度解析四大主流部署框架,覆盖个人本地调试、边缘设备、高并发生产环境三大核心场景,助你精准匹配技术方案。

定位:个人PC/Mac本地快速部署

核心价值:开箱即用的模型管家

# 典型工作流示例ollama pull qwen:7b-chat-v1.5-q4_k # 下载4-bit量化版千问7Bollama run qwen "用Python实现快速排序" # 即时交互

技术亮点:

适用场景:

某程序员用M2 MacBook部署CodeLlama 70B,代码补全响应速度 <800ms

定位:树莓派/工控机/老旧PC部署

核心理念:极致的资源优化

// 典型硬件要求对比设备类型 | 可运行模型规格---------------------------------树莓派5 (8GB) | Mistral-7B-Q4Jetson Orin | CodeLlama-34B-Q5x86旧笔记本 | Qwen-14B-Q4_K

性能突破:

实战案例:

某工业设备厂商在ARM工控机部署llama.cpp,实现设备故障语音诊断,延迟<1.2秒

定位:百人以上团队API服务

核心科技:Continuous Batching + PagedAttention

# 企业级部署示例from vllm import LLMEngineengine = LLMEngine(model="qwen-72b-chat",tensor_parallel_size=8, # 8卡并行max_num_seqs=256 # 并发256请求)

性能碾压传统方案:

| 框架 | 吞吐量(req/s) | 显存利用率 | 动态批处理 |

|---|---|---|---|

| vLLM | 142 | 92% | ✅ |

| TextGen | 78 | 85% | ❌ |

| HF Pipeline | 56 | 79% | ❌ |

核心优势:

定位:个人开发者的瑞士军刀

突出特性:可视化模型实验室

功能矩阵:

典型工作流:

开发者在MacBook用LM Studio调试Qwen-7B → 通过内网API暴露服务 → 前端应用调用接口

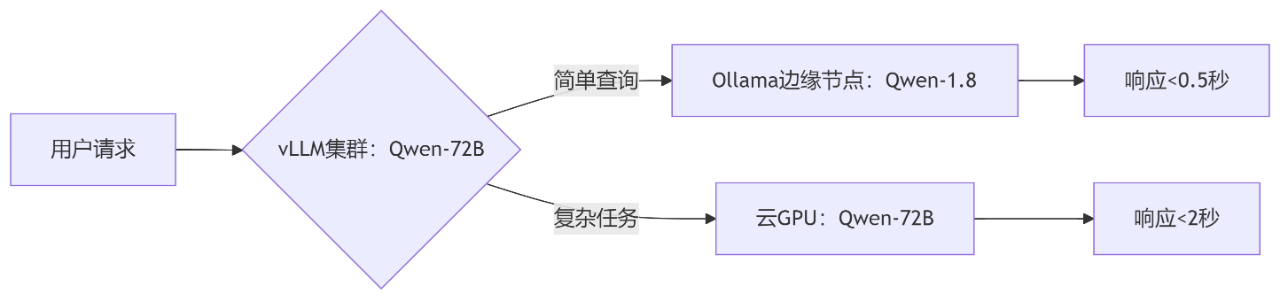

场景:某智能客服系统

成效:

▸ 高峰期节省68% 云计算成本

▸ 平均响应延迟降至1.1秒

大模型部署正经历从“中心化”到“泛在化”的范式转移。无论是个人开发者的笔记本,还是万级QPS的企业系统,选择匹配场景的部署方案,将成为AI工程化落地的决胜关键。

Copyright 2014-2025 //m.sbmmt.com/ All Rights Reserved | php.cn | 湘ICP备2023035733号