用多进程爬取数据写入文件,运行没有报错,但是打开文件却乱码。

用多线程改写时却没有这个问题,一切正常。

下面是数据写入文件的代码:

def Get_urls(start_page,end_page):

print ' run task {} ({})'.format(start_page,os.getpid())

url_text = codecs.open('url.txt','a','utf-8')

for i in range(start_page,end_page+1):

pageurl=baseurl1+str(i)+baseurl2+searchword

response = requests.get(pageurl, headers=header)

soup = BeautifulSoup(response.content, 'html.parser')

a_list=soup.find_all('a')

for a in a_list:

if a.text!=''and 'wssd_content.jsp?bookid'in a['href']:

text=a.text.strip()

url=baseurl+str(a['href'])

url_text.write(text+'\t'+url+'\n')

url_text.close()多进程用的进程池

def Multiple_processes_test():

t1 = time.time()

print 'parent process {} '.format(os.getpid())

page_ranges_list = [(1,3),(4,6),(7,9)]

pool = multiprocessing.Pool(processes=3)

for page_range in page_ranges_list:

pool.apply_async(func=Get_urls,args=(page_range[0],page_range[1]))

pool.close()

pool.join()

t2 = time.time()

print '时间:',t2-t1

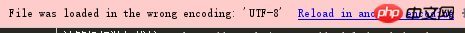

图片上已经说了,文件以错误的编码形式载入了,说明你多进程写入的时候,编码不是utf-8

文件第一行添加:

打开同一个文件,相当危险,出错机率相当大,

多线程不出错,极有可能是GIL,

多进程没有锁,因此容易出错了。

建议改为生产者消费都模式!

比如这样

结果

foo /4/wssd_content.jsp?bookid

foo /5/wssd_content.jsp?bookid

foo /6/wssd_content.jsp?bookid

foo /1/wssd_content.jsp?bookid

foo /2/wssd_content.jsp?bookid

foo /3/wssd_content.jsp?bookid

foo /7/wssd_content.jsp?bookid

foo /8/wssd_content.jsp?bookid

foo /9/wssd_content.jsp?bookid