3 月 18 日消息,在今年 2 月召开的人工智能促进协会会议上,一项新研究结果表明,可以判断内容是由 ChatGPT 生成的还是人类撰写的。

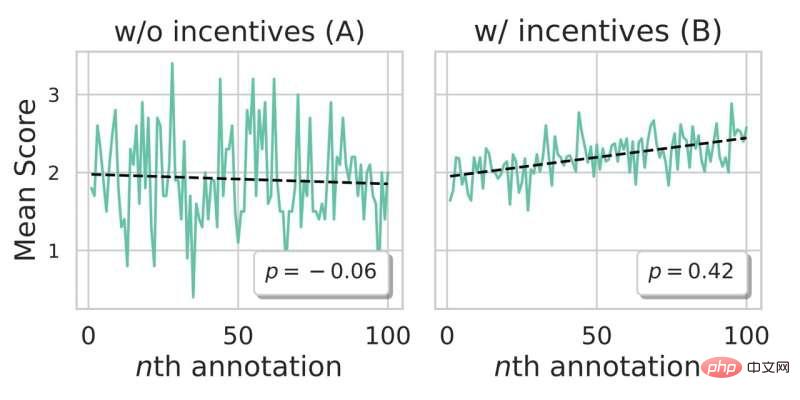

美国宾夕法尼亚大学工程与应用科学学院的一支科研团队日前展开有史以来最大规模的人工智能检测活动,基于该大学创建的网页训练游戏 Real or Fake Text?,收集相关数据进行培训,从而让 AI 可以判断出内容是由 ChatGPT 生成的还是人类撰写的。

该研究的合著者、博士 Liam Dugan 对此做出了解释,IT之家翻译内容如下:

今天的人工智能已经可以生成出非常流畅、非常符合语法的文本。但是人工智能会犯错误。

我们已经证明机器会犯诸如常识性错误、相关性错误、推理错误和逻辑错误等错误,而且我们已经找到了如何发现这些错误的方法。

人们对于人工智能感到焦虑。我们的研究可以缓解部分焦虑情绪。我认为目前 AI 可以帮助我们编写更有想象力、更有趣的文本,最适合创意协作。但是 AI 在新闻报道、学术论文或法律建议方面的应用还是非常糟糕的,我们无法确保其真实性。

报告内容如下://m.sbmmt.com/link/fc5b3186f1cf0daece964f78259b7ba0

以上是ChatGPT 等 AI 生成的内容存在常识、推理等错误,依然可以判别出来的详细内容。更多信息请关注PHP中文网其他相关文章!