如何兼容 MySQL + ES + MongoDB 实现上亿数据的深度分页?

面试题 & 真实经历

面试题:在数据量很大的情况下,怎么实现深度分页?

大家在面试时,或者准备面试中可能会遇到上述的问题,大多的回答基本上是分库分表建索引,这是一种很标准的正确回答,但现实总是很骨感,所以面试官一般会追问你一句,现在工期不足,人员不足,该怎么实现深度分页?

这个时候没有实际经验的同学基本麻爪,So,请听我娓娓道来。

惨痛的教训

首先必须明确一点:深度分页可以做,但是深度随机跳页绝对需要禁止。

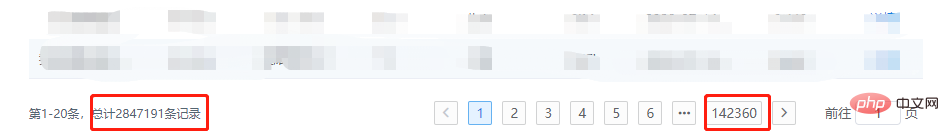

上一张图:

你们猜,我点一下第142360页,服务会不会爆炸?

像MySQL,MongoDB数据库还好,本身就是专业的数据库,处理的不好,最多就是慢,但如果涉及到ES,性质就不一样了,我们不得不利用 SearchAfter Api,去循环获取数据,这就牵扯到内存占用的问题,如果当时代码写的不优雅,直接就可能导致内存溢出。

为什么不能允许随机深度跳页

从技术的角度浅显的聊一聊为什么不能允许随机深度跳页,或者说为什么不建议深度分页

MySQL

分页的基本原理:

SELECT * FROM test ORDER BY id DESC LIMIT 10000, 20;

LIMIT 10000 , 20的意思扫描满足条件的10020行,扔掉前面的10000行,返回最后的20行。如果是LIMIT 1000000 , 100,需要扫描1000100 行,在一个高并发的应用里,每次查询需要扫描超过100W行,不炸才怪。

MongoDB

分页的基本原理:

db.t_data.find().limit(5).skip(5);

同样的,随着页码的增大,skip 跳过的条目也会随之变大,而这个操作是通过 cursor 的迭代器来实现的,对于cpu的消耗会非常明显,当页码非常大时且频繁时,必然爆炸。

ElasticSearch

从业务的角度来说,ElasticSearch不是典型的数据库,它是一个搜索引擎,如果在筛选条件下没有搜索出想要的数据,继续深度分页也不会找到想要的数据,退一步讲,假如我们把ES作为数据库来使用进行查询,在进行分页的时候一定会遇到max_result_window 的限制,看到没,官方都告诉你最大偏移量限制是一万。

查询流程:

如查询第501页,每页10条,客户端发送请求到某节点

此节点将数据广播到各个分片,各分片各自查询前 5010 条数据

查询结果返回至该节点,然后对数据进行整合,取出前 5010 条数据

返回给客户端

由此可以看出为什么要限制偏移量,另外,如果使用 Search After 这种滚动式API进行深度跳页查询,也是一样需要每次滚动几千条,可能一共需要滚动上百万,千万条数据,就为了最后的20条数据,效率可想而知。

再次和产品对线

俗话说的好,技术解决不了的问题,就由业务来解决!

在实习的时候信了产品的邪,必须实现深度分页 + 跳页,如今必须拨乱反正,业务上必须有如下更改:

尽可能的增加默认的筛选条件,如:时间周期,目的是为了减少数据量的展示

修改跳页的展现方式,改为滚动显示,或小范围跳页

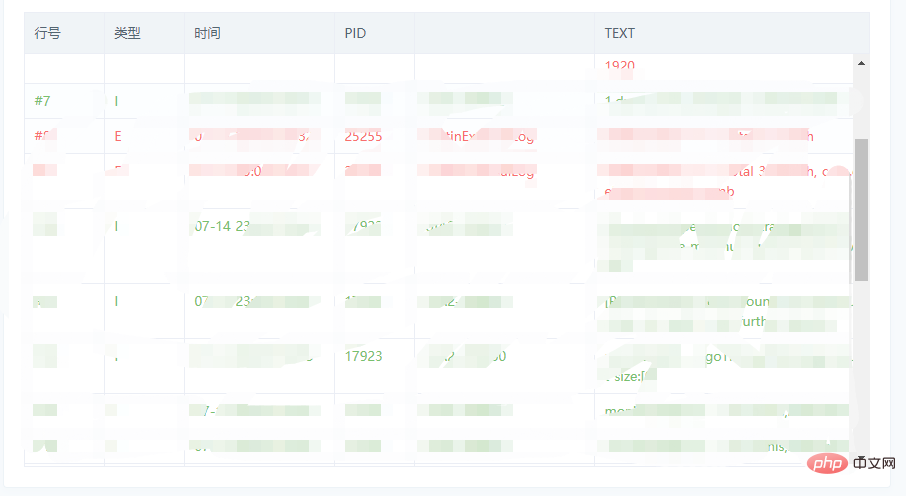

滚动显示参考图:

小规模跳页参考图:

通用解决方案

短时间内快速解决的方案主要是以下几点:

必备:对排序字段,筛选条件务必设置好索引

核心:利用小范围页码的已知数据,或者滚动加载的已知数据,减少偏移量

额外:如果遇到不好处理的情况,也可以获取多余的数据,进行一定的截取,性能影响并不大

MySQL

原分页SQL:

# 第一页 SELECT * FROM `year_score` where `year` = 2017 ORDER BY id limit 0, 20; # 第N页 SELECT * FROM `year_score` where `year` = 2017 ORDER BY id limit (N - 1) * 20, 20;

通过上下文关系,改写为:

# XXXX 代表已知的数据 SELECT * FROM `year_score` where `year` = 2017 and id > XXXX ORDER BY id limit 20;

在 没内鬼,来点干货!SQL优化和诊断 一文中提到过,LIMIT会在满足条件下停止查询,因此该方案的扫描总量会急剧减少,效率提升Max!

ES

方案和MySQL相同,此时我们就可以随用所欲的使用 FROM-TO Api,而且不用考虑最大限制的问题。

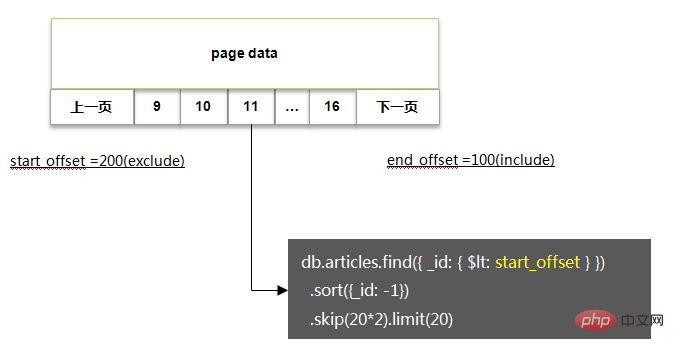

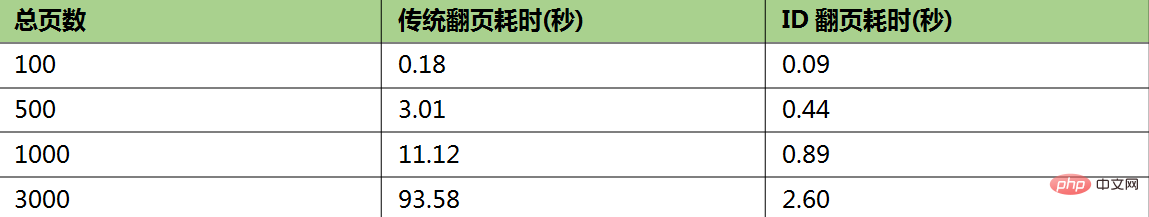

MongoDB

方案基本类似,基本代码如下:

相关性能测试:

如果非要深度随机跳页

如果你没有杠过产品经理,又该怎么办呢,没关系,还有一丝丝的机会。

在 SQL优化 一文中还提到过MySQL深度分页的处理技巧,代码如下:

# 反例(耗时129.570s) select * from task_result LIMIT 20000000, 10; # 正例(耗时5.114s) SELECT a.* FROM task_result a, (select id from task_result LIMIT 20000000, 10) b where a.id = b.id; # 说明 # task_result表为生产环境的一个表,总数据量为3400万,id为主键,偏移量达到2000万

该方案的核心逻辑即基于聚簇索引,在不通过回表的情况下,快速拿到指定偏移量数据的主键ID,然后利用聚簇索引进行回表查询,此时总量仅为10条,效率很高。

因此我们在处理MySQL,ES,MongoDB时,也可以采用一样的办法:

限制获取的字段,只通过筛选条件,深度分页获取主键ID

通过主键ID定向查询需要的数据

瑕疵:当偏移量非常大时,耗时较长,如文中的 5s

推荐教程:《MySQL教程》

文章来源:https://juejin.im/post/5f0de4d06fb9a07e8a19a641

以上是如何兼容 MySQL + ES + MongoDB 实现上亿数据的深度分页?的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undress AI Tool

免费脱衣服图片

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

如何在PHP环境中设置环境变量 PHP运行环境变量添加说明

Jul 25, 2025 pm 08:33 PM

如何在PHP环境中设置环境变量 PHP运行环境变量添加说明

Jul 25, 2025 pm 08:33 PM

PHP设置环境变量主要有三种方式:1.通过php.ini全局配置;2.通过Web服务器(如Apache的SetEnv或Nginx的fastcgi_param)传递;3.在PHP脚本中使用putenv()函数。其中,php.ini适用于全局且不常变的配置,Web服务器配置适用于需要隔离的场景,putenv()适用于临时性的变量。持久化策略包括配置文件(如php.ini或Web服务器配置)、.env文件配合dotenv库加载、CI/CD流程中动态注入变量。安全管理敏感信息应避免硬编码,推荐使用.en

如何让PHP容器支持自动构建 PHP环境持续集成CI配置方式

Jul 25, 2025 pm 08:54 PM

如何让PHP容器支持自动构建 PHP环境持续集成CI配置方式

Jul 25, 2025 pm 08:54 PM

要让PHP容器支持自动构建,核心在于配置持续集成(CI)流程。1.使用Dockerfile定义PHP环境,包括基础镜像、扩展安装、依赖管理和权限设置;2.配置GitLabCI等CI/CD工具,通过.gitlab-ci.yml文件定义build、test和deploy阶段,实现自动构建、测试和部署;3.集成PHPUnit等测试框架,确保代码变更后自动运行测试;4.使用Kubernetes等自动化部署策略,通过deployment.yaml文件定义部署配置;5.优化Dockerfile,采用多阶段构

如何搭建独立PHP任务容器环境 PHP定时脚本运行容器配置方法

Jul 25, 2025 pm 07:27 PM

如何搭建独立PHP任务容器环境 PHP定时脚本运行容器配置方法

Jul 25, 2025 pm 07:27 PM

搭建独立PHP任务容器环境可通过Docker实现,具体步骤如下:1.安装Docker与DockerCompose作为基础;2.创建独立目录存放Dockerfile、crontab文件;3.编写Dockerfile定义PHPCLI环境并安装cron及必要扩展;4.编写crontab文件定义定时任务;5.编写docker-compose.yml挂载脚本目录并配置环境变量;6.启动容器并验证日志。相比Web容器内执行定时任务,独立容器具备资源隔离、环境纯粹、稳定性强、便于扩展等优势。为确保日志与错误捕

如何用PHP构建日志管理系统 PHP日志采集与分析工具

Jul 25, 2025 pm 08:48 PM

如何用PHP构建日志管理系统 PHP日志采集与分析工具

Jul 25, 2025 pm 08:48 PM

选择日志记录方式:初期可用PHP内置error_log(),项目扩大后务必切换至Monolog等成熟库,支持多handler和日志级别,确保日志含时间戳、级别、文件行号及错误详情;2.设计存储结构:小量日志可文件存储,大量或需分析则选数据库,结构化数据用MySQL/PostgreSQL,半结构化/非结构化推荐Elasticsearch Kibana,同时制定备份与定期清理策略;3.开发分析界面:应具备搜索、过滤、聚合、可视化功能,可直接集成Kibana,或用PHP框架 图表库自研,注重界面简洁易

MySQL/Laravel中关系数据的高级条件查询与过滤

Jul 25, 2025 pm 08:39 PM

MySQL/Laravel中关系数据的高级条件查询与过滤

Jul 25, 2025 pm 08:39 PM

本文旨在探讨如何在Laravel框架中,利用EloquentORM对关联数据进行高级条件查询与过滤,解决在数据库关系中实现“条件连接”的需求。文章将澄清MySQL中外键的实际作用,并详细讲解如何通过Eloquent的with方法结合闭包函数,对预加载的关联模型应用特定的WHERE子句,从而灵活地筛选出符合条件的相关数据,提升数据检索的精确性。

优化MySQL用于财务数据存储

Jul 27, 2025 am 02:06 AM

优化MySQL用于财务数据存储

Jul 27, 2025 am 02:06 AM

MySQL用于金融系统需优化四个关键点:1.金融数据必须使用DECIMAL类型确保精度,时间字段使用DATETIME避免时区问题;2.索引设计要合理,避免频繁更新字段建索引,组合索引按查询顺序排列并定期清理无用索引;3.使用事务确保一致性,控制事务粒度,避免长事务和非核心操作嵌入其中,并根据业务选择合适隔离级别;4.对历史数据按时间分区、归档冷数据并使用压缩表,提升查询效率并优化存储。

MySQL数据库成本效益分析用于云迁移

Jul 26, 2025 am 03:32 AM

MySQL数据库成本效益分析用于云迁移

Jul 26, 2025 am 03:32 AM

是否值得将MySQL迁到云上取决于具体使用场景。如果你的业务需要快速上线、弹性扩展和简化运维,且能接受按需付费模式,那么迁云是值得的;但若你的数据库长期稳定、对延迟敏感或受合规限制,则可能不划算。控制成本的关键包括选择合适厂商与套餐、合理配置资源、利用预留实例、管理备份日志及优化查询性能。

优化MySQL用于实时数据提要

Jul 26, 2025 am 05:41 AM

优化MySQL用于实时数据提要

Jul 26, 2025 am 05:41 AM

TooptimizeMySQLforreal-timedatafeeds,firstchoosetheInnoDBstorageenginefortransactionsandrow-levellocking,useMEMORYorROCKSDBfortemporarydata,andpartitiontime-seriesdatabytime.Second,indexstrategicallybyonlyapplyingindexestoWHERE,JOIN,orORDERBYcolumns,