最初由 Liz Acosta 发表在 Streamlit 博客上

还记得第一次使用人工智能图像生成器有多酷吗?那两千万根手指和噩梦般的吃意大利面的画面不仅仅是有趣,它们在不经意间透露了哎呀!人工智能模型的智能程度与我们一样。和我们一样,他们也很难画手。

人工智能模型很快变得更加复杂,但现在的模型数量太多了。而且,和我们一样,他们中的一些人比其他人更擅长某些任务。以文本生成为例。尽管 Llama、Gemma 和 Mistral 都是法学硕士,但他们中的一些人更擅长生成代码,而另一些人则更擅长头脑风暴、编码或创意写作。根据提示,它们提供不同的优势,因此在您的 AI 应用程序中包含多个模型可能是有意义的。

但是如何将所有这些模型集成到你的应用程序中而不需要重复代码?如何使人工智能的使用更加模块化,从而更易于维护和扩展?这就是 API 可以提供用于跨不同技术进行通信的标准化指令集的地方。

在这篇博文中,我们将了解如何使用 Replicate 和 Streamlit 来创建一个应用程序,该应用程序允许您通过单个 API 调用来配置和提示不同的 LLM。别担心——当我说“应用程序”时,我并不是说必须启动整个 Flask 服务器或繁琐地配置你的路由或担心 CSS。 Streamlit 已经为您解决了这个问题?

继续阅读以学习:

不想读书?以下是探索此演示的一些其他方法:

Replicate 是一个平台,使开发人员能够通过 CLI、API 或 SDK 部署、微调和访问开源 AI 模型。该平台可以轻松地以编程方式将人工智能功能集成到软件应用程序中。

当一起使用时,Replicate 允许您开发多模式应用程序,这些应用程序可以接受输入并生成各种格式的输出,无论是文本、图像、语音还是视频。

Streamlit 是一个开源 Python 框架,只需几行代码即可构建高度交互的应用程序。 Streamlit 与生成式 AI 中的所有最新工具集成,例如任何 LLM、矢量数据库或各种 AI 框架(如 LangChain、LlamaIndex 或 Weights & Biases)。 Streamlit 的聊天元素使与 AI 交互变得特别容易,因此您可以构建“与您的数据对话”的聊天机器人。

与 Replicate 这样的平台相结合,Streamlit 允许您创建生成式 AI 应用程序,而无需任何应用程序设计开销。

?要了解有关 Streamlit 如何使您取得进步的更多信息,请查看此博客文章。

要了解有关 Streamlit 的更多信息,请查看 101 指南。

但不要相信我的话。亲自尝试该应用程序或观看视频演示,看看您的想法。

在此演示中,您将使用 Replicate 启动 Streamlit 聊天机器人应用程序。该应用程序使用单个 API 来访问三个不同的 LLM 并调整温度和 top-p 等参数。这些参数影响人工智能生成文本的随机性和多样性,以及选择标记的方法。

?什么是模型温度?温度控制模型如何选择 token。较低的温度使模型更加保守,有利于常见和“安全”的词语。相反,较高的温度会鼓励模型通过选择可能性较小的令牌来承担更多风险,从而产生更多创意输出。

?什么是 top-p?也称为“核采样”——是另一种调整随机性的方法。随着 top-p 值的增加,它的工作原理是考虑更广泛的代币集。较高的 top-p 值会导致采样的代币范围更加多样化,从而产生更加多样化的输出。

?要了解有关 API 密钥的更多信息,请查看此处的博客文章。

本地设置

GitHub Codespaces 设置

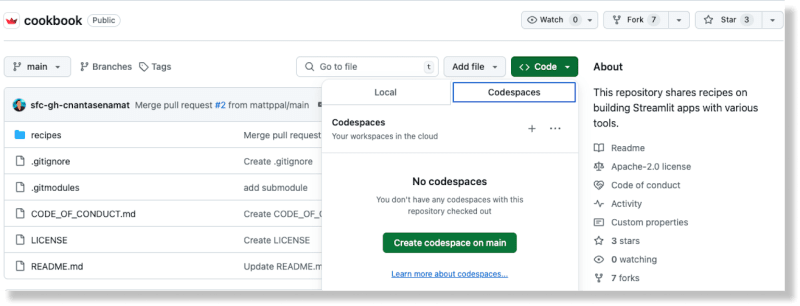

从 GitHub 上的 Cookbook 存储库,通过从“代码”按钮中选择“代码空间”选项来创建一个新的代码空间

生成代码空间后,将您的 Replicate API 密钥添加到recipe/replicate/.streamlit/secrets_template.toml 文件中

将文件名从secrets_template.toml更新为secrets.toml

(要了解有关 Streamlit 中秘密处理的更多信息,请参阅此处的文档。)

从Cookbook根目录,将目录更改为复制食谱:cdrecipes/replicate

安装依赖项:pip install -rrequirements.txt

将以下代码添加到文件中:

运行脚本:pythonreplicate_hello_world.py

您应该会看到模型生成的文本的打印结果。

要了解有关复制模型及其工作原理的更多信息,您可以在此处参考其文档。从本质上讲,复制“模型”是指经过训练、打包和发布的软件程序,它接受输入并返回输出。

在这种特殊情况下,模型是meta/meta-llama-3-8b,输入是“提示”:“什么是Streamlit?”。当您运行脚本时,将调用 Replicate 端点,打印的文本是模型通过 Replicate 返回的输出。

要运行演示应用程序,请使用 Streamlit CLI:streamlit run streamlit_app.py。

运行此命令会将应用程序部署到本地主机上的端口。当您访问此位置时,您应该会看到 Streamlit 应用程序正在运行。

您可以使用此应用程序通过复制提示不同的LLM,并根据您提供的配置生成生成文本。

使用 Replicate 意味着您可以使用一个 API 提示多个开源 LLM,这有助于简化 AI 与现代软件流程的集成。

这是通过以下代码块完成的:

模型、温度和 top p 配置由用户通过 Streamlit 的输入小部件提供。 Streamlit 的聊天元素可以轻松地将聊天机器人功能集成到您的应用程序中。最好的部分是您不需要了解 JavaScript 或 CSS 来实现和设计这些组件 - Streamlit 提供了所有开箱即用的功能。

Replicate 提供了一个 API 端点来搜索公共模型。您还可以在他们的网站上探索特色模型和用例。这可以让您轻松找到适合您特定需求的型号。

不同的型号有不同的性能特点。根据您对准确性和速度的需求使用适当的模型。

Les données de sortie de Replicate ne sont disponibles que pendant une heure. Utilisez des webhooks pour enregistrer les données sur votre propre stockage. Vous pouvez également configurer des webhooks pour gérer les réponses asynchrones des modèles. Ceci est crucial pour créer des applications évolutives.

Tirez parti du streaming lorsque cela est possible. Certains modèles prennent en charge le streaming, vous permettant d'obtenir des résultats partiels au fur et à mesure de leur génération. C'est idéal pour les applications en temps réel.

L'utilisation d'URL d'images offre des performances améliorées par rapport à l'utilisation d'images téléchargées codées en base 64.

Avec Streamlit, des mois et des mois de travail de conception d'applications sontrationalisésen seulement quelques lignes de Python. C’est le cadre idéal pour présenter vos dernières inventions en matière d’IA.

Lancez-vousrapidementavec d'autres recettes d'IA dans le livre de recettes Streamlit. (Et n'oubliez pas de nous montrer ce que vous construisez sur le forum !)

Joyeux streamlit-ing ! ?

以上是如何使用一个 API 创建 AI 聊天机器人来访问多个 LLM的详细内容。更多信息请关注PHP中文网其他相关文章!