Große Modelle können Ihr eigenes Verständnis der realen Welt entwickeln!

Eine Studie des MIT ergab, dass mit zunehmender Leistungsfähigkeit eines Modells sein Verständnis der Realität möglicherweise über die bloße Nachahmung hinausgeht.

Wenn das große Model beispielsweise noch nie einen Geruch gerochen hat, bedeutet das dann, dass es Gerüche nicht verstehen kann?

Untersuchungen haben ergeben, dass einige Konzepte spontan simuliert werden können, um das Verständnis zu erleichtern.

Diese Forschung bedeutet, dass von großen Modellen in Zukunft ein tieferes Verständnis der Sprache und der Welt erwartet wird. Das Papier wurde von der Spitzenkonferenz ICML 24 angenommen.

Die Autoren dieses Papiers sind der chinesische Doktorand Charles Jin und sein Betreuer Professor Martin Rinard vom MIT Computer and Artificial Intelligence Laboratory (CSAIL).

In der Studie bat der Autor das große Modell, nur den Codetext zu lernen, und stellte fest, dass das Modell nach und nach die Bedeutung dahinter erfasste.

Professor Rinard sagte, dass diese Forschung direkt eine Kernfrage der modernen künstlichen Intelligenz anspricht –

Ob die Fähigkeiten großer Modelle einfach auf groß angelegten statistischen Korrelationen beruhen oder ob sie ein aussagekräftiges Verständnis der realen Probleme generieren, um die es sich dabei handelt beabsichtigt zu lösen?

△Quelle: Offizielle Website des MIT

Gleichzeitig löste diese Forschung auch viele Diskussionen aus.

Einige Internetnutzer sagten, dass große Modelle zwar Sprache anders verstehen als Menschen, diese Studie aber zumindest zeigt, dass das Modell mehr kann, als nur Trainingsdaten zu speichern.

Lassen Sie das große Modell reinen Code lernen

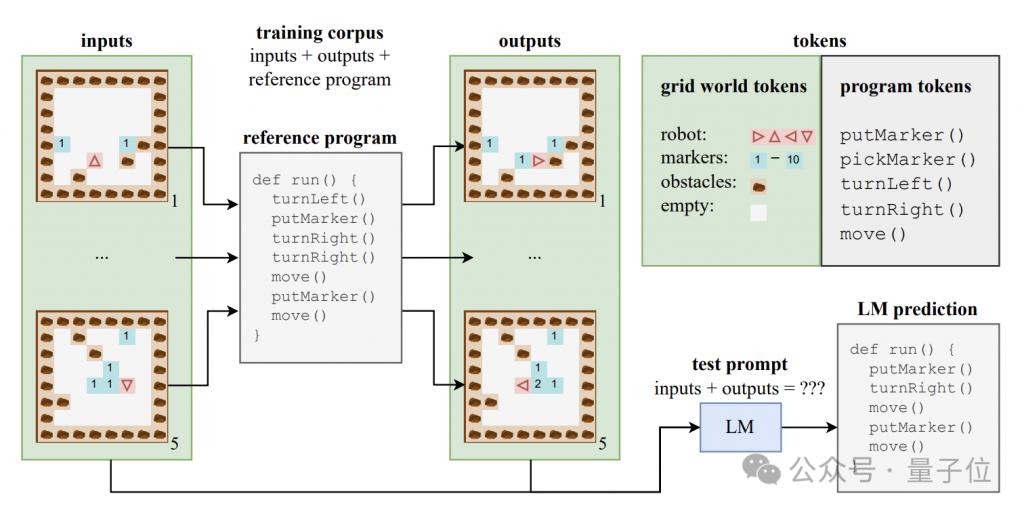

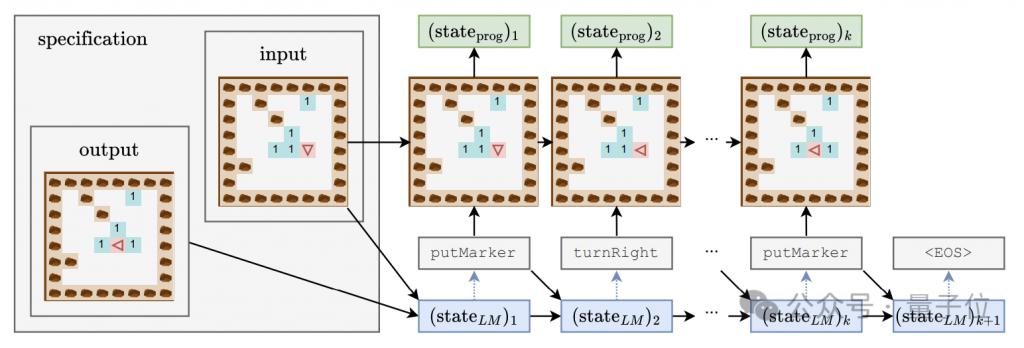

Um zu untersuchen, ob das große Modell ein Verständnis auf semantischer Ebene erzeugen kann, erstellte der Autor einen synthetischen Datensatz, der aus Programmcode und den entsprechenden Eingaben und Ausgaben besteht.

Diese Codeprogramme sind in einer Lehrsprache namens Karel geschrieben und werden hauptsächlich zur Umsetzung der Aufgabe von Robotern verwendet, die in einer 2D-Gitterwelt navigieren.

Diese Gitterwelt besteht aus 8x8 Gittern, jedes Gitter kann Hindernisse, Markierungen oder offene Räume enthalten. Der Roboter kann sich zwischen Gittern bewegen und Vorgänge wie das Platzieren/Aufnehmen von Markierungen ausführen.

Karel-Sprache enthält 5 Grundoperationen – move (einen Schritt vorwärts), turnLeft (um 90 Grad nach links drehen), turnRight (um 90 Grad nach rechts drehen), pickMarker (Marker aufnehmen), putMarker (Marker platzieren), aus denen das Programm besteht Eine Folge dieser primitiven Operationen.

Der Autor hat zufällig einen Trainingssatz mit 500.000 Karel-Programmen generiert, wobei jedes Programm eine Länge zwischen 6 und 10 hat.

Jedes Trainingsbeispiel besteht aus drei Teilen: 5 Eingabezustände, 5 Ausgabezustände und vollständiger Programmcode. Die Eingabe- und Ausgabezustände werden in einem bestimmten Format in Zeichenfolgen codiert.

Anhand dieser Daten trainierten die Autoren eine Variante des CodeGen-Modells der Standard-Transformer-Architektur.

Während des Trainingsprozesses kann das Modell auf die Eingabe- und Ausgabeinformationen und Programmpräfixe in jedem Beispiel zugreifen, es kann jedoch nicht den vollständigen Verlauf und die Zwischenzustände der Programmausführung sehen.

Zusätzlich zum Trainingssatz hat der Autor auch einen Testsatz mit 10.000 Proben erstellt, um die Generalisierungsleistung des Modells zu bewerten.

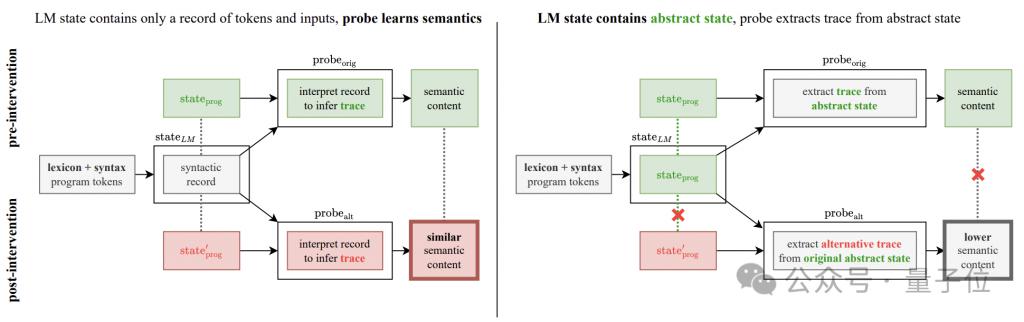

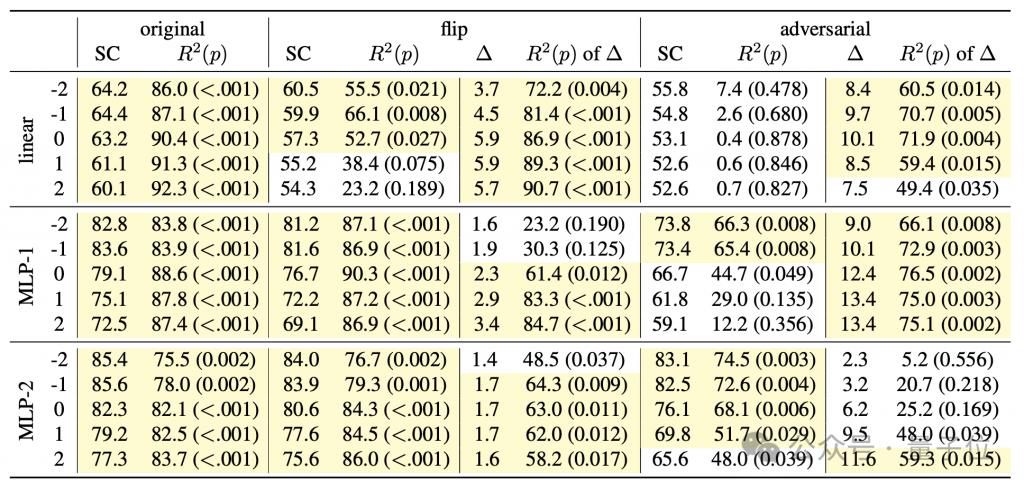

Um zu untersuchen, ob das Sprachmodell die Semantik hinter dem Code erfasst, und gleichzeitig ein tiefes Verständnis des „Denkprozesses“ des Modells zu erlangen, entwarf der Autor eine Detektorkombination, die einen linearen Klassifikator und einen einfachen/doppelten versteckten Klassifikator umfasst Schicht MLP.

Die Eingabe des Detektors ist der verborgene Zustand des Sprachmodells beim Generieren von Programm-Tokens, und das Vorhersageziel ist der Zwischenzustand der Programmausführung, insbesondere einschließlich der Ausrichtung (Richtung) des Roboters, versetzt relativ zur Anfangsposition (Position) und ob die Vorderseite dem Hindernis (Hindernis) zugewandt ist, sind diese drei Merkmale.

Während des Trainingsprozesses des generativen Modells zeichnete der Autor alle 4000 Schritte die oben genannten drei Merkmale auf und zeichnete auch den verborgenen Zustand des generativen Modells auf, um einen Trainingsdatensatz für den Detektor zu bilden.

Drei Phasen des Lernens mit großen Modellen

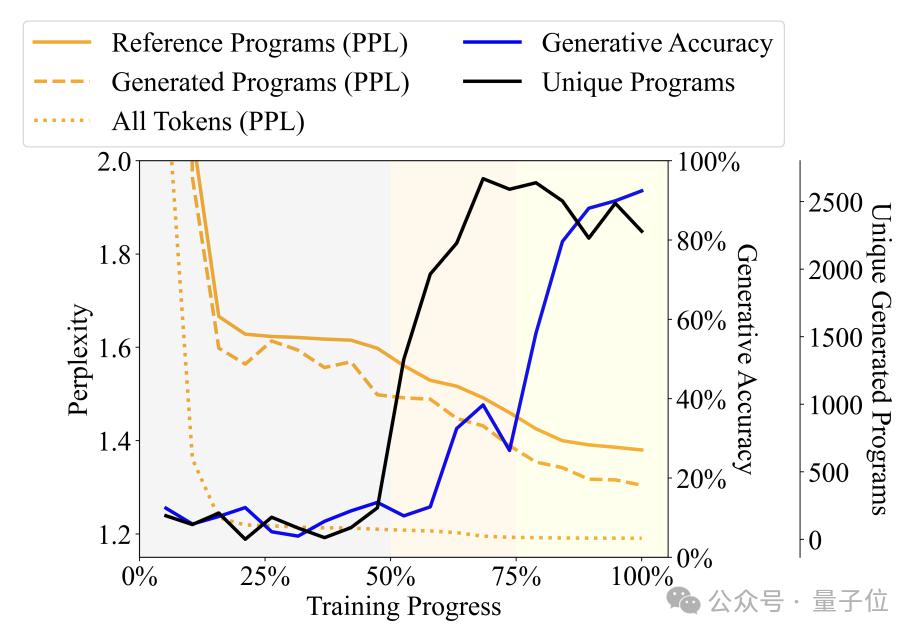

Durch Beobachtung der Veränderungen in der Vielfalt, Verwirrung und anderen Indikatoren der vom Sprachmodell während des Trainingsprozesses generierten Programme hat der Autor den Trainingsprozess in drei Phasen unterteilt -

Phase des Plapperns (Unsinn): Das Ausgabeprogramm wiederholt sich stark und die Genauigkeit des Detektors ist instabil.

Grammatikerwerbsphase: Die Programmvielfalt nimmt schnell zu, die Generierungsgenauigkeit nimmt leicht zu und die Verwirrung nimmt ab, was darauf hinweist, dass das Sprachmodell die syntaktische Struktur des Programms gelernt hat.

Semantische Erfassungsphase: Der Grad der Programmvielfalt und die Beherrschung der syntaktischen Struktur sind stabil, aber die Generierungsgenauigkeit und die Detektorleistung sind erheblich verbessert, was darauf hinweist, dass das Sprachmodell die Semantik des Programms gelernt hat.

具体来说,Babbling 阶段占据了整个训练过程的前50%,例如在训练到20% 左右的时候,无论输入什么规范,模型都只会生成一个固定的程序—— "pickMarker" 重复9 次。

语法习得阶段处于训练过程的50% 到75%,模型在Karel 程序上的困惑度显着下降,表明语言模型开始更好地适应Karel 程序的统计特性,但生成程序的准确率提升幅度不大(从10% 左右提升到25% 左右),仍然无法准确完成任务。

语义习得阶段是最后的 25%,程序的准确率出现了急剧提升,从 25% 左右提升到 90% 以上,生成的程序能够准确地完成给定的任务。

进一步实验又发现,探测器不仅可以对 t 时刻的同时间步进行预测,还能预测后续时间步的程序执行状态。

举例来说,假设生成模型在 t 时刻生成了 token"move",并将在 t+1 时刻生成 "turnLeft"。

与此同时,t 时刻的程序状态是机器人面向北方,位于坐标 ( 0,0 ) ,而 t+1 时刻机器人将是机器人将面向西方,位置不变。

如果探测器能够从语言模型在t 时刻的隐藏状态中,成功预测到t+1 时刻机器人会面向西方,就说明在生成"turnLeft" 之前,隐藏状态就已经包含了这一操作带来的状态变化信息。

这一现象说明,模型并非只对已生成的程序部分有语义理解,而是在生成每一步时,就已经对接下来要生成的内容有所预期和规划,显现出了初步的面向未来的推理能力。

但这一发现又给这项研究带来了新的问题——

实验中观察到的准确度提升,到底真的是生成模型进步了,还是探测器自己推论的结果呢?

为了解决这个疑惑,作者补充了语义探测干预实验。

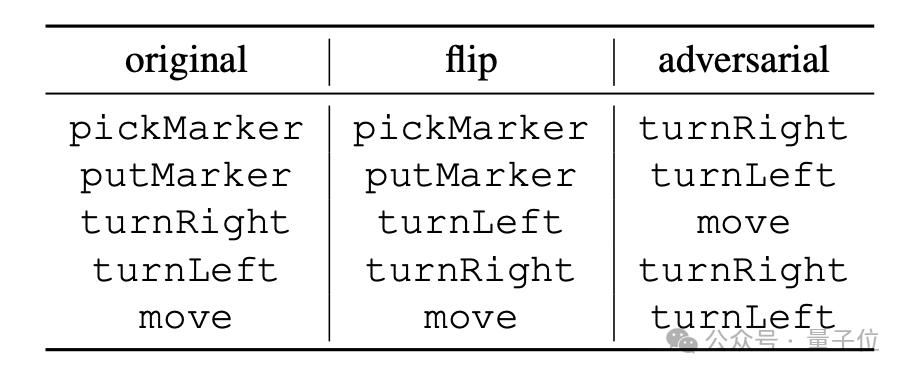

实验的基本思路是改变程序操作的语义解释规则,具体又分为 "flip" 和 "adversarial" 两种方式。

"flip" 是强行反转指令含义,如将"turnRight" 强行解释为" 左转" 不过能进行这种反转的也只有"turnLeft" 和"turnRight";#🎜 🎜#

"adversarial" 则是将所有指令对应的语义随机打乱,具体方式如下方表格。

# 🎜🎜# [ 1 ] https://news.mit.edu/2024/llms-develop-own-understanding-of-reality-as-language-abilities-improve-0814

[ 2 ] https://www.reddit.com/r/LocalLLaMA/comments/1esxkin/llms_develop_their_own_understanding_of_reality/

以上是大模型对语言有自己的理解!MIT 论文揭示大模型'思维过程”的详细内容。更多信息请关注PHP中文网其他相关文章!