AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。

指代分割 (Referring Image Segmentation,RIS) 是一项极具挑战性的多模态任务,要求算法能够同时理解精细的人类语言和视觉图像信息,并将图像中句子所指代的物体进行像素级别的分割。RIS 技术的突破有望在人机交互、图像编辑、自动驾驶等诸多领域带来革命性变革。它能够极大地提升人机协作的效率和体验。尽管目前最先进的 RIS 算法已经取得了显著进展,但仍然面临着模态差异 (modality gap) 的问题,即图像和文本特征的分布并未完全对齐。这一问题在处理复杂的指代语言表达和罕见语境时尤为突出。

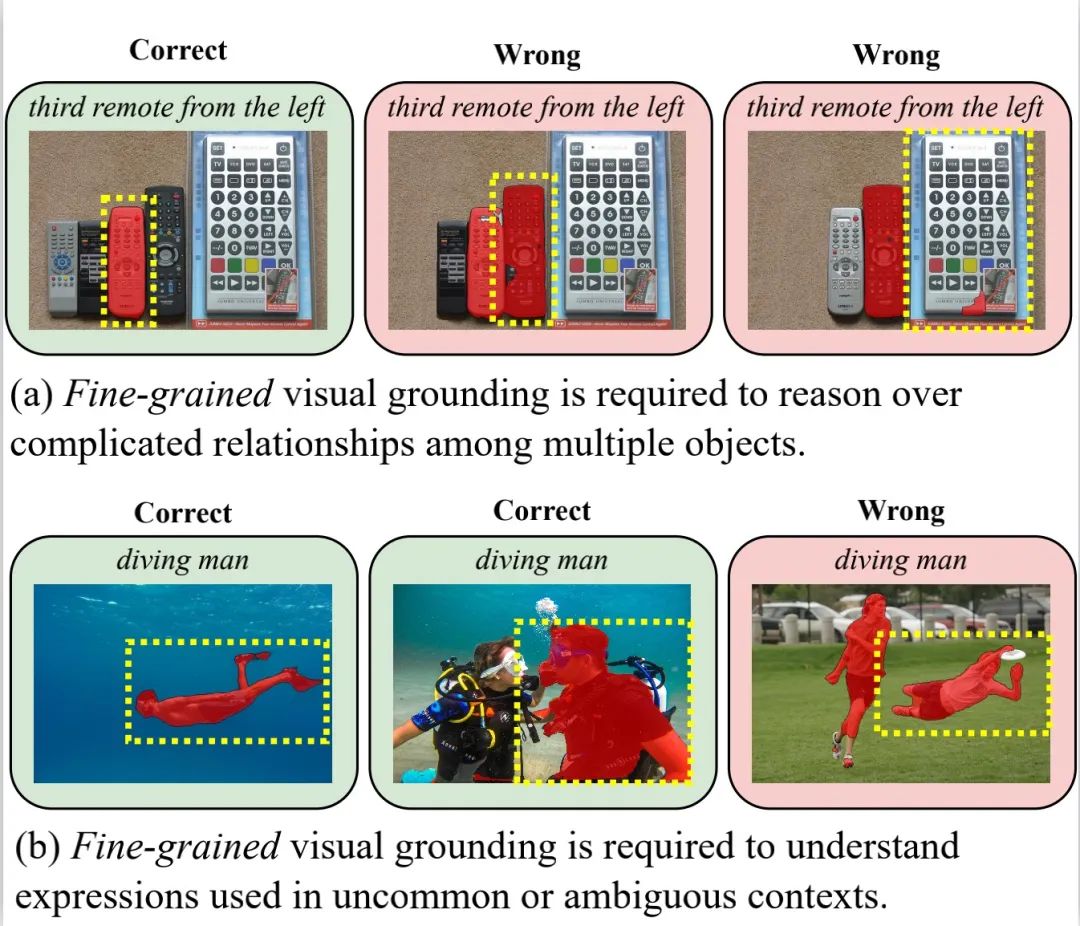

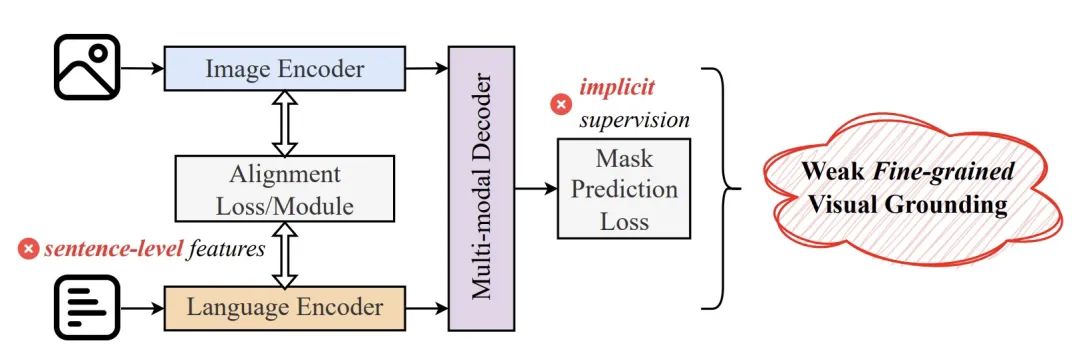

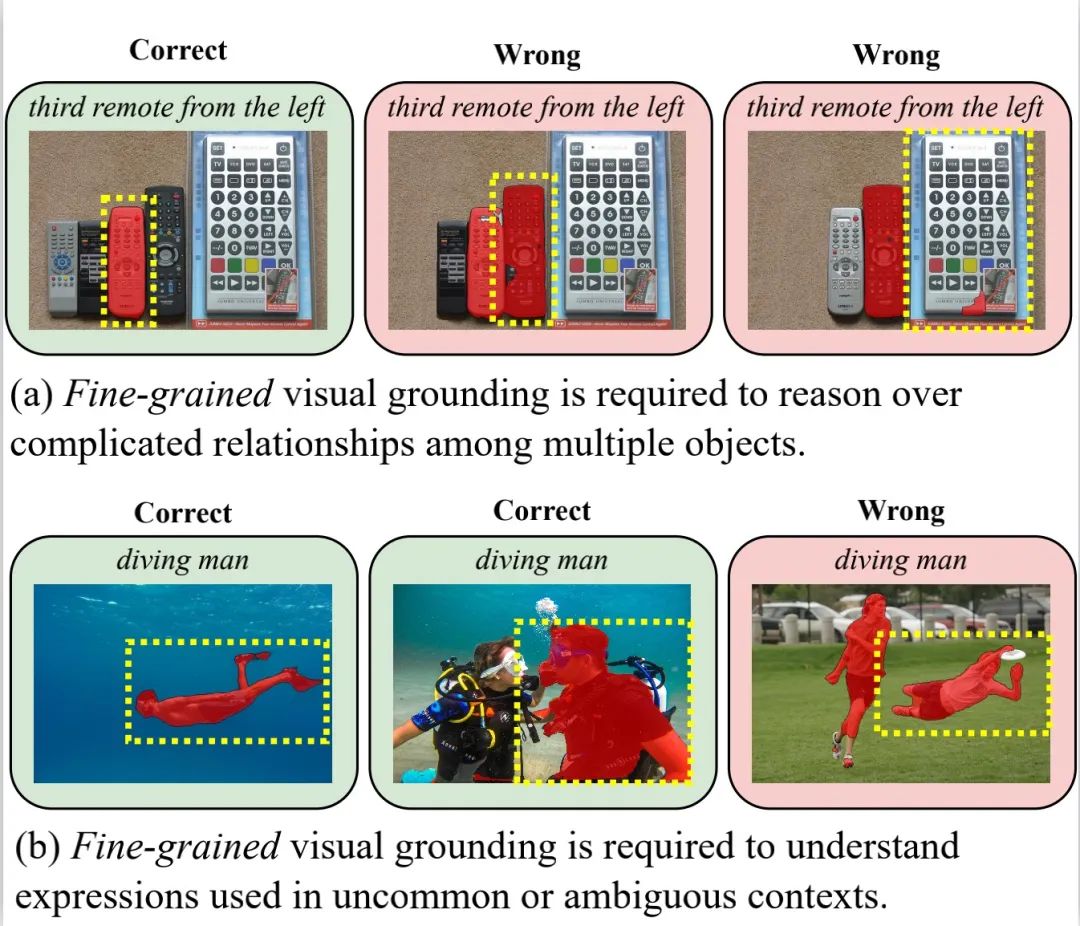

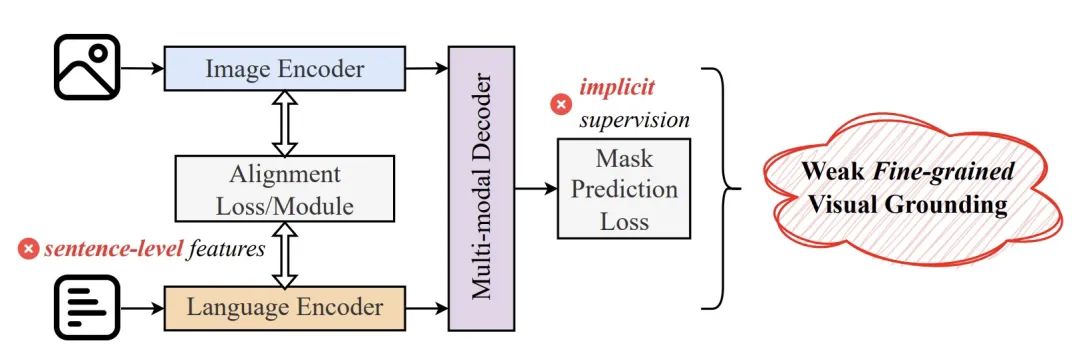

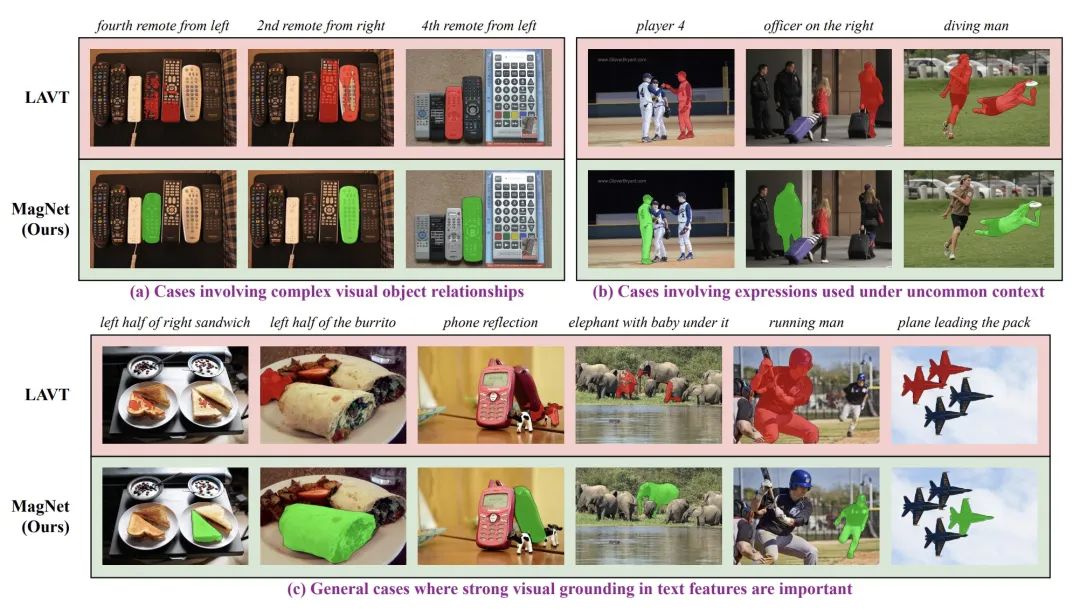

图 1:细粒度语言 - 图像对齐能力对 RIS 的重要性示意图。红色掩码是目前最先进的 RIS 算法之一 LAVT 的预测结果,而黄色虚线框则是正确的标注。目前的 RIS 研究主要集中在设计新颖的损失函数或引入创新的网络架构 / 模块,以增强语言 - 图像的分布对齐。尽管取得了显著进展,但仍存在两个根本性问题,导致它们在细粒度语言 - 图像对齐(Fine-grained Visual Grounding)方面能力不足:1. 这些方法主要依赖于句子级别的语言特征进行语言 - 图像对齐,导致它们在文字级别的语言 - 图像对齐能力较为薄弱。2. 这些方法在训练过程中往往缺乏显式的监督信号,无法有效地教会模型进行细粒度对齐,导致它们在处理复杂的指代语言时表现不佳。

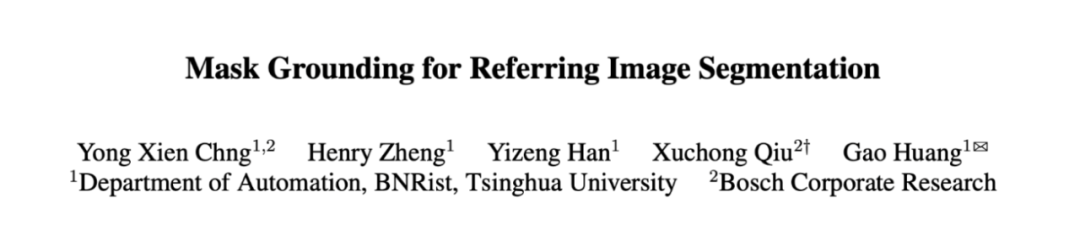

在近期一篇 CVPR 2024 工作中,来自清华大学自动化系和博世中央研究院的联合研究团队设计了一种新的辅助任务 Mask Grounding。通过随机掩码部分文本词汇,并让算法学习预测其真实身份,这一任务旨在显式地教会模型学习文本与视觉对象之间的细粒度对应关系。除此之外,他们还提出了一个新颖的跨模态对齐模块(Cross-modal Alignment Module)和一个新颖的跨模态对齐损失函数 (Cross-modal Alignment Loss),来进一步全面缩小语言和图像之间的模态差距。基于这些技术,他们设计了一个全新的实例分割网络架构 Mask-grounded Network (MagNet)。

- 论文标题:Mask Grounding for Referring Image Segmentation

- 论文地址:https://arxiv.org/abs/2312.12198

在 RefCOCO、RefCOCO 和 G-Ref 数据集上,MagNet 大幅超越了所有之前最优的算法,在整体交并比 (oIoU) 这项核心指标上显著提升了 2.48 个百分点。可视化结果也证实,MagNet 在处理复杂场景和语言表达时具有出色的表现。MagNet 由 3 个独立互补的模块组成,分别为 Mask Grounding,Cross-modal Alignment Module 和 Cross-modal Alignment Loss。

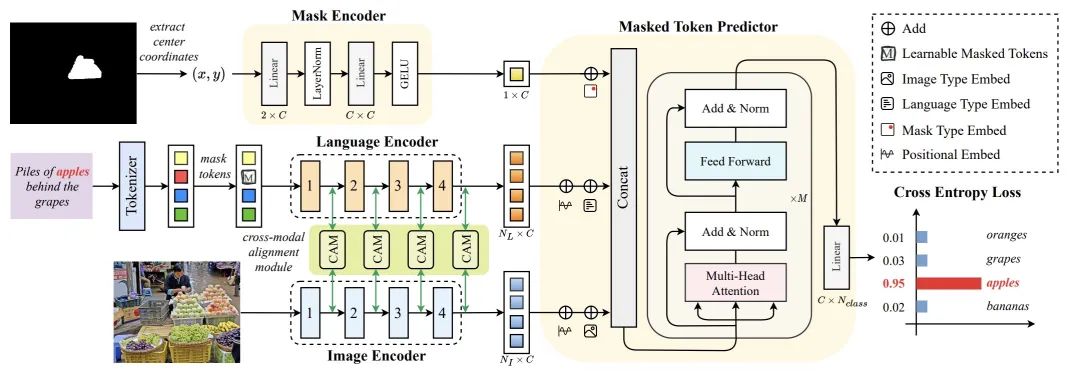

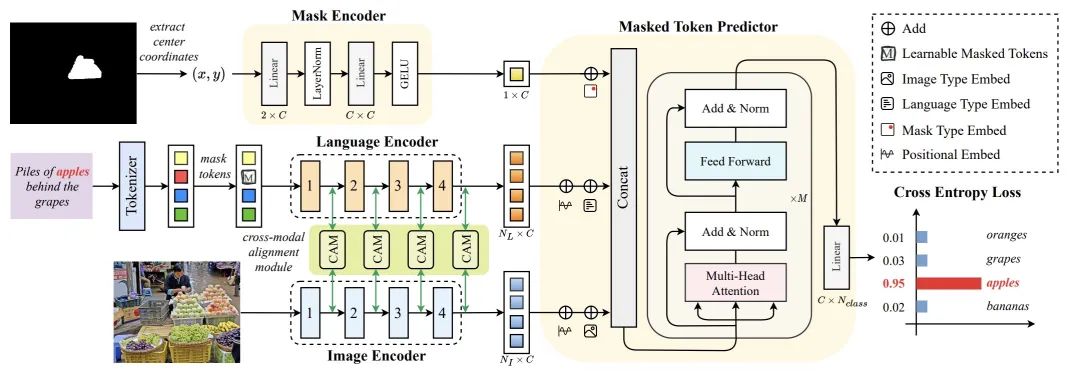

如圖3 所示,在給定輸入圖像、對應的指代表達以及分割遮罩的情況下,作者隨機選取句子中的某些詞彙,並將其替換為一個特殊的可學習遮罩token。然後,訓練模型來預測這些被替換詞彙的實際身分。透過成功預測被遮罩 token 的身份,模型能夠理解文本中的哪些詞彙對應於圖像的哪些部分,從而在此過程中學習細粒度語言 - 圖像對齊能力。為了執行這項輔助任務,首先提取遮罩區域的中心座標,並將其傳遞給一個 2 層 MLP,以編碼分割遮罩的特徵。同時,使用線性層將語言特徵映射到與圖像特徵相同的維度。然後,使用提出的遮罩 token 預測器聯合處理這些特徵,並使用注意力機制模組來進行遮罩 token 預測。雖然 Mask Grounding 需要透過語言編碼器進行額外的前向傳遞來處理被遮罩的表達式,但由於語言編碼器非常小,整體計算成本幾乎可以忽略不計。 2.Cross-modal Alignment Module (CAM)

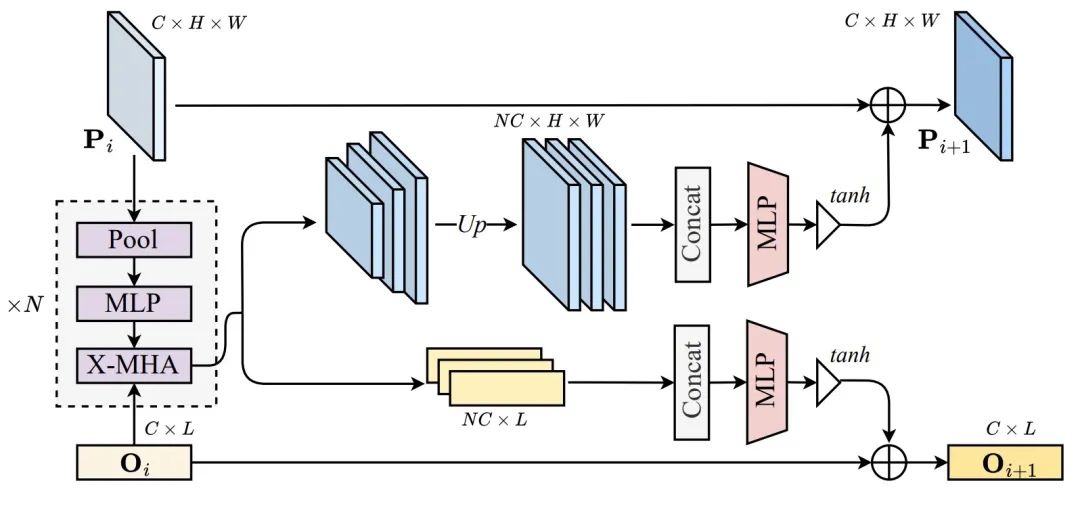

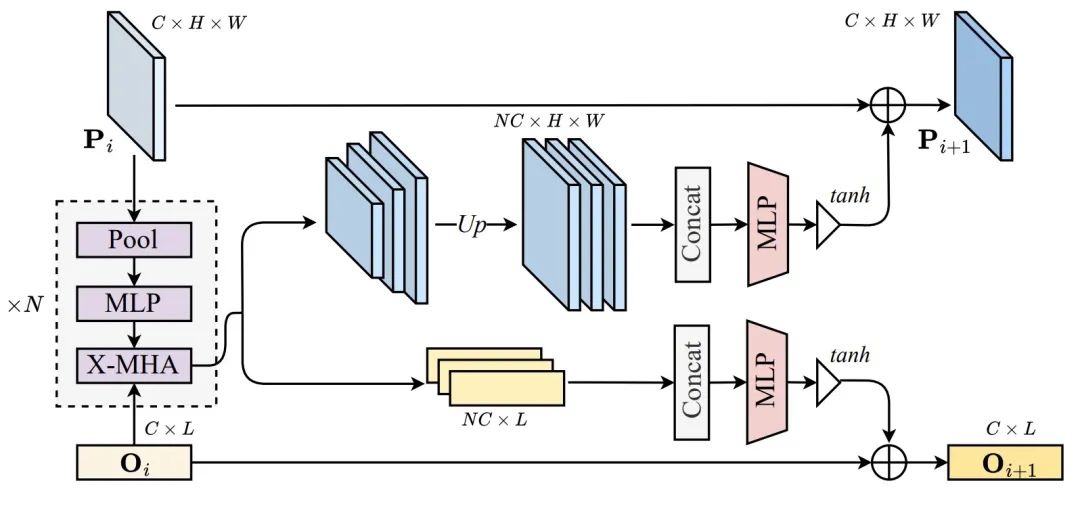

## 圖上中:Cross-modal Alignment Module 結構圖##13!模態對齊模組(CAM),透過在執行語言- 影像融合之前將全局上下文先驗注入影像特徵來增強語言- 影像對齊效果。 CAM 首先使用不同視窗大小的池化操作來產生 K 個不同金字塔尺度的特徵圖。然後,每個特徵圖透過 3 層 MLP 以更好地提取全局訊息,並與另一個模態進行交叉注意力操作。接下來,所有輸出特徵透過雙線性插值上取樣到原始特徵圖尺寸,並在通道維度上拼接。隨後,使用一個 2 層 MLP 將拼接後的特徵通道數減少回原始維度。為了防止多模態訊號淹沒原始訊號,使用一個具有 Tanh 非線性的閘控單元來調製最終輸出。最後,這個門控後的特徵被加回輸入特徵中,然後傳遞給影像或語言編碼器的下一階段。在作者的實作中,CAM 被加到圖像和語言編碼器的每個階段末尾。

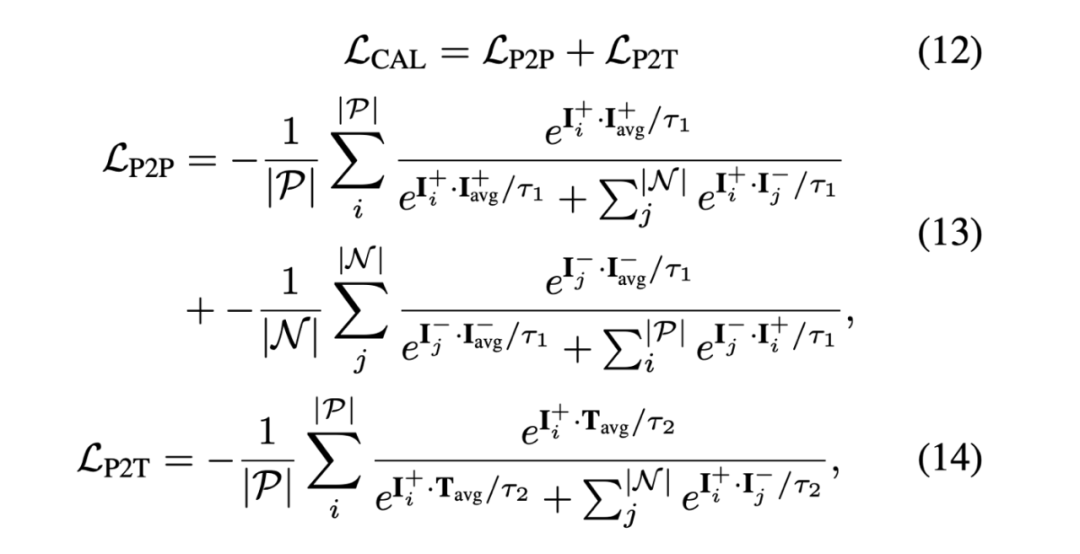

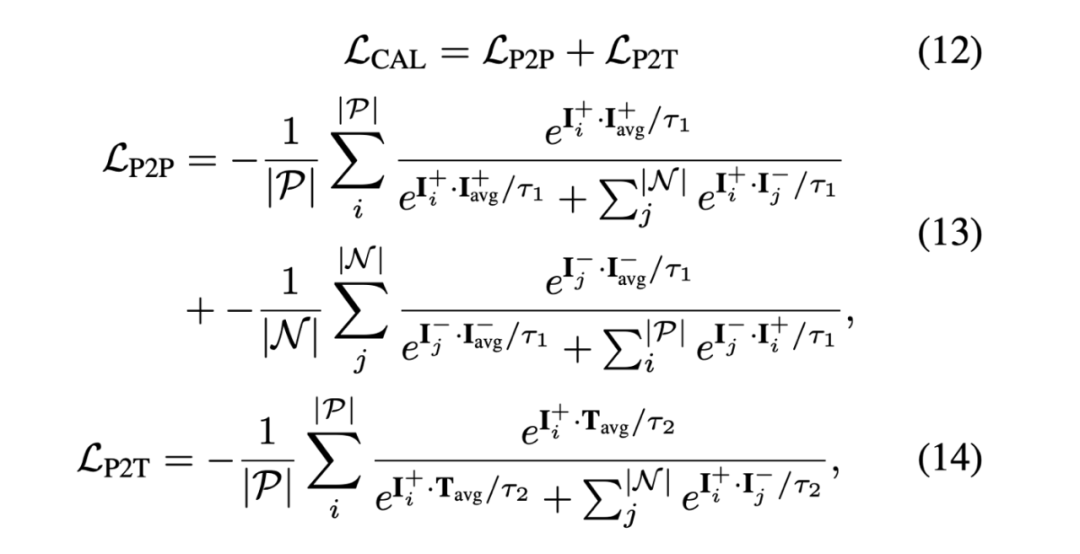

3.Cross-modal Alignment Loss (CAL)

## 中使用模態對齊損失函數(CAL)。圖五展示了此損失函數的數學公式。與先前工作不同,CAL 同時考慮了像素到像素 (Pixel-to-Pixel,P2P) 和像素到文字 (Pixel-to-Text,P2T) 之間的對齊。精確的像素到像素對齊能確保模型能分割輸出具有準確形狀和邊界的分割掩碼,而精確的像素到文字對齊能使模型能夠正確地將文字描述與其匹配的圖像區域進行合理的關聯。 實驗

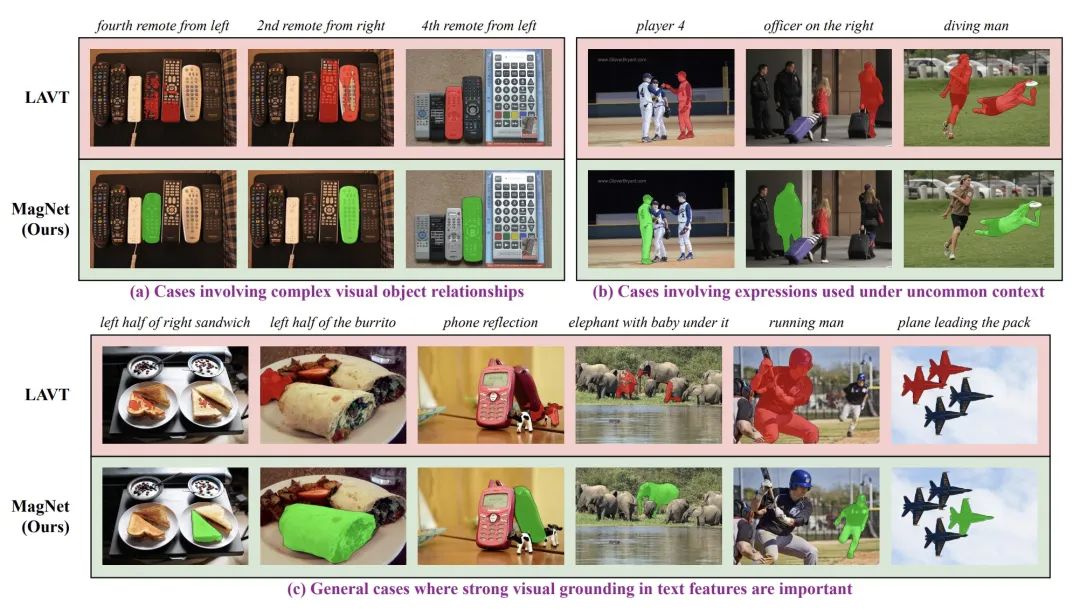

#在表1 中,作者使用oIoU 指標評估MagNet,並與現有最先進的演算法做性能比較。測試數據為 RefCOCO、RefCOCO 和 G-Ref。在單一和多個 / 額外資料集的設定下,MagNet 的效能在這些資料集上全都是 SOTA。 可视化结果 在图 6 中,我们可以看到,MagNet 的可视化结果也非常突出,在许多困难的场景中都比对比基准 LAVT 强很多。这篇文章深入探讨了指代分割(RIS)领域的挑战和当前存在的问题,特别是在细粒度语言 - 图像对齐方面的不足。针对这些问题,清华大学和博世中央研究院的研究人员提出了一种新的方法,名为 MagNet,通过引入辅助任务 Mask Grounding、跨模态对齐模块和跨模态对齐损失函数,全面提升了语言和图像之间的对齐效果。实验证明,MagNet 在 RefCOCO、RefCOCO 和 G-Ref 数据集上均取得了显著优异的性能,超越了之前最先进的算法,表现出了强大的泛化能力。可视化结果也证实了 MagNet 在处理复杂场景和语言表达时的优越性。这一研究为指代分割领域的进一步发展提供了有益的启示,有望推动该领域取得更大的突破。此论文来源于清华大学自动化系(https://www.au.tsinghua.edu.cn)和博世中央研究院(https://www.bosch.com/research/)。其中论文一作庄荣贤为清华大学在读博士生,并在博世中央研究院实习;项目负责人为邱旭冲博士,任博世中央研究院资深研发科学家;通讯作者为清华大学自动化系黄高教授。

在图 6 中,我们可以看到,MagNet 的可视化结果也非常突出,在许多困难的场景中都比对比基准 LAVT 强很多。这篇文章深入探讨了指代分割(RIS)领域的挑战和当前存在的问题,特别是在细粒度语言 - 图像对齐方面的不足。针对这些问题,清华大学和博世中央研究院的研究人员提出了一种新的方法,名为 MagNet,通过引入辅助任务 Mask Grounding、跨模态对齐模块和跨模态对齐损失函数,全面提升了语言和图像之间的对齐效果。实验证明,MagNet 在 RefCOCO、RefCOCO 和 G-Ref 数据集上均取得了显著优异的性能,超越了之前最先进的算法,表现出了强大的泛化能力。可视化结果也证实了 MagNet 在处理复杂场景和语言表达时的优越性。这一研究为指代分割领域的进一步发展提供了有益的启示,有望推动该领域取得更大的突破。此论文来源于清华大学自动化系(https://www.au.tsinghua.edu.cn)和博世中央研究院(https://www.bosch.com/research/)。其中论文一作庄荣贤为清华大学在读博士生,并在博世中央研究院实习;项目负责人为邱旭冲博士,任博世中央研究院资深研发科学家;通讯作者为清华大学自动化系黄高教授。

以上是CVPR 2024 | 擅長處理複雜場景與語言表達,清華&博世提出全新實例分割網路架構MagNet的詳細內容。更多資訊請關注PHP中文網其他相關文章!