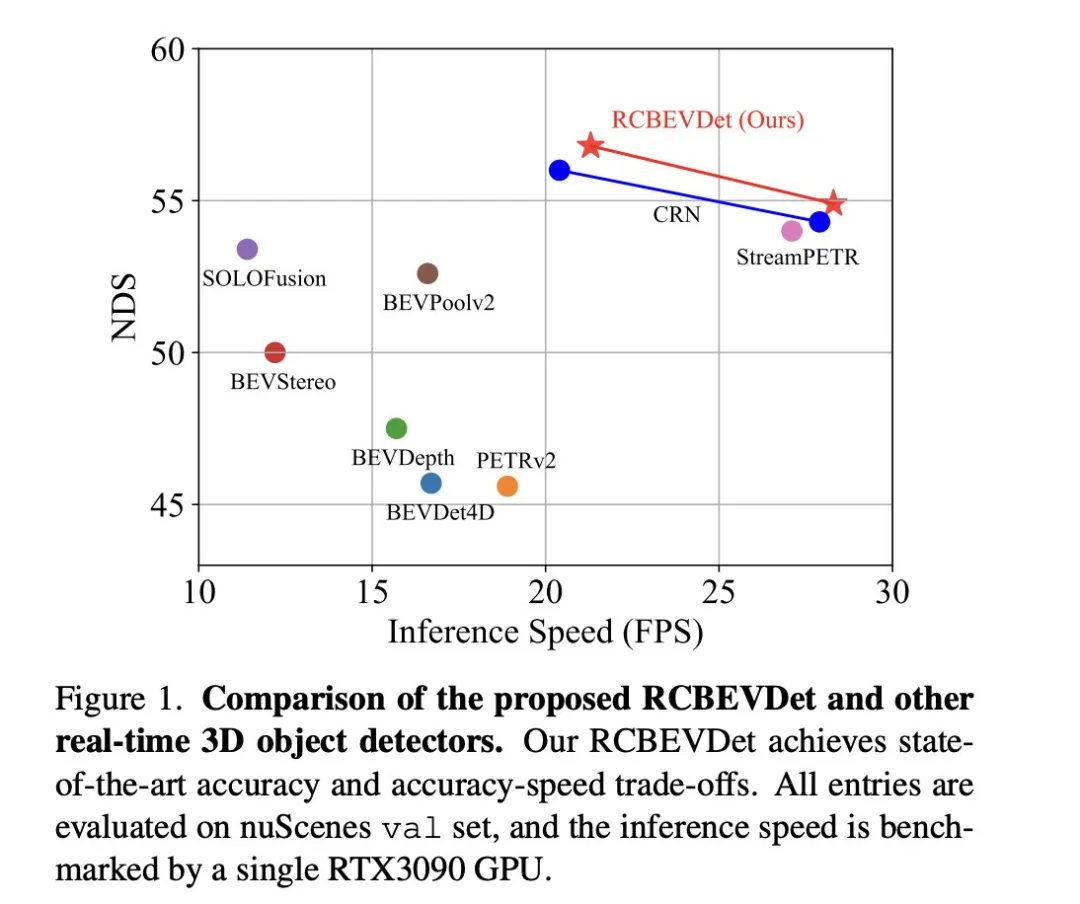

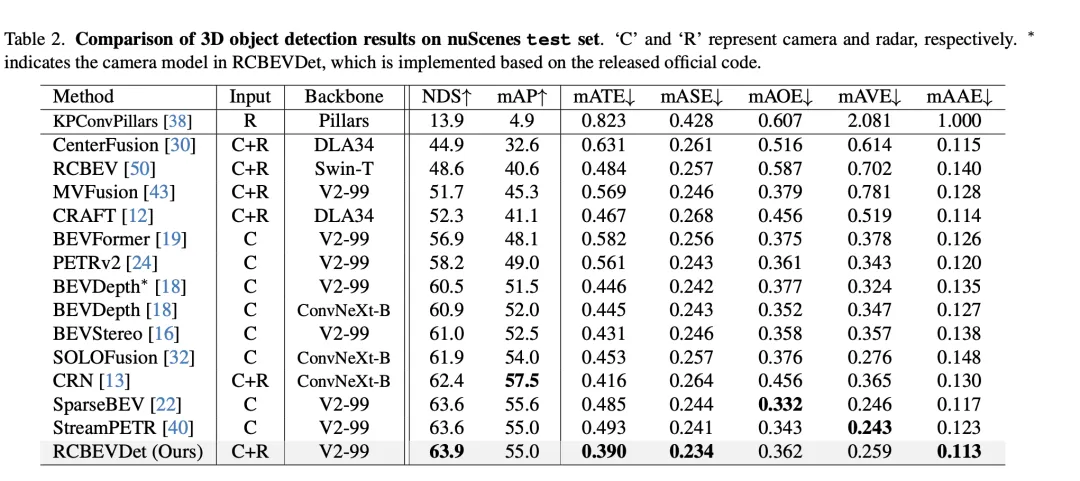

這篇討論文關注的主要問題是3D目標偵測技術在自動駕駛進程中的應用。儘管環境視覺相機技術的發展為3D目標檢測提供了高分辨率的語義訊息,但這種方法因無法精確捕獲深度資訊和在惡劣天氣或低光照條件下的表現不佳等問題而受限。針對這一問題,討論提出了一種結合環視相機和經濟型毫米波雷達感測器的多模式3D目標檢測新方法—RCBEVDet。該方法透過綜合使用多感測器的信息,提供了更豐富的語義資訊以及在惡劣天氣或低光照條件下的表現不佳等問題的解決方案。針對這一問題,討論提出了一種結合環視相機和經濟型毫米波雷達感測器的多模式3D目標檢測新方法—RCBEVDet。透過綜合使用多模感測器的信息,RCBEVDet能夠提供高解析度的語義訊息,並在惡劣天氣或低光照條件下表現出良好的性能。此方法的提出對於改善自動

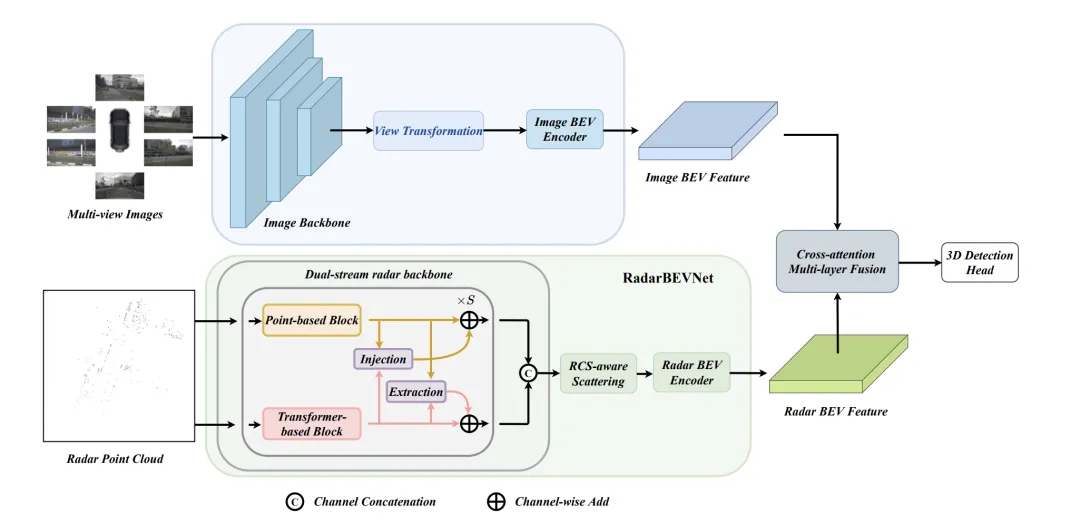

RCBEVDet的核心在於兩個關鍵設計:RadarBEVNet和Cross-Attention Multi-layer Fusion Module(CAMF)。 RadarBEVNet旨在有效提取雷達特徵,它包括雙流雷達主幹網路RCS(雷達截面積)感知的BEV(鳥瞰圖)編碼器。這樣的設計利用了點雲基和變換器基編碼器處理雷達點,透過交互更新雷達點特徵,同時將雷達特定的RCS特性作為目標大小的先驗資訊來優化BEV空間的點特徵分佈。 CAMF模組透過多模態交叉注意力機制解決了雷達點的方位誤差問題,實現了雷達和相機的BEV特徵圖的動態對齊以及透過通道和空間融合的多模態特徵自適應融合。 在實作中,透過互動更新雷達點特徵,同時將雷達特定的RCS特性作為目標大小的先驗資訊來優化BEV空間的點特徵分佈。 CAMF模組透過多模態交叉注意力機制解決了雷達點的方位誤差問題,實現了雷達和相機的BEV特徵圖的動態對齊以及透過通道和空間融合的多模態特徵自適應融合。

論文提出的新方法透過以下幾點實現對現有問題的解決:

論文的主要貢獻如下:

RadarBEVNet是這篇論文提出的有效雷輛BEV(鳥現圖)特徵提取的網路架構,主要包括兩個核心組成部分:雙流雷達主幹網路和RCS(雷達截面積)感知的BEV編碼器。 雙流雷達主幹網路用於從多通道雷達資料中提取豐富的特徵表示。它基於深度卷積神經網路(CNN)構建,在嵌套的捲積和池化層之間交替進行特徵提取和降維操作,以逐漸獲得抽

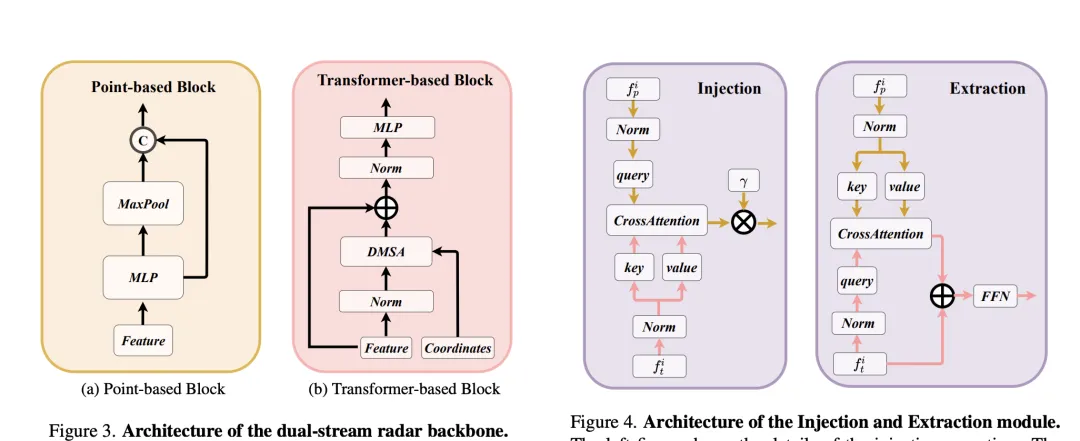

雙流雷達主幹網路由點基主幹幹和變換器基底主幹組成。點基主幹網路透過多層感知機(MLP)和最大池化操作學習部雷達特徵,其過程可以簡化為以下公式:

在這裡的表示雷達點特徵,透過MLP增加特徵維度後,再透過最大池化操作提取全局資訊並與高維特徵連接。

變換器基於幹擾量塊,引入了距離調製的注意力機制(DMSA),透過考慮雷達點之間的距離訊息,優化模型聚集鄰近資訊的能力,促進模型的收斂。 DMSA機制的自註意力可表示為:

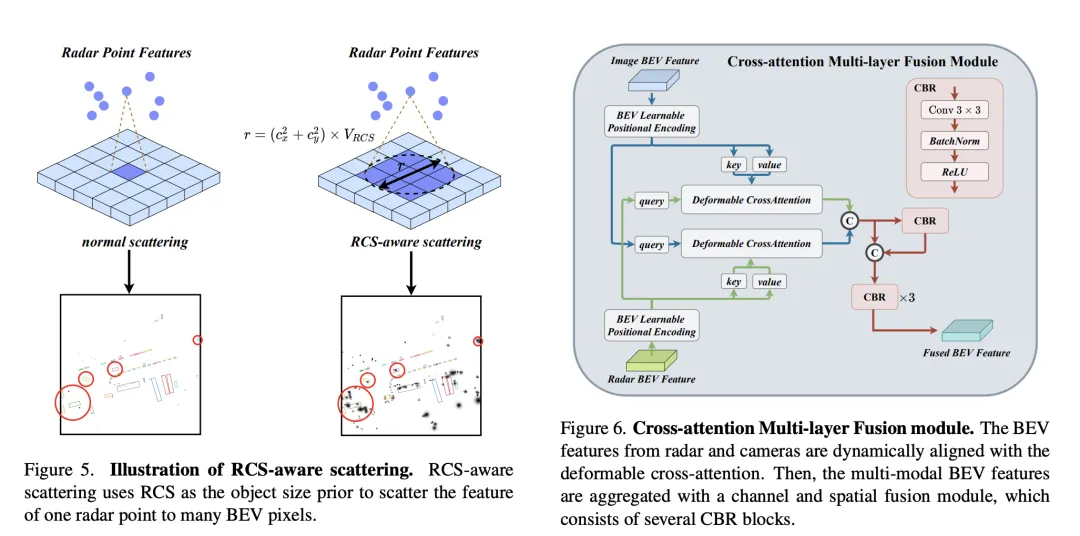

為了解決傳統雷達BEV編碼器產生的BEV特徵稀疏性問題,提出了RCS感知的BEV編碼器。它利用RCS作為目標大小的先驗訊息,將雷達點特徵散佈到BEV空間中的多個像素上,而不是單一像素,以增加BEV特徵的密度。該過程透過以下公式實現:

其中,為基於RCS的高斯式BEV權重圖,透過最大化所有雷達點的權重圖來最佳化。最終,將RCS散佈得到的特徵與連接並透過MLP處理,得到最終的RCS感知BEV特徵。

整體而言,RadarBEVNet透過結合雙流雷達主幹網路和RCS感知的BEV編碼器,高效地提取雷達資料的特徵,並透過RCS作為目標大小的先驗,優化了BEV空間的特徵分佈,為之後的多模態融合提供了強大的基礎。

Cross-Attention Multi-layer Fusion Module (CAMF)是一種用於動態對齊和融合多模態特徵的高階網路結構,特別針對雷達和相機產生的鳥瞰圖(BEV)特徵的動態對齊和融合設計。這個模組主要解決了由於雷達點雲的方位誤差導致的特徵不對齊問題,透過變形的交叉注意力機制(Deformable Cross-Attention),有效地捕捉雷達點的微小偏差,並減少了標準交叉注意力的計算複雜度。

CAMF利用變形交叉注意力機制來對齊相機和雷達的BEV特徵。給定相機和雷達的BEV特徵和,首先給和添加可學習的位置嵌入,然後將轉換為查詢和參考點,作為鍵和值。多頭變形交叉注意力的計算可以表示為:

其中表示注意力頭的索引,表示取樣鍵的索引,是總的取樣鍵數。表示採樣偏移,是由和計算得到的注意力權重。

在透過交叉注意力對齊相機和雷達的BEV特徵之後,CAMF使用通道和空間融合層來聚合多模態BEV特徵。具體地,首先將兩個BEV特徵串聯為,然後將送入CBR(卷積-批歸一化-激活函數)區塊並透過殘差連接獲得融合特徵。 CBR塊依序由一個的捲積層、一個批歸一化層和一個ReLU激活函數組成。之後,連續應用三個CBR塊以進一步融合多模態特徵。

透過上述過程,CAMF有效地實現了雷達和相機BEV特徵的精確對齊和高效融合,為3D目標檢測提供了豐富而準確的特徵信息,從而提高了檢測性能。

在VoD驗證集上的3D目標偵測結果比較中,RadarBEVNet透過融合相機和雷達數據,在整個標註區域內和興趣區域內的平均精度(mAP)表現上均展現了優秀的性能。具體來說,對於整個標註區域,RadarBEVNet在汽車、行人和騎乘者的偵測上分別達到了40.63%、38.86%和70.48%的AP值,將綜合mAP提升到了49.99%。而在興趣區域,即靠近本車的駕駛通道內,RadarBEVNet的表現更為突出,分別在汽車、行人和騎行者的檢測上達到了72.48%、49.89%和87.01%的AP值,綜合mAP達到了69.80%。

這些結果揭示了幾個關鍵點。首先,RadarBEVNet透過有效融合相機和雷達輸入,能夠充分利用兩種感光元件的互補優勢,提升了整體的偵測效能。相較於僅使用雷達的方法如PointPillar和RadarPillarNet,RadarBEVNet在綜合mAP上有明顯的提升,顯示多模態融合對於提高偵測精度尤為重要。其次,RadarBEVNet在興趣區域內的表現特別優秀,這對於自動駕駛應用來說尤其關鍵,因為興趣區域內的目標通常對即時駕駛決策影響最大。最後,雖然在汽車和行人的偵測上,RadarBEVNet的AP值略低於某些單一模態或其他多模態方法,但在騎乘者偵測和綜合mAP表現上,RadarBEVNet展現了其綜合性能的優勢。 RadarBEVNet透過融合相機和雷達的多模態數據,實現了在VoD驗證集上的優異表現,特別是在對自動駕駛至關重要的興趣區域內展現了強大的檢測能力,證明了其作為一種有效的3D目標檢測方法的潛力。

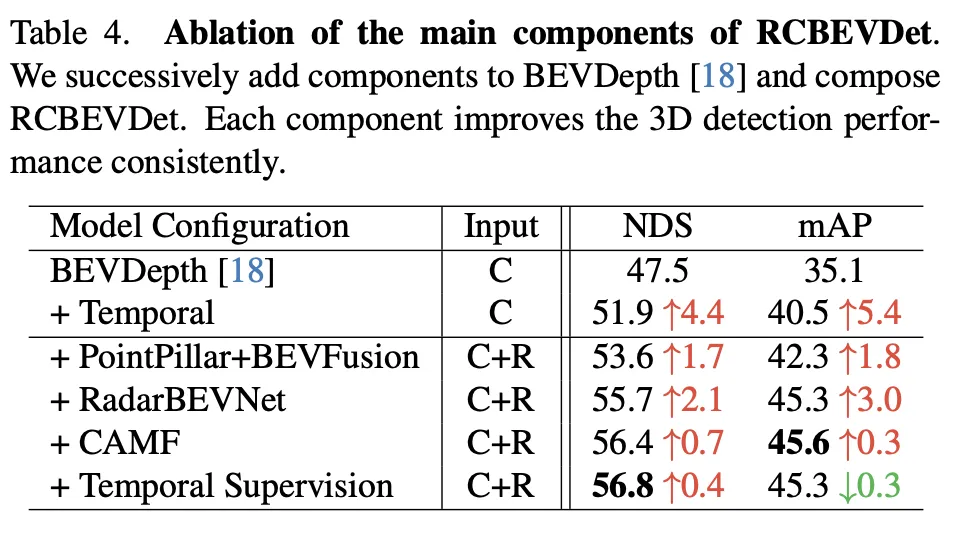

这个消融实验展示了RadarBEVNet在逐步添加主要组件时,对3D目标检测性能的持续改进。从基准模型BEVDepth开始,每一步增加的组件都显著提高了NDS(核心度量标准,反映了检测精度和完整性)和mAP(平均精确度,反映了模型对目标的检测能力)。

总的来说,这一系列的消融实验清晰地展示了RadarBEVNet中每个主要组件对于提高3D目标检测性能的贡献,从时间信息的引入到复杂的多模态融合策略,每一步都为模型带来了性能上的提升。特别是,对雷达和相机数据的精细处理和融合策略,证明了在复杂的自动驾驶环境中,多模态数据处理的重要性。

论文提出的RadarBEVNet方法通过融合相机和雷达的多模态数据,有效地提升了3D目标检测的准确性和鲁棒性,尤其在复杂的自动驾驶场景中表现出色。通过引入RadarBEVNet和Cross-Attention Multi-layer Fusion Module(CAMF),RadarBEVNet不仅优化了雷达数据的特征提取过程,还实现了雷达和相机数据之间精准的特征对齐和融合,从而克服了单一传感器数据使用中的局限性,如雷达的方位误差和相机在低光照或恶劣天气条件下的性能下降。

优点方面,RadarBEVNet的主要贡献在于其能够有效处理并利用多模态数据之间的互补信息,提高了检测的准确度和系统的鲁棒性。RadarBEVNet的引入使得雷达数据的处理更为高效,而CAMF模块确保了不同传感器数据之间的有效融合,弥补了各自的不足。此外,RadarBEVNet在实验中展现了在多个数据集上的优异性能,尤其是在自动驾驶中至关重要的兴趣区域内,显示了其在实际应用场景中的潜力。

缺点方面,尽管RadarBEVNet在多模态3D目标检测领域取得了显著成果,但其实现的复杂性也相应增加,可能需要更多的计算资源和处理时间,这在一定程度上限制了其在实时应用场景中的部署。此外,虽然RadarBEVNet在骑行者检测和综合性能上表现优秀,但在特定类别上(如汽车和行人)的性能仍有提升空间,这可能需要进一步的算法优化或更高效的特征融合策略来解决。

总之,RadarBEVNet通过其创新的多模态融合策略,在3D目标检测领域展现了显著的性能优势。尽管存在一些局限性,如计算复杂度较高和在特定检测类别上的性能提升空间,但其在提高自动驾驶系统准确性和鲁棒性方面的潜力不容忽视。未来的工作可以聚焦于优化算法的计算效率和进一步提高其在各类目标检测上的表现,以推动RadarBEVNet在实际自动驾驶应用中的广泛部署。

论文通过融合相机和雷达数据,引入了RadarBEVNet和Cross-Attention Multi-layer Fusion Module(CAMF),在3D目标检测领域展现出显著的性能提升,特别是在自动驾驶的关键场景中表现优异。它有效地利用了多模态数据之间的互补信息,提高了检测准确性和系统的鲁棒性。尽管存在计算复杂度高和在某些类别上性能提升空间的挑战,\ours在推动自动驾驶技术发展,尤其是在提升自动驾驶系统的感知能力方面,展现了巨大的潜力和价值。未来工作可以关注于优化算法效率和进一步提升检测性能,以便更好地适应实时自动驾驶应用的需求。

以上是RV融合性能拉爆! RCBEVDet:Radar也有春天,最新SOTA!的詳細內容。更多資訊請關注PHP中文網其他相關文章!