只需2張圖片,無需測量任何額外數據-

當當,一個完整的3D小熊就有了:

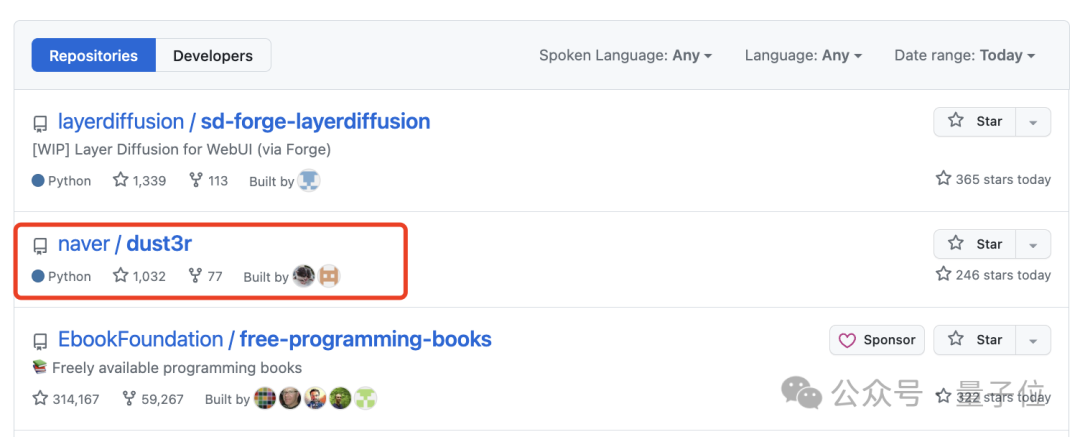

這個名為DUSt3R的新工具,火得一塌糊塗,才上線沒多久就登上GitHub熱榜第二。

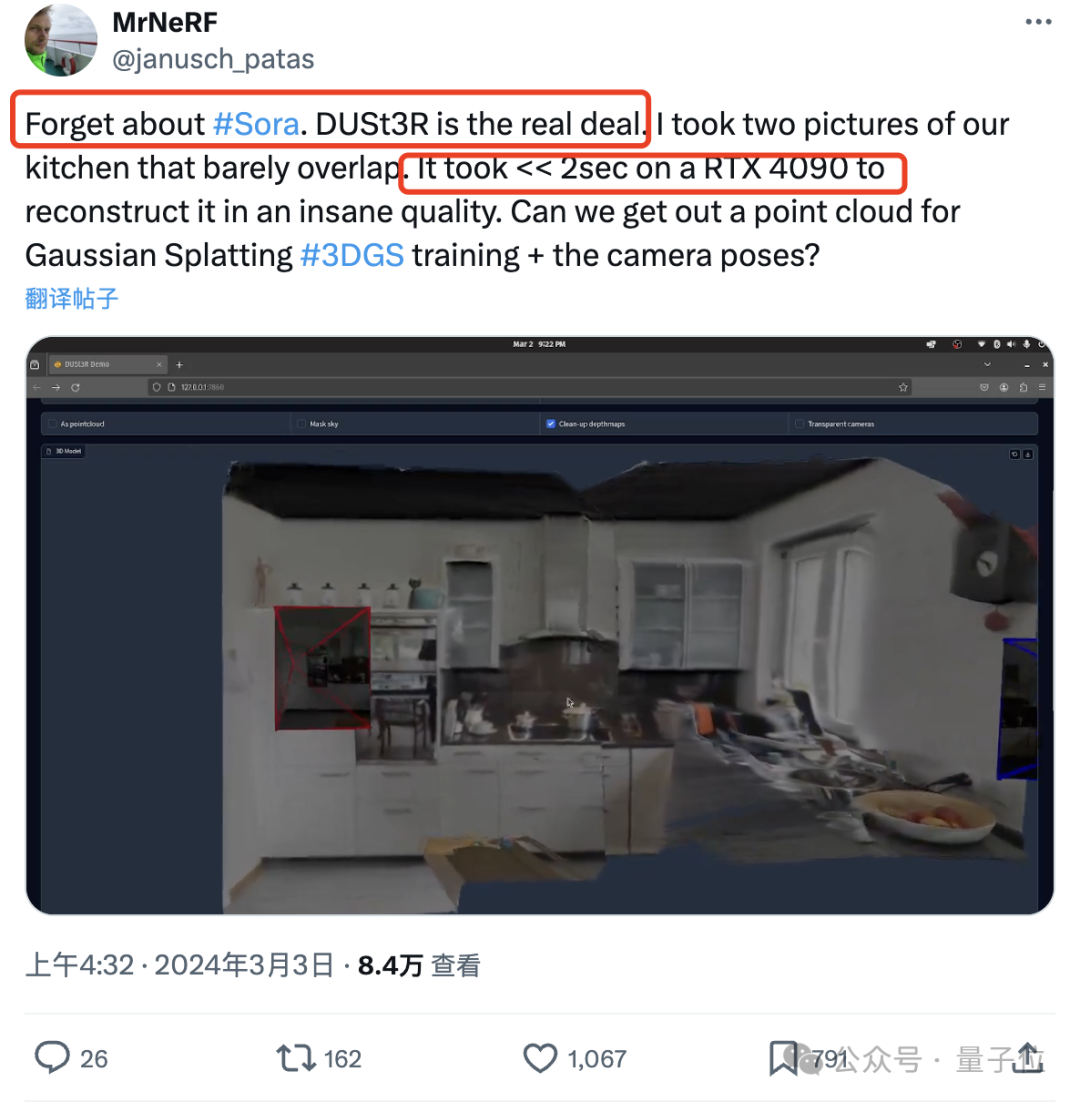

有網友實測#,拍兩張照片,真的就重建出了他家的廚房,整個過程耗時不到2秒鐘!

(除了3D圖,深度圖、置信度圖和點雲圖它都能一併給出)

驚得這位朋友直呼:

大夥先忘掉sora吧,這才是我們真正看得見摸得著的東西。

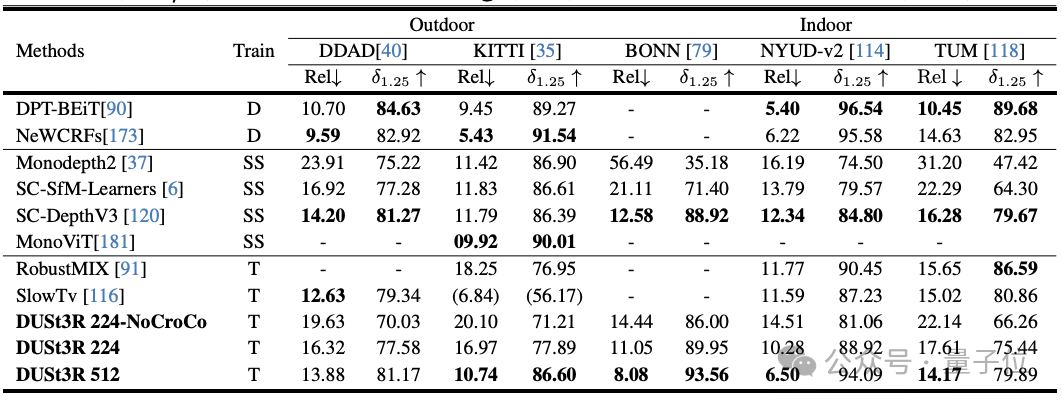

實驗顯示,DUSt3R在單目/多視圖深度估計以及相對位姿估計三個任務上,均取得SOTA。

作者團隊(來自芬蘭阿爾託大學NAVER LABS人工智慧研究所歐洲分所)的「宣語」也是氣勢滿滿:

我們就是要讓天下沒有難搞的3D視覺任務。

所以,它是如何做到?

對於多視圖立體重建(MVS)任務來說,第一步就是估計相機參數,包括內外參。

這個操作很枯燥也很麻煩,但對於後續在三維空間中進行三角測量的像素不可或缺,而這又是幾乎所有效能比較好的MVS演算法都離不開的一環。

在本文研究中,作者團隊引進的DUSt3R則完全採用了截然不同的方法。

它不需要任何相機校準或視點姿勢的先驗資訊,就可完成任意影像的密集或無約束3D重建。

在此,團隊將成對重建問題表述為點圖迴歸,統一單目和雙眼重建情況。

在提供超過兩張輸入影像的情況下,透過簡單而有效的全域對準策略,將所有成對的點圖表示為一個共同的參考框架。

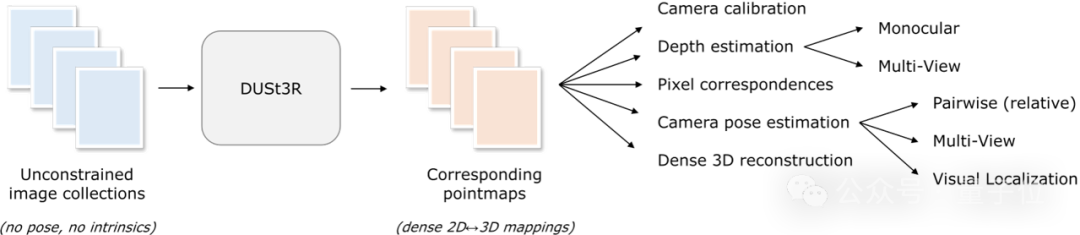

如下圖所示,給定一組具有未知相機姿態和內在特徵的照片,DUSt3R輸出對應的一組點圖,從中我們就可以直接恢復各種通常難以同時估計的幾何量,如相機參數、像素對應關係、深度圖,以及完全一致的3D重建效果。

(作者提示,DUSt3R也適用於單張輸入影像)

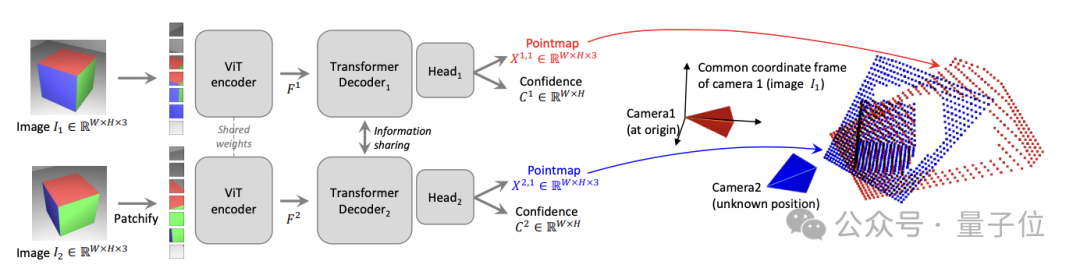

具體網路架構方面,DUSt3R基於的是標準Transformer編碼器和解碼器,受到了CroCo(透過跨視圖完成3D視覺任務的自我監督預訓練的一個研究)的啟發,並採用簡單的回歸損失訓練完成。

如下圖所示,場景的兩個視圖(I1,I2)首先以共享的ViT編碼器以連體(Siamese)方式進行編碼。

所得到的token表示(F1和F2)隨後被傳遞到兩個Transformer解碼器,後者透過交叉注意力不斷地交換資訊。

最後,兩個迴歸頭輸出兩個對應的點圖和相關的置信圖。

重點是,這兩個點圖都要在第一張影像的同一座標系中進行表示。

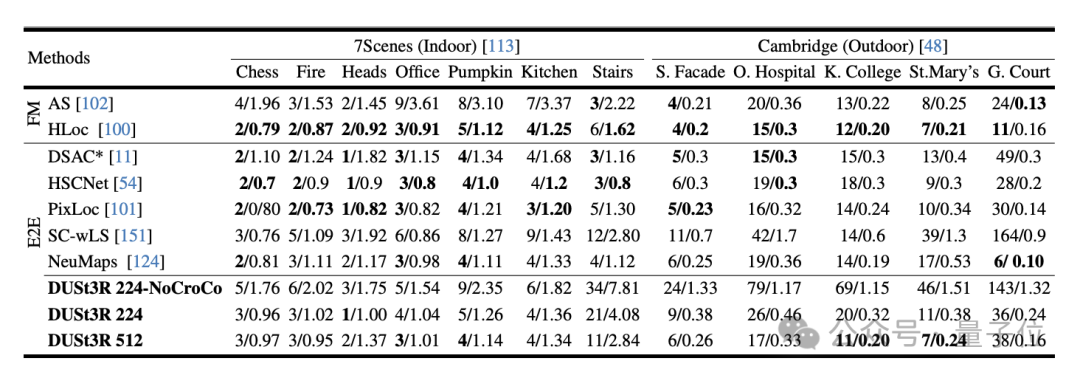

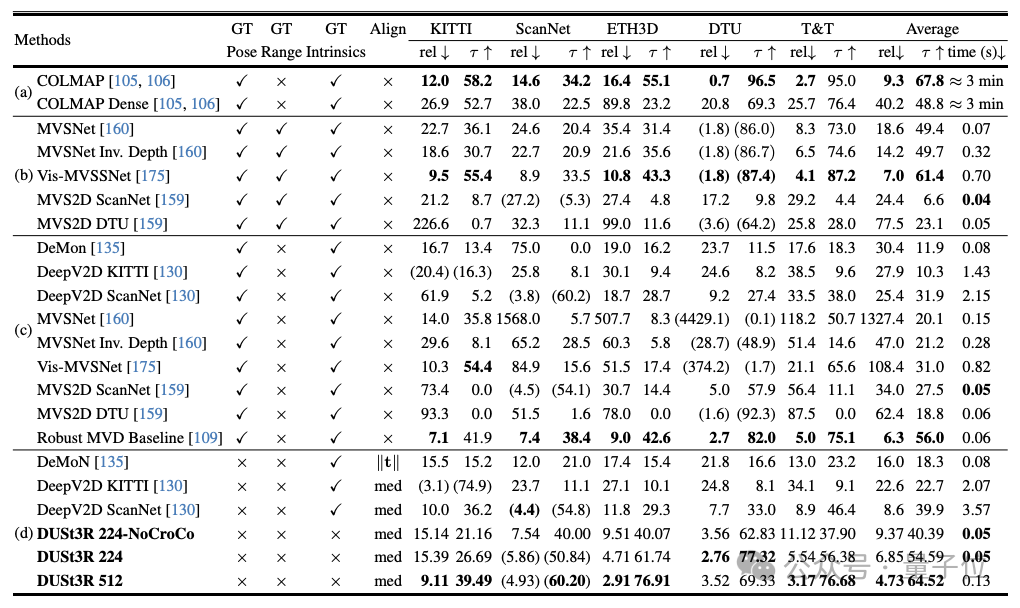

The experiment first evaluates DUST3R on the 7Scenes (7 indoor scenes) and Cambridge Landmarks (8 outdoor scenes) datasets Performance on the absolute pose estimation task, the indicators are translation error and rotation error (the smaller the value, the better) .

The author stated that compared with other existing feature matching and end-to-end methods, the performance of DUSt3R is remarkable.

Because it has never received any visual positioning training, and secondly, it has not encountered query images and database images during the training process.

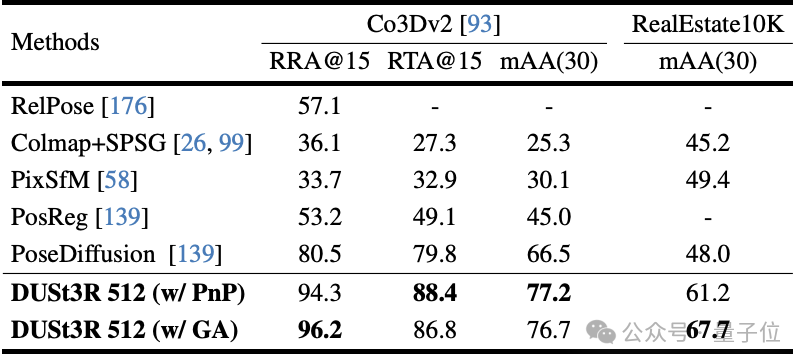

Secondly, is the multi-view pose regression task performed on 10 random frames. Results DUST3R achieved the best results on both datasets.

On the monocular depth estimation task, DUSt3R can also hold indoor and outdoor scenes well, with performance better than that of self-supervised baselines and different from the most advanced supervised baselines. Up and down.

In terms of multi-view depth estimation, DUSt3R’s performance is also outstanding.

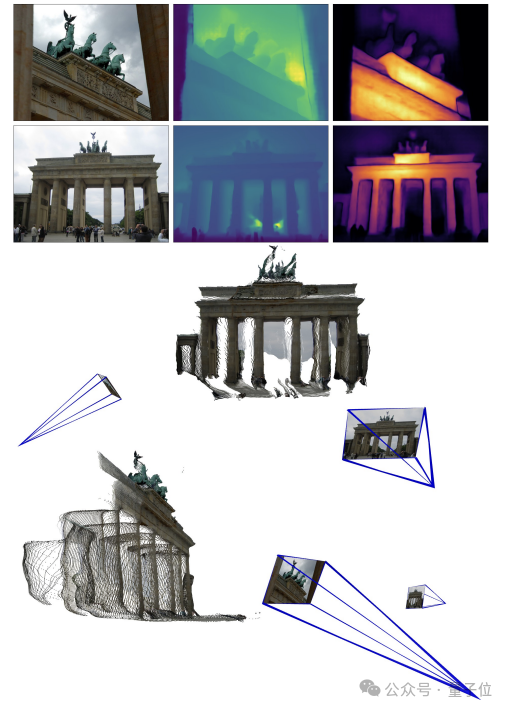

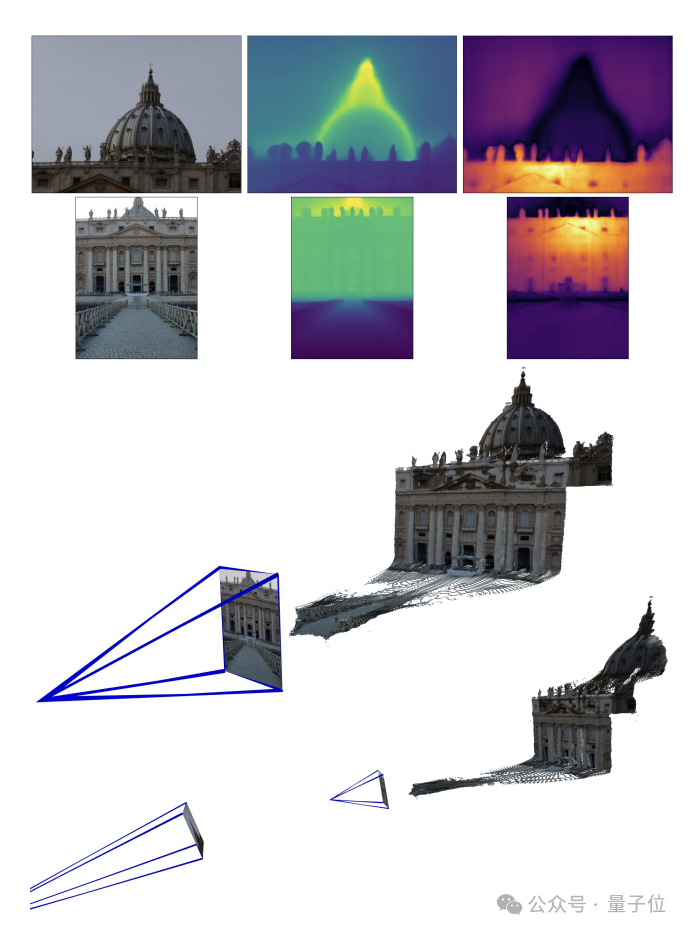

The following are the 3D reconstruction effects given by the two groups of officials. To give you a feel, they only input two images:

(1)

(2)

Yes A netizen gave DUST3R two images without any overlapping content, and it also output an accurate 3D view within a few seconds:

(The picture is his office, so I must have never seen it in training)

In response, some netizens said that this means that the method is not there Make "objective measurements" and instead behave more like an AI.

In addition, some people are curiousWhether the method is still valid when the input images are taken by two different cameras?

Some netizens actually tried it, and the answer is yes!

Portal:

[1]Paper https://arxiv.org/abs/2312.14132

[2]Code https ://github.com/naver/dust3r

以上是兩張圖2秒鐘3D重建!這款AI工具火爆GitHub,網友:忘掉Sora的詳細內容。更多資訊請關注PHP中文網其他相關文章!