在自動駕駛領域,研究人員也朝著 GPT/Sora 等大模型方向進行探索。

與生成式 AI 相比,自動駕駛也是近期 AI 最活躍的研究和開發領域之一。要建立完全的自動駕駛系統,人們面臨的主要挑戰是 AI 的場景理解,這會涉及複雜、不可預測的場景,例如惡劣天氣、複雜的道路佈局和不可預見的人類行為。

目前的自動駕駛系統通常由3D感知、運動預測和規劃三個部分組成。具體而言,3D感知主要用於檢測和追蹤熟悉的物體,但對於罕見物體及其屬性的識別能力有所限制;而運動預測和規劃主要關注物體的軌跡動作,但通常忽略了物體與車輛之間的決策級交互作用。這些限制可能會影響自動駕駛系統在處理複雜交通場景時的準確性和安全性。因此,未來的自動駕駛技術需要進一步改進,以更好地識別和預測各種類型的物體,以及更有效地規劃車輛的行駛路徑,以提高系統的智能性和可靠性

實現自動駕駛的關鍵在於將資料驅動的方法轉變為知識驅動,這需要訓練具備邏輯推理能力的大型模型。只有這樣,自動駕駛系統才能真正解決長尾問題,並且朝向 L4 級能力邁進。目前,隨著像 GPT4、Sora 這樣的大型模型不斷湧現,規模效應也展現出了強大的 few-shot/zero-shot 能力,這使人們開始考慮一種新的發展方向。

最新的研究論文來自清華大學交叉資訊研究院和理想汽車,其中他們介紹了名為DriveVLM的新模型。這項模型受到了生成式人工智慧領域中興起的視覺語言模型(VLM)的啟發。 DriveVLM在視覺理解和推理方面展現了出色的能力。

這項工作在業界是首個提出自動駕駛速度控制系統的工作,其方法充分結合了主流自動駕駛流程和具備邏輯思考能力的大型模型流程,並首次成功將大型模型部署到終端進行測試(基於Orin平台)。

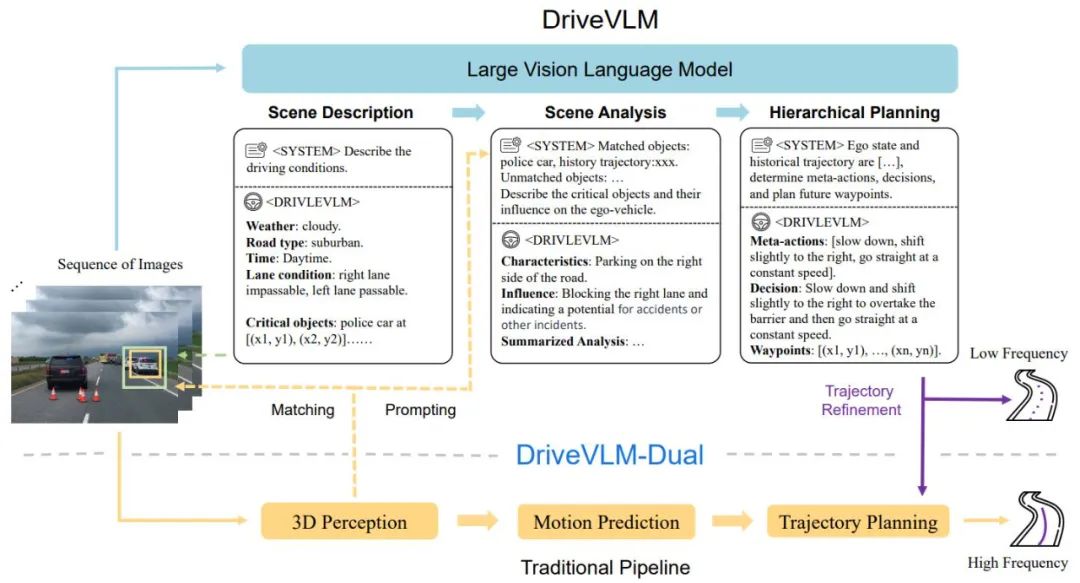

DriveVLM涵蓋一個Chain-of-Though (CoT)流程,包括三個主要模組:情境描述、情境分析和分層規劃。在場景描述模組中,使用語言描述駕駛環境並確定場景中的關鍵對象;場景分析模組深入研究這些關鍵對象的特徵以及它們對自動駕駛車輛的影響;而分層規劃模組則逐步製定計劃,從元動作和決策描述到路徑點。

這些模組對應於傳統自動駕駛系統的感知、預測和規劃步驟,但不同之處在於它們處理物件感知、意圖層級預測和任務層級規劃,這些在以往是非常具有挑戰性的。

雖然 VLM 在視覺理解方面表現出色,但它們在空間基礎和推理方面存在局限性,而且其算力需求對端側推理速度提出了挑戰。因此,作者進一步提出了 DriveVLMDual,這是一個結合了 DriveVLM 和傳統系統優點的混合系統。 DriveVLM-Dual 可選擇將 DriveVLM 與傳統 3D 感知和規劃模組(如 3D 物體探測器、佔用網路和運動規劃器)集成,使系統能夠實現 3D 接地和高頻規劃能力。這種雙系統設計類似於人腦的慢速和快速思考過程,可以有效適應駕駛場景中不同的複雜性。

新研究也進一步明確了情境理解和規劃(SUP)任務的定義,並提出了一些新的評估指標,以評估 DriveVLM 和 DriveVLM-Dual 在情境分析和元動作規劃方面的能力。此外,作者還進行了大量的資料探勘和註釋工作,為 SUP 任務建立了內部 SUP-AD 資料集。

經過 nuScenes 資料集和自有資料集上的大量實驗,人們證明了 DriveVLM 的優越性,尤其是在少量鏡頭的情況下。此外,DriveVLM-Dual 超越了最先進的端到端運動規劃方法。

論文《DriveVLM: The Convergence of Autonomous Driving and Large Vision-Language Models》

論文連結:https://arxiv.org/abs/ 2402.12289

專案連結:https://tsinghua-mars-lab.github.io/DriveVLM/

DriveVLM 的整體流程如圖1 所示:

#將連續影格視覺影像編碼,透過特徵對齊模組,與LMM 互動;

從場景描述開始引導VLM 模型的思考,先引導時間、場景、車道環境等靜態場景,再引導影響駕駛決策關鍵障礙物;

對關鍵障礙物進行分析,透過傳統3D 偵測和VLM 理解的障礙物進行匹配,進⼀步確認障礙物的有效性並消除幻覺,描述該場景下的關鍵障礙物的特徵和對我們駕駛的影響;

給出關鍵的「元決策」,如減速、停車、左右轉等,在根據元決策給出駕駛策略描述,並最終給出主車未來的駕駛軌跡。

#圖 1.DriveVLM 與 DriveVLM-Dual 模型管道。一系列圖像由大視覺語言模型 (VLM) 處理,以執行特殊的思想鏈 (CoT) 推理,從而得出駕駛規劃結果。大型 VLM 涉及視覺變換器編碼器和大語言模型(LLM)。視覺編碼器產生影像標記;然後基於注意力的擷取器將這些標記與 LLM 對齊;最後,LLM 進行 CoT 推理。 CoT 流程可分為三個模組:情境描述、情境分析和層級規劃。

DriveVLM-Dual 是一種混合系統,利用 DriveVLM 對環境的綜合理解和決策軌蹟的建議,提升了傳統自動駕駛 Pipeline 的決策和規劃能力。它將 3D 感知結果合併為語言提示,以增強 3D 場景理解能力,並透過即時運動規劃器進一步細化軌跡路點。

儘管 VLM 擅長識別長尾物體和理解複雜場景,但它們經常難以理解物體的空間位置和詳細運動狀態,這一不足構成了重大挑戰。更糟的是,VLM 龐大的模型體量導致高延遲,阻礙了自動駕駛的即時反應能力。為了應對這些挑戰,作者提出了 DriveVLM-Dual,讓 DriveVLM 和傳統自動駕駛系統合作。這種新方法涉及兩個關鍵策略:結合 3D 感知進行關鍵物件分析,給出高維度駕駛決策訊息,以及高頻軌跡細化。

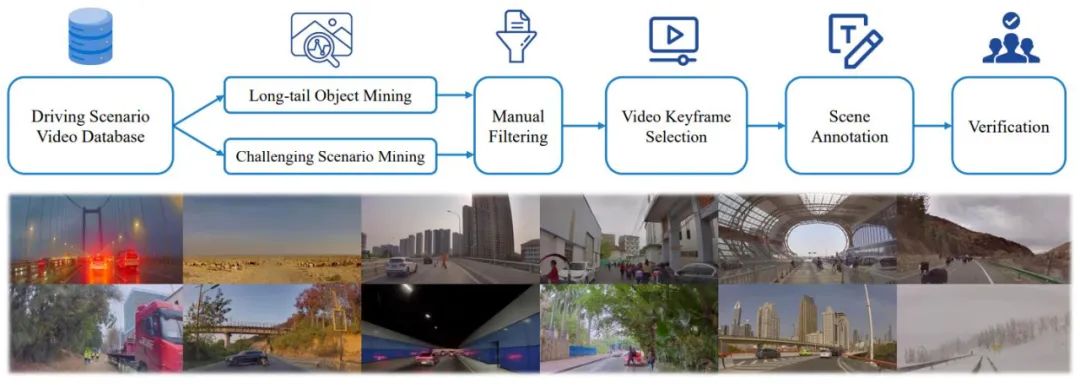

另外,為了充分發揮 DriveVLM 和 DriveVLMDual 在處理複雜和長尾駕駛場景方面的潛力,研究人員正式定義了一項名為場景理解規劃的任務,以及一組評估指標。此外,作者提出了一種資料探勘和註釋協議來管理場景理解和規劃資料集。

為了充分訓練模型,作者全新開發了⼀套Drive LLM 的標註工具和標註方案,透過自動化挖掘、感知演算法預刷、GPT-4 大模型總結和人工標註等多種方式結合,形成了目前這⼀套高效的標註方案,每⼀個Clip 資料都包含了多達數十種標註內容。

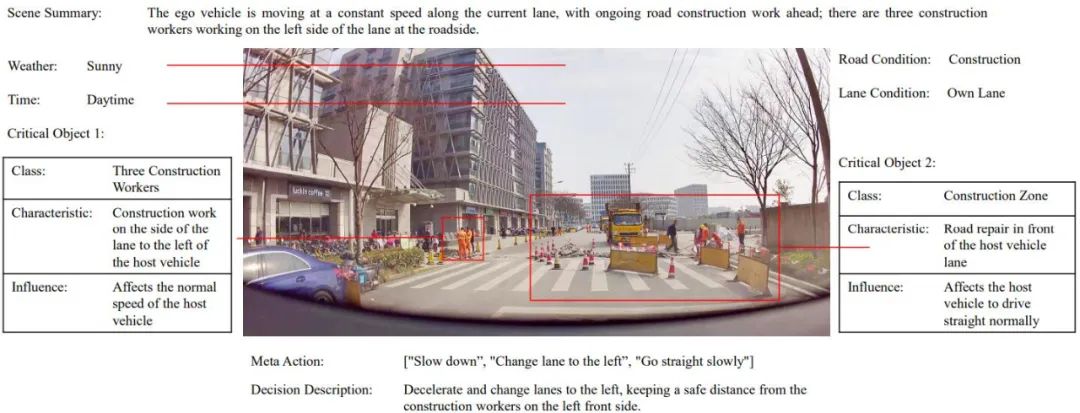

之後中使用資料集的註解範例資料集。

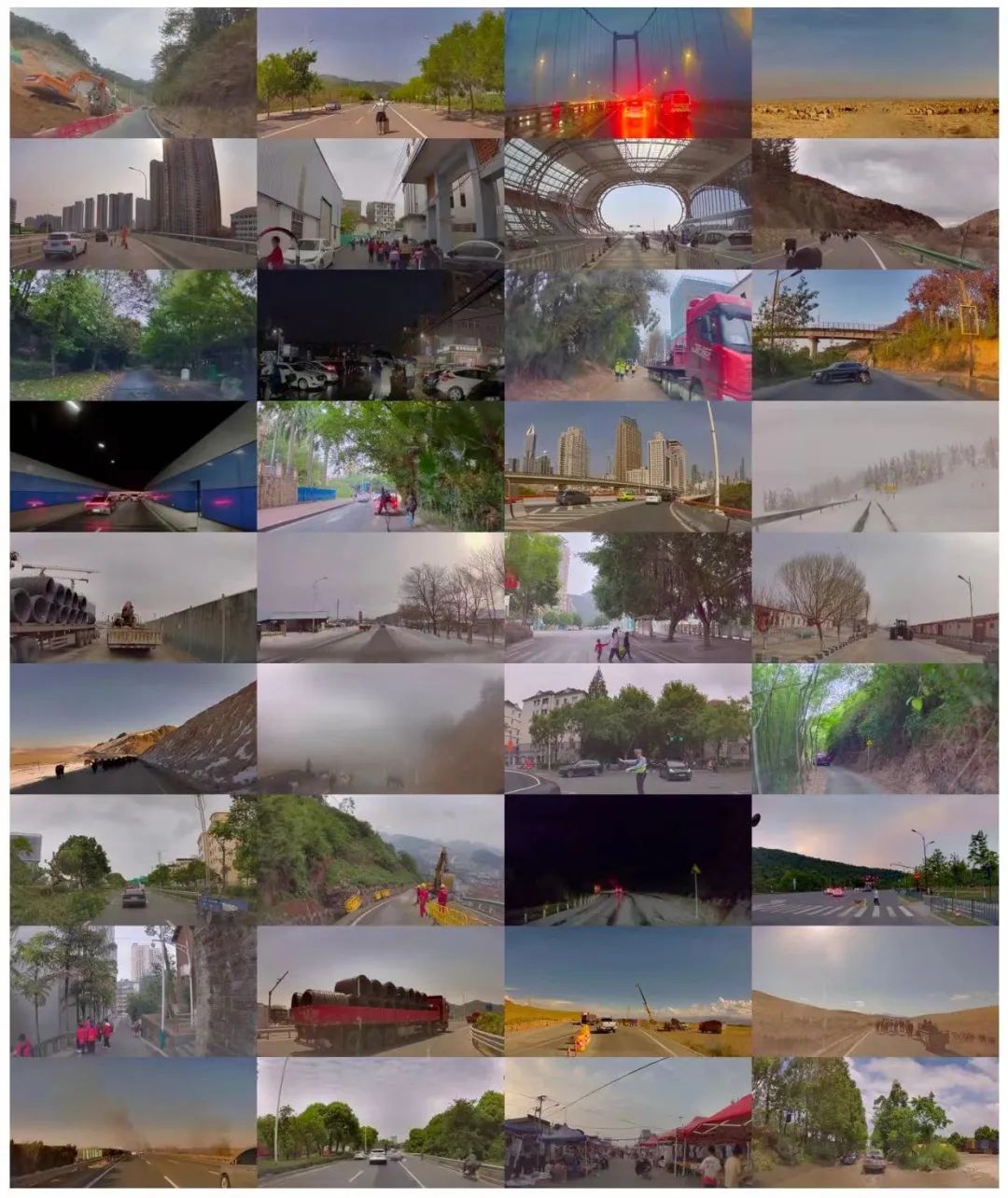

作者也提出了一個全面的資料探勘與註解管道,如圖3 所示,為所提出的任務建構場景理解規劃(SUP-AD,Scene Understanding for Planning in Autonomous Driving) 資料集,包含100k 影像和1000k 圖文對。具體來說,作者首先從大型資料庫中進行長尾物件挖掘和具有挑戰性的場景挖掘來收集樣本,然後從每個樣本中選擇一個關鍵影格並進一步進行場景註釋。

圖 3. 用於建構場景理解和規劃資料集的資料探勘與註解管道(上圖)。從資料集中隨機採樣的場景範例(如下)展示了資料集的多樣性和複雜性。

SUP-AD 分為訓練、驗證和測試部分,比例為 7.5 : 1 : 1.5。作者在訓練分割上訓練模型,並使用新提出的場景描述和元動作指標來評估驗證 / 測試分割上的模型表現。

nuScenes 資料集是一個大規模的城市場景駕駛資料集,有 1000 個場景,每個場景持續約 20 秒。關鍵影格在整個資料集上以 2Hz 的頻率均勻註解。在這裡,作者採用位移誤差(DE)和碰撞率(CR)作為指標來評估模型在驗證分割上的表現。

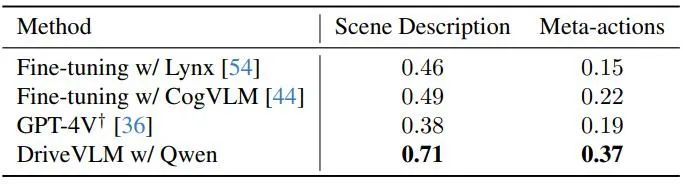

作者展示了 DriveVLM 與幾種大型視覺語言模型的效能,並將它們與 GPT-4V 進行比較,如表 1 所示。 DriveVLM 利用 Qwen-VL 作為其骨幹,其實現了與其他開源 VLM 相比的最佳性能,具有回應和靈活互動的特性。其中前兩個大模型已開源,使用了相同的資料進進了微調訓練,GPT-4V 使用了複雜的 Prompt 進行 Prompt 工程。

表 1. 在 SUP-AD 数据集上的测试集结果。这里使用了 GPT-4V 的官方 API,对于 Lynx 和 CogVLM,利用训练分割来进行微调。

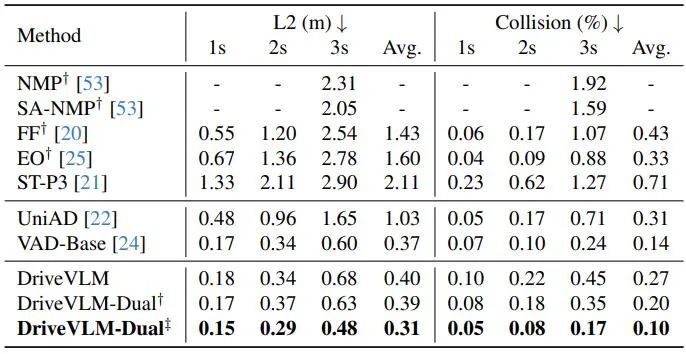

如表 2 所示,DriveVLM-Dual 与 VAD 配合时,在 nuScenes 规划任务上取得了最先进的性能。这表明新方法虽然是为理解复杂场景而定制的,但在普通场景中也表现出色。请注意,DriveVLM-Dual 比 UniAD 有了显著提升:平均规划位移误差降低了 0.64 米,碰撞率降低了 51%。

表 2. nuScenes 验证数据集的规划结果。DriveVLM-Dual 实现了最佳性能。† 表示使用 Uni-AD 的感知和占用预测结果。‡ 表示与 VAD 合作,所有模型都以自我状态作为输入。

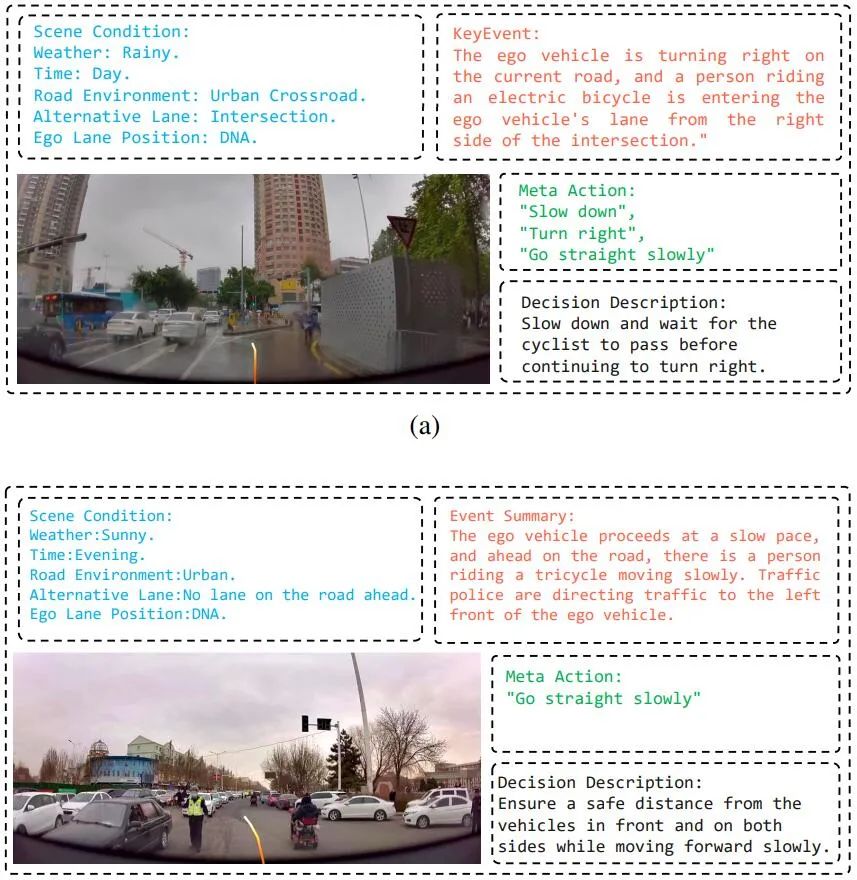

图 4. DriveVLM 的定性结果。橙色曲线代表模型在接下来 3 秒内计划的未来轨迹。

DriveVLM 的定性结果如图 4 所示。在图 4a 中,DriveVLM 准确预测当前场景条件,并结合有关接近我们的骑车人的有思考的规划决策。DriveVLM 还有效地理解了前方交警手势,向自我车辆发出继续前进的信号,并且还考虑了右侧骑三轮车的人,从而做出正确的驾驶决策。这些定性结果证明了 DriveVLM 模型具有理解复杂场景并制定合适驾驶计划的卓越能力。

图 7:SUP-AD 数据集中的各种驾驶场景。

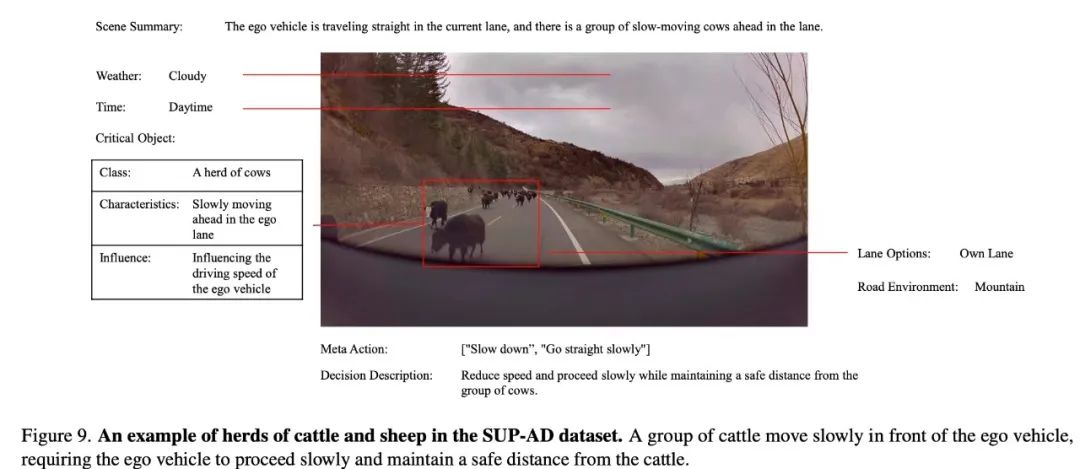

图 9. SUP-AD 数据集中牛群和羊群的示例。一群牛在本车前方缓慢移动,要求策略推理出本车缓慢行驶并与牛保持安全距离。

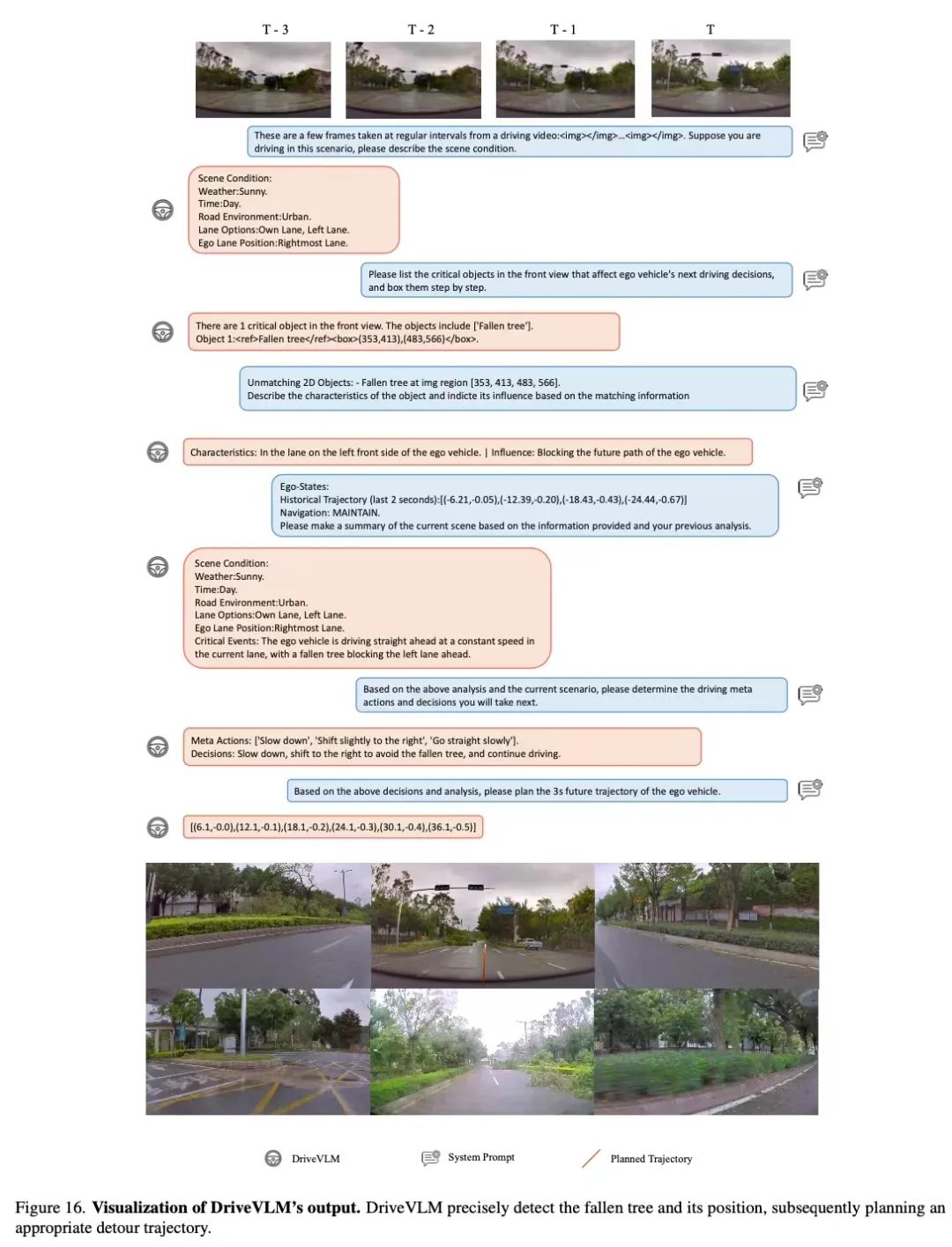

图 16. DriveVLM 输出的可视化。DriveVLM 可以精确检测倒下的树木及其位置,随后规划合适的绕行轨迹。

以上是清華叉院、理想提出DriveVLM,視覺大語言模型提升自動駕駛能力的詳細內容。更多資訊請關注PHP中文網其他相關文章!