隨著LLaMA、Mistral等大語言模型的成功,許多公司開始創建自己的大語言模型。然而,從頭訓練新的模型成本高昂,且可能存在能力冗餘。

近日,中山大學和騰訊 AI Lab 的研究人員提出了 FuseLLM,用於「融合多個異構大模型」。

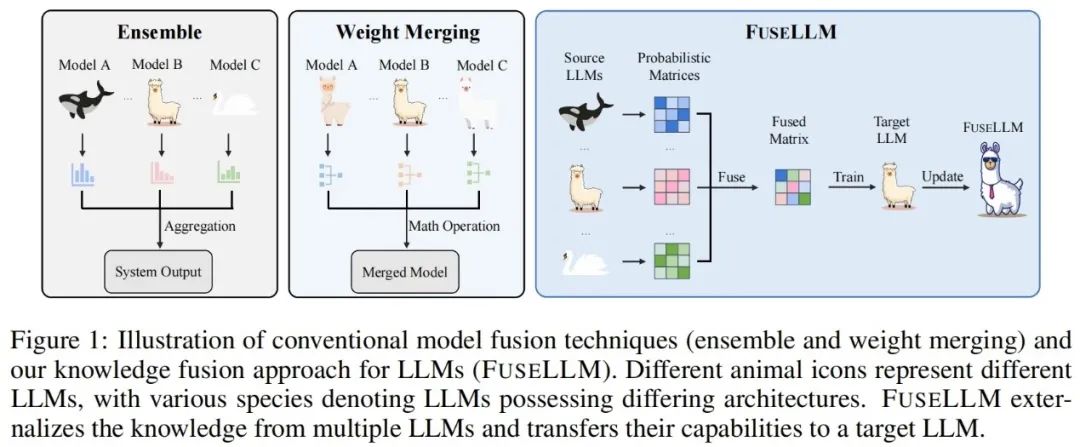

與傳統的模型整合和權重合併方法不同,FuseLLM提供了一種新的方式來融合多個異質大語言模型的知識。與同時部署多個大語言模型或要求合併模型結果不同,FuseLLM使用輕量級的持續訓練方法,將各個模型的知識和能力轉移到一個融合的大語言模型中。這種方法的獨特之處在於它能夠在推理時使用多個異質大語言模型,並將它們的知識外化到融合模型中。透過這種方式,FuseLLM有效地提高了模型的性能和效率。

該論文剛剛在 arXiv 上發布就引起了網友的大量關注和轉發。

有人覺得在另一種語言上訓練模型很有趣,我一直在思考這個問題。

目前論文已被 ICLR 2024 接受。

FuseLLM 的關鍵在於從機率分佈表徵的角度來探討大語言模型的融合,對於同樣的輸入文本,作者認為由不同大語言模型產生的表徵可以反映出它們在理解這些文本時的內在知識。因此,FuseLLM 首先利用多個源大語言模型產生表徵,將它們的集體知識和各自優勢外化,然後將生成的多個表徵取長補短進行融合,最後經過輕量級的持續訓練遷移到目標大語言模型。下圖展示了 FuseLLM 方法的概述。

考慮到多個異質大語言模型的tokenizer 以及詞表存在差異,在融合多個表徵時,如何對齊分詞結果是一大關鍵: FuseLLM 在token 層級的完全匹配之上,額外設計了基於最小編輯距離的詞表層級對齊,最大程度地保留了表徵中的可用資訊。

為了在結合多個大語言模型的集體知識的同時保持其各自的優勢,需要精心設計用於融合模型生成表徵的策略。具體而言,FuseLLM 透過計算生成表徵和標籤文本之間交叉熵來評估不同大語言模型對這條文本的理解程度,然後引入了兩種基於交叉熵的融合函數:

#在持續訓練階段,FuseLLM 使用融合後的表徵作為目標計算融合損失,同時也保留了語言模型損失。最終的損失函數為融合損失和語言模型損失之和。

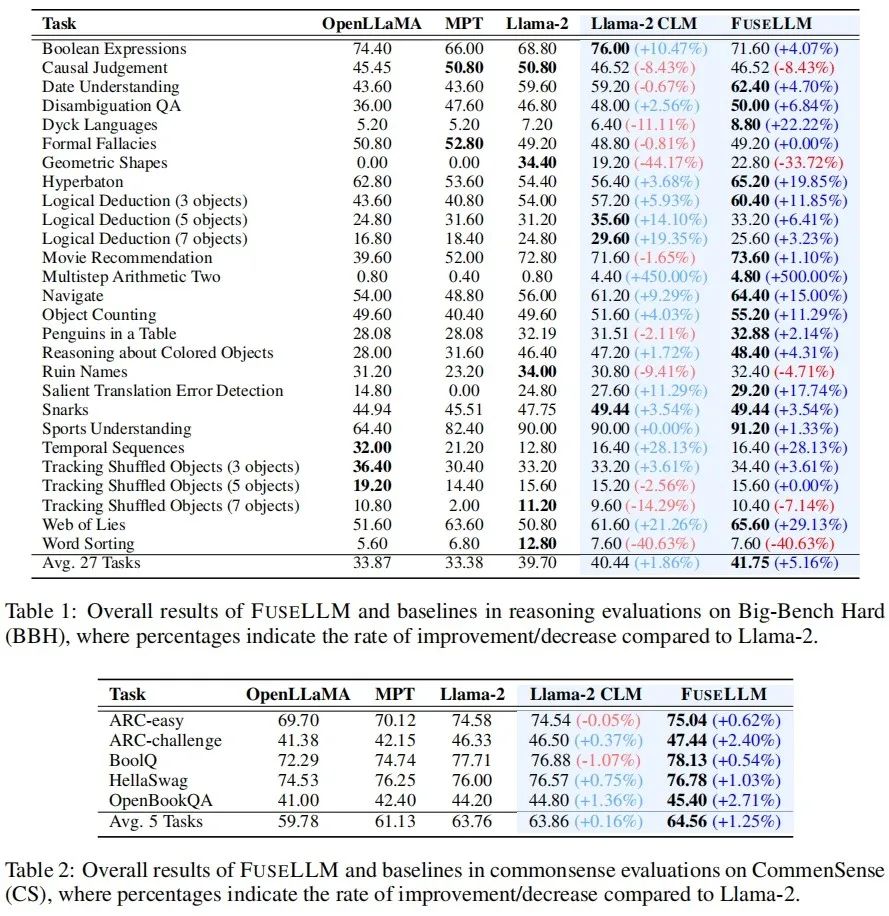

在實驗部分,作者考慮了一個通用但具有挑戰性的大語言模型融合場景,其中源模型在結構或能力上具備較小的共通性。具體來說,其在 7B 規模上進行了實驗,並選擇了三個代表性的開源模型:Llama-2、OpenLLaMA,和 MPT 作為待融合的大模型。

作者在通用推理、常识推理、代码生成、文本生成、指令跟随等场景评估了 FuseLLM,发现其相较于所有源模型和继续训练基线模型取得了显著的性能提升。

通用推理 & 常识推理

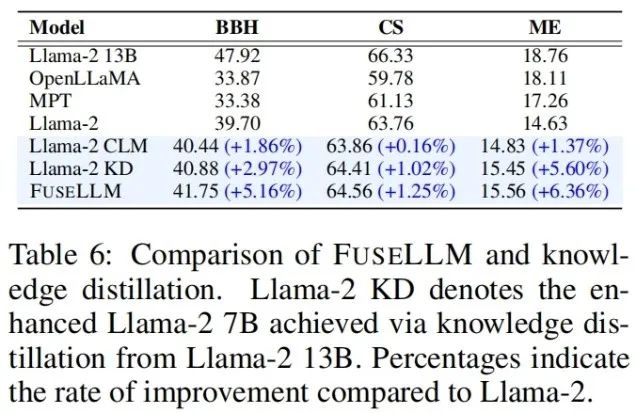

在测试通用推理能力的 Big-Bench Hard Benchmark 上,经过持续训练后的 Llama-2 CLM 相较于 Llama-2 在 27 个任务上取得了平均 1.86% 的提升,而 FuseLLM 则相较于 Llama-2 取得了 5.16% 的提升,显著优于 Llama-2 CLM,说明 FuseLLM 能结合多个大语言模型的优势取得性能提升。

在测试常识推理能力的 Common Sense Benchmark 上,FuseLLM 超过了所有的源模型和基线模型,在所有任务上都取得了最佳的性能。

代码生成 & 文本生成

在测试代码生成能力的 MultiPL-E Benchmark 上,FuseLLM 在 10 个任务中,有 9 个超过了 Llama-2,取得了平均 6.36% 的性能提升。而 FuseLLM 没有超过 MPT 和 OpenLLaMA 的原因可能是由于使用 Llama-2 作为目标大语言模型,其代码生成能力较弱,且持续训练语料中的代码数据比例较低,仅占约 7.59%。

在多个测量知识问答(TrivialQA)、阅读理解(DROP)、内容分析(LAMBADA)、机器翻译(IWSLT2017)和定理应用(SciBench)的文本生成 Benchmark 上,FuseLLM 也在所有任务中超过了所有源模型,并在 80% 的任务中超过了 Llama-2 CLM。

指令跟随

由于 FuseLLM 仅需提取多个源模型的表征进行融合,然后对目标模型持续训练,因此其也能适用于指令微调大语言模型的融合。在评估指令跟随能力的 Vicuna Benchmark 上,FuseLLM 同样取得了出色表现,超过了所有源模型和 CLM。

FuseLLM vs. 知识蒸馏 & 模型集成 & 权重合并

考虑到知识蒸馏也是一种利用表征提升大语言模型性能的方法,作者将 FuseLLM 和用 Llama-2 13B 蒸馏的 Llama-2 KD 进行了比较。结果表明,FuseLLM 通过融合三个具有不同架构的 7B 模型,超过了从单个 13B 模型蒸馏的效果。

为了将 FuseLLM 与现有融合方法进行比较(例如模型集成和权重合并),作者模拟了多个源模型来自相同结构的底座模型,但在不同的语料库上持续训练的场景,并测试了各种方法在不同测试基准上的困惑度。可以看到虽然所有的融合技术都可以结合多个源模型的优势,但 FuseLLM 能达到最低的平均困惑度,表明 FuseLLM 具备能比模型集成和权重合并方法更有效地结合源模型集体知识的潜力。

最后,尽管社区目前已经关注大模型的融合,但目前的做法大多基于权重合并,无法扩展到不同结构、不同规模的模型融合场景。虽然 FuseLLM 只是一项初步的异构模型融合研究,但考虑到目前技术社区存在大量不同的结构和规模的语言、视觉、音频和多模态大模型,未来这些异构模型的融合会迸发出怎样惊人地表现呢?让我们拭目以待!

以上是多個異構大模型的融合帶來驚人效果的詳細內容。更多資訊請關注PHP中文網其他相關文章!