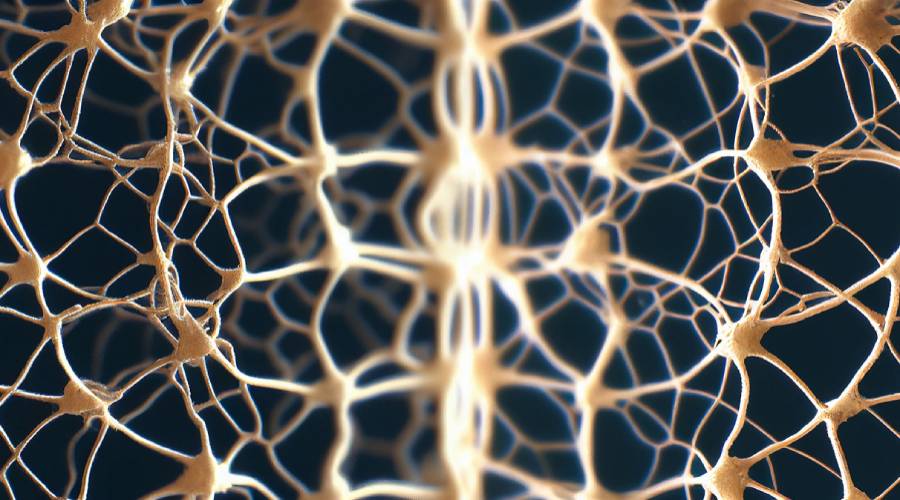

神經網路可解釋性(Explainable Artificial Intelligence, XAI)指的是解釋機器學習模型或人工智慧系統的決策能力。在實際應用中,我們需要了解模型為何做出某種決策,以便能夠理解並信任模型的輸出結果。傳統的機器學習模型,如決策樹和線性迴歸,具有良好的可解釋性。然而,深度學習模型,例如神經網絡,由於其複雜的結構和黑盒子特性,其決策過程往往難以解釋。這是因為神經網路透過學習大量資料來提取特徵和模式,而這些特徵和模式往往超出了我們的認知能力。因此,提高神經網路的可解釋性成為了一個非常重要的研究領域。目前,研究人員已經提出了許多方法來解釋神經網路的決策過程,例如特徵重要性分析、激活熱力學圖和對抗樣本生成等。這些方法可以幫助我們理解神經網路的決策過程,並提高對模型的信任度。

為了解決這個問題,研究者提出了一系列方法,包括視覺化、對抗性樣本、特徵重要性分析等,來解釋神經網路的決策過程。視覺化技術是一種常用的方法,它能以直觀的方式展示神經網路的關鍵節點和連接,有助於人們理解模型的決策過程。透過對輸入資料進行微小擾動的對抗性樣本方法,可以改變神經網路預測結果,從而揭示模型的弱點和漏洞。特徵重要性分析可以透過計算每個輸入特徵在模型中的貢獻來解釋神經網路的決策過程。這些方法的綜合使用可以提高對神經網路決策過程的理解,並幫助進一步優化和改進模型的效能。

神經網路的可解釋性對於實現可信任和可接受的人工智慧至關重要。它能幫助人們理解並信任機器學習模型的決策過程,以便更好地應用這些技術。

神經網路可解釋性的方法包括以下幾種:

視覺化方法:透過視覺化神經網路中的關鍵節點和連接,來展示模型的決策過程。例如,使用熱力學圖來表示神經網路中每個神經元的活躍程度,或使用網路拓撲圖來表示神經網路中的層級關係。

對抗性樣本方法是一種透過對輸入資料進行微小擾動的方式,來改變神經網路的預測結果,以揭示模型的弱點和漏洞。其中常用的方法是FGSM(Fast Gradient Sign Method),它可以產生對抗性樣本,使得神經網路的預測結果會改變。透過這種方式,研究人員可以發現模型在面對特定的擾動時的脆弱性,進而改進模型的穩健性。對抗性樣本方法在安全性領域和模型穩健性研究中具有重要的應用價值。

特徵重要性分析方法旨在解釋神經網路的決策過程,透過計算每個輸入特徵在模型中的貢獻。常見的方法是使用LIME(Local Interpretable Model-Agnostic Explanations),它可以計算每個輸入特徵對模型預測結果的影響。 LIME方法能夠產生局部可解釋的模型,從而幫助我們理解神經網路的決策過程。透過分析特徵的重要性,我們可以了解哪些特徵對模型的預測有關鍵作用,進而優化模型表現或提升模型的解釋能力。

設計可解釋性較強的模型,例如基於規則的模型或決策樹,可取代神經網路進行預測和解釋。

資料視覺化方法是一種透過視覺化訓練資料和測試資料的分佈、統計特徵等資訊來幫助人們理解神經網路決策過程的技術。其中,t-SNE方法可以將高維資料映射到二維平面上,以便直觀地展示資料的分佈。透過這種視覺化手段,人們可以更清楚地了解神經網路的工作原理和決策依據,從而提高對其的理解和信任。

神經網路解釋性方法正迅速發展,未來將出現更多技術,助於理解和應用。

神經網路的可解釋性是目前人工智慧領域的研究熱點之一,國內外都有很多研究者投入這個領域的研究。以下是神經網路可解釋性在國內外的現況:

國外:

深度學習可解釋性工作小組(Interpretability Working Group):由OpenAI、Google Brain等公司組成的深度學習可解釋性工作小組,旨在研究深度學習模型的可解釋性問題。

可解釋機器學習(Explainable Machine Learning):是一個由國際機器學習研究者組成的跨學科研究領域,旨在提高機器學習模型的可解釋性和可靠性。

LIME(Local Interpretable Model-Agnostic Explanations):是一種基於局部模型的可解釋性方法,可以解釋任何機器學習模型的決策過程。

國內:

中科院自動化研究所:該研究所的研究團隊在神經網路可解釋性方面進行了一系列研究,包括可解釋性深度學習、可解釋性強化學習等面向。

清華大學電腦科學與技術系:該系的研究團隊在神經網路可解釋性方面進行了一系列研究,包括可解釋性深度學習、可解釋性強化學習等面向。

北京郵電大學:該校的研究團隊在神經網路可解釋性方面進行了一系列研究,包括基於視覺化方法的可解釋性方法和基於對抗性樣本的可解釋性方法等方面。

以上是解釋神經網路的能力的詳細內容。更多資訊請關注PHP中文網其他相關文章!