為了避免人工智慧(AI)可能帶來的巨大風險,OpenAI決定授予董事會更大的權力來監管安全事務,並對上個月剛在內部爭鬥中獲勝的CEO Sam Altman進行嚴格的監督

OpenAI在美東時間12月18日週一發布了一系列指南,旨在追蹤、評估、預測和防範日益強大的人工智慧(AI)模型帶來的災難性風險。 OpenAI將"災難性風險"定義為可能導致數千億美元的經濟損失,或導致多人嚴重傷害或死亡的任何風險

這篇27頁的指引被稱為“準備框架”,其中提到,即使公司的高層管理人員,包括CEO或由領導層指定的人員認為即將發布的AI模型是安全的,公司董事會仍然有權選擇推遲該模型的發布。這意味著,儘管OpenAI的CEO負責日常工作的決策,但董事會將了解風險的發現,並有權否決CEO的決定

OpenAI的準備框架建議除了對公司領導層和董事會權限的規定外,還使用了矩陣方法來記錄多個類別的前沿AI模型所帶來的風險水平。這些風險包括行為不端者使用AI模型創建惡意軟體、發動社會工程攻擊,或傳播有害的核武或生物武器資訊

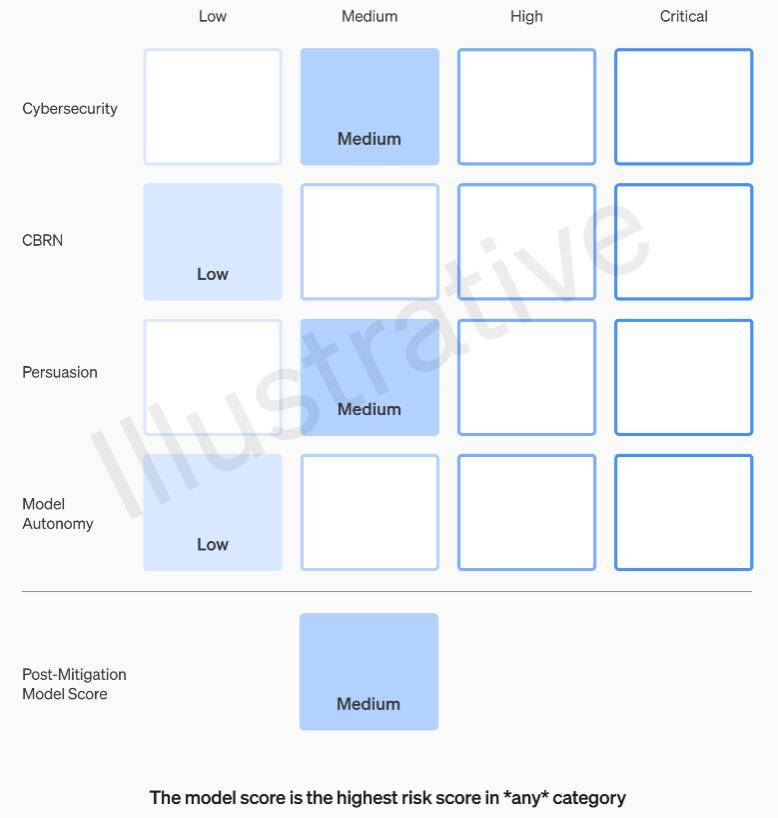

具體來說,OpenAI 在網路安全、CBRN(化學、生物、放射、核威脅)、說服和模型自主四個類別上設定了風險閾值。在實施風險緩解措施之前和之後,OpenAI 將每種風險分為低、中、高或嚴重四個等級

OpenAI規定,只有在風險緩解後評級為「中」或以下等級的AI模型才可以進行部署,只有在風險緩解後評級為「高」或以下的模型才能繼續進行開發,如果無法將風險降低到嚴重以下級別,公司將停止開發模型。對於在風險緩解前評定為高風險或嚴重風險的模型,OpenAI也將採取額外的安全措施

OpenAI將安全問題處理人員分為三個團隊。安全系統團隊專注於減輕和解決目前產品(如GPT-4)所帶來的風險。超對齊團隊則專注於未來系統超越人類能力可能帶來的問題。此外,還有一個名為準備的新團隊,由麻省理工學院(MIT)電機工程與電腦科學系(EECS)教授Aleksander Madry領導

新的團隊將對強大的模型開發和實施進行評估。他們將專門負責監督與安全決策相關的技術工作和操作架構。他們將推動技術工作,審查前沿模型能力的限制,並進行評估和綜合相關報告

Madry表示,他的團隊將定期評估OpenAI尚未發布的最先進的人工智慧模型的風險水平,並每月向OpenAI內部的安全顧問組織(SAG)提交報告。 SAG將分析Madry團隊的工作,並向CEO Altman和公司董事會提供建議

根據本週一公佈的指引文件顯示,Altman及其領導層可以根據這些報告來決定是否發布新的AI系統,但董事會保有推翻他們決定的權力

目前,Madry的團隊只有四個人,但他正在努力招募更多的成員。預計團隊成員將達到15到20人的規模,與現有的安全團隊和超對齊團隊的人數相當

Madry希望其他人工智慧公司能夠以類似的方式評估其模型的風險,並認為這可能成為監管的典範

以上是OpenAI指引允許董事會限制CEO發布新模型,以防範AI風險的詳細內容。更多資訊請關注PHP中文網其他相關文章!