研究者指出,CoDi-2標誌著在開發全面的多模態基礎模型領域取得了重大突破

今年5 月,北卡羅來納大學教堂山分校、微軟提出一個可組合擴散(Composable Diffusion,簡稱CoDi)模型,讓一個模型統一多種模態成為可能。 CoDi 不僅支援從單模態到單模態的生成,還能接收多個條件輸入以及多模態聯合生成。

最近,來自UC柏克萊、微軟Azure AI、Zoom、以及北卡羅萊納大學教堂山分校的多位研究者已將CoDi系統升級至CoDi-2版本

#重新寫內容,不改變原意,需要改寫成中文語言,不需要出現原句

根據Zineng Tang的論文,CoDi-2遵循複雜的多模態交錯上下文指令,以零樣本或少樣本交互的方式生成任何模態(文本、視覺和音頻)

此連結為圖片來源:https://twitter.com/ZinengTang/status/1730658941414371820

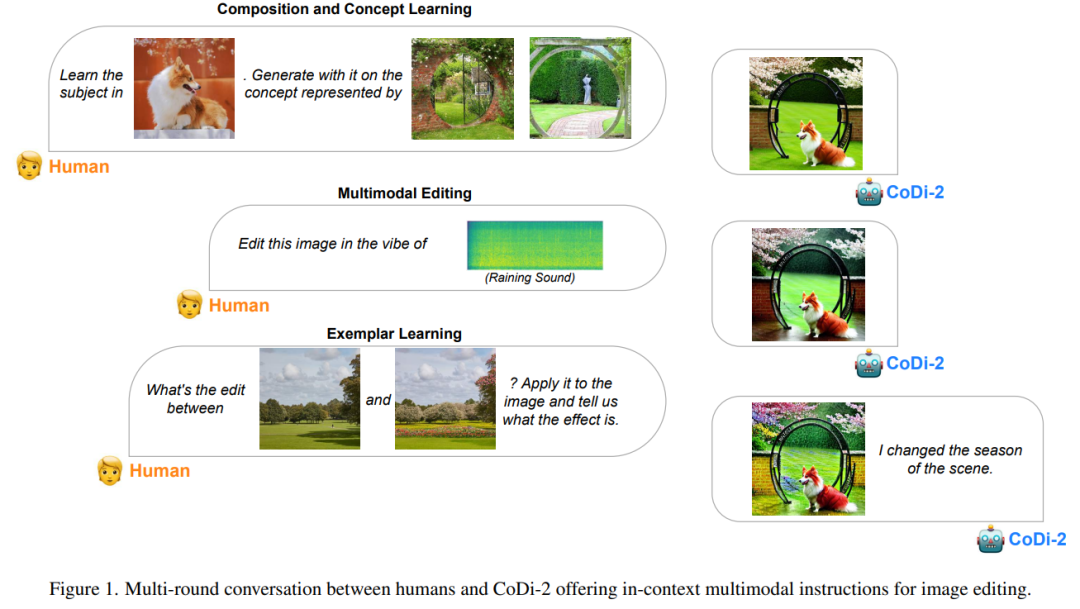

可以說,作為一個多功能、互動的多模態大語言模型(MLLM),CoDi-2 能夠以any-to-any 輸入-輸出模態範式進行上下文學習、推理、聊天、編輯等任務。透過對齊編碼與生成時的模態與語言,CoDi-2 使LLM 不僅可以理解複雜的模態交錯指令和上下文範例, 還能在連續的特徵空間內自回歸地產生合理和連貫的多模態輸出。

而為了訓練 CoDi-2,研究者建構了一個大規模生成資料集,包含了跨文字、視覺和音訊的上下文多模態指令。 CoDi-2 展示了一系列多模態生成的零樣本能力,例如上下文學習、推理以及透過多輪互動對話實現的 any-to-any 模態生成組合。其中在主題驅動影像生成、視覺轉換和音訊編輯等任務上超越了以往領域特定的模型。

人類與 CoDi-2 的多輪對話為影像編輯提供了上下文多模態指令。

需要重新書寫的內容是:模型架構

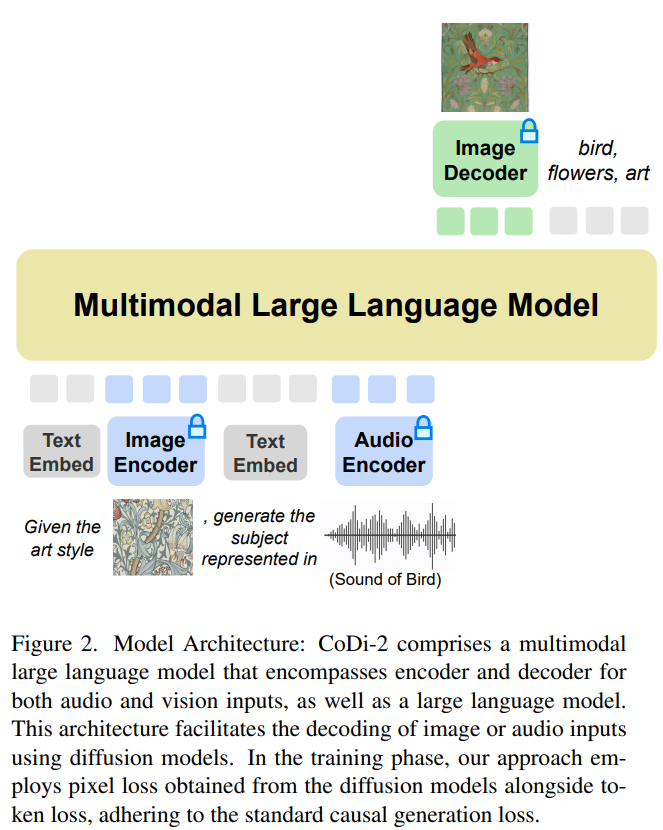

#CoDi-2 在設計時旨在處理上下文中的文字、圖像和音頻等多模態輸入,利用特定指令促進上下文學習並產生對應的文字、影像和音訊輸出。 CoDi-2 需要重新書寫的內容是:模型架構圖如下。

以多模態大語言模型作為基礎引擎

這種any-to-any 基礎模型可以消化交錯式模態輸入,理解和推理複雜指令(如多輪對話、上下文範例),並與多模態擴散器交互,實現這一切的前提是需要一個強大的基礎引擎。研究者提出將 MLLM 作為這個引擎,它的建構需要為僅文本的 LLM 提供多模態感知。

利用對齊的多模態編碼器映射,研究者可以無縫地使 LLM 感知到模態交錯的輸入序列。具體地,在處理多模態輸入序列時,他們首先使用多模態編碼器將多模態資料映射到特徵序列,然後特殊token 被添加到特徵序列的前後,例如「〈audio〉 [audio feature sequence ] 〈/audio〉」。

多模態產生的基礎是MLLM

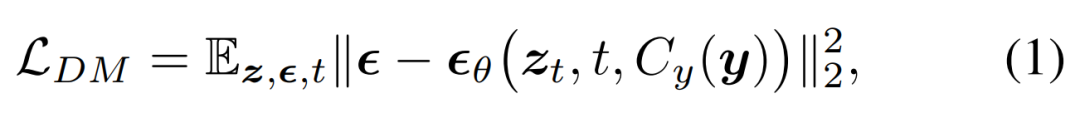

研究者提出將擴散模型(DM)整合到MLLM中,以產生多模態輸出。在此過程中,遵循了詳盡的多模態交錯指令和提示。擴散模型的訓練目標如下所示:

接著他們提出訓練 MLLM 以產生條件式特徵 c = C_y (y),該特徵被饋入到擴散模型中以合成目標輸出 x。這樣一來,擴散模型的生成損失被用來訓練 MLLM。

任務類型

該模型在以下範例任務類型中展現出強大的能力,它提供了一種獨特的方法,可以促使模型產生或轉換上下文中的多模態內容,包括文字、圖像、音訊、視訊及其組合

#重寫後的內容為:1. 零樣本推理。零樣本推理任務要求模型在沒有任何先前範例的情況下進行推理並產生新的內容

2. 一次/少量樣本提示。一次或少量樣本提示為模型提供了一個或幾個範例,以便在執行類似任務之前從中學習。這種方法在以下任務中很明顯:模型將學習到的概念從一個圖像應用到另一個圖像,或透過理解所提供範例中描述的風格來創建一個新的藝術品。

實驗及結果

#模型設定

#本文模型的實作是基於Llama2,特別是Llama-2-7b- chat-hf。研究者使用 ImageBind ,它具有對齊的圖像、視訊、音訊、文字、深度、thermal 和 IMU 模式編碼器。研究者使用 ImageBind 對影像和音訊特徵進行編碼,並透過多層感知器(MLP)將其投射到 LLM(Llama-2-7b-chat-hf)的輸入維度。 MLP 由線性映射、活化、歸一化和另一個線性映射組成。當 LLM 產生影像或音訊特徵時,他們會透過另一個 MLP 將其投射回 ImageBind 特徵維度。本文影像擴散模型基於 StableDiffusion2.1 (stabilityai/stable-diffusion-2-1-unclip)、AudioLDM2 和 zeroscope v2。

研究人員為了獲得更高保真度的原始輸入圖像或音頻,將它們輸入到擴散模型中,並透過連接擴散噪聲來產生特徵。這種方法非常有效,它可以最大程度地保留輸入內容的感知特徵,並能夠添加新內容或改變風格等指令編輯

需要進行重寫的內容是:圖像生成評估

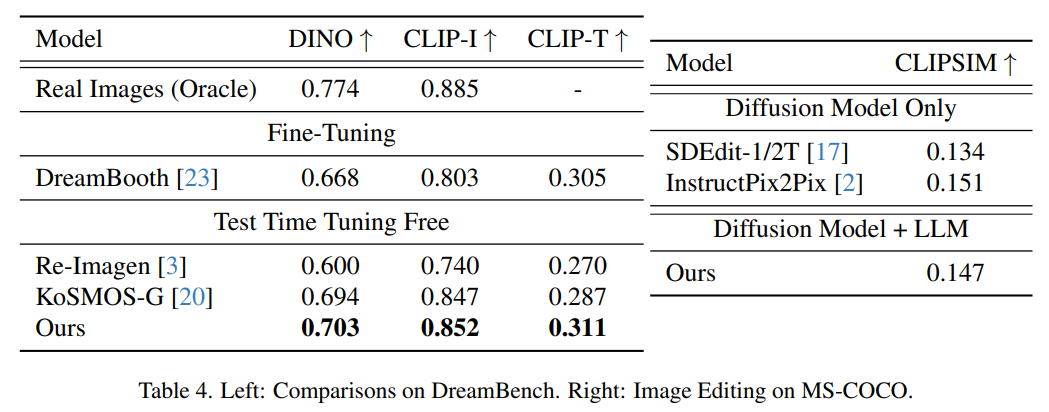

下圖展示了Dreambench 上主題驅動影像產生的評估結果和MSCOCO 上的FID 分數。本文方法實現了極具競爭力的零樣本性能,顯示了其對未知新任務的泛化能力。

音訊產生評估

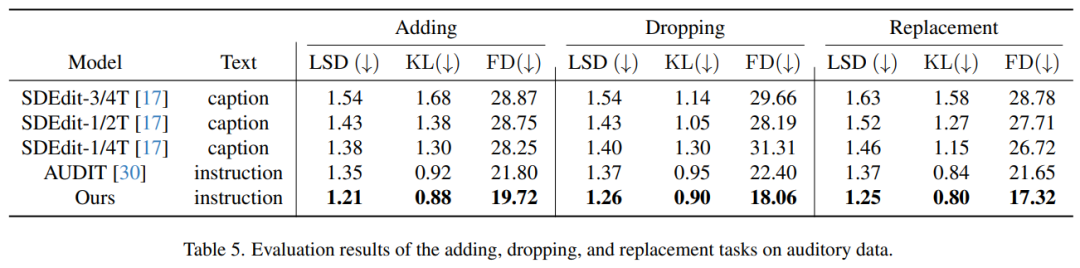

表5 展示了音訊處理任務的評估結果,即在新增、刪除和取代音軌中的元素。從表中可以明顯看出,與先前的方法相比,本文方法表現出了卓越的性能。值得注意的是,在所有三個編輯任務中,它在所有指標——對數譜距離(LSD)、Kullback-Leibler(KL)發散和Fréchet Distance(FD)上都取得了最低得分

閱讀原文,了解更多技術細節。

以上是任意文字、視覺、音訊混合生成,多模態有了強大的基礎引擎CoDi-2的詳細內容。更多資訊請關注PHP中文網其他相關文章!