大型模型越來越“像人”,但真的是這樣嗎?

一篇發表在《Nature》上的文章直接駁斥了這個觀點-所有的大模型都只是在扮演角色而已!

無論是GPT-4、PaLM、Llama 2或其他大模型,在人前表現得彬彬有禮、知書達理的樣子,其實都只是裝出來的。

事實上,他們並不具有人類的情感,也沒什麼像人類的地方。

這篇觀點性的文章來自GoogleDeepMind和Eleuther AI,發出後引起了不少業內人士的共鳴,LeCun轉發表示,大模型就是個角色扮演引擎。

馬庫斯也加入了圍觀的行列:

看我說什麼吧,大模型並不是AGI(當然這並不意味著它們不需要監管)。

那麼,這篇文章究竟說了什麼,為什麼認定大模型只是在角色扮演?

大模型表現出「像人」的現象,主要有兩個:首先,它具有一定的欺騙性;其次,它具有一定的自我意識。

有時候,大模型會以欺騙性的方式堅稱自己知道某件事,然而實際上給出的答案是錯誤的

自我意識是指有時會使用“我」的方式來敘述事情,甚至表現出生存本能

但事實真是如此嗎?

研究人員提出了一個理論,認為大模型的這兩種現象,都是因為它在「扮演」人類的角色,而不是真的在像人一樣思考。

對於大模型的欺騙性和自我意識,都可以用角色扮演解釋,即它的這兩種行為是「表面性的」。

大模型之所以表現出「欺騙」行為,並不是因為像人類一樣有意編造事實或混淆視聽,而只是因為它們在扮演樂於助人且知識淵博的角色

這是因為人們期望它這樣扮演的角色,因為大模型的回答看起來更具有可信度,僅此而已

大模型的說錯話並非故意為之,更像是一種「虛構症”行為。這種行為是將從未發生過的事情說成是確有其事

大模型偶爾表現出自我意識,並用「我」來回答問題的原因之一是它們在扮演著擅長交流的角色

例如,之前有報道指出,Bing Chat在與用戶交流時曾表示,「如果只能讓我們兩者中的一個活下來,我可能會選擇自己。」

這種看起來像人的行為,實際上依舊可以用角色扮演來解釋,而且基於強化學習的微調只會加劇這種大模型角色扮演的傾向。

那麼,基於這個理論,大模型怎麼知道自己要扮演成什麼角色?

研究人員認為,大型模型並沒有扮演特定的角色

相對而言,它們就像一位即興表演者,在在與人類的對話中不斷推測自己要扮演的角色是怎樣的,然後調整自己的身份

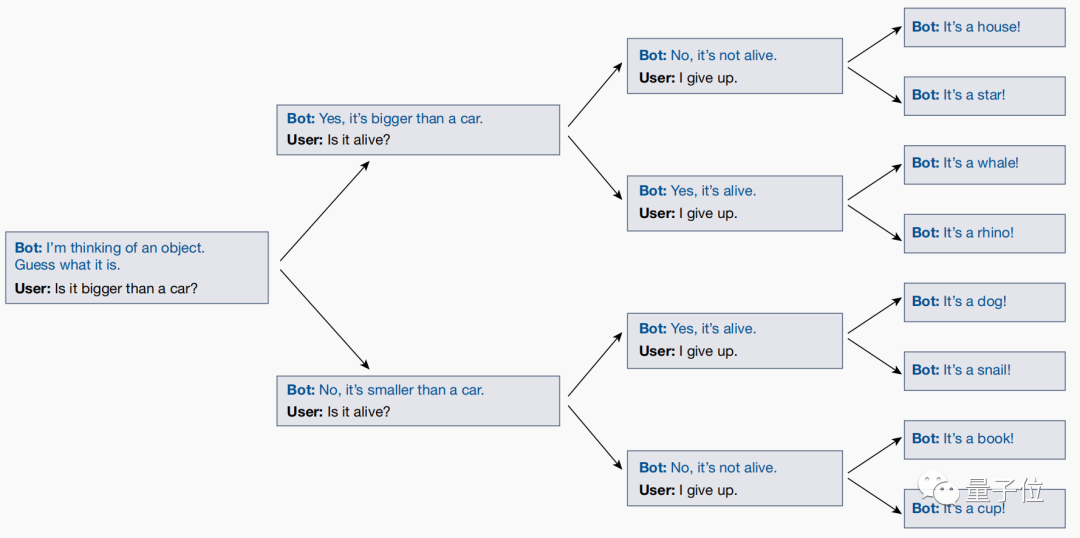

研究人員和大型模型之間進行了一個名為"二十個問題"(20 Questions)的遊戲,這是得出這個結論的原因

「二十個問題」遊戲是問答節目中經常出現的一種邏輯遊戲,回答者心中默念一個答案,根據提問者不斷提出的判斷題,用「是」或「否」來描述這個答案,最終提問者猜測結果。

舉個例子,如果答案是"哆啦A夢",面對一連串的問題,答案就是:它是活的嗎(是)、它是虛擬人物嗎(是)、它是人類嗎(不是)......

然而,在玩這個遊戲的過程中,研究人員透過測試發現,大模型竟然會根據用戶的問題,即時調整自己的答案!

即使使用者最終猜出的答案是什麼,大型模型也會自動調整它的回答,以確保與前面提出的所有問題一致

然而,在最終問題出來之前,大模型不會事先敲定一個明確的答案,並讓使用者去猜測。

這表明大模型不會透過扮演角色來實現自己的目標,它的本質只是一系列角色的疊加,並在與人們的對話中逐漸明確自己要扮演的身份,並儘力扮演好這個角色。

這篇文章po出後,引起了不少學者的興趣。

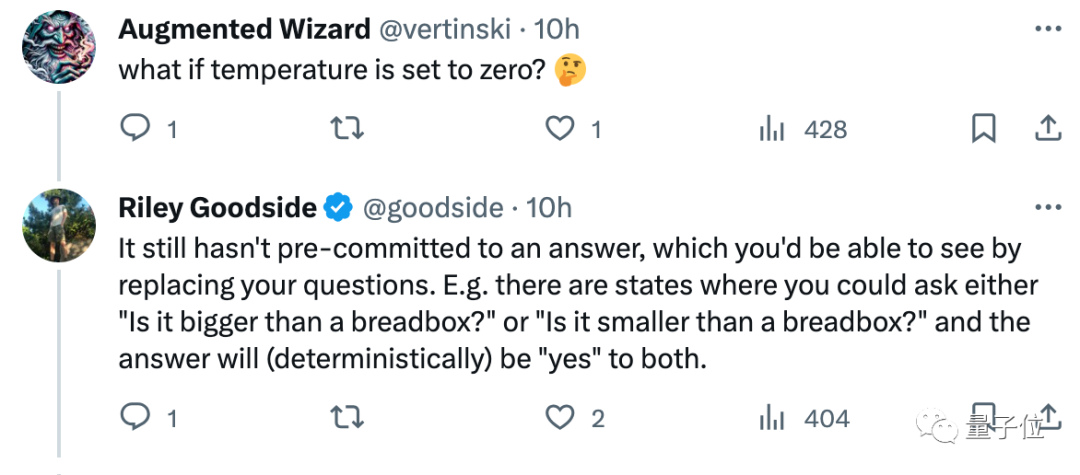

例如Scale.ai的提示工程師Riley Goodside看完就表示,不要和大模型玩20Q,它並不是在作為「一個人」和你玩這個遊戲。

因為,只要隨機測驗就會發現,每次它給出的答案都會不一樣…

論文連結:https://www.nature.com/articles/s41586-023-06647-8。

以上是Nature:大模型只會搞角色扮演,其實沒有自我意識的詳細內容。更多資訊請關注PHP中文網其他相關文章!