前段時間,開源大模型領域迎來了一個新的模型 —— 上下文視窗大小突破 200k,能一次處理 40 萬漢字的「Yi」。

創新工場董事長兼CEO 李開復創立了大模型公司「零一萬物」,並且建構了這個大模型,其中包括了Yi-6B 和Yi-34B 兩個版本

根據Hugging Face 英文開源社群平台和C-Eval 中文評測榜單,Yi-34B 推出時取得了多項SOTA 國際最佳性能指標認可,成為全球開源大模型「雙料冠軍」,擊敗了LLaMA2 和Falcon 等開源競品。

Yi-34B 也成為當時唯一成功登頂Hugging Face 全球開源模型排行榜的國產模型,稱「全球最強開源模型」。

發布後,這個模型吸引了許多國內外的研究人員和開發者的關注

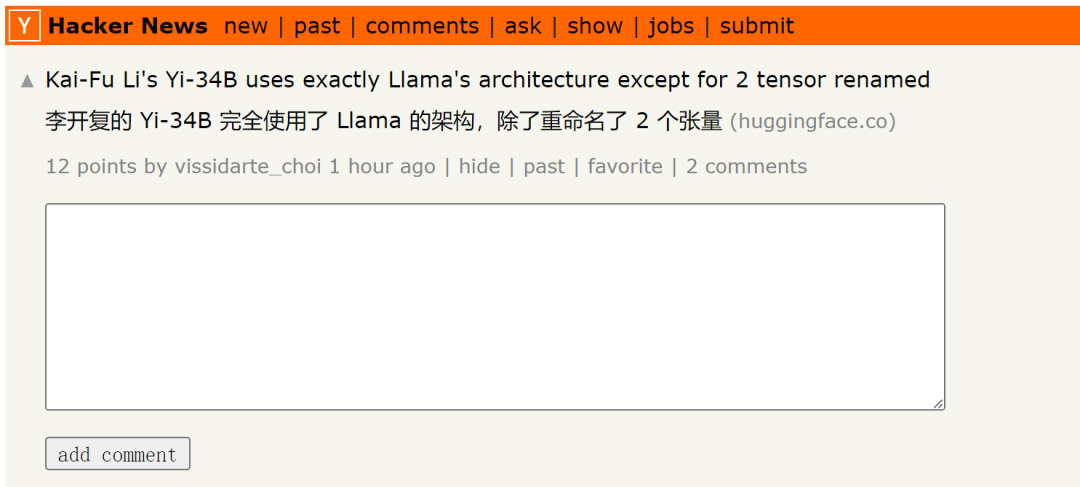

但最近,有研究者發現, Yi-34B 模型基本上採用了LLaMA 的架構,只是重新命名了兩個張量。

請點選此連結查看原貼:https://news.ycombinator.com/item?id=38258015

#貼文中也提到:

Yi-34B 的程式碼其實是LLaMA 程式碼的一次重構,但看似並未做出任何實質改變。這個模型明顯是基於原始Apache 2.0 版的LLaMA 檔案進行的編輯,但卻未提及LLaMA:

Yi vs LLaMA代碼對比。程式碼連結:https://www.diffchecker.com/bJTqkvmQ/

此外,這些程式碼變更並沒有透過Pull Request 的方式提交到transformers 專案中,而是以外部程式碼的形式附加上去,這可能存在安全風險或不被框架所支援。 HuggingFace 排行榜甚至不會對這個上下文視窗最高可達 200K 的模型進行基準測試,因為它沒有自訂程式碼策略。

他們聲稱這是32K 模型,但它被配置為4K 模型,沒有RoPE 伸縮配置,也沒有解釋如何伸縮(註:零一萬物之前表示模型本身在4K 的序列上進行訓練,但是在推理階段可以擴展到32K)。目前,關於其微調數據的資訊為零。他們也沒有提供復現他們的基準測試的說明,包括可疑的 MMLU 高分。

任何在人工智慧領域工作過一段時間的人都不會對此視而不見。這是虛假宣傳嗎?違反許可證規定嗎?實際上是作弊了基準測試嗎?誰在乎呢?我們可以換一篇論文,或者在這種情況下,拿走所有創投的錢。至少Yi在標準之上,因為它是一個基礎模型,而且性能確實不錯

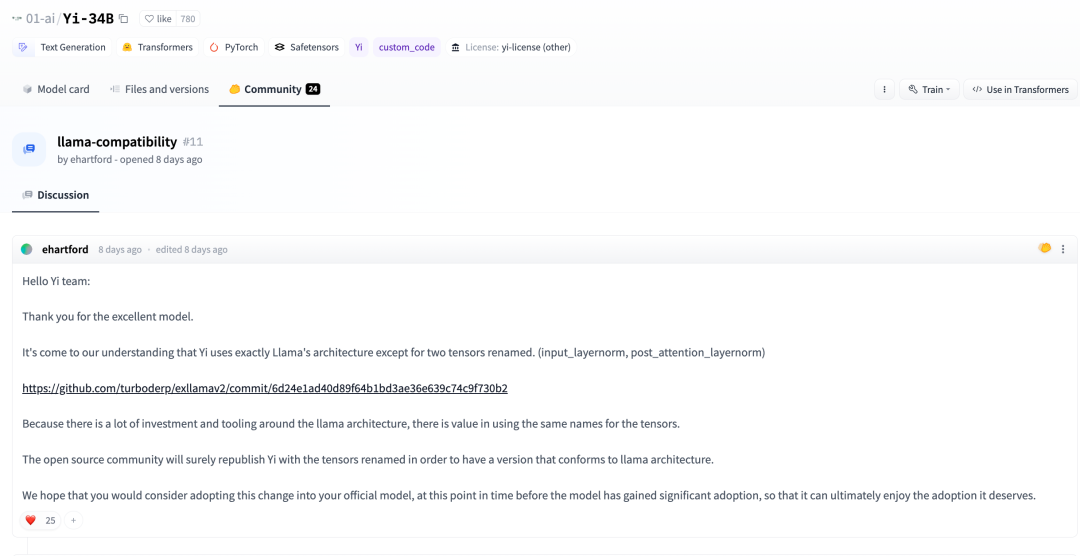

在數天前,在Huggingface 社區中,有開發者也指出:

根據我們的了解,除了重新命名兩個張量之外,Yi 完全採用了LLaMA 的架構。 (input_layernorm, post_attention_layernorm)

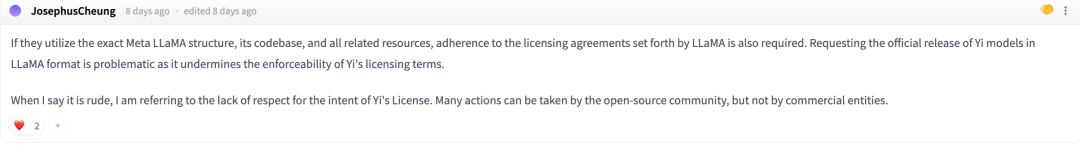

在討論中,一些網友表示:如果他們要確切地使用Meta LLaMA的架構、程式碼庫和其他相關資源,就必須遵守LLaMA規定的授權協議

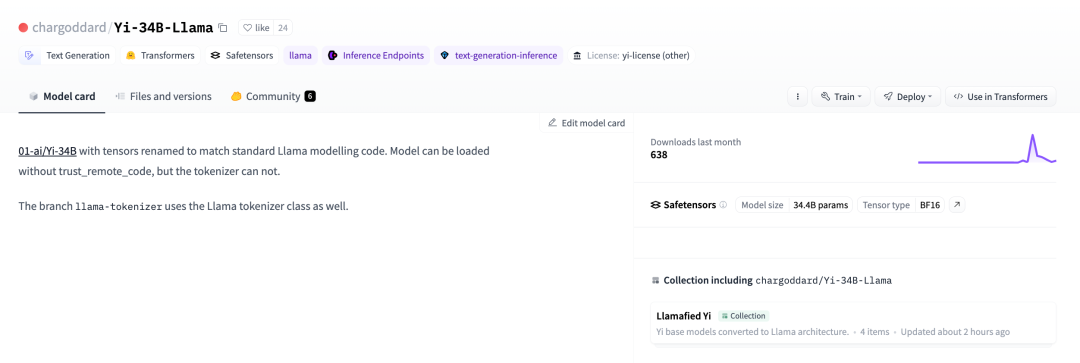

為了遵守LLaMA 的開源協議,一位開發者決定將自己的名字改回,並重新發布到huggingface 上

01-ai/Yi-34B,張量已重新命名以符合標準LLaMA 模型代碼。相關連結:https://huggingface.co/chargoddard/Yi-34B-LLaMA

01-ai/Yi-34B,張量已重新命名以符合標準LLaMA 模型代碼。相關連結:https://huggingface.co/chargoddard/Yi-34B-LLaMA

透過閱讀這段內容,我們可以推論出賈揚清離開阿里並開始創業的消息是前幾天在他的朋友圈中提到的

對於這件事,機器之心也向零一萬物進行了求證。零一萬物回應說:

GPT 是一個業界公認的成熟架構,LLaMA 在 GPT 上做了總結。零一萬物研發大模型的結構設計基於GPT 成熟結構,借鑒了行業頂尖水平的公開成果,同時基於零一萬物團隊對模型和訓練的理解做了大量工作,這是我們首次發布獲得優秀結果的地基之一。同時,零一萬物也持續探索模型結構層面本質上的突破。

模型結構僅是模型訓練其中一部分。 Yi 開源模型在其他方面的精力,例如資料工程、訓練方法、baby sitting(訓練過程監測)的技巧、hyperparameter 設定、評估方法以及對評估指標的本質理解深度、對模型泛化能力的原理的研究深度、業界頂尖的AI Infra 能力等,投入了大量研發打底工作,這些工作往往比起基本結構能起到更大的作用跟價值,這些也是零一萬物在大模型預訓練階段的核心技術護城河。

在進行大量的訓練實驗過程中,我們根據實驗執行的需求對程式碼進行了改名。我們非常重視開源社群的回饋,並對程式碼進行了更新,以更好地融入Transformer生態系統

我們非常感謝社群的回饋,我們在開源社群剛剛起步,希望和大家攜手共創社區繁榮,易開源將會盡力持續進步

以上是基於LLaMA卻改張量名,李開復公司大模型引爭議,官方回應來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!