LoRAShear是微軟為優化語言模型模型(llm)和保存知識而開發的一種新方法。它可以進行結構性修剪,減少計算需求並提高效率。

LHSPG技術(Lora Half-Space Projected Gradient)支援漸進式結構化剪枝和動態知識復原。可以透過依賴圖分析和稀疏度最佳化應用於各種LLM

LoRAPrune將LoRA與迭代結構化修剪結合,以實現參數的高效微調。即使在LLAMA v1上進行了大量修剪,其性能仍能保持相當水平

#在不斷發展的人工智慧領域,語言模型模型( llm)已成為處理大量文字資料、快速檢索相關資訊和增強知識可存取性的關鍵工具。它們的深遠影響跨越了各個領域,從增強搜尋引擎和問答系統到啟用數據分析,研究人員、專業人員和知識尋求者都從中獲益。

目前最大的問題是,LLM需要不斷更新知識以滿足資訊的動態性要求。一般情況下,開發人員會使用特定領域的資料對預訓練模型進行微調,以保持其最新狀態,並向模型灌輸最新的見解。定期更新對於組織和研究人員來說是至關重要的,以確保LLM與不斷變化的資訊景觀保持同步。然而,微調的成本很高且週期長

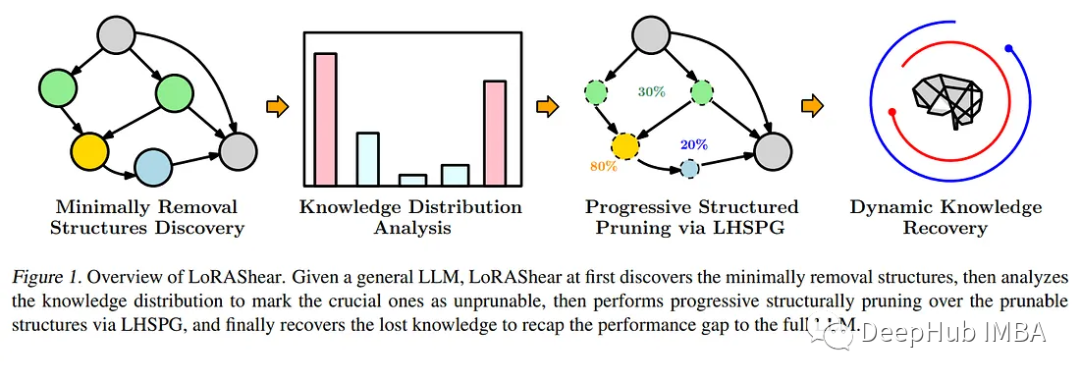

為了應對這一迫切需要,微軟的研究人員推出了一種開創性的方法——LoRAShear。這種創新的方法不僅簡化了llm,而且促進了結構知識的恢復。結構修剪的核心是去除或減少神經網路架構中的特定元件,優化效率、緊湊性和運算需求。

微軟的LoRAShear使用了LHSPG技術,以支援漸進式結構化修剪。這種方法可以在LoRA模組之間無縫傳遞知識,並且還整合了動態知識恢復階段。微調過程類似於預訓練和指導微調,以確保LLM保持更新和相關性

#重新寫成:利用依賴圖分析,LoRAShear可以擴展到一般的llm,尤其是在LoRA模組的支援範圍內。該方法使用原始LLM和LoRA模組創建依賴關係圖,並引入了一種結構化稀疏性優化演算法,該演算法利用LoRA模組的資訊來增強權重更新過程中的知識保存

在論文中,也提到了一種稱為LoRAPrune的整合技術,它將LoRA與迭代結構化修剪相結合,以實現參數的高效微調和直接硬體加速。這種節省記憶體的方法完全依賴LoRA的權重和梯度來進行修剪標準。具體的過程包括建立一個追蹤圖,確定需要壓縮的節點組,劃分可訓練的變量,並最終將它們返回給LLM

論文通過在開源LLAMAv1上的實現,證明了LoRAShear的有效性。值得注意的是,修剪了20%的LLAMAv1只有1%的性能損失,而修剪了50%的模型在評估基準上保留了82%的性能。

LoRAShear代表了人工智慧領域的重大進步。它不僅簡化了LLM的使用方式,使其更有效率,而且確保了關鍵知識的保存。它可以使人工智慧驅動的應用程式能夠在優化運算資源的同時,與不斷發展的資訊環境保持同步。隨著組織越來越依賴人工智慧進行資料處理和知識檢索,像LoRAShear這樣的解決方案將在市場上發揮關鍵作用,提供效率和知識彈性。

論文網址:https://arxiv.org/abs/2310.18356

以上是微軟最新研究探索LLM修剪和知識復原的LoRAShear技術的詳細內容。更多資訊請關注PHP中文網其他相關文章!