本文對按比例擴大的NFNets 進行了評估,並挑戰了ConvNets 在大規模問題上表現不如ViTs 的觀點

深度學習的早期成功可歸功於卷積神經網路(ConvNets)的發展。近十年來,ConvNets 主導了電腦視覺基準測試。然而近年來,它們越來越多地被 ViTs(Vision Transformers)所取代。

很多人認為,ConvNets 在小型或中等規模的資料集上表現良好,但在那種比較大的網路規模的資料集上卻無法與 ViTs 競爭。

同時,CV 社群已經從評估在特定資料集(如 ImageNet)上隨機初始化網路的效能,轉變為評估從網路收集的大型通用資料集上預訓練的網路的效能。這引出了一個重要的問題:在相似的運算預算下,Vision Transformers 是否優於預先訓練的 ConvNets 架構?

在這篇文章中,來自Google DeepMind的研究人員對這個問題進行了研究。他們透過在不同尺度的JFT-4B資料集上對多種NFNet模型進行預先訓練,獲得了類似於ViTs在ImageNet上的性能

##然而,有網友對LeCun的評論表示,他認為在多模態模型中使用ViT可能仍然使其在研究中具有優勢

##然而,有網友對LeCun的評論表示,他認為在多模態模型中使用ViT可能仍然使其在研究中具有優勢來自Google DeepMind 的研究員表示,ConvNets 永遠不會消失

接下來我們來看看論文具體內容。

接下來我們來看看論文具體內容。 本文在 JFT-4B 上訓練了一系列不同深度和寬度的 NFNet 模型。

根據圖2所示,驗證損失與訓練模型的計算預算呈線性關係,與使用Transformer進行語言建模時觀察到的雙對數(log-log)擴展定律相符。隨著計算預算的增加,最佳模型大小和最佳epoch預算(實現最低驗證損失)也會增加

在下面的圖表中,我們可以看到三個模型在一系列的epoch 預算中觀察到的最佳學習率(即最大程度地減少驗證損失)。研究人員發現,對於較低的 epoch 預算,NFNet 系列模型都顯示出類似的最佳學習率,約為1.6。然而,隨著 epoch 預算的增加,最優學習率會下降,對於更大的模型,最優學習率下降得更快。研究人員表示,可以假設最佳學習率會隨著模型大小和 epoch 預算的增加而緩慢且單調地下降,因此在兩次試驗中可以有效地調整學習率

在下面的圖表中,我們可以看到三個模型在一系列的epoch 預算中觀察到的最佳學習率(即最大程度地減少驗證損失)。研究人員發現,對於較低的 epoch 預算,NFNet 系列模型都顯示出類似的最佳學習率,約為1.6。然而,隨著 epoch 預算的增加,最優學習率會下降,對於更大的模型,最優學習率下降得更快。研究人員表示,可以假設最佳學習率會隨著模型大小和 epoch 預算的增加而緩慢且單調地下降,因此在兩次試驗中可以有效地調整學習率

需要重新寫的內容是:需要注意的是,圖表2中一些預訓練模型的表現不如預期。研究團隊認為,出現這種情況的原因是如果訓練運行被搶佔/重新啟動,資料加載流程無法保證每個訓練樣本在每個週期都能被採樣一次。如果訓練運行多次重新啟動,則可能導致某些訓練樣本的採樣次數不足

NFNet vs ViT

在ImageNet上進行的實驗顯示,經過微調的NFNet和Vision Transformer的性能相當

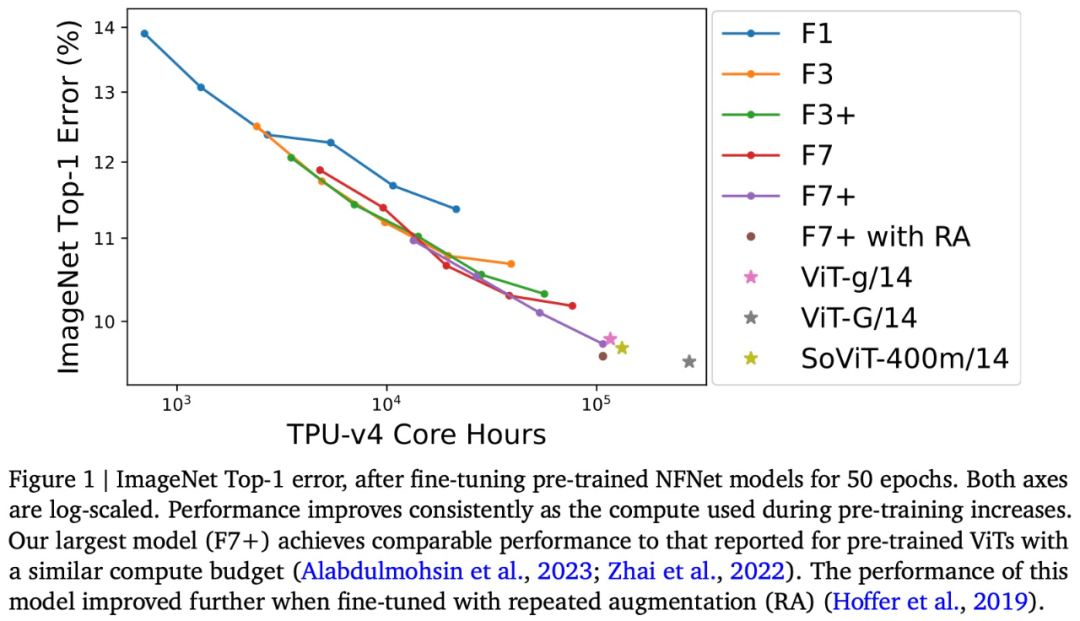

具體來說,該研究在ImageNet 上微調了預訓練NFNet,並繪製了預訓練計算與Top-1 error 關係圖,如上述圖1 所示。

隨著預算的增加,ImageNet Top-1準確度持續提高。其中最昂貴的預訓練模型是預訓練8個epoch的NFNet-F7 ,在ImageNet Top-1準確率達到了90.3%。預訓練和微調需要大約110k TPU-v4核小時和1.6k TPU-v4核小時。此外,如果在微調期間引入額外的重複增強技術,可以實現90.4%的Top-1準確率。 NFNet在大規模預訓練中獲得了很大的好處

儘管NFNet和ViT兩種模型架構之間有明顯的差異,但預先訓練的NFNet和預訓練的ViT在性能上是相當的。例如,在對JFT-3B進行210k TPU-v3核小時的預訓練後,ViT-g/14在ImageNet上實現了90.2%的Top-1準確率;而在對JFT-3B進行超過500k TPU-v3在核小時的預訓練後,ViT-G/14實現了90.45%的Top-1準確率

本文評估了這些模型在TPU-v4 上的預訓練速度,並估計ViT-g/14需要120k TPU-v4 核小時來預訓練,而ViTG/14 則需要280k TPU-v4 核小時數,SoViT-400m/14 將需要130k TPU-v4 核小時數。本文使用這些估計值來比較圖 1 中 ViT 和 NFNet 的預訓練效率。研究注意到,NFNet 針對 TPU-v4 進行了最佳化,在其他設備上評估時表現較差。

最終,本文注意到,在JFT-4B上,預訓練的檢查點實現了最低的驗證損失,但在微調後,並不總是能在ImageNet上實現最高的Top-1準確率。特別是,本文發現,在固定的預訓練計算預算下,微調機制傾向於選擇稍大的模型和稍小的epoch預算。直觀上來說,更大的模型具有更大的容量,因此能夠更好地適應新的任務。在某些情況下,稍大的學習率(在預訓練期間)在微調後也能獲得更好的表現

以上是DeepMind:誰說卷積網不如ViT?的詳細內容。更多資訊請關注PHP中文網其他相關文章!