重寫內容為:機器之心報道

編輯:杜偉、小舟

GPT-4 與機器人又擦出了新的火花。

在機器人領域,實現通用機器人策略需要大量數據,而在真實世界收集這些數據又耗時費力。儘管模擬為產生場景層級和實例層級的不同體量的資料提供了一種經濟的解決方案,但由於需要大量的人力(尤其是對複雜任務),在模擬環境中增加任務多樣性仍面臨挑戰。這就導致典型的人工模擬基準通常只能包含數十到數百個任務。

如何解決呢?近年來,大語言模型在自然語言處理及各類任務的程式碼產生方面不斷取得重大進展。同樣,LLM 已經應用於機器人的多個方面,包括使用者介面、任務和運動規劃、機器人日誌總結、成本和獎勵設計,揭示了在物理基礎和程式碼生成任務上的強大能力。

在近日的一項研究中,來自 MIT CSAIL、上海交通大學等機構的研究者進一步探究 LLM 是否可以用來創建多樣化的模擬任務,並進一步挖掘它們的能力。

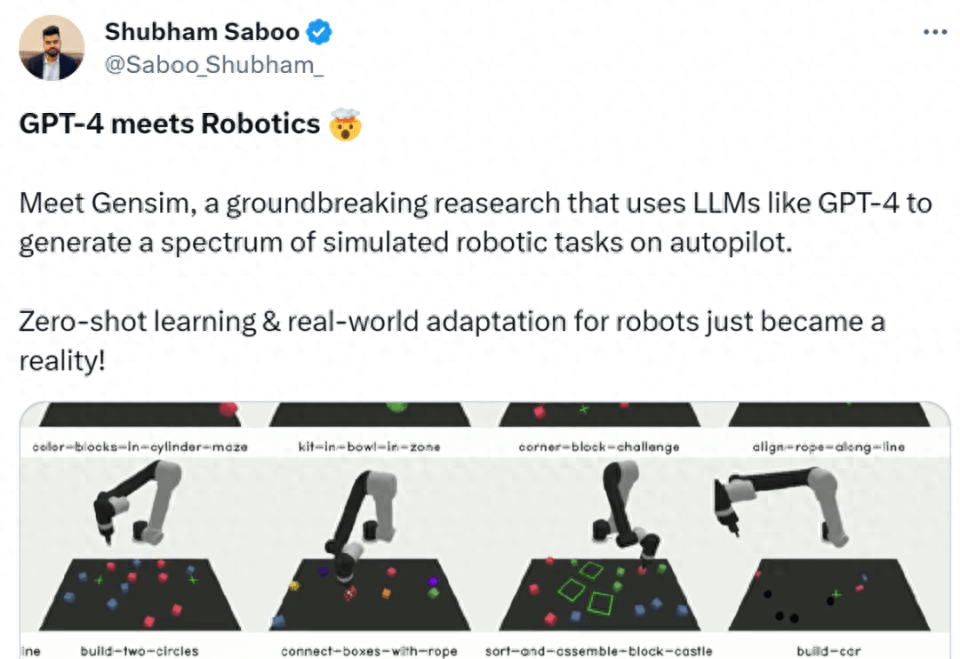

具體來講,研究者提出了一個基於 LLM 的框架 GenSim,它為設計和驗證任務資產安排、任務進展提供了一種自動化機制。更重要的是,生成的任務表現出了極大的多樣性,促進了機器人策略的任務級泛化。此外從概念上講,利用 GenSim,LLM 的推理和編碼能力透過中間合成的模擬資料被提煉成了語言 - 視覺 - 行動策略。

需要重寫的是:論文連結:

https://arxiv.org/pdf/2310.01361.pdf

#GenSim 框架由以下三個部分組成:

同時該框架透過兩種不同的模式運作。其中在目標導向設定中,使用者有特定的任務或希望設計一個任務課程。這時 GenSim 採取自上而下的方法,以預期任務作為輸入,迭代地產生相關任務以實現預期目標。而在探索性環境中,如果缺乏目標任務的先驗知識,則 GenSim 逐漸探索現有任務以外的內容,並建立與任務無關的基礎策略。

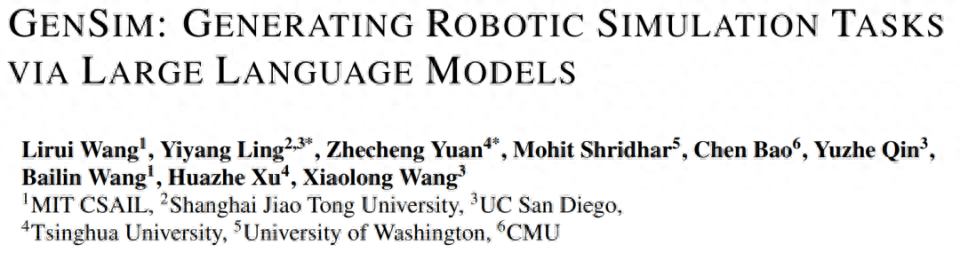

在下圖 1 中,研究者初始化了包含 10 個人工策劃任務的任務庫,使用 GenSim 對它進行擴展並產生 100 多個任務。

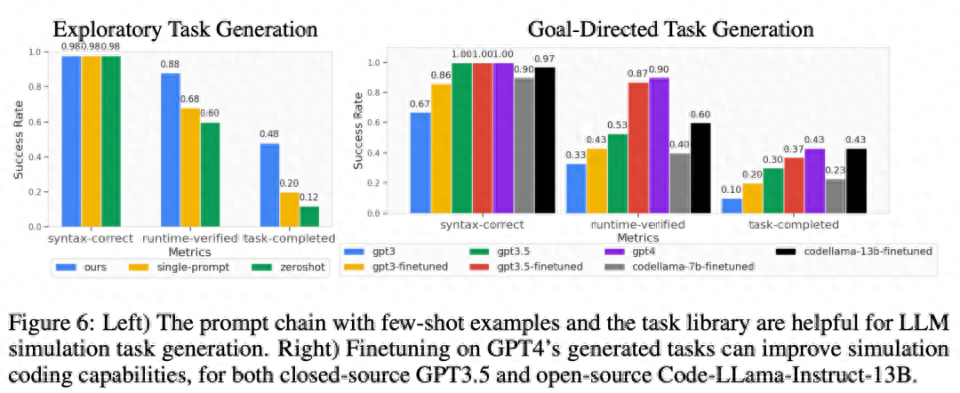

研究者也提出了幾個客製化的指標來漸進地衡量生成模擬任務的質量,並在目標導向和探索性設定中評估了幾種 LLM。其中對於 GPT-4 產生的任務庫,他們對 GPT-3.5 和 Code-Llama 等 LLM 進行有監督微調,進一步提升了 LLM 的任務產生效能。同時透過策略訓練定量地衡量任務的可實現性,並提供不同屬性的任務統計資料和不同模型之間的程式碼比較。

不僅如此,研究者還訓練了多任務機器人策略,與僅在人工策劃任務上訓練的模型相比,這些策略在所有生成任務上都能很好地泛化,並提高了零樣本泛化性能。其中與 GPT-4 生成任務的聯合訓練可以將泛化效能提升 50%,並在模擬中將約 40% 的零樣本任務遷移到新任務中。

最後,研究者也考慮了模擬到真實的遷移,顯示在不同模擬任務上的預訓練可以將真實世界的泛化能力提升 25%。

總之,在不同 LLM 生成的任務上訓練的策略實現了對新任務的更好任務級泛化能力,彰顯了透過 LLM 擴展模擬任務來訓練基礎策略的潛力。

Tenstorrent AI 產品管理總監Shubham Saboo 給予了這項研究很高的評價,他表示,這是GPT-4 結合機器人的突破性研究,透過GPT-4 等LLM 來產生autopilot 上的一系列模擬機器人任務,使機器人的零樣本學習和真實世界適應成為了現實。

方法介紹

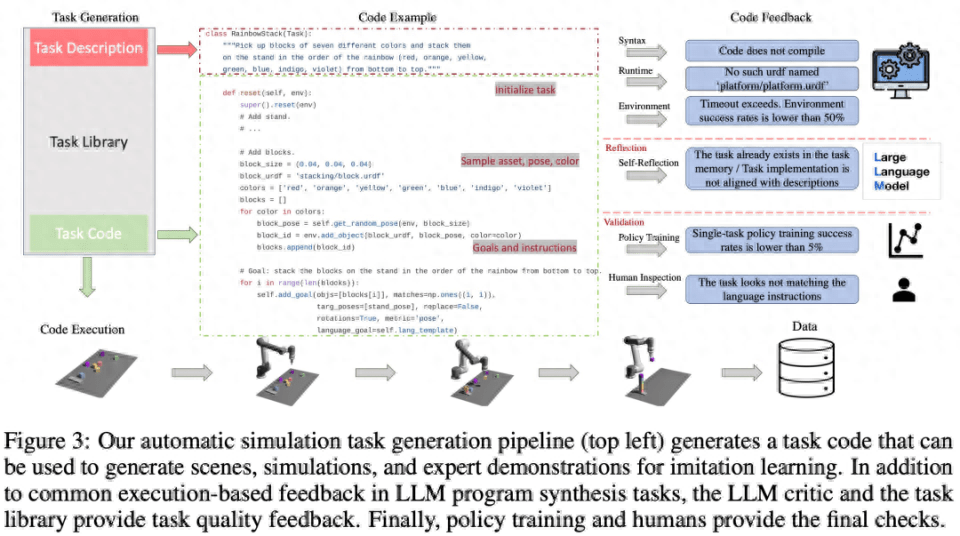

如下圖 2 所示,GenSim 框架透過程式合成產生模擬環境、任務和演示。 GenSim pipeline 從任務建立器開始,prompt 鏈以兩種模式運行,即目標導向模式和探索模式,取決於目標任務。 GenSim 中的任務庫是一個記憶體元件,用於儲存先前產生的高品質任務,任務庫中儲存的任務可用於多任務策略訓練或微調 LLM。

任務創建器

#如下圖 3 所示,語言鏈會先產生任務描述,然後再產生相關的實作。任務描述包括任務名稱、資源和任務摘要。研究在 pipeline 中採用少樣本 prompt 來產生程式碼。

任務庫

GenSim 框架中的任務庫會儲存任務建立器產生的任務,以產生更好的新任務和訓練多任務策略。任務庫是根據人工創建的基準中的任務進行初始化的。

任務庫為任務創建器為描述生成階段提供了作為條件的先前的任務描述,為程式碼生成階段提供了先前的程式碼,並prompt 任務創建器從任務庫中選擇參考任務作為編寫新任務的範例。完成任務實現並通過所有測試後,LLM 會被 prompt,以「反思(reflect)」新任務和任務庫,並形成是否應將新產生的任務新增至庫中的綜合決策。

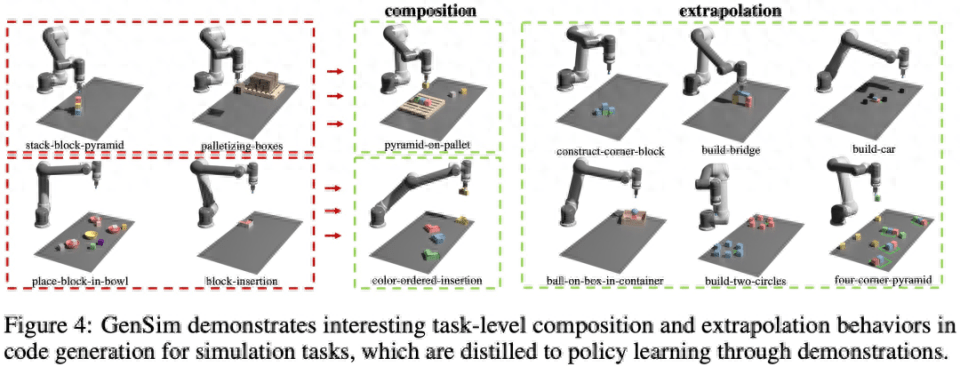

如下圖 4 所示,研究也觀察到 GenSim 表現出有趣的任務級組合和外推行為:

LLM 監督的多任務策略

產生任務後,研究使用這些任務實作來產生示範資料並訓練操作策略,並使用與 Shridhar et al. (2022) 類似的雙流傳輸網路架構。

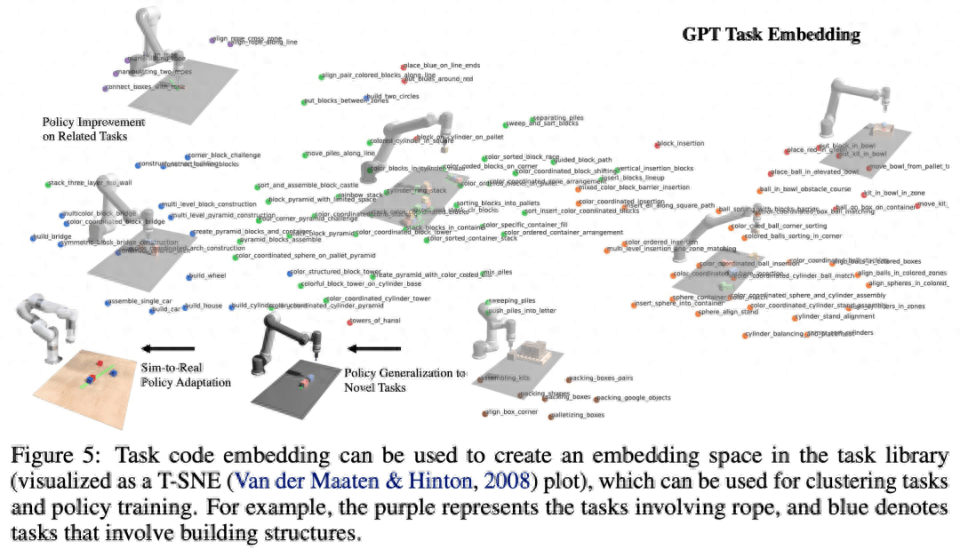

如下圖5 所示,該研究將程序視為任務和相關演示數據的有效表徵(圖5),就可以定義任務之間的嵌入空間,其距離指標對於來自感知的各種因素(例如物件姿態和形狀)更加穩健。

為了實現內容的重寫,需要將原文的語言改寫為中文,不需要出現原句

#該研究透過實驗來驗證 GenSim 框架,針對以下具體問題:(1)LLM 設計和實現模擬任務的效果如何? GenSim 可以改進 LLM 在任務產生方面的表現嗎? (2) 對 LLM 產生的任務進行訓練是否可以提升策略泛化能力?如果給予更多的生成任務,策略訓練是否會受益更多? (3) 針對 LLM 產生的模擬任務進行預訓練是否有利於現實世界的機器人策略部署?

評估 LLM 機器人模擬任務的泛化能力

#如下圖 6 所示,對於探索模式和目標導向模式任務生成,少樣本和任務庫的兩階段 prompt 鏈可以有效提高程式碼產生的成功率。

任務層級泛化

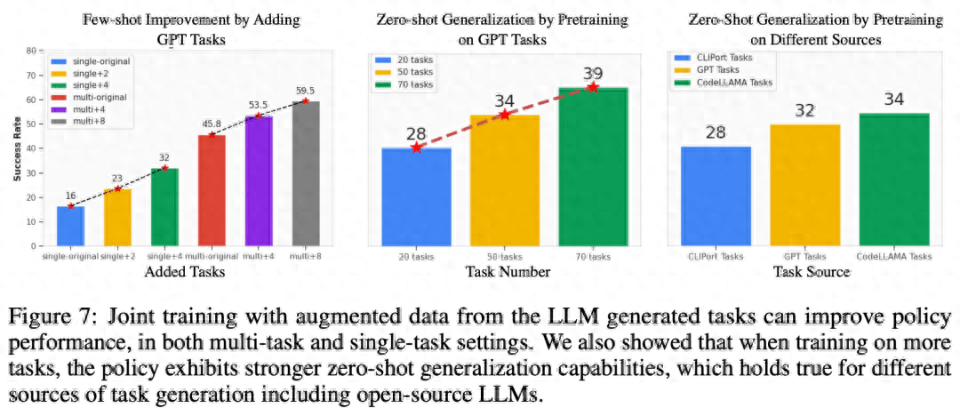

#相關任務的少樣本策略最佳化。從下圖 7 左可以觀察到,聯合訓練 LLM 產生的任務可以將原始 CLIPort 任務上的策略效能提升 50% 以上,尤其是在低資料情況(如 5 個 demo)下。

對未見過任務的零樣本策略泛化。從圖 7 可以看到,透過對 LLM 產生的更多任務進行預訓練,研究者的模型可以更好地泛化到原始 Ravens 基準中的任務。圖 7 右中,研究者也對人工編寫任務、閉源 LLM 和開源微調 LLM 等不同任務來源上的 5 個任務進行了預訓練,並觀察到了類似的零樣本任務層級泛化。

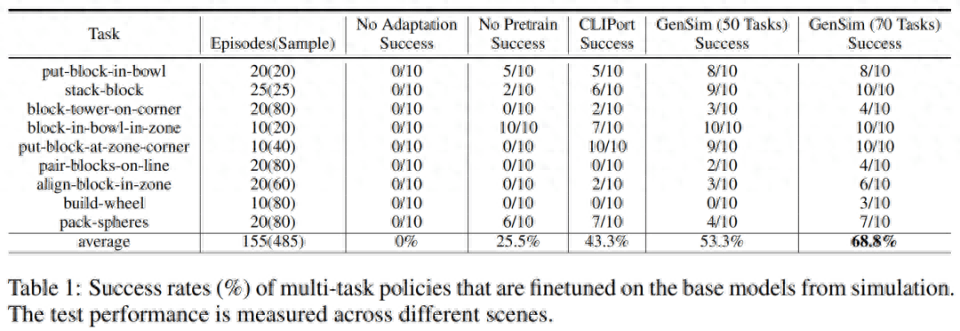

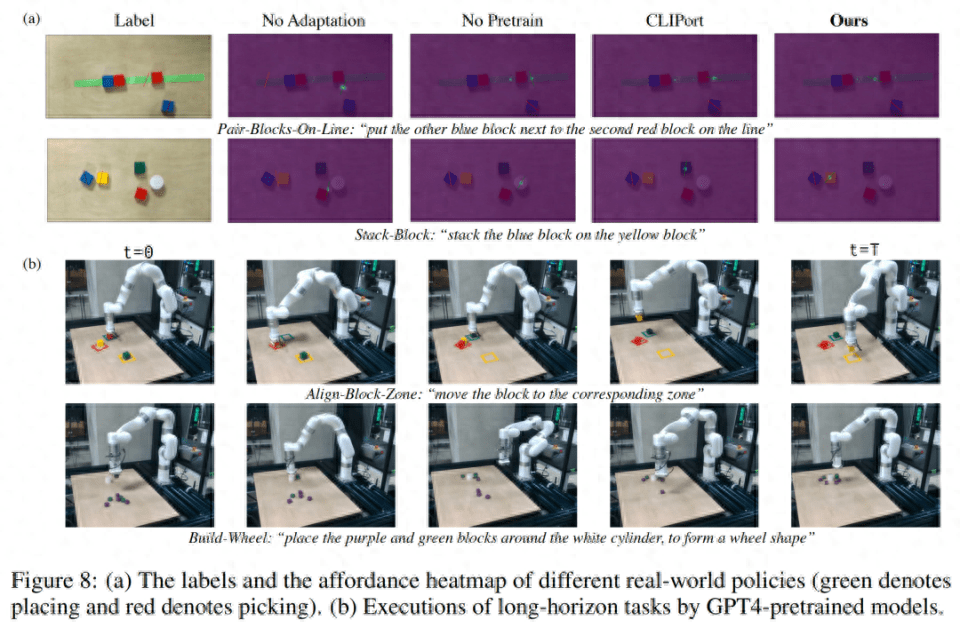

讓預訓練模型適應真實世界

研究者將模擬環境中訓練的策略遷移到了真實環境。結果如下表1 所示,在70 個GPT-4 產生的任務上進行預訓練的模型在9 個任務上進行了10 次實驗,取得68.8% 的平均成功率,與僅在CLIPort 任務上進行預訓練的基準模型相比提升了25% 以上,與僅在50 個任務上預訓練的模型相比提升了15%。

研究者也觀察到,對不同模擬任務的預訓練提高了長期複雜任務的穩健性。比方說,GPT-4 預訓練的模型在真實世界的 build-wheel 任務上展現了更穩健的表現。

消融實驗

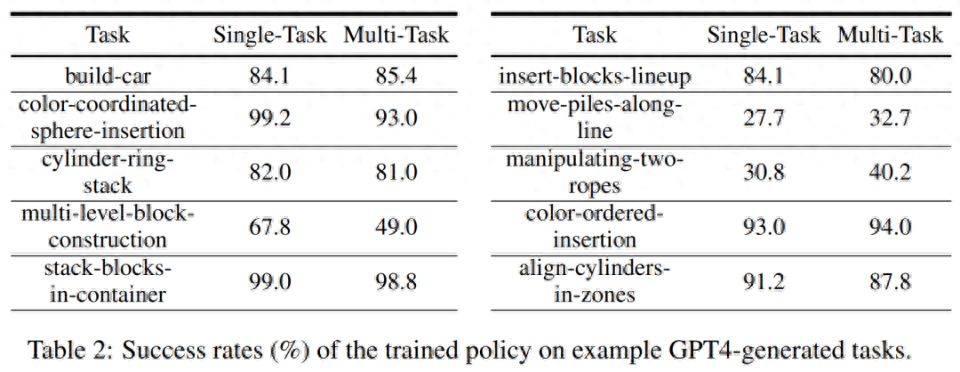

模擬訓練成功率。在下表 2 中,研究者在擁有 200 個 demo 的生成任務子集上,示範了單任務和多任務策略訓練的成功率。對於 GPT-4 生成任務的策略訓練,它的平均任務成功率為單任務 75.8%,多任務 74.1%。

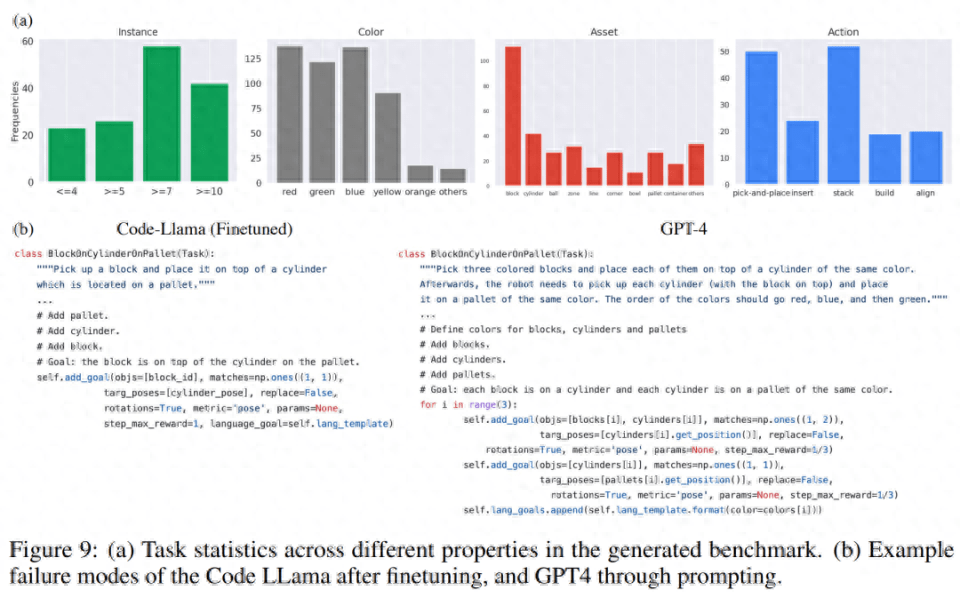

產生任務統計。下圖 9 (a) 中,研究者展示了 LLM 產生的 120 個任務的不同特徵的任務統計。其中 LLM 模型產生的顏色、資產、動作和實例數量之間存在著有趣的平衡。例如,產生的程式碼包含了許多超過 7 個物件實例的場景,以及許多拾起 - 放置原始動作和區塊等資產。

在程式碼產生的比較中,研究者在下圖9(b)中對GPT-4和Code Llama的自上而下實驗中的失敗案例進行了定性評估

更多技術細節請參閱原文。

以上是語言、機器人破壁,MIT等以GPT-4生成模擬任務,遷移到真實世界的詳細內容。更多資訊請關注PHP中文網其他相關文章!