今年的ICCV2023 best student paper頒給了康乃爾大學的qianqian wang,目前是加州大學柏克萊分校的博士後研究員!

在影片運動估計領域,作者指出傳統方法主要分為兩種:稀疏特徵追蹤和密集光流。雖然這兩種方法都在各自的應用中被證明有效,但它們都無法完整地捕捉到影片中的運動。成對的光流無法捕捉長時間視窗內的運動軌跡,而稀疏追蹤則無法模擬所有像素的運動

為了彌補這一差距,許多研究都試圖在影片中同時估計密集和長距離的像素軌跡。這些研究的方法多種多樣,從簡單地將兩幀光流場連結起來,到直接預測在多個畫面中的每個像素軌跡。但這些方法在估計運動時往往只考慮有限的上下文,並忽略了時間或空間上較遠的資訊。這種短視可能導致長軌跡中的錯誤累積,以及運動估計中的時空不一致。儘管某些方法考慮了長時間的上下文,但它們仍然在2D領域進行操作,這可能在遮蔽事件中導致追蹤遺失。

總的來說,影片中的密集和長距離軌跡估計仍然是該領域一個尚未解決的問題。這個問題涉及到三個主要挑戰:1)如何在長序列中保持軌蹟的準確性,2)如何在遮擋情況下跟踪點的位置,3)如何保持時空的一致性

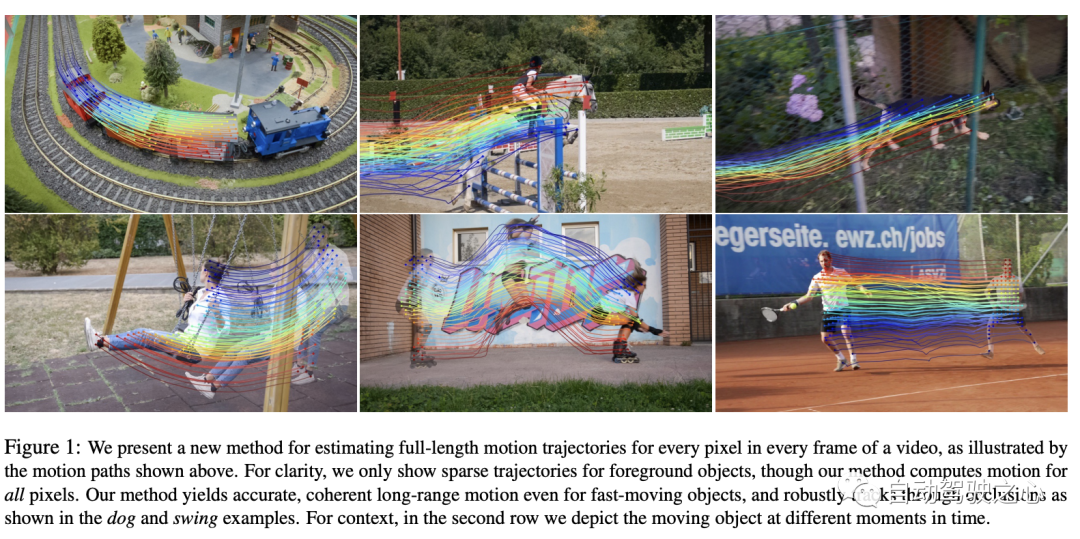

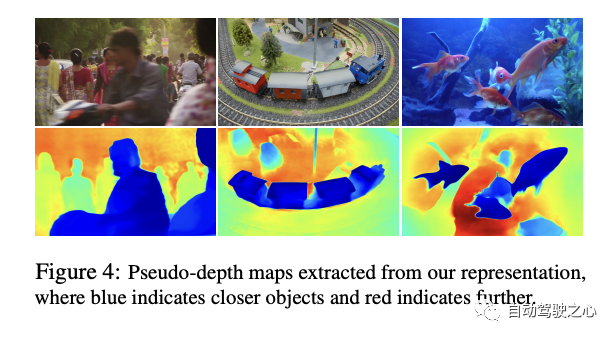

在這在文章中,作者提出了一種新穎的視訊運動估計方法,該方法利用影片中的所有資訊來共同估計每個像素的完整運動軌跡。這種方法被稱為"OmniMotion",它採用了一種準3D的表示形式。在這種表示形式中,一個標準的3D體被映射到每一幀的局部volume。這種映射作為動態多視圖幾何的一種靈活擴展,可以同時模擬相機和場景的運動。這種表示形式不僅確保了循環的一致性,還能在遮擋時追蹤所有的像素。作者為每個影片優化了這種表示形式,從而為整個影片的運動提供了解決方案。經過最佳化後,這種表示形式可以在影片的任何連續座標上查詢,以獲得跨越整個影片的運動軌跡

本文提出的這種方法可以:1) 為整個影片中的所有點生成全域一致的完整運動軌跡,2) 追蹤經過遮蔽的點,以及3) 處理具有各種相機和場景動作組合的實際影片。在TAP視訊追蹤基準測試中,該方法表現出色,遠遠超越了先前的方法。

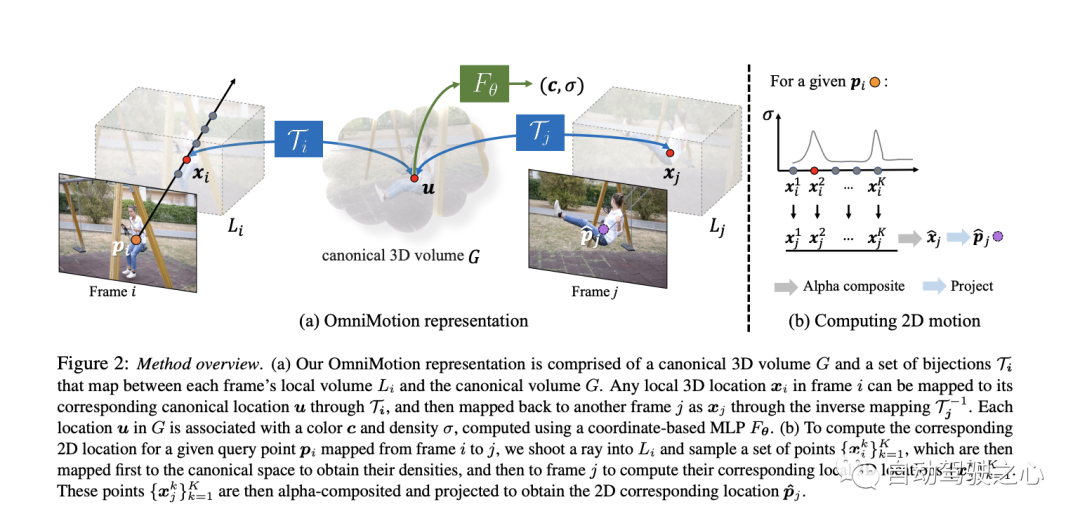

論文提出了一種基於測試時最佳化的方法,用於從影片序列中估計密集和長距離的運動。首先來對論文提出的方法來一個總覽:

這種方法能夠提供一個全面且連貫的視訊運動表示,並且能夠有效地解決遮蔽等挑戰性問題。現在我們來詳細了解一下

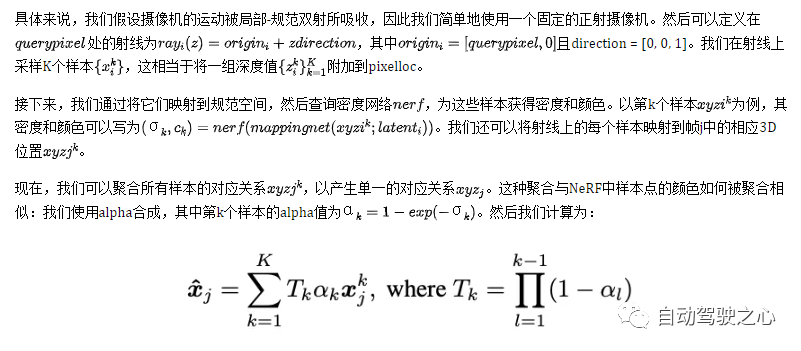

影片內容由一個名為G的典型volume表示,該volume充當觀察到的場景的三維地圖。與NeRF中的做法類似,他們定義了一個基於座標的網路nerf,它為G中的每個典型3D座標uvw映射到一個密度σ和顏色c。 G中儲存的密度告訴我們典型空間中的表面位置。當與3D雙射結合使用時,這使我們能夠追蹤多幀的表面並理解遮蔽關係。 G中儲存的顏色則允許我們在最佳化期間計算光度損失。

本文介紹了一個連續的雙射映射,記為,它將3D點從局部座標系轉換到一個規範的3D座標系。這個規範座標作為一個場景點或3D軌跡在時間上的一致引用或「索引」。使用雙射映射的主要優勢是它們在不同幀之間的3D點提供的週期一致性,因為它們都源自於同一個規範點。

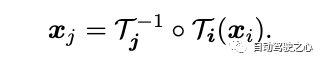

從一個局部影格到另一個的3D點的映射方程式為:

#為了捕捉複雜的真實世界運動,這些雙射被參數化為可逆神經網路(INNs)。選擇Real-NVP作為模型是受到其簡單性和其解析可逆性的屬性的影響。 Real-NVP透過使用稱為仿射耦合層的基本變換來實現雙射映射。這些層將輸入分割,使一部分保持不變,而另一部分則進行仿射變換。

為了進一步增強這個架構,我們可以透過對每一幀的潛碼latent_i進行條件化來實現。因此,所有的可逆映射mapping i都是由一個單一的可逆網絡mappingnet決定,但它們具有不同的潛碼latent code

#重新計算幀間運動

在這部分,描述如何為幀i中的任何查詢像素querypixel計算2D運動。直觀地說,首先通過在射線上採樣點將查詢像素“提升”到3D,然後使用雙射mapping i和mapping j將這些3D點“映射”到目標幀j,接著通過alpha合成從不同的樣本“渲染」這些映射的3D點,最後「投影」回2D以獲得一個假定的對應關係。

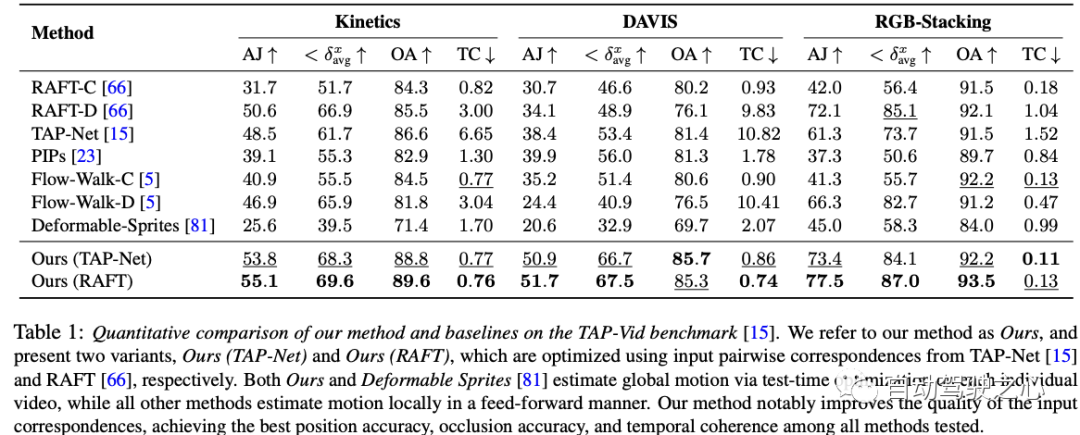

這份實驗資料表展示了在三個資料集-Kinetics、DAVIS和RGB-Stacking上,多種運動估計方法的表現。為了評估各個方法的效能,使用了四個度量標準:AJ、avg、OA和TC。除了作者提出的兩種方法(我們的(TAP-Net)和我們的(RAFT)),還有其他7種方法。值得注意的是,作者的兩種方法在大部分度量和資料集上都表現出色。具體來說,我們的(RAFT)方法在所有三個資料集的AJ、avg和OA上取得了最佳成績,而在TC上則次佳。我們的(TAP-Net)方法在某些測量上也達到了類似的優異表現。同時,其他方法在這些測量上的表現則參差不齊。需要提及的是,作者的方法和「Deformable Sprites」方法透過在每個影片上的測試時間最佳化來估計全局運動,而其他所有方法都採用前向方式在局部進行運動估計。總結來說,作者的方法在位置精度、遮擋精度和時間連續性上都超越了其他所有測試的方法,展現出了顯著的優勢

這是一個針對DAVIS資料集的消融實驗結果表。消融實驗是為了驗證每個組件對整個系統表現的貢獻大小。這個表格中列出了四種方法,其中三種是移除了某個關鍵元件的版本,而最後的"Full"版本包含了所有元件。

總的來說,這個消融實驗的結果顯示,雖然每個組件都對表現有一定的提升,但可逆性可能是最重要的元件,因為沒有它的話,效能損失會非常嚴重

這份工作中對DAVIS資料集進行的消融實驗為我們提供了寶貴的洞察,揭示了每個組件對整個系統性能的關鍵作用。從實驗結果中,我們可以明確地看到可逆性組件在整體框架中扮演了至關重要的角色。當缺少這項關鍵組件時,系統的效能大幅下降。這進一步強調了在動態視訊分析中考慮可逆性的重要性。同時,儘管光度組件的缺失也會導致性能下降,但它對性能的影響似乎不如可逆性那麼大。此外,統一的採樣策略雖然對性能有一定的影響,但與前兩者相比,其影響相對較小。最後,完整的方法整合了所有這些組件,為我們展示了在所有考慮因素下所能達到的最佳性能。總體來說,這份工作為我們提供了一個深入了解視頻分析中各個組件如何相互作用,以及它們對整體性能的具體貢獻的寶貴機會,從而強調了在設計和優化視頻處理算法時採用綜合方法的重要性

但是,像許多運動估計方法一樣,我們的方法在處理快速和高度非剛性運動以及細小結構時面臨困難。在這些情境下,成對的對應方法可能無法為我們的方法提供足夠的可靠對應關係來計算精確的全局運動。另外,由於基礎優化問題的高度非凸性質,我們觀察到,對於某些困難的視頻,我們的優化過程可能對初始化非常敏感。這可能會導致次優的局部最小值,例如,錯誤的表面排序或在規範空間中的重複對象,有時這些問題很難透過最佳化來修正。

最後,我們的方法在其當前形式下可能在計算上是昂貴的。首先,流量收集過程涉及全面計算所有的成對流,這與序列長度呈二次比例增長。但我們相信,透過探索更有效率的匹配方法,例如詞彙樹或基於關鍵影格的匹配,並從結構運動和SLAM文獻中獲取靈感,可以提高這一過程的可擴展性。其次,與其他使用神經隱式表示的方法一樣,我們的方法涉及一個相對較長的最佳化過程。此領域的近期研究可能有助於加速這一過程,並進一步擴展到更長的序列

本文提出了一個新的測試時最佳化方法,用於估計整個影片的完整和全局一致的運動。引入了一個新的視頻運動表示,稱為OmniMotion,它包括一個準3D標準volume和每幀的local-canonical雙射。 OmniMotion可以處理具有不同攝影機設定和場景動態的普通視頻,並透過遮擋產生準確且平滑的長距離運動。在品質和數量上,都比以前的最先進方法取得了顯著的改善。

需要重寫的內容是:原文連結:https://mp.weixin.qq.com/s/HOIi5y9j-JwUImhpHPYgkg

以上是標題重寫:ICCV 2023優秀學生論文跟踪,Github已經獲得1.6K star,彷彿魔法般的全面信息!的詳細內容。更多資訊請關注PHP中文網其他相關文章!